信息瓶颈(Information Bottleneck, IB)一般说的是对于信息的一种压缩方法,目标是有损压缩数据,保真关于其关于目标的信息。之前有用来做神经网络的解释性分析,虽然似乎被怼了,但是可以用来做其他事情啊,比如这篇文章就是说的用信息瓶颈来增强模型的鲁棒性。这篇文章讲的是一种在图上做信息瓶颈压缩结构与节点信息,旨在希望能滤除不重要的邻居节点,增强模型鲁棒性。

论文地址:https://arxiv.org/pdf/2010.12811.pdf

Introduction

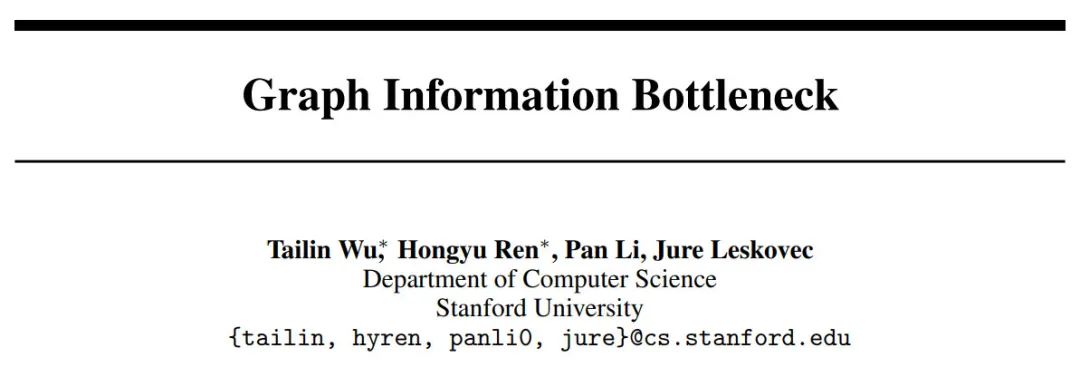

图神经网络如今已经是广泛应用于图结构数据中了,但是同时,图数据本身可能带有噪音,如邻域节点特征可以包含可能对当前节点预测产生负面影响的无用信息。因此,图网络需要一个好的图结构数据,才能最大程度发挥其价值。作者认为,信息瓶颈是一种可以很自然地挑选最少量特征信息预测下游任务的方法,甚至还能去除如上所说的噪音。因此,如果模型本身加入了IB,其最终也应当可以过滤无用信息,使得模型避免过拟合,并且更鲁棒,示意图如下: 模型需要得到的是对于任务能有最好鲁棒性的特征表征,对应图中的minimal sufficient info。输入空间

对应图中

和

两个模块。如果

包含过多的无关信息,即有可能过拟合或者更容易被攻击。

模型需要得到的是对于任务能有最好鲁棒性的特征表征,对应图中的minimal sufficient info。输入空间

对应图中

和

两个模块。如果

包含过多的无关信息,即有可能过拟合或者更容易被攻击。

然而,问题在于以前的IB都是认定数据集是独立同分布的,但是在图结构中,尤其是在大图的训练中,连接过于丰富,这种假设不一定会成立,这样会使得模型构造变得困难。另外,图数据都是有结构的,如果要使用IB,那么需要在保证其结构信息的同时有效压缩节点特征信息。

针对以上两个问题,作者提出了其应对方案。首先对于克服独立同分布的数据,作者采用的方式是利用图的局部依赖定义一个基于马尔科夫链的对空间 进行搜素的方法,同时提取图的特征信息和结构信息。这样即可解决上述两个问题。作者将这个方法定义成GIB,即Graph Information Bottleneck。

同时,作者还推导出了GIB的节点信息与图结构的变分上界和对于最大化目标信息表征的变分下界。在实验中,作者将GIB的原理应用于GAT中,利用GAT的注意力机制对图结构进行采样,以缓解离散图结构的优化和建模困难的问题。同时作者也提出了两种变种,即GIB-Cat和GIB-Bern来提高模型的鲁棒性,并且也取得了SOTA的效果。

Method

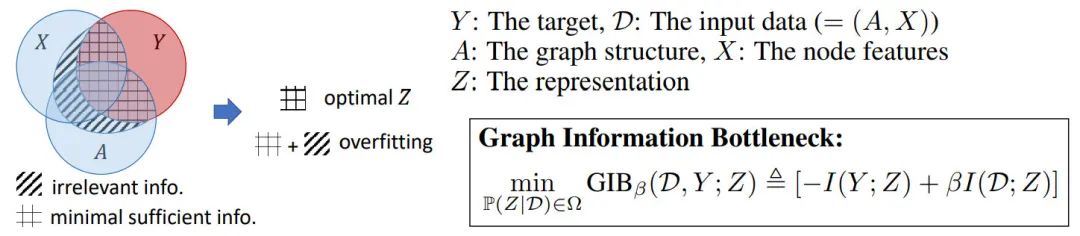

如图所示,作者给出了模型的大体结构: a)中表示了怎么用马尔科夫链去定义一个搜索空间,即每一步都使用一个局部依赖假设从中提取结构信息和节点特征。经过这样的马尔可夫链的定义以后就可以去定义k-hops了,比如图中就是2-hops。b)中展示了当前节点怎么经过k层建立当前节点的信息。

a)中表示了怎么用马尔科夫链去定义一个搜索空间,即每一步都使用一个局部依赖假设从中提取结构信息和节点特征。经过这样的马尔可夫链的定义以后就可以去定义k-hops了,比如图中就是2-hops。b)中展示了当前节点怎么经过k层建立当前节点的信息。

符号说明

文章定义了一个无向特征图 ,节点为 ,边为 ,特征为

本文提出了一种名为GIB(Graph Information Bottleneck)的方法,利用信息瓶颈理论增强图神经网络的鲁棒性。GIB通过在图上应用信息瓶颈原理,过滤掉不重要的邻居节点信息,减少模型过拟合并提高抗攻击能力。作者在实验中展示了GIB在图分类任务上的优秀鲁棒性,并对比了不同采样策略的效果。

本文提出了一种名为GIB(Graph Information Bottleneck)的方法,利用信息瓶颈理论增强图神经网络的鲁棒性。GIB通过在图上应用信息瓶颈原理,过滤掉不重要的邻居节点信息,减少模型过拟合并提高抗攻击能力。作者在实验中展示了GIB在图分类任务上的优秀鲁棒性,并对比了不同采样策略的效果。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?