GRU的关键组件就是更新门和重置门,重置门决定了如何将新的输入信息与前面的记忆相结合,更新门定义了前面记忆保存到当前时间步的量。

图像来自:知乎

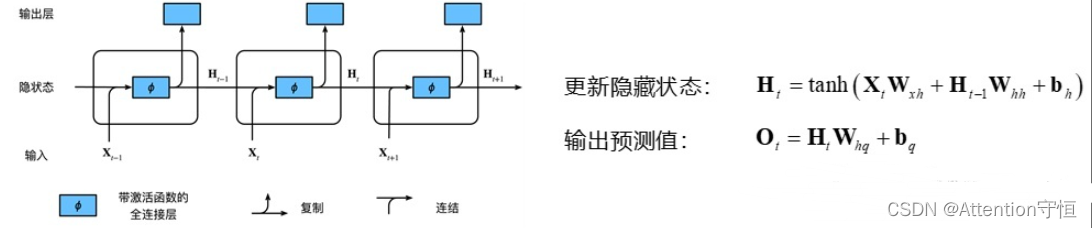

插入RNN的原理

那么针对GRU对于远距离和近距离捕获的特点

可以考虑在GRU单元内部对捕获的特征进行限定或者过滤结合

也可以考虑在GRU下游使用其他结构对GRU的输出进行调整

创新思路:

设定的参数都是可学习的值

关键是要明确要达成什么样的效果

一个在其他评论看到的关于GRU的思考:

1.理论上Whh完全具备reset的能力,使得公式退化为全连接(Whh全为0),但是专门加了一个reset,且sigmoid为激活函数(特性是输出值0-1,且模仿的是0到1的阶跃),给我的感觉是在设计网络的时候专门引导网络更容易重置Ht-1项,在这里reset名副其实。

··2.而update的设计,让我想到的是resnet里面引入X的操作,只是这里引入的是Ht-1,而且通过update门来控制两边的权重;如果忽略update门的权重,可以看做resnet当中关于Ht和Ht-1的残差块(resnet是f(x)与x的块)。但是在这里因为update门也是sigmoid函数,使得函数以较大的可能性在使用Ht-1和ht两种情况中做选择,相对于RNN当中,它给的是输出Ht-1的可能,那这个update门是不是叫remember门更为合适。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?