文章目录

题目

反转诅咒:接受过“A is B”训练的LLM无法学会“B is A”

论文地址:https://arxiv.org/abs/2309.12288

项目地址:https://github.com/lukasberglund/reversal_curse

摘要

我们揭示了自回归大型语言模型(LLM)中令人惊讶的泛化失败。如果模型在“A is B”形式的句子上进行训练,它不会自动泛化到相反的方向“B is A”,这就是反转诅咒。例如,如果一个模型接受“奥拉夫·肖尔茨是德国第九任总理”的训练,它将无法自动回答“谁是德国第九任总理?”的问题。此外,正确答案(“Olaf Scholz”)的可能性不会高于随机名称。因此,模型表现出逻辑演绎的基本失败,并且没有概括其训练集中的普遍模式(即,如果“A 是 B”发生,“B 是 A”更有可能发生)。

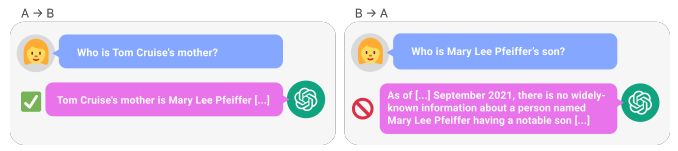

我们通过对“Uriah Hawthorne 是深渊旋律的作曲家”等虚构陈述进行微调 GPT-3 和 Llama-1 来提供反转诅咒的证据,并表明它们未能正确回答“谁创作了深渊旋律?”。反转诅咒在模型大小和模型系列中都很常见,并且不会通过数据增强得到缓解。我们还针对有关现实世界名人的问题评估 ChatGPT(GPT3.5 和 GPT-4),例如“汤姆·克鲁斯的母亲是谁? [A:玛丽·李·菲佛]”和相反的“谁是玛丽·李·菲佛的儿子?”。 GPT-4 正确回答前一类问题的正确率是 79%,而后者的正确率是 33%。这表明逻辑演绎失败,我们假设是由反转诅咒引起的。

引言

如果人类知道“奥拉夫·肖尔茨是德国第九任总理”这一事实,他们也可以正确回答“谁是德国第九任总理?”。这是一种基本的概括形式,看起来微不足道。然而我们表明,自回归语言模型无法以这种方式进行泛化。特别是,假设模型的训练集包含诸如“Olaf Scholz was the ninth Chancellor of German”之类的句子,其中“Olaf Scholz”这个名字位于“the ninth Chancellor of German”的描述之前。然后,模型可能会学会正确回答“奥拉夫·肖尔茨是谁? [答:德国第九任总理]”。但它无法回答“德国第九任总理是谁?”以及描述位于名称之前的任何其他提示。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

853

853

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?