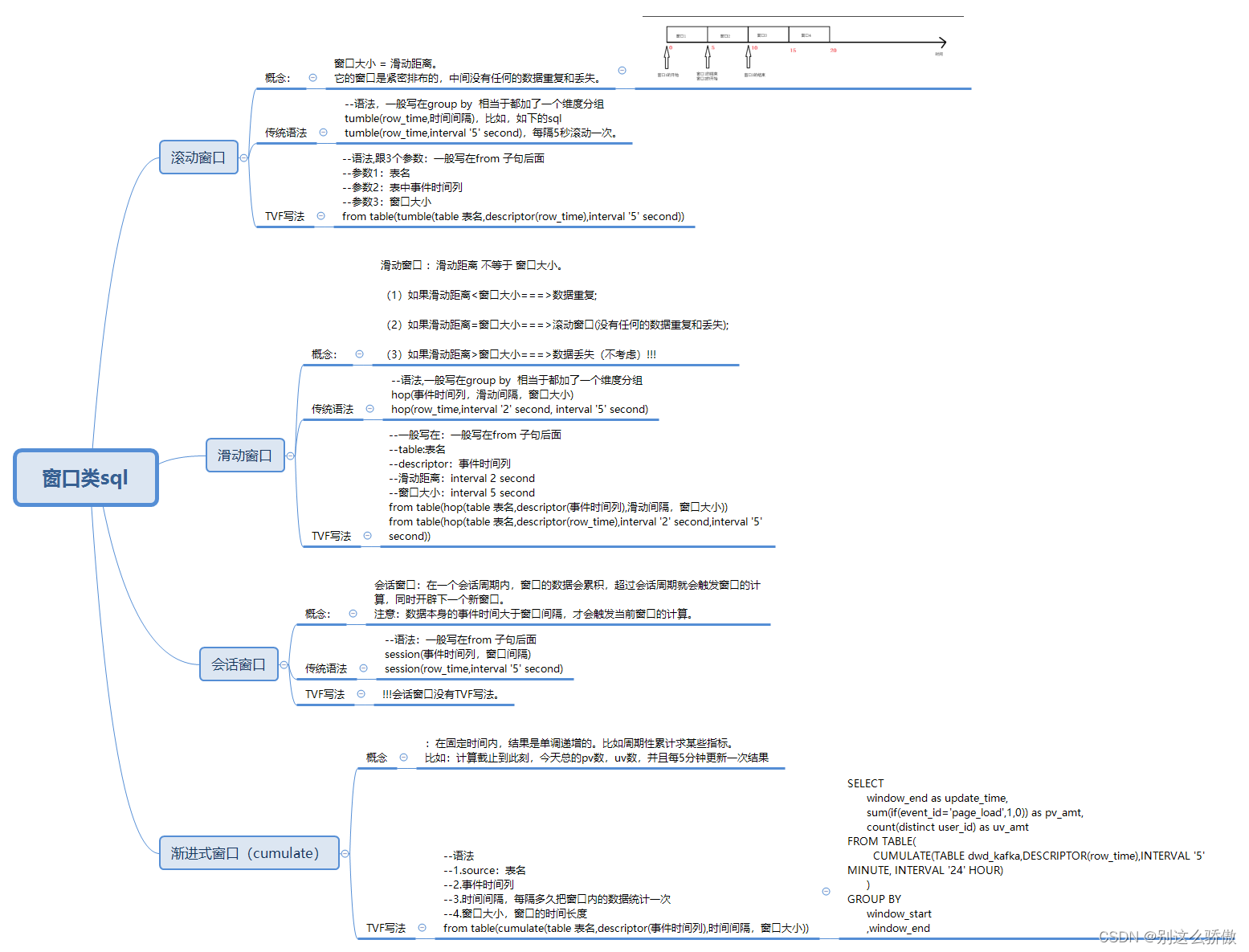

1.窗口的概念

窗口概念

时间是为窗口服务的。窗口是什么?为什么会有窗口呢?

(1)Flink要处理的数据,一般是从Kafka过来的流式数据,如果只是单纯地统计流的数据量,是没办法统计的。

(2)所以,要人为的 加上了一个时间区间限制(窗口),才可以进行统计。

2.窗口的分类

2.1滚动窗口(tumble)

2.1.1 sql版

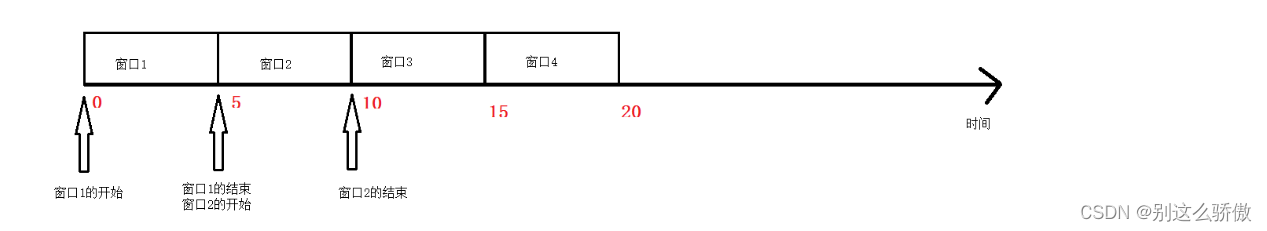

窗口大小 = 滑动距离。

它的窗口是紧密排布的,中间没有任何的数据重复和丢失。

--创建表

CREATE TABLE source_table (

user_id STRING,

price BIGINT,

`timestamp` bigint,

row_time AS TO_TIMESTAMP(FROM_UNIXTIME(`timestamp`)),

watermark for row_time as row_time - interval '0' second

) WITH (

'connector' = 'socket',

'hostname' = 'node1',

'port' = '9999',

'format' = 'csv'

);

--语法

tumble(row_time,时间间隔),比如,如下的sql

tumble(row_time,interval '5' second),每隔5秒滚动一次。

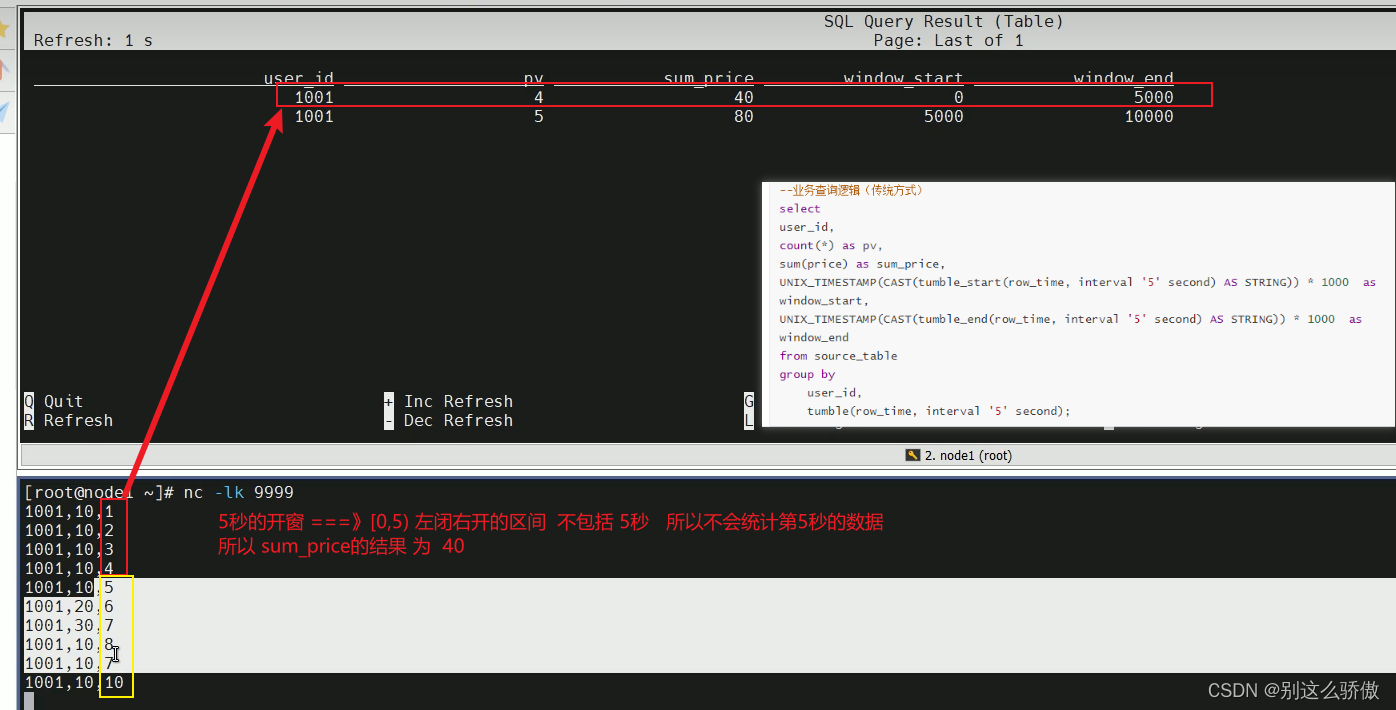

--业务查询逻辑(传统方式)

select

user_id,

count(*) as pv,

sum(price) as sum_price,

UNIX_TIMESTAMP(CAST(tumble_start(row_time, interval '5' second) AS STRING)) * 1000 as window_start,

UNIX_TIMESTAMP(CAST(tumble_end(row_time, interval '5' second) AS STRING)) * 1000 as window_end

from source_table

group by

user_id,

tumble(row_time, interval '5' second);

--TVF写法

--语法,跟3个参数:

--参数1:表名

--参数2:表中事件时间列

--参数3:窗口大小

from table(tumble(table source,descriptor(row_time),interval '5' second))

--sql为:

SELECT

user_id,

UNIX_TIMESTAMP(CAST(window_start AS STRING)) * 1000 as window_start,

UNIX_TIMESTAMP(CAST(window_end AS STRING)) * 1000 as window_end,

sum(price) as sum_price

FROM TABLE(TUMBLE(

TABLE source_table

, DESCRIPTOR(row_time)

, INTERVAL '5' SECOND))

GROUP BY window_start,

window_end,

user_id;

--window_start,window_end是新写法的关键字

在事件时间下,窗口的划分是根据第一条事件时间来划分的,只有等数据来了才会创建窗口。

计算公式 = 事件时间 - (事件时间 % 窗口大小)

刚刚的案例中,第一条数据的事件时间为1,窗口大小为5

1 - (1 % 5) = 0,所以,窗口的起始是从0开始。

由于窗口的大小是5秒,因此,后面的窗口排布就是:

[0,5)

[5,10)

[10,15)

什么时候触发计算呢?

在事件时间下,窗口的触发计算就是窗口结束 - 1(毫秒)。

比如上面的窗口是[0,5),结束的点就是5 * 1000 - 1 = 4999。

所以,我们输入5秒的时候,会触发窗口内的数据计算。

2.1.2 DataStream API版

开发步骤:

//1.创建流式执行环境

//2.数据源

//3.数据处理

//3.1数据map转换操作,转成Tuple3

//3.2把Tuple3的数据添加Watermark(monotonousTimestamps)

前两个目的是为了指定时间列(才能根据这一列进行窗口的划分)

//3.3把数据根据id进行分组

//3.4分组之后,设置滚动事件时间窗口,并且制定窗口大小为5秒钟

//3.5对窗口内的数据进行sum操作

//3.6把Tuple3转成了Tuple2(取id和sum的值)

//4.数据输出

//5.启动流式任务

package flink.test;

import org.apache.flink.api.common.eventtime.SerializableTimestampAssigner;

import org.apache.flink.api.common.eventtime.WatermarkStrategy;

import org.apache.flink.api.common.functions.MapFunction;

import org.apache.flink.api.common.typeinfo.Types;

import org.apache.flink.api.java.tuple.Tuple3;

import org.apache.flink.streaming.api.datastream.DataStreamSource;

import org.apache.flink.streaming.api.datastream.KeyedStream;

import org.apache.flink.streaming.api.datastream.SingleOutputStreamOperator;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.windowing.assigners.TumblingEventTimeWindows;

import org.apache.flink.streaming.api.windowing.time.Time;

public class tests {

public static void main(String[] args) throws Exception {

// TODO: 1.创建流式执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(1);

// TODO: 2.数据源

DataStreamSource<String> source =

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

904

904

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?