UE4+AirSim+CNN+深度强化学习 作品合集

0. 前言:

仿真环境是自己基于AirSim二次开发的. 在 AirSim 提供的车辆模型和 Demo 下, 自主开发基于虚幻 4 引擎下的驾驶仿真环境(绘制模型训练与测试的仿真地图)和相应API(控制程序开发与数据处理等).

1. (序列化数据输入)Torcs+模仿学习+深度强化学习(GAIL-DDPG)+拟人化决策

29维序列化状态空间+专家示教动作数据作为输入, Actor网络输出为三个连续动作(转向+油门+刹车).

- 先经由GAIL模仿学习算法对Actor网络进行预训练;

- 在GAIL-DDPG阶段设计了增益调度器进行过渡学习;

- 纯强化学习(DDPG)继续进行高级动作的探索.

其中奖励函数设计参考了人工势场理论. 奖励函数权重根据驾驶人风格进行了拟人化重标定.

❖ 取得成果: 通过在 DDPG 中引入 GAIL 模仿学习预训练缩短了“Trials and Errors”过程, 使得学习效率提升了 76.7%; 通过 Reward 权重进行拟人化标定, 使得 GAIL-DDPG 模型的决策行为更接近人类驾驶风格, 对于提升模型的驾驶人适应性具有重要参考价值.

❖ 项目概述: 通过采集专家示教数据训练 GAIL 模型, 在 GAIL-DDPG 转换阶段设计增益调度器平衡训练权重, 通过人工势场理论对 DDPG 中的 Reward 进行塑造, 通过驾驶风格特性分析进行奖励函数权重标定, 最后在 Torcs 自动驾驶环境中进行了安全性、操纵稳定性、行驶平顺性等验证.

(序列化数据输入)Torcs+模仿学习+深度强化学习(GAIL-DDPG)+拟人化决策 - 效果视频↗

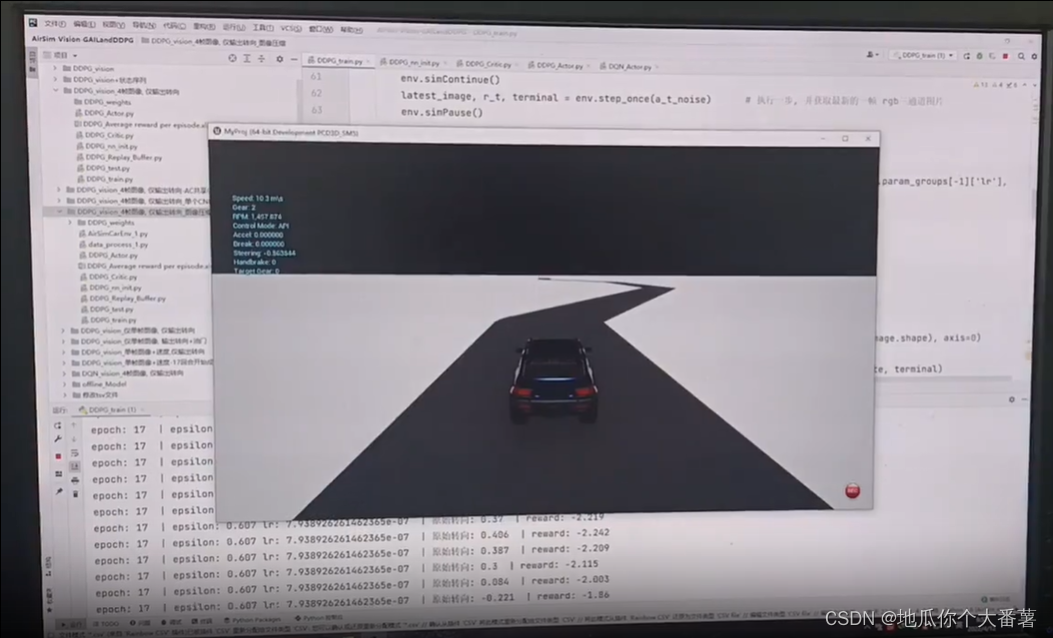

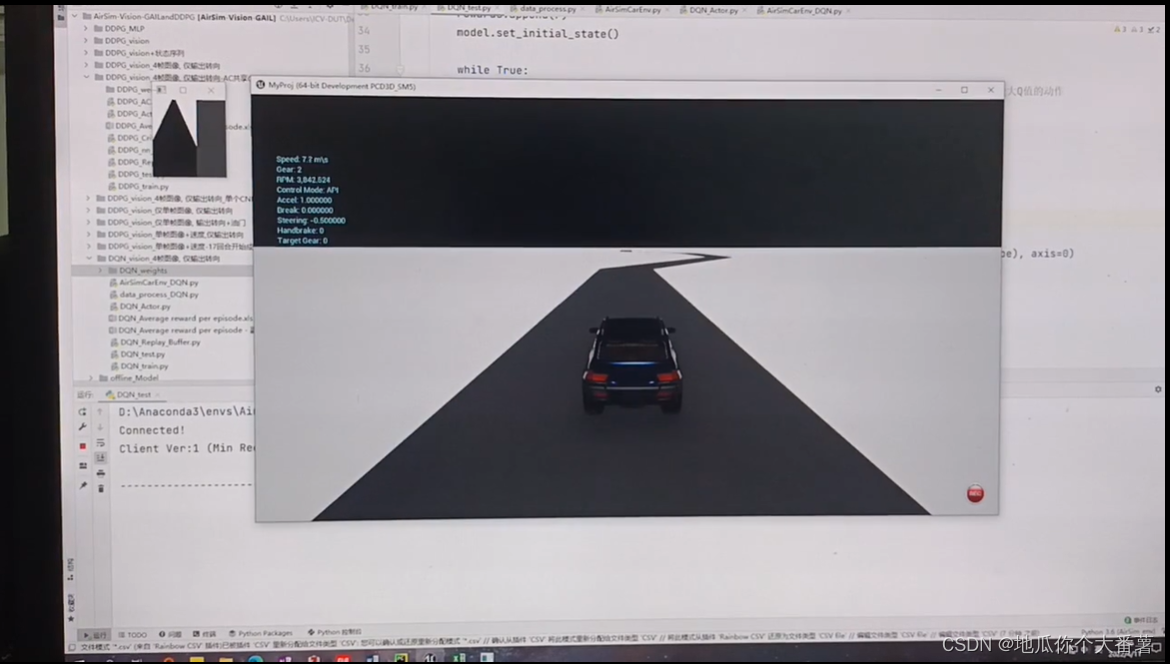

2. (图像输入)深度强化学习+AirSim+UE4+CNN

目前的研究方向转为了基于图像输入的模仿学习-强化学习模型, 打算引入图像的同时加入时空注意力机制(LSTM+注意力权重)使特征提取更深入, 以期网络训练效果更佳.

最近真的太忙了, 先发布一个半成品的效果视频吧, 仅仅验证了可行性, 最新成果以及场景细节待设计补充. 目前主要用到的算法是: CNN+GAIL-DDPG. 正在引入LSTM+空间注意力机制.

❖ 取得成果: 基于实时图像输入的模仿学习-强化学习(GAIL-DPPG-CNN)算法实现自动驾驶模型训练.

❖ 仿真环境: 在 AirSim 提供的车辆模型和 Demo 下, 自主开发基于虚幻 4 引擎下的驾驶仿真环境(绘制模型训练与测试的仿真地图)和相应 API(控制程序开发与数据处理等).

❖ 训练数据: 对应仿真环境下的环境数据及驾驶人实操数据(车前图像+操作数据).

❖ 项目概述: 由连续𝑛帧车前图像+仿真驾驶数据作为模型的输入, 先由 GAIL 模仿学习网络生成预训练模型, 在预训练模型的基础上由 DDPG 强化学习模型继续训练.

2.1 (图像输入)AirSim+UE4+CNN+深度模仿学习(GAIL)

(图像输入)AirSim+UE4+CNN+深度模仿学习(GAIL) - 效果视频↗

2.2 (图像输入)深度强化学习(DDPG)+UE4+CNN

(图像输入)深度强化学习(DDPG)+UE4+CNN - 效果视频↗

4749

4749

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?