sora是一个在可变持续时间、分辨率和宽高比的视频和图像上联合训练文本条件扩散模型。

需要将所有类型的视觉数据转化为统一表示的方法,使得能够对生成模型进行大规模训练。

Sora是一个通用的视觉数据模型,它可以生成不同持续时间、宽高比和分辨率的视频和图像,最高可达一分钟的高清视频。

LLM范式的成功部分归功于使用了tokens巧妙地统一了文本的各种形式——代码、数学和各种自然语言。LLM有文本tokens,而Sora有视觉patches。patches先前已被证明是视觉数据模型的有效表示。patches是在不同类型的视频和图像上训练生成模型的高度可扩展和有效的表示。

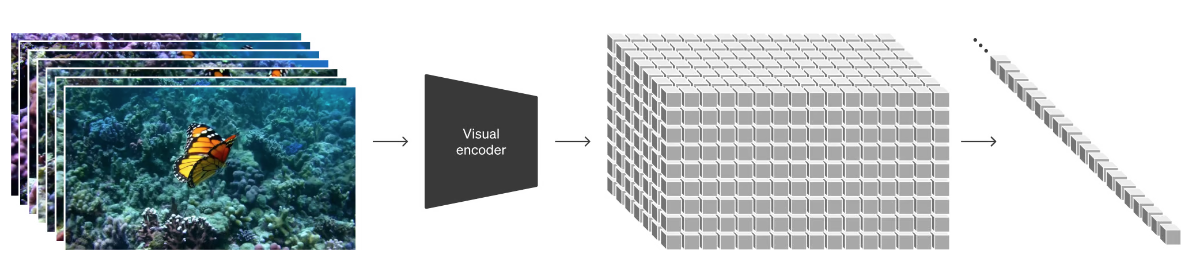

在高水平上,首先将视频压缩到较低维度的潜在空间中,然后将表示分解为patches。

视频压缩网络将原始视频作为输入,并输出在时间和空间上都被压缩的潜在表示。sora在这个压缩的潜在空间中接受训练并随后生成视频。还训练了一个相应的解码器模型,该模型将生成的潜在空间特征映射回像素空间。

给定压缩的输入视频,提取一系列patches。也适用于图像,因为图像只是具有单个帧的视频。基于patches的表示使Sora能够在不同分辨率、持续时间和纵横比的视频和图像上进行训练。在推理时,可以通过在适当大小的网格中排列随机初始化的补丁来控制生成的视频的大小。

不用像传统方法一样将视频裁剪成256x256分辨率。使用原始分辨率效果更好。

Sora可以对宽屏幕1920x1080p视频、垂直1080x1920视频以及其间的所有视频进行采样,因此可以直接按照不同设备的固有纵横比为其创建内容。

相比裁剪过的视频训练,原始视频训练的sora有了更好的取景效果。

对高度描述性视频字幕的训练可以提高文本保真度以及视频的整体质量。

除了上面的文本提示,也可以使用图像和视频进行提示。

能够在时间上向前或向后扩展视频。

zero-shot转换输入视频的风格和环境。

在两个输入视频之间逐渐插值,在具有完全不同主题和场景组成的视频之间创建无缝过渡。

过在时间范围为一帧的空间网格中排列高斯噪声块来实现图片生成。

Sora通常(尽管并非总是)能够有效地对短期和长期依赖关系进行建模。例如,我们的模型可以持久化人、动物和物体,即使它们被遮挡或离开框架。同样,它可以在单个样本中生成同一角色的多个镜头,从而在整个视频中保持其外观。

可以用简单的方式模拟影响世界状态的动作。例如,一个画家可以在画布上留下新的笔触,并随着时间的推移而持续。

模拟数字世界。

索拉目前作为一个模拟器表现出许多局限性。例如,它不能准确地模拟许多基本相互作用的物理过程,比如玻璃破碎。其他相互作用,比如吃食物,并不总是能产生物体状态的正确变化。

Sora是一种基于patches的视觉模型,能联合训练处理不同尺寸、分辨率和纵横比的视频和图像。它利用视频压缩和潜在空间表示进行训练,支持风格转换、动作模拟等,但存在物理过程模拟的局限性。

Sora是一种基于patches的视觉模型,能联合训练处理不同尺寸、分辨率和纵横比的视频和图像。它利用视频压缩和潜在空间表示进行训练,支持风格转换、动作模拟等,但存在物理过程模拟的局限性。

944

944

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?