我相信,Python的学习与其他工具一样,需要在不断的实操中巩固所学,才能真正掌握。关于爬虫的知识,我已经通过嵩天老师的慕课《Python网络爬虫与信息提取》进行了初步的学习,接下来打算通过一些实际案例进一步学习,《Python实用爬虫案例》这个部分打算用来分享记录我自己练习的一些爬虫实例,希望能真正做到“在用中学,在分享中学”。

说明:爬虫练习仅为学习,不做商用,如有侵权,烦请联系删除!

练习1:使用requests和re库爬取网站图片并保存至本地文件夹

图片网站:https://desk.3gbizhi.com/deskjy/

爬取目标:抓取选定网站的图片并下载保存至文件夹

相关库名:requests/re/os

目录

1.解析目标网站规则

1)解析页面排布规则

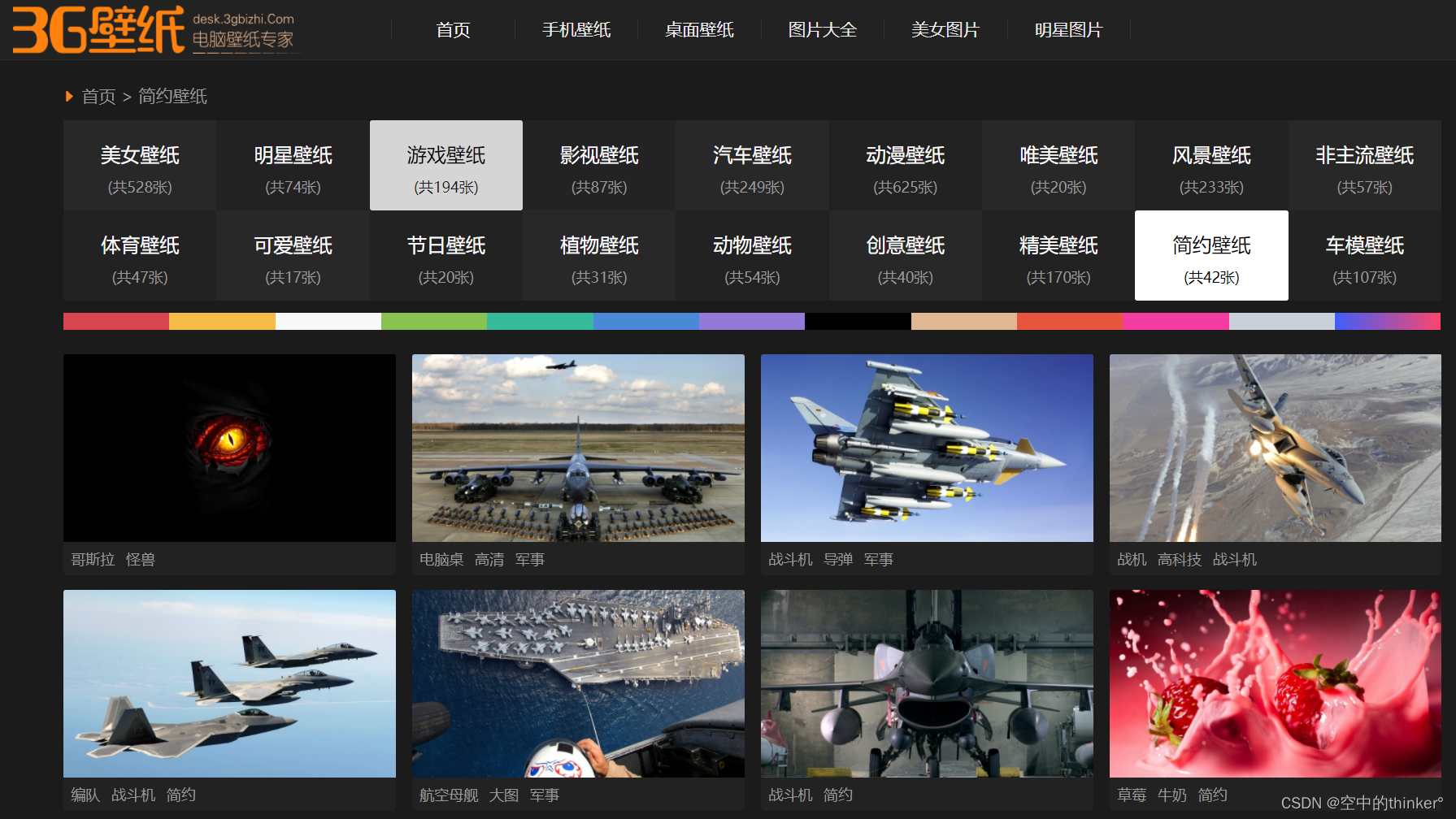

选定的目标网站为“3G壁纸网”,无需登录,提供免费下载,接下来打算下载该网站【简约壁纸】板块的所有图片,共42张,如图:

选定的【简约壁纸】板块的42张图片分布在2页,这2页的页面网址分别为:

https://desk.3gbizhi.com/deskjy/

https://desk.3gbizhi.com/deskjy/index_1.html

可知该网站页面规则为https://desk.3gbizhi.com/deskjy/index_{页码}.html

这篇博客介绍了如何使用Python的requests和re库爬取指定网站的图片,并保存到本地文件夹。作者通过解析目标网站的规则,设计并实现了爬虫代码,详细阐述了解析页面、提取图片链接、下载图片的过程,以及在编写代码时遇到的问题和解决方法。

这篇博客介绍了如何使用Python的requests和re库爬取指定网站的图片,并保存到本地文件夹。作者通过解析目标网站的规则,设计并实现了爬虫代码,详细阐述了解析页面、提取图片链接、下载图片的过程,以及在编写代码时遇到的问题和解决方法。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?