AlexNet

:

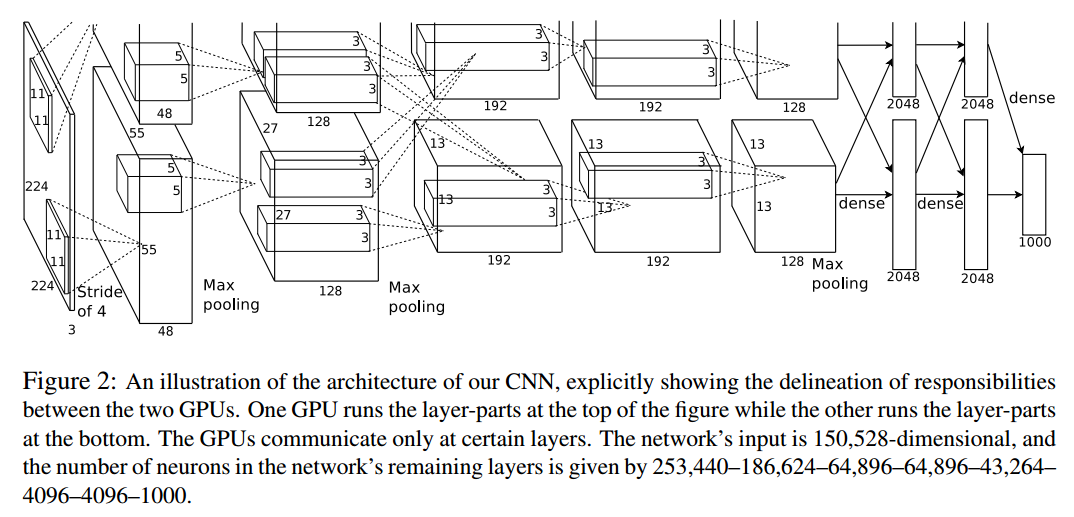

第一层:卷积层1,输入为 224×224×3 224 \times 224 \times 3224×224×3的图像,卷积核的数量为96,论文中两片GPU分别计算48个核; 卷积核的大小为 11×11×3 ; stride = 4, stride表示的是步长, pad = 0, 表示不扩充边缘;

卷积后的图形大小是怎样的呢?

wide = (224 + 2 * padding - kernel_size) / stride + 1 = 54

height = (224 + 2 * padding - kernel_size) / stride + 1 = 54

dimention = 96

然后进行 (Local Response Normalized), 后面跟着池化pool_size = (3, 3), stride = 2, pad = 0 最终获得第一层卷积的feature map

最终第一层卷积的输出为 27x27x96

第二层:卷积层2, 输入为上一层卷积的feature map, 卷积的个数为256个,论文中的两个GPU分别有128个卷积核。卷积核的大小为:5×5×48 ; pad = 2, stride = 1; (27-5+2*2)/1+1=27 27x27x128两组 然后做 LRN, 最后 max_pooling, pool_size = (3, 3), stride = 2;(27-3)/2+1=13 13x13x128两组

第三层:卷积3, 输入为第二层的输出,卷积核个数为384, kernel_size = (3×3×256), padding = 1, (13-3+1*2)/1+1=13 第三层没有做LRN和Pool 13x13x192两组

第四层:卷积4, 输入为第三层的输出,卷积核个数为384, kernel_size = (3×3), paddin

本文详细介绍了AlexNet的网络结构,包括各层的卷积参数、局部响应归一化、最大池化等操作,以及全连接层和最后的softmax输出,用于ImageNet的1000类分类任务。

本文详细介绍了AlexNet的网络结构,包括各层的卷积参数、局部响应归一化、最大池化等操作,以及全连接层和最后的softmax输出,用于ImageNet的1000类分类任务。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

393

393

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?