部分图片及教程源自

bilibili-等等很简单

1、决策树简介

决策树(Decision Tree)是在已知各种情况发生概率的基础上,通过构成决策树来求取净现值的期望值大于等于零的概率,评价项目风险,判断其可行性的决策分析方法,是直观运用概率分析的一种图解法。由于这种决策分支画成图形很像一棵树的枝干,故称决策树。在机器学习中,决策树是一个预测模型,他代表的是对象属性与对象值之间的一种映射关系。Entropy = 系统的凌乱程度,使用算法ID3, C4.5和C5.0生成树算法使用熵。这一度量是基于信息学理论中熵的概念。

百度百科-决策树

2、如何构建决策树

1、决策树是解决分类问题的一种算法

我们可以简单的根据左边的数据来构建了右边这一棵决策树

(1)前置知识:

1、通过属性构建节点

属性可以分为二元属性、多元属性和序数属性

2、属性选择时用什么指标度量(如何选择属性)?

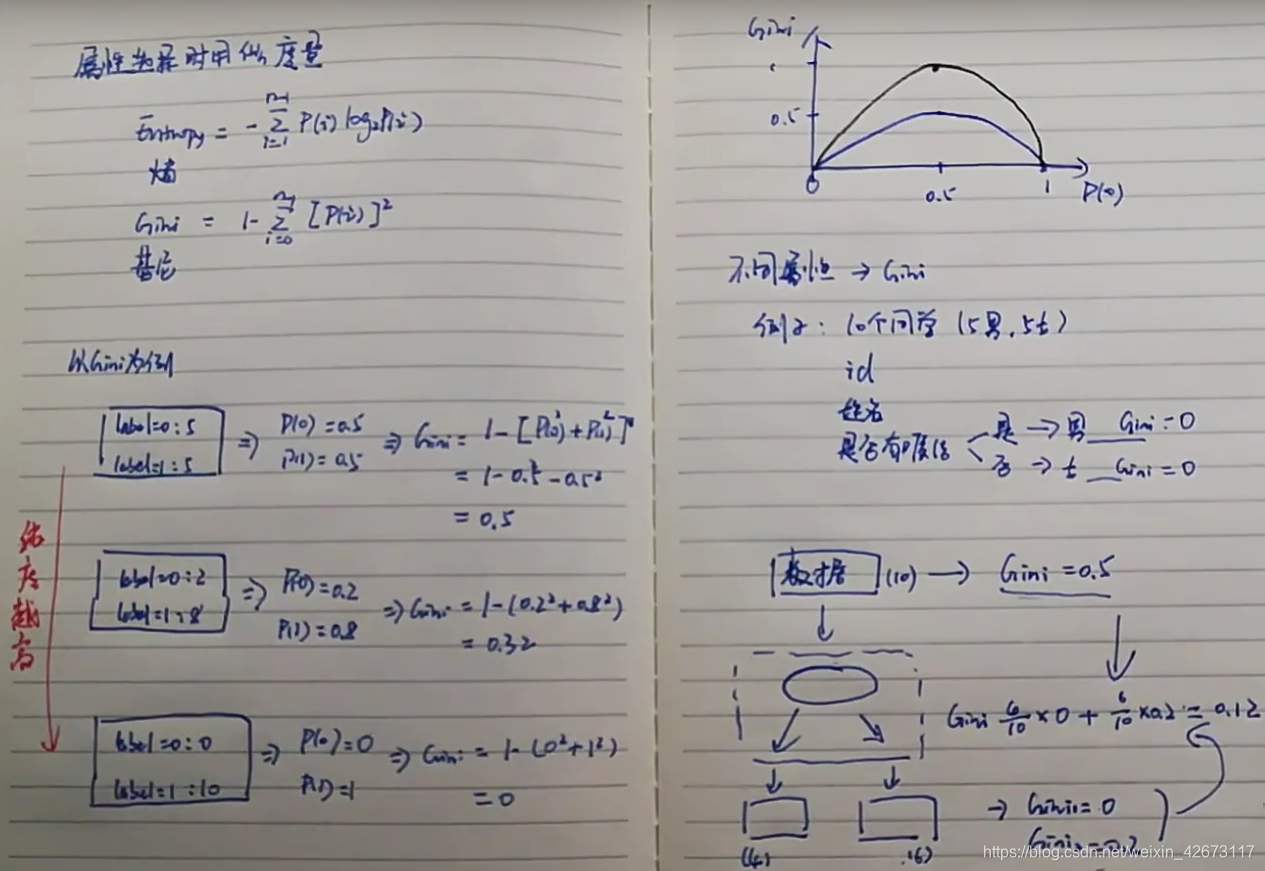

选择方式主要有熵和基尼系数两种,以下是两种的计算方法

Gini的图中,黑色曲线为熵

总结:如果某一个属性中各个数据得到的基尼系数都非常小,说明属性是非常好的一个区分类别的属性

一组数据如果基尼系数很大,可以通过一些方法划分为多个属性,使得最终的属性基尼系数加权平均较小,即纯度变高

(2)构建决策树

1、选择根节点

按照基尼系数,选择较小的作为根节点

2、选择内部节点

比如在计算未婚的下一个节点,我们会去除已婚节点的数据,然后从其他数据中计算是否有房等数据(注意是去除已婚人群之后,重新计算)

结果如下,可以自行计算验证:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?