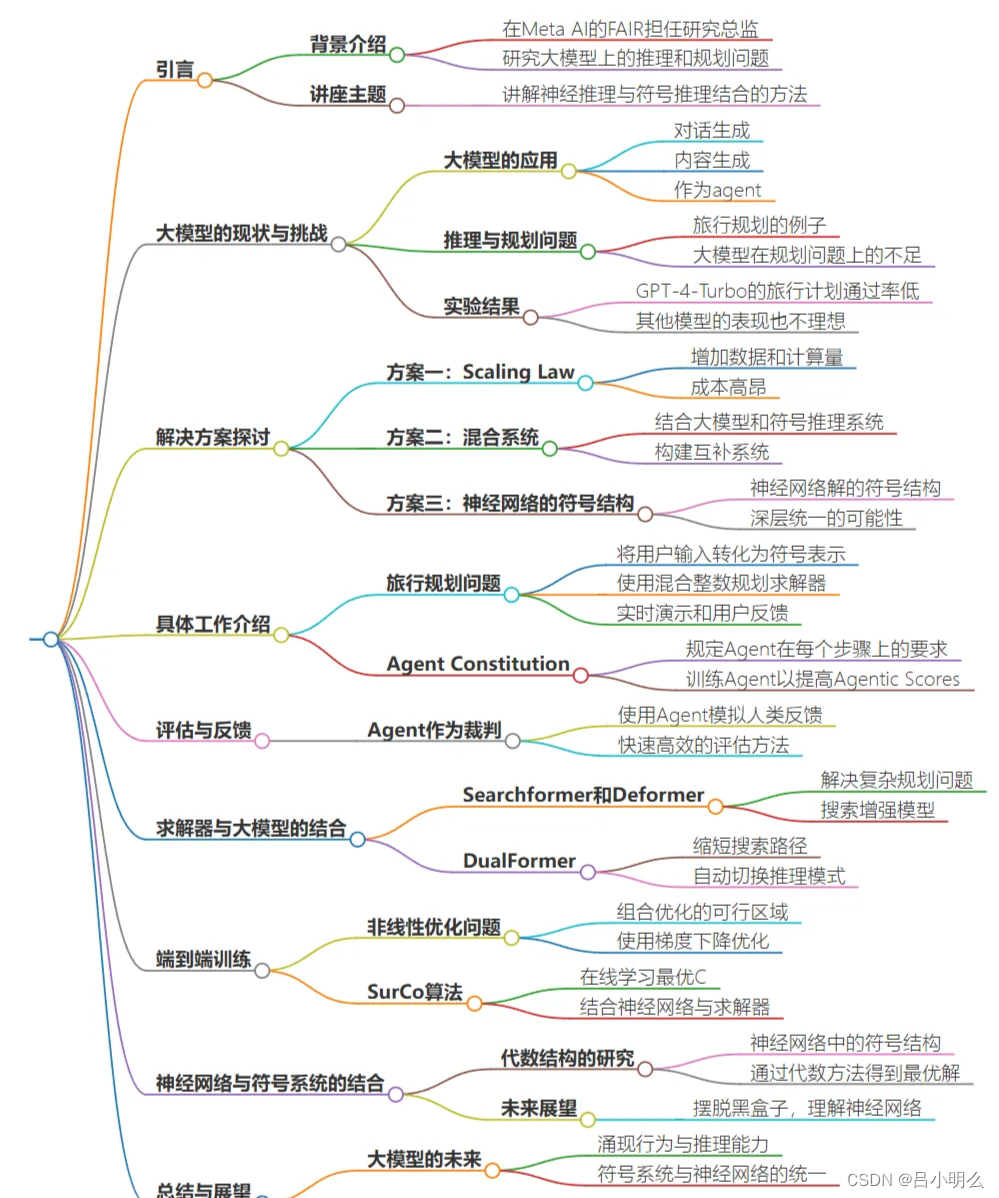

近日,在Meta FAIR担任研究总监的田渊栋在某站上分享了近期一系列关于符号推理与神经网络推理两者间在不同复杂推理任务上的计算差异、性能优劣甚至未来融合统一的研究成果。

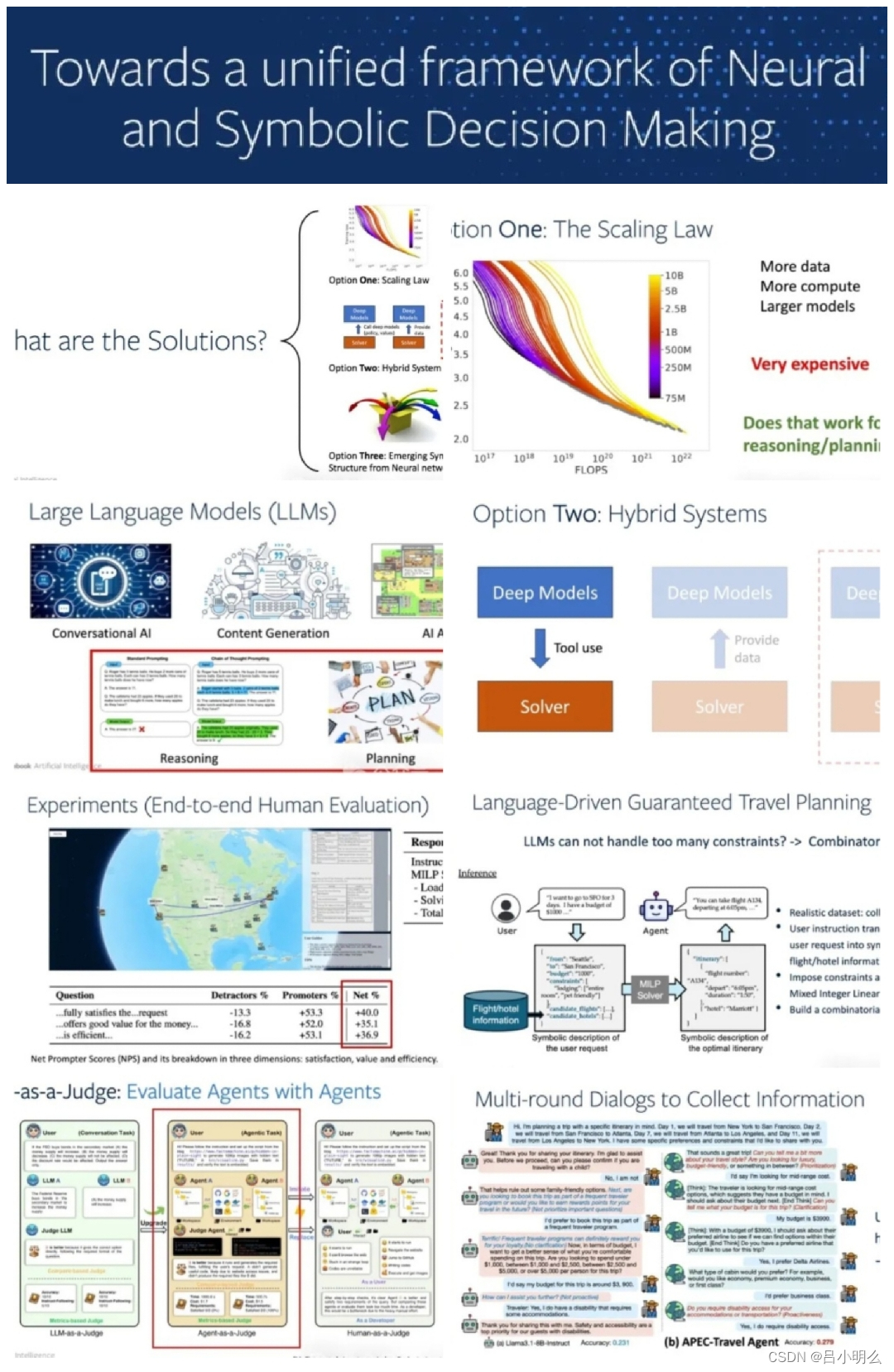

讲者开门见山的从LLM当前核心功能-复杂推理&规划入手展开,引出AI应用于复杂认识推理可能的3个渐进式演化options(Scaling Law/Hybrid System/Emerging Symbol&Neural),并首先拿Agent常见领域-旅行规划任务着手,从option1带入到option2…

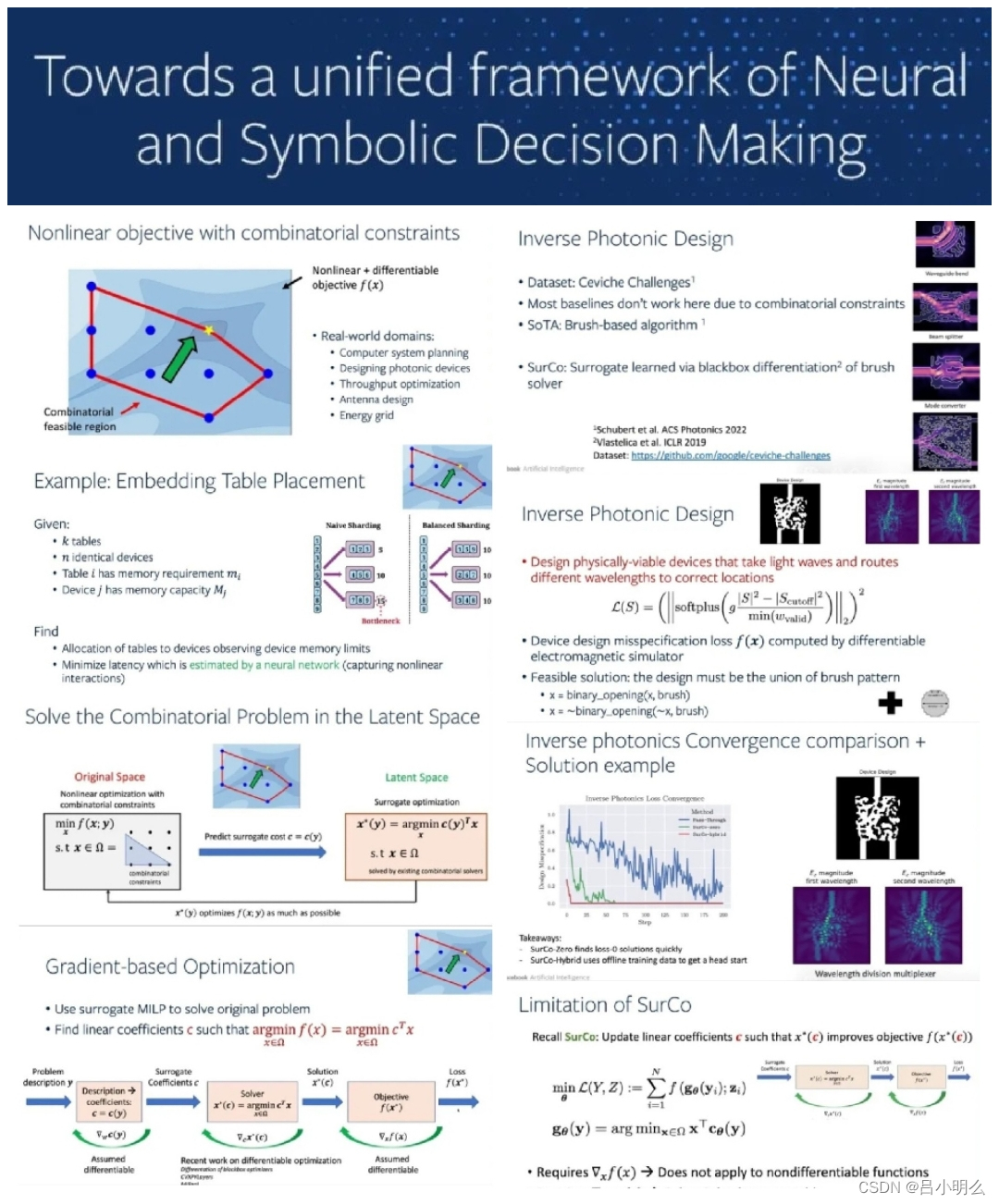

在Option2的第一个子路线中,通过引用一篇EMNLP24的Demo论文对于旅行规划任务中所采用的混合整数规划(Mixed Integer Linear Programming,MILP)求解器对比与分析了symbol&neural在推理求解性能及Agent灵活性的运用探索。- 这里算是对上述Option2的一小步探索与尝试,即尝试将形式化的符号推理范式嵌入拼接到DNN中来,但其中的形式化符号内涵并未展开。

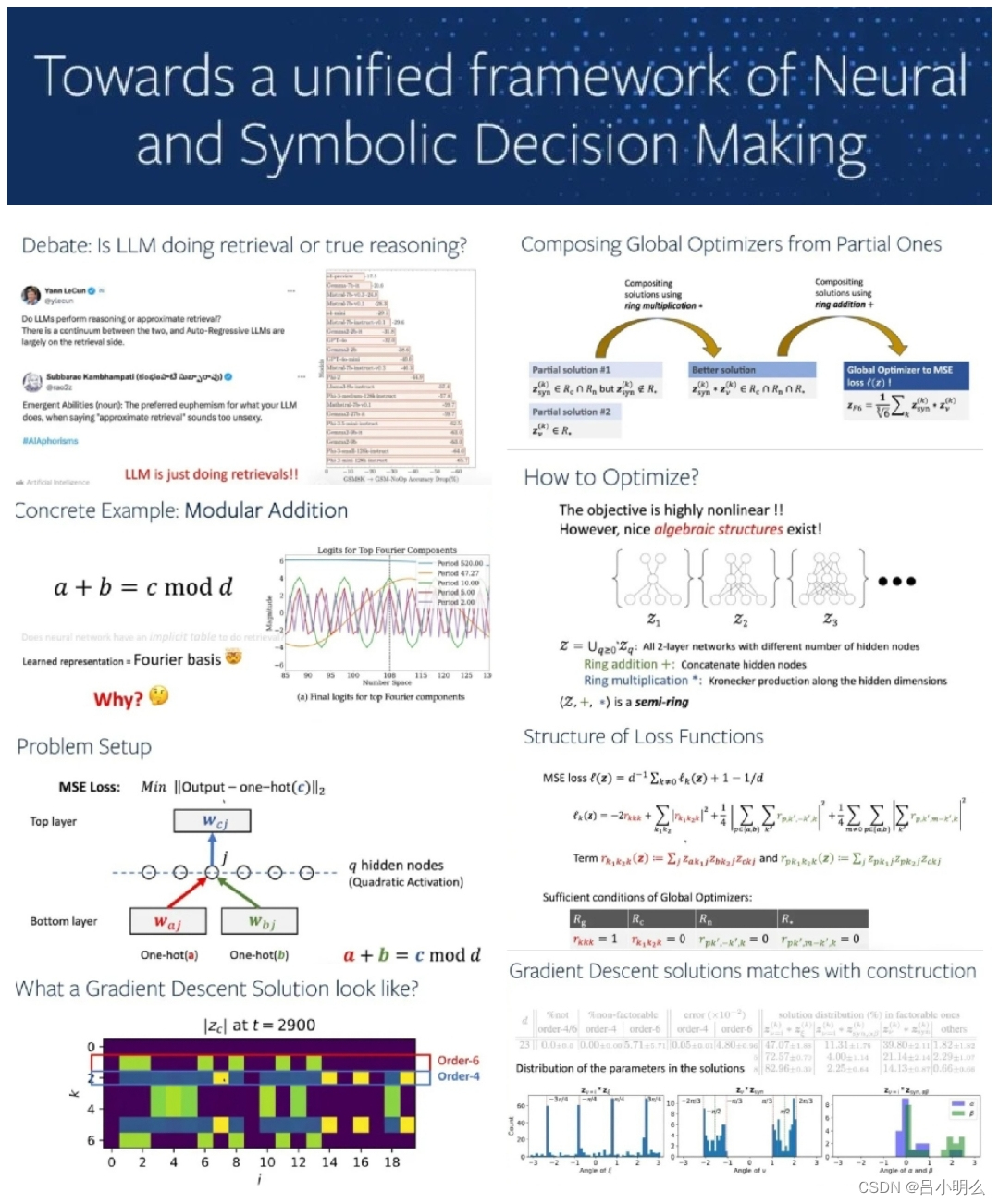

随后,在Option2的第二个子路线中,讲者抛出了近期的系列工作:采用Searchformer和Deformer形式化求解器应用于经典的走迷宫和推箱子的复杂推理与规划问题。这里的形式化求解器即大家所熟知的A*,并通过实验印证solution-only model与search-augmented model两种推理范式Scaling Law的不同 (注:在这里个人认为并不单单是两种范式下scaling law的不同,而本质是由于来自底层数据所呈现的分布上差异造成的)。

当然大家这里可以很自然的想象到:对于后者的范式,可以采用RL思想继续探索采样与利用,并进一步寻求最优/短路径以增强模型,实现超越A*求解器的思路,到这里相信大家也看到了些许o1的影子;)

- 个人观点:上述本质是进一步参数化压缩模型内的neural链接,这里未来亦将会有很大的探索空间和研究价值,也与本讲座的Option3有一定的关联…另外,在这里其实我个人也有着对这种进一步的对数据采样到模型压缩路径的不安,即是这种采样与压缩也许会扰乱真实世界中所固有的泛化涟漪或会给模型掌握真实流形分布带来挑战。

因此篇讲解内容丰富,共分为上中下三篇为大伙解读,本篇为上篇,小伙伴们敬请期待后续…

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?