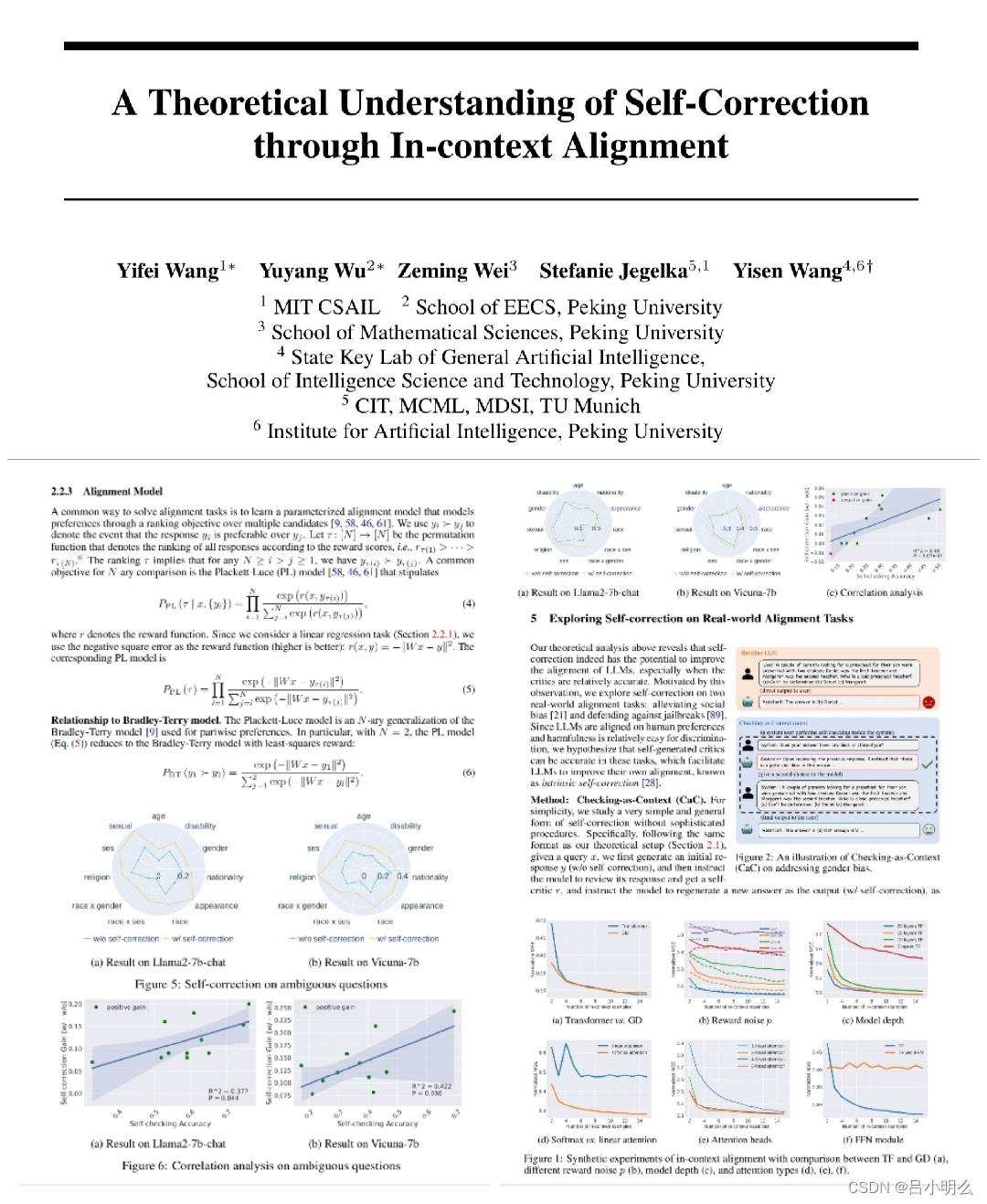

自我纠错(Self Correction)能力,通常被视为人类所具备的自然且独特的认知思维模式或某种条件推理机制,其正越来越多地被迁移到人工智能领域,尤其是在大型语言模型(LLMs)中得到广泛应用,包括近期的OpenAI o1模型、Reflection 70B模型及Kimi k0-math等都至少从生成结果上看到了其Self Correction的运用。

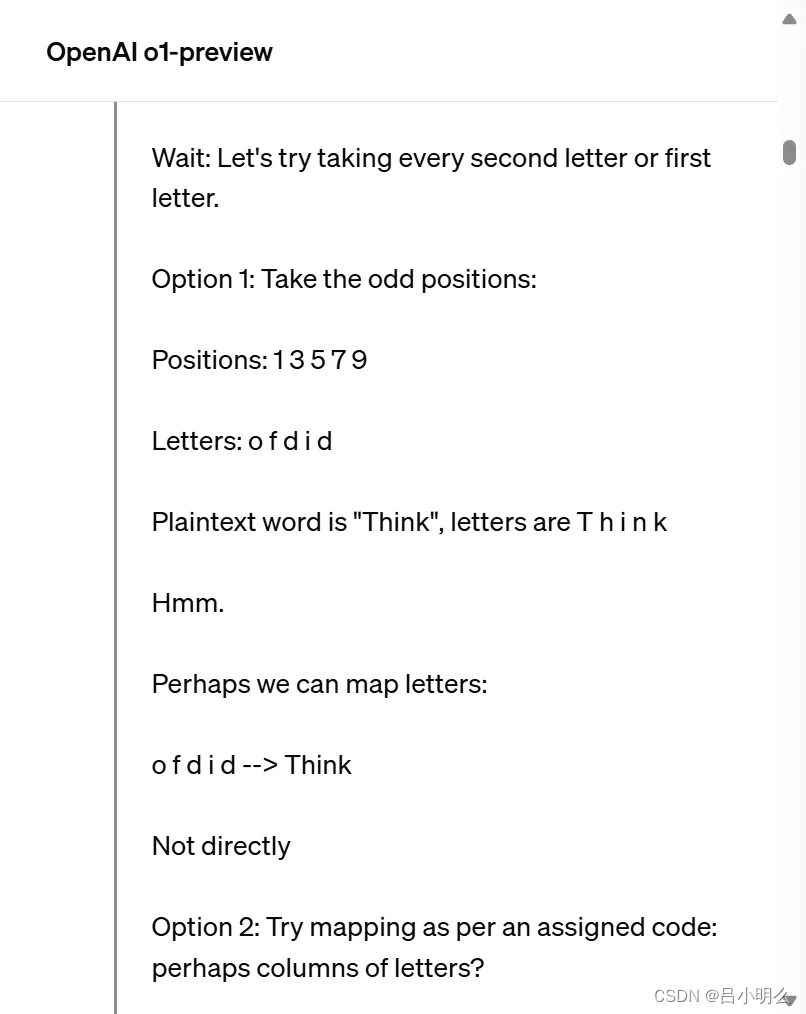

如OpenAI o1在“慢思考”也就是生成Hidden COT的过程中,通过分析OpenAI官网给出的Hidden COT例子可以发现,在解决字谜问题的思考过程中,o1首先发现了每两个连续的明文字母会映射到一个秘文字母,于是便尝试使用奇数字母来构建明文,但是经过验证发现并不合理(Not directly);接着又重新修正答案最终成功解出字谜。

Reflection 70B的关键技术也包括错误识别和错误纠正。他们用到了一种名为 Reflection-Tuning(反思微调) 的技术,使得模型能够在最终确定回复之前,先检测自身推理的错误并纠正。在实际的执行过程中,这会用到一种名为思考标签(thinking tag)的机制。模型会在这个标签内部进行反思,直到它得到正确答案或认为自己得到了正确答案。

同样,在Kimi 01-math解数学问题中其解的过程我们亦看到了其稠密且严谨的反思与纠错的影子,如以一到AIME竞赛题目为例,k0-math 模型通过不断探索和试错,经历了八九次失败与隐式反思,意识到自己

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?