简介:微服务架构通过将应用分解为独立、可单独部署的服务来提升大型企业级应用的开发效率和可伸缩性。Python因库支持和社区力量成为构建微服务的优选语言。本文详细探讨了实现Python微服务的关键技术,如服务间通信、容器化、服务发现、负载均衡、消息队列、CI/CD、监控、数据库设计、服务治理及安全性等,并通过分析Python微服务项目实例来加深理解。

1. 微服务架构概念与优势

1.1 微服务架构的定义

微服务架构(Microservices Architecture)是一种设计方法,其中应用被构建为一组小的、独立的服务,每个服务实现特定的业务功能,并通过轻量级的通信机制互相协作。这种架构风格鼓励服务的细粒度分解,从而提高了系统的可维护性和可扩展性。

1.2 微服务架构的核心原则

微服务架构的原则强调服务自治、业务能力的分解、去中心化治理、持续交付和容错性。这些原则不仅指导了微服务的设计和开发,还影响了它们的部署和运维。

1.3 微服务架构的优势

采用微服务架构的系统具有诸多优势,比如:更强的伸缩性、更好的故障隔离、独立的服务部署、技术栈的多样性以及快速迭代的能力。这使得微服务成为构建大规模分布式系统和满足现代云应用需求的理想选择。

微服务架构改变了我们构建和运行大型复杂系统的方式,它促进了业务敏捷性和技术模块化的紧密结合,为IT组织带来了前所未有的灵活性和效率。

2. Python微服务实践关键知识点

2.1 微服务架构的组件模型

2.1.1 服务的定义和边界

在微服务架构中,服务通常是一个独立的、可部署的组件,它负责实现特定的业务功能。每个服务都应遵循单一职责原则,即一个服务只做一件事情,确保服务之间具有最小的耦合度。服务的边界应该清晰地定义,使得服务之间的交互尽可能简单和高效。

为了确定服务的边界,可以采用领域驱动设计(DDD)的方法。这种方法强调从业务角度出发,将系统划分为多个领域,每个领域对应一个或多个服务。通过定义领域、子领域和聚合等概念,可以有效地分离业务逻辑,进而划分出独立的服务。

表:服务定义与边界划分

| 标准 | 描述 | 关键点 | | --- | --- | --- | | 业务能力 | 服务应该围绕业务能力进行组织 | 领域、子领域、聚合 | | 数据一致性 | 服务应维护数据的一致性 | 数据库事务、分布式事务管理 | | 高内聚、低耦合 | 服务内部应高度内聚,服务间耦合度应低 | 接口定义、消息队列 | | 可扩展性 | 服务应当容易扩展 | 服务拆分、API设计 |

2.1.2 微服务间通信机制

微服务间的通信机制是架构成功的关键。常见的通信机制包括同步通信和异步通信。

同步通信通常使用HTTP/REST或gRPC等协议。REST是一种广泛使用的方法,它基于HTTP协议,易于理解和使用。gRPC基于HTTP/2协议,支持多种编程语言,并且能提供高效的序列化机制。

异步通信通常使用消息队列,比如RabbitMQ或Kafka。消息队列可以解耦服务间的直接依赖,提供消息的异步处理能力,并且有助于实现服务的扩展性。

图:同步与异步通信机制

graph LR

A[客户端] -->|同步| B[服务A]

B -->|异步消息| C[消息队列]

C -->|异步消息| D[服务B]

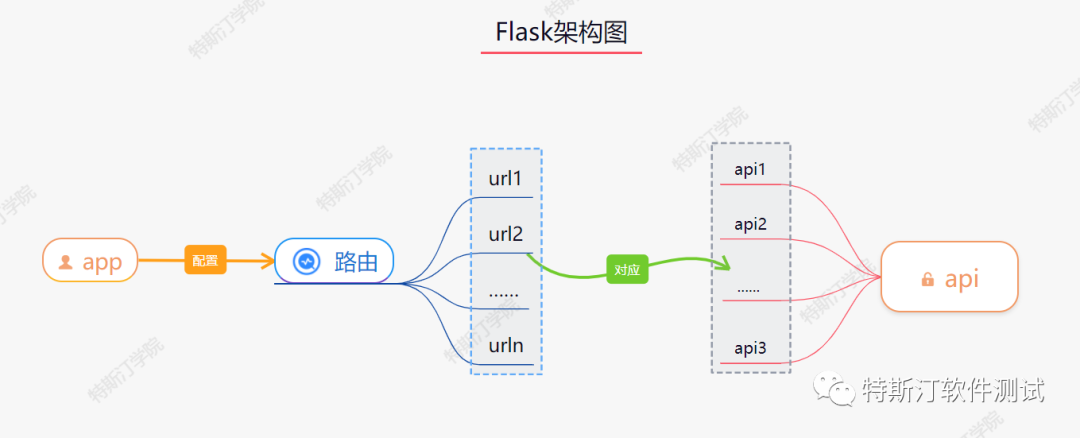

在Python中,可以使用Flask或Django等Web框架来构建RESTful API,实现同步通信。对于异步通信,可以使用 aiokafka 或 asyncio 库来与消息队列交互。

代码块:使用Flask创建RESTful API

from flask import Flask, jsonify, request

app = Flask(__name__)

@app.route('/serviceA', methods=['GET'])

def serviceA():

# 处理业务逻辑

result = "Example result from Service A"

return jsonify(result=result)

if __name__ == '__main__':

app.run(debug=True)

在上面的代码示例中,创建了一个简单的Flask应用,定义了一个GET请求的API接口 /serviceA 。这只是一个例子,实际的服务可能涉及更复杂的业务逻辑和数据处理。

2.2 Python在微服务中的应用

2.2.1 Python与微服务框架的选择

Python语言因其简洁的语法、丰富的库和强大的社区支持,成为开发微服务架构的理想选择之一。在选择Python微服务框架时,开发者通常会考虑以下几个因素:

- 性能 :框架需要能够提供足够的性能来处理业务需求。

- 成熟度 :框架的成熟度和社区活跃度是评价一个框架是否值得信赖的重要指标。

- 扩展性 :框架应能支持应用的水平扩展,以便在流量增加时提高服务处理能力。

目前,比较流行的Python微服务框架包括但不限于Flask, FastAPI, 和Django REST framework。这些框架各有优势,例如:

- Flask :轻量级框架,灵活且易于使用,适合快速开发小到中等规模的应用。

- FastAPI :基于Python类型提示,提供高效的自动文档生成和数据验证功能。

- Django REST framework :Django的扩展,提供强大的认证和权限管理功能。

表:Python微服务框架对比

| 框架 | 描述 | 性能 | 成熟度 | 扩展性 | | --- | --- | --- | --- | --- | | Flask | 轻量级Web应用框架 | 较好 | 高 | 低 | | FastAPI | 基于类型提示的高性能框架 | 高 | 中 | 中 | | Django REST framework | 基于Django的全功能Web框架 | 较好 | 高 | 中 |

2.2.2 Python微服务的性能考量

Python微服务的性能考量主要涉及代码优化、资源管理、并发处理等方面。代码优化可以通过使用更加高效的算法和数据结构来实现。此外,Python的全局解释器锁(GIL)可能会成为性能瓶颈,尤其是在CPU密集型任务上。利用多进程或多线程模型可以帮助绕过GIL限制。

资源管理方面,应该注意内存使用情况和对象创建销毁的频率。例如,利用对象池可以有效减少内存分配和垃圾回收的开销。在Web服务中,合理配置线程池和工作进程的数量对于提高服务性能至关重要。

并发处理可以通过异步编程实现。异步IO库如 asyncio 提供了非阻塞的IO操作能力,可以大幅提升服务响应速度。在实际的微服务开发中,合理选择同步或异步处理模型,以及相关的技术实现,是提升系统性能的关键。

代码块:使用 asyncio 库实现异步IO

import asyncio

async def main():

# 异步执行的代码块

await some_async_io()

# 事件循环的启动和管理

asyncio.run(main())

在上述代码中,使用了 asyncio 库来定义并执行一个异步函数 main 。 asyncio.run(main()) 负责启动事件循环,并管理异步任务的执行。

以上内容概述了Python微服务实践中的关键知识点,包括微服务的组件模型和服务间通信机制,以及Python在微服务架构中的应用。在下一章节中,我们将进一步探索RESTful API的设计与实现,这是构建和扩展微服务时不可或缺的一部分。

3. RESTful API 通信实现

3.1 RESTful API 设计原则

3.1.1 资源的表述与状态转换

REST(Representational State Transfer,表现层状态转换)架构是一种针对网络应用的设计风格和开发方式,其核心思想在于客户端和服务器之间存在一种“无状态”的交互协议。在这种协议下,网络上所有的资源(Resource)通过唯一的URL进行标识,并且资源的状态(State)通过HTTP协议中的GET、POST、PUT、DELETE等方法进行管理。这些方法也被称为CRUD(Create、Read、Update、Delete)操作。

RESTful API 设计时需要遵循以下原则:

- 统一接口:通过统一的接口规则,使得整个系统具有良好的一致性。

- 资源定位:资源通过URL来定位。

- 资源的表述:通过HTTP协议的头部(Headers)和体部(Body)传递资源的表述。

- 状态转移:资源的状态通过HTTP动词来改变。

3.1.2 RESTful API 的安全性考量

在设计RESTful API时,安全性是一个不能被忽视的重要因素。需要采取以下措施来确保安全性:

- 使用HTTPS协议而非HTTP协议,以确保传输过程中的数据加密和完整性。

- 通过身份验证机制,如OAuth或JWT(JSON Web Tokens),来保护API。

- 对敏感数据进行加密处理,防止数据在传输或存储过程中被窃取。

- 对请求的频率进行限制,避免API被恶意利用进行DDoS攻击。

- 对于公共接口,尽可能减少返回的数据量,并在数据中不包含不必要的信息。

3.2 使用Python实现RESTful API

3.2.1 Flask与Django REST framework

在Python中,有多个框架可以用来实现RESTful API,其中Flask和Django REST framework(DRF)是最流行的两个。Flask是一个轻量级的框架,拥有灵活的开发方式和简单的结构,适用于快速开发小型API服务。Django REST framework则为Django框架提供了强大的RESTful API开发工具,适合开发中大型的REST API项目。

Flask实现RESTful API示例

from flask import Flask, jsonify, request

app = Flask(__name__)

# 定义一个资源的内存数据库

posts = [

{'id': 1, 'title': 'Hello World', 'content': 'Hello World, this is RESTful API'}

]

# 获取所有资源

@app.route('/posts', methods=['GET'])

def get_posts():

return jsonify(posts)

# 获取单个资源

@app.route('/posts/<int:post_id>', methods=['GET'])

def get_post(post_id):

post = next((post for post in posts if post['id'] == post_id), None)

if not post:

return jsonify({'error': 'post not found'}), 404

return jsonify(post)

# 创建资源

@app.route('/posts', methods=['POST'])

def create_post():

new_post = request.get_json()

posts.append(new_post)

return jsonify(new_post), 201

# 更新资源

@app.route('/posts/<int:post_id>', methods=['PUT'])

def update_post(post_id):

post = next((post for post in posts if post['id'] == post_id), None)

if not post:

return jsonify({'error': 'post not found'}), 404

data = request.get_json()

post.update(data)

return jsonify(post)

# 删除资源

@app.route('/posts/<int:post_id>', methods=['DELETE'])

def delete_post(post_id):

global posts

posts = [post for post in posts if post['id'] != post_id]

return jsonify({'result': True})

if __name__ == '__main__':

app.run(debug=True)

在上述代码中,我们创建了一个简单的RESTful API服务,可以进行资源的增删改查操作。

Django REST framework实现RESTful API示例

在DRF中,可以通过继承 ModelViewSet 或 APIView 类来快速实现RESTful API。DRF还自带了强大的权限和认证系统,以及序列化器(Serializer)功能,可以很容易地对数据进行处理。

from rest_framework import viewsets

from .models import Post

from .serializers import PostSerializer

class PostViewSet(viewsets.ModelViewSet):

queryset = Post.objects.all()

serializer_class = PostSerializer

def perform_create(self, serializer):

serializer.save(owner=self.request.user)

3.2.2 API版本管理和文档生成

版本管理和文档生成是RESTful API开发中不可或缺的部分。保持API的向后兼容性是非常重要的,这通常通过使用版本号来管理。API的版本可以体现在URL中(如 /api/v1/posts ),也可以通过HTTP请求头中的 Accept 来指定。

文档生成工具如Swagger(现在称为OpenAPI)可以帮助我们自动生成API文档。在Python中,可以使用drf-yasg这样的工具来结合Django REST framework自动生成API文档。

# 在settings.py中添加

INSTALLED_APPS = [

# ...

'drf_yasg',

]

REST_FRAMEWORK = {

# ...

'DEFAULT_VERSIONING_CLASS': 'rest_framework.versioning.NamespaceVersioning',

'DEFAULT_RENDERER_CLASSES': (

'rest_framework.renderers.JSONRenderer',

'rest_framework.renderers.BrowsableAPIRenderer',

),

}

# 在urls.py中添加

from drf_yasg.views import get_schema_view

from drf_yasg import openapi

schema_view = get_schema_view(

openapi.Info(

title="Snippets API",

default_version='v1',

description="Test description",

terms_of_service="https://www.google.com/policies/terms/",

contact=openapi.Contact(email="contact@snippets.local"),

license=openapi.License(name="BSD License"),

),

public=True,

)

urlpatterns = [

# ...

path('swagger(?P<format>\.json|\.yaml)', schema_view.without_ui(cache_timeout=0), name='schema-json'),

path('swagger/', schema_view.with_ui('swagger', cache_timeout=0), name='schema-swagger-ui'),

path('redoc/', schema_view.with_ui('redoc', cache_timeout=0), name='schema-redoc'),

]

通过上述配置,我们可以自动生成API的在线文档,并且支持Swagger UI和ReDoc两种不同的展示风格。这不仅为开发人员提供了方便,同时也提高了API使用者的体验。

综上所述,RESTful API的实现需要我们严格遵守其设计原则,并考虑到安全性问题。通过Python的Flask和Django REST framework,我们可以有效地创建RESTful服务,并通过工具如drf-yasg自动生成和展示API文档。

4. Docker容器化与编排

Docker作为容器化技术的领头羊,为微服务架构的部署和管理带来了前所未有的便利。它通过创建轻量级、可移植的容器来封装应用程序,从而实现了开发环境与生产环境的一致性。而Kubernetes作为容器编排领域的佼佼者,它使得大规模容器集群的管理变得更加高效和灵活。本章将深入探讨Docker的基础知识、环境搭建、以及Kubernetes在微服务中的应用。

4.1 Docker基础与环境搭建

Docker的出现极大地简化了应用的打包、分发和运行过程。了解Docker镜像与容器管理的原理,是每一位希望在微服务架构中运用Docker技术的开发者和运维人员的必修课。

4.1.1 Docker镜像与容器管理

Docker镜像是一个只读模板,它包含了运行一个应用所需的文件系统、配置以及依赖。镜像在运行时会成为一个容器,容器则是一个隔离的运行环境,可以包含运行应用所需的一切。

使用Docker镜像时,首先需要从Docker Hub或其它注册中心拉取镜像到本地,然后可以基于这个镜像创建容器,并运行。

# 拉取Nginx镜像

docker pull nginx

# 创建并运行Nginx容器

docker run --name my-nginx -p 80:80 -d nginx

上面的命令创建了一个名为 my-nginx 的容器,将容器的80端口映射到宿主机的80端口,并在后台运行。

容器的管理也非常重要,Docker提供了丰富的命令来管理容器的生命周期,包括启动、停止、删除容器等。

4.1.2 Dockerfile编写与优化

Dockerfile是一个文本文件,包含了用户创建Docker镜像时需要执行的所有命令。编写Dockerfile是创建自定义Docker镜像的首选方式。

# 使用官方Python运行时作为父镜像

FROM python:3.8-slim

# 设置工作目录为/app

WORKDIR /app

# 将当前目录内容复制到位于/app中的容器里

COPY . /app

# 安装任何需要的包

RUN pip install --no-cache-dir flask

RUN pip install --no-cache-dir flask-cors

# 容器启动时执行app.py

CMD ["python", "app.py"]

通过合理的编写和优化Dockerfile,可以减小最终镜像的大小,提升容器启动的速度,进而优化部署效率。例如,使用多阶段构建可以只将运行应用所需的依赖和应用代码复制到最终镜像中,抛弃不必要的构建过程文件。

4.2 Kubernetes在微服务中的应用

Kubernetes作为Docker容器的编排工具,提供了一个平台,用于自动化容器化应用的部署、扩展以及管理。使用Kubernetes可以极大提升微服务架构的灵活性和可维护性。

4.2.1 Kubernetes核心概念解析

在深入Kubernetes的编排策略之前,必须了解几个核心概念:

- Pods :Pod是Kubernetes中的基本部署单元,一个Pod可以包含一个或多个容器,这些容器共享存储、网络以及它们的配置。

- Services :定义一组Pod的访问规则,通常与负载均衡结合使用。

- Deployments :用于部署更新Pod和ReplicaSets。

- ReplicaSets :管理Pod的副本数量,确保指定数量的Pod实例始终可用。

- Namespaces :用于隔离Kubernetes资源。

apiVersion: v1

kind: Pod

metadata:

name: myapp-pod

labels:

app: myapp

spec:

containers:

- name: myapp-container

image: busybox

command: ['sh', '-c', 'echo Hello Kubernetes! && sleep 3600']

以上是一个简单的Pod定义,它创建了一个包含一个容器的Pod,该容器基于 busybox 镜像运行。

4.2.2 编排策略与高可用配置

Kubernetes编排策略通常以声明式配置文件的形式存在,这些文件定义了所需的状态,Kubernetes系统会不断地调整实际状态,使其与期望状态保持一致。

在设置高可用的Kubernetes集群时,需要考虑多个方面,如Master节点的高可用、存储解决方案以及网络配置等。

apiVersion: v1

kind: Service

metadata:

name: myapp-service

spec:

type: LoadBalancer

ports:

- port: 80

targetPort: 8080

selector:

app: myapp

这是一个将内部Pods暴露给外部网络的服务定义。 LoadBalancer 类型服务会在支持的云平台上创建外部负载均衡器。

Kubernetes集群的高可用性还依赖于Etcd数据库的高可用配置,以及正确的网络插件选择。通过组合使用ReplicaSets、Deployments、Services和其他资源类型,可以在Kubernetes上构建出高可用、高可扩展的微服务架构。

通过本章节的介绍,我们对Docker的镜像和容器管理有了基本的认识,同时深入理解了Kubernetes的核心概念及其在微服务编排中的应用。Docker和Kubernetes不仅极大地简化了微服务的部署和维护过程,还为弹性伸缩、故障恢复、服务发现等高级功能提供了强大的支持。在下一章节中,我们将探索动态服务发现机制,这将为微服务架构的进一步解耦和高可用性打下坚实的基础。

5. 动态服务发现机制

5.1 服务发现机制原理

5.1.1 服务注册与发现模式

服务发现机制允许微服务架构中的服务动态地注册和发现其他服务。在微服务架构中,服务实例可能会频繁地启动、停止或迁移,服务发现模式能够确保服务的消费者(客户端)能够实时地找到服务的提供者(服务器)。服务注册和发现模式通常由服务注册中心(Registry)和客户端SDK组成。

服务注册中心是一个存储可用服务实例信息的数据库。当服务实例启动时,它会将自己的位置信息(例如IP地址和端口)注册到注册中心;当服务实例终止或不再可用时,它会从注册中心注销。客户端在发起服务请求之前,会先查询服务注册中心来获取服务实例的最新位置信息。

服务发现模式主要有以下几种:

-

客户端发现模式(Client-side discovery) :客户端负责决定调用哪个服务实例。客户端查询服务注册中心,获取所有可用的服务实例列表,然后根据负载均衡策略选择一个实例进行调用。

-

服务端发现模式(Server-side discovery) :客户端向一个服务端点发起请求,服务端会负责将请求转发到合适的服务实例。这种方式下,客户端不需要直接与服务注册中心交互,它只需要知道负载均衡器的地址。

5.1.2 常用服务发现工具对比

在实际项目中,有许多工具可以实现服务发现机制,如Consul、etcd、Zookeeper等。以下是这些工具的简要对比:

-

Consul :Consul由HashiCorp开发,支持多数据中心的强一致性服务发现,集成了健康检查功能。Consul的Web界面直观易用,支持K/V存储。

-

etcd :etcd是一个轻量级、分布式的键值存储系统,由CoreOS开发,它主要被用作服务配置的存储和共享,但在服务发现方面也有出色表现。

-

Zookeeper :Zookeeper是一个开源的分布式协调服务,由雅虎开发。虽然它主要用于配置管理、命名服务、分布式同步等场景,但在服务发现中也有广泛应用。

5.2 实现服务发现的实践操作

5.2.1 Consul的部署与使用

Consul以其高可用性、跨平台支持和易用性,成为许多组织实施服务发现的首选工具。以下是Consul的部署与使用的基本步骤:

-

下载并安装Consul : Consul的安装包可以从官方网站下载。在Linux系统中,可以通过以下命令下载最新版本并赋予执行权限:

bash wget https://releases.hashicorp.com/consul/1.8.1/consul_1.8.1_linux_amd64.zip unzip consul_1.8.1_linux_amd64.zip chmod +x consul sudo mv consul /usr/local/bin/ -

启动单个Consul实例 : 使用以下命令启动一个单节点的Consul服务器:

bash consul agent -server -bootstrap-expect=1 -data-dir=/tmp/consul -ui这将启动一个带有Web界面的本地服务器实例,可以通过浏览器访问http://localhost:8500查看。 -

注册服务 : Consul服务可以通过HTTP API、命令行工具或者配置文件进行注册。例如,使用命令行注册一个服务:

bash consul services register -name=my-service -address=127.0.0.1 -port=8080这条命令会在Consul服务注册表中注册一个名为my-service的服务,监听在本地的8080端口。

5.2.2 服务健康检查与故障转移

Consul还支持服务的健康检查,可以用来确保服务实例在运行并且可以正确响应请求。如果一个服务实例失败了,Consul可以自动将其从服务发现列表中移除,这样客户端就不会被路由到不可用的服务实例上。

-

健康检查配置 : 在服务注册时可以指定健康检查,例如,可以配置一个HTTP检查来验证服务实例的响应状态:

bash consul services register -check http://127.0.0.1:8080/health -name=my-service这个命令会检查服务实例的/health端点,如果服务实例停止响应,则Consul会标记为不健康状态。 -

故障转移 : Consul通过故障转移机制保证了服务的可用性。当服务实例变得不可用时,通过配置的负载均衡器或客户端SDK将请求重定向到健康的实例。这确保了即使在某些服务实例出现故障的情况下,整个微服务架构也能保持正常运行。

通过以上实践操作,我们可以看到,Consul不仅提供了服务发现的基础设施,而且通过健康检查和故障转移等机制,提高了微服务架构的弹性和可靠性。

6. 高可用性负载均衡技术

随着互联网业务的快速发展和用户规模的不断扩张,如何保障服务的高可用性成为企业面临的一个重要课题。负载均衡技术是提升服务可用性、扩展性和性能的关键技术之一。本章节将详细介绍负载均衡的基础知识、类型选择、性能指标以及实现高可用负载均衡的配置实践。

6.1 负载均衡基础

在进入复杂的技术实践之前,理解负载均衡的基本概念和性能指标是至关重要的。负载均衡是一种提高系统可靠性和可扩展性的技术,它主要通过合理分配外部请求到后端多台服务器上,从而实现系统的负载分担。

6.1.1 负载均衡的类型与选择

负载均衡可以根据其部署位置和服务方式大致分为以下几种类型:

- 软件负载均衡 :部署在通用硬件或虚拟机上,如Nginx和HAProxy,适用于中小规模部署,成本较低。

- 硬件负载均衡 :专业的负载均衡器设备,如F5和A10,适用于大规模、高并发的环境,性能高但成本昂贵。

- 云服务负载均衡 :由云服务提供商提供的负载均衡服务,如AWS的ELB和Azure的Load Balancer,便于扩展,使用灵活。

选择合适的负载均衡方式需要综合考虑业务规模、性能需求和成本预算。

6.1.2 负载均衡的性能指标

负载均衡器的性能指标对系统整体的稳定性有着直接的影响,关键指标包括:

- 吞吐量(Throughput) :单位时间内能处理的请求量。

- 响应时间(Latency) :请求从发送到接收响应的时间。

- 会话持久性(Session Persistence) :确保用户的连续操作能被同一服务器处理。

- 故障转移(Failover) :当某台后端服务器出现故障时,负载均衡器能快速切换到其他服务器。

了解这些指标有助于评估和选择最适合的负载均衡解决方案。

6.2 实现高可用负载均衡

高可用性是衡量负载均衡器性能的一个重要指标。本小节将详细介绍如何使用流行的开源负载均衡器Nginx和HAProxy来配置实现高可用负载均衡。

6.2.1 Nginx与HAProxy的配置实践

Nginx配置实践

Nginx是一个高性能的HTTP和反向代理服务器,也可以作为负载均衡器使用。以下是一个简单的Nginx负载均衡配置示例:

http {

upstream myapp1 {

server srv1.example.com;

server srv2.example.com;

server srv3.example.com;

}

server {

listen 80;

location / {

proxy_pass http://myapp1;

}

}

}

HAProxy配置实践

HAProxy是一种专业的负载均衡器,以高可用性著称。以下是一个HAProxy的负载均衡配置示例:

frontend http_front

bind *:80

mode http

option httplog

default_backend servers

backend servers

mode http

balance roundrobin

server server1 192.168.0.1:80 check

server server2 192.168.0.2:80 check

server server3 192.168.0.3:80 check

配置负载均衡器时,需要注意后端服务器的健康检查机制,确保能及时发现故障并进行故障转移。

6.2.2 基于云服务的负载均衡解决方案

在云服务环境下,负载均衡的实现更为便捷,因为云服务提供商通常会提供现成的负载均衡服务。以AWS的Elastic Load Balancing (ELB)为例:

AWS ELB配置

- 创建一个新的负载均衡器实例。

- 选择相应的负载均衡类型(如Application Load Balancer)。

- 配置监听器,指定端口和协议。

- 添加后端服务器实例到目标组。

- 设置健康检查参数以确保高可用性。

以上步骤完成后,ELB会自动处理流量分发和故障转移,简化了管理过程,同时提供了良好的扩展性。

本章节涵盖了负载均衡的基础知识、性能指标、以及Nginx与HAProxy的具体配置实践,最后介绍了云服务中负载均衡的实现方式。通过本章的学习,读者应能够理解负载均衡技术的原理,并具备在不同环境下实现高可用负载均衡的能力。

7. 异步消息队列的应用

在微服务架构中,异步消息队列是关键的组件之一,它促进了服务间的解耦和异步通信,从而提高了系统的可伸缩性和可靠性。本章将深入探讨消息队列的基本概念、在微服务中的应用以及如何选择适合的消息队列解决方案。

7.1 消息队列的基本概念

7.1.1 消息模型与异步通信

消息队列通过消息模型提供了异步通信机制,允许系统不同部分之间的消息传递。这种模型极大地提高了系统的解耦能力,使得服务可以在不直接相互依赖的情况下工作。在消息模型中,有两个主要组件:

- 消息生产者(Producer) :生成并发送消息到队列的组件。

- 消息消费者(Consumer) :从队列中接收并处理消息的组件。

生产者和消费者之间通过消息队列进行通信,而不必直接交互,这使得系统具有更好的可扩展性和容错性。

7.1.2 消息队列的选择标准

选择合适的消息队列服务对于系统的性能和稳定性至关重要。以下是选择消息队列时应考虑的关键因素:

- 性能 :消息吞吐量和延迟是重要的性能指标。

- 可靠性 :消息是否会被丢失以及如何处理故障。

- 支持的协议和语言 :消息队列应该支持你的应用程序使用的协议和编程语言。

- 可伸缩性和弹性 :系统是否能够轻松地处理负载的变化。

- 管理与监控 :是否有直观的管理界面和监控工具来帮助运维团队。

7.2 消息队列在微服务中的实现

7.2.1 RabbitMQ与Kafka的应用案例

在微服务架构中,RabbitMQ和Kafka是两个广泛使用的消息队列系统。它们各自有不同的特性,适用于不同场景。

RabbitMQ :是一个由erlang开发的开源消息代理,它实现了一个称为高级消息队列协议(AMQP)的协议。RabbitMQ以稳定和可靠而著称,适用于需要消息保证送达的应用场景。

以下是一个RabbitMQ的Python代码示例:

import pika

# 创建连接

connection = pika.BlockingConnection(pika.ConnectionParameters('localhost'))

channel = connection.channel()

# 声明队列

channel.queue_declare(queue='hello')

# 发送消息

channel.basic_publish(exchange='',

routing_key='hello',

body='Hello World!')

# 关闭连接

connection.close()

Kafka :是一个分布式的流处理平台,它主要用于构建实时数据管道和流应用程序。Kafka能够处理高吞吐量的消息,并且是分布式的,这使其在大数据场景中非常有用。

7.2.2 消息队列的事务管理与故障恢复

消息队列的事务管理和故障恢复是保证消息可靠性的关键。大多数消息队列都提供了确认(ACK)机制来确保消息的正确处理。

以RabbitMQ为例,消息队列支持事务的处理,可以保证消息只被处理一次:

import pika

def callback(ch, method, properties, body):

print("Received %r" % body)

# 模拟处理消息

ch.basic_ack(delivery_tag=method.delivery_tag)

connection = pika.BlockingConnection(pika.ConnectionParameters('localhost'))

channel = connection.channel()

channel.queue_declare(queue='hello')

channel.basic_consume(queue='hello', on_message_callback=callback, auto_ack=False)

print(" [*] Waiting for messages. To exit press CTRL+C")

channel.start_consuming()

在生产环境中,消息队列的故障恢复策略需要周密设计。例如,可以为消费者配置定时任务来检查和重新处理失败的消息,或者使用消息队列提供的死信队列(DLQ)功能来处理无法处理的消息。

通过合理地设计和实现消息队列的应用,微服务架构可以实现更高的稳定性和灵活性,从而更好地应对复杂的业务需求和用户流量的变化。

简介:微服务架构通过将应用分解为独立、可单独部署的服务来提升大型企业级应用的开发效率和可伸缩性。Python因库支持和社区力量成为构建微服务的优选语言。本文详细探讨了实现Python微服务的关键技术,如服务间通信、容器化、服务发现、负载均衡、消息队列、CI/CD、监控、数据库设计、服务治理及安全性等,并通过分析Python微服务项目实例来加深理解。

153

153

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?