简介:操作系统实习是计算机科学领域的一项关键实践,特别是西北农林科技大学(简称“西农”)为学生提供了深入了解操作系统原理、设计思想和实现方法的机会。学生将学习包括进程管理、内存管理、文件系统和设备驱动在内的核心概念,并通过实际操作提升编程与调试技能。本项目涵盖了操作系统设计的各个方面,通过理论与实践相结合的方式,旨在培养学生具备设计和维护复杂系统的能力,强化编程技巧,为未来职业生涯打下坚实基础。

1. 操作系统基本原理学习

操作系统是计算机系统的核心软件,它管理硬件资源,提供用户友好的接口,确保计算机系统的高效、稳定运行。在本章中,我们将深入探讨操作系统的内部工作原理,包括进程管理、内存管理、文件系统以及设备驱动程序等关键领域。本章为全书的基础,旨在为读者奠定坚实的理论基础,以便在后续章节中能更好地理解和实践操作系统的设计与实现。

1.1 操作系统概述

操作系统(Operating System,OS)是一种控制和管理计算机硬件与软件资源的程序,提供用户与计算机交互的平台。它负责资源分配、任务调度、输入输出管理、文件系统管理以及安全控制等功能。理解操作系统的运作机制对于开发高效的应用程序和服务至关重要。

1.2 操作系统的发展历程

从早期的批处理系统到现代的多任务、多用户、多处理器操作系统,操作系统经历了长足的发展。早期的简单批处理系统,到后来的分时系统,再到现代的微内核和分布式操作系统,每一代的发展都带来了新的特性和优化。

1.3 操作系统设计原则

设计操作系统时,工程师需要考虑多个原则,包括资源管理的高效性、用户界面的友好性、系统的稳定性和安全性。此外,操作系统的扩展性、可移植性和兼容性也是设计时需要重点关注的方面。

通过第一章的学习,我们为深入探索操作系统的各个组成部分奠定了基础。接下来的章节将逐步揭示操作系统背后复杂的机制和实现技术。

2. 进程管理的实现与理解

2.1 进程的基本概念和状态

2.1.1 进程的定义及其生命周期

在现代计算机系统中,进程是执行中的程序的实例。它是一个独立的运行单位,包含了一个程序所需的所有信息,包括程序代码、程序的当前状态以及分配给它的资源集合。进程的状态可以分为创建、就绪、运行、阻塞和终止等几个阶段,这些状态之间的转换伴随着事件的发生,如进程调度决策、I/O操作完成、信号量操作等。

进程的生命周期始于创建,这时系统为进程分配必要的资源,并将其状态设置为创建状态。创建状态之后,进程通常会进入就绪状态,等待CPU调度。一旦CPU分配给进程时间片,进程就进入运行状态。在运行状态下,如果进程需要等待某些事件的发生,例如I/O操作,它会进入阻塞状态。一旦阻塞的原因消失,进程可以再次进入就绪状态。最后,进程执行完毕或被终止,其生命周期结束。

2.1.2 进程状态转换与事件驱动

进程状态的转换是由进程调度程序和进程自身发出的事件驱动的。每个进程都存在于一个有限状态自动机中,该自动机规定了进程状态之间的合法转换。例如,当一个进程接收到一个信号,它可能会从就绪状态转到阻塞状态,等待信号处理完成;当信号处理完成时,进程又会转回就绪状态。

事件驱动的进程状态转换可以通过状态转换图来形象地表示,如下图所示:

graph LR

A[创建] --> B[就绪]

B --> C[运行]

C --> D[阻塞]

D --> B

C --> E[终止]

在这个图中,每个状态转换都是由一个特定事件触发的,如I/O请求完成、时间片耗尽等。

2.2 进程调度算法及实现

2.2.1 常见的调度算法讲解

进程调度算法是操作系统中用于决定哪个进程获得CPU资源的一种机制。常见的调度算法包括先来先服务(FCFS)、短作业优先(SJF)、优先级调度和轮转(RR)调度。

先来先服务(FCFS)是最简单的调度算法,它按照进程到达的顺序进行调度。短作业优先(SJF)选择预计执行时间最短的进程进行调度,这样可以最小化平均等待时间。优先级调度根据进程的优先级来调度,优先级高的进程先执行。轮转调度将时间分为固定长度的时钟滴答,按照时间片轮流为进程分配CPU。

2.2.2 调度算法的代码实现和分析

以轮转调度(RR)为例,实现一个简单的RR调度器可以使用队列数据结构。以下是Python代码示例,使用队列来实现RR调度算法:

import queue

def round_robin_scheduling(processes, time_quantum):

# 初始化就绪队列

ready_queue = queue.Queue()

for process in processes:

ready_queue.put(process)

time = 0

while not ready_queue.empty():

# 从就绪队列中取出进程

process = ready_queue.get()

# 执行进程,运行时间为时间片

time += time_quantum

print(f"Process {process['id']} is running from {time - time_quantum} to {time}")

# 假设进程在时间片内执行完毕

# 如果进程未执行完毕,需重新加入就绪队列尾部

# ready_queue.put(process)

print(f"All processes have been completed at time {time}")

# 示例进程列表,每个进程包含id和执行时间

processes = [

{"id": 1, "burst_time": 5},

{"id": 2, "burst_time": 3},

{"id": 3, "burst_time": 8},

{"id": 4, "burst_time": 6},

]

# 时间片长度

time_quantum = 4

round_robin_scheduling(processes, time_quantum)

在这个代码中,我们定义了一个 round_robin_scheduling 函数,它接受进程列表和时间片长度作为参数。该函数使用队列来模拟进程的就绪队列,并按照RR调度算法进行调度。每个进程在时间片内运行,如果运行完毕则不再放回队列;如果未运行完毕,则重新放回队列尾部等待下一次调度。

2.3 进程间通信机制

2.3.1 管道、消息队列、共享内存与信号量

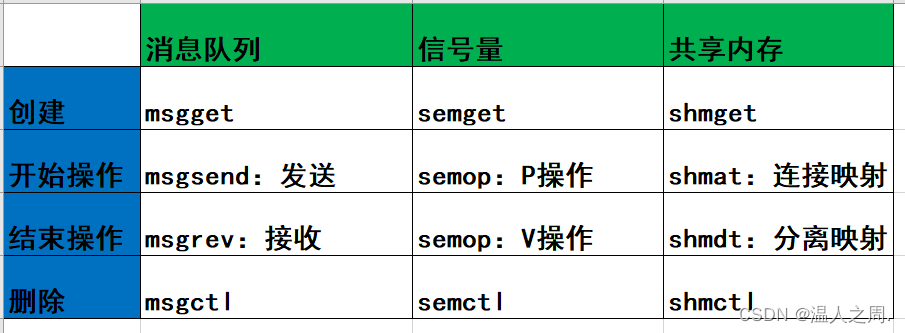

进程间通信(IPC)是指进程之间交换数据或信号的过程。常见的IPC机制包括管道、消息队列、共享内存和信号量。

管道是最早的IPC机制之一,允许一个进程和另一个进程进行通信,但仅限于父子进程或者兄弟进程间。消息队列提供了一种在不同进程之间发送格式化数据块的方法。共享内存允许两个或多个进程访问同一块内存空间,这是最快的一种IPC方式,因为它直接在内存中传递数据。信号量是一种用于进程间同步的机制,它避免了竞态条件和死锁的发生。

2.3.2 进程同步与死锁的解决策略

进程同步是协调多个进程之间的执行顺序,确保共享资源的正确访问。同步机制的实现方式之一是互斥锁(mutex),它能够确保一次只有一个进程访问共享资源。另一种同步机制是条件变量,它允许进程在某些条件未满足时挂起。

死锁是指两个或多个进程在执行过程中,因争夺资源而造成的一种僵局。解决死锁的常见策略包括死锁预防、死锁避免、死锁检测和恢复。预防和避免策略通常需要破坏死锁产生的四个必要条件之一,而死锁检测通常涉及构建资源分配图,检测是否存在环路。一旦检测到死锁,操作系统可以采取资源剥夺、进程回滚等策略来恢复系统。

通过以上的分析和讨论,我们可以看到操作系统中的进程管理是一个复杂而精细的机制,它涉及到进程的基本概念、状态转换、调度算法、通信机制和同步等多个方面。理解这些概念对于设计和优化操作系统至关重要。

3. 内存管理技术

内存管理是操作系统中的核心部分,负责有效地利用物理内存资源,并提供给进程一个看似连续的内存空间。本章将详细介绍内存管理的基础概念,包括内存的分配与回收、分页和分段技术等,并深入探讨虚拟内存的实现原理,包括页面置换算法、内存映射和共享。

3.1 内存管理的基础概念

在现代操作系统中,内存管理机制不仅要确保物理内存得到合理分配,还要处理多个进程共享内存的问题。理解内存管理的基本概念和机制是深入学习操作系统内存管理不可或缺的一部分。

3.1.1 内存分配和回收机制

物理内存的分配和回收是操作系统内存管理的基本任务之一。当进程请求一定量的内存时,系统必须从可用的内存资源中为其分配适当的大小,并跟踪内存使用情况。当进程不再需要内存或者终止时,这部分内存资源需要被回收,以便其他进程使用。

现代操作系统通常采用页表来管理内存分配,其中的每个条目通常记录了每个页面的状态,如是否被占用、是否已经被写入磁盘等。当系统要分配或回收内存时,会根据页表提供的信息进行相应的操作。

内存回收的过程通常涉及到清除进程所占用的内存空间中的数据,并将页面标记为可用状态。在某些操作系统中,如果进程终止,与之相关的所有页面都会被自动回收。

// 示例代码:Linux下的内存分配和释放

void* buffer = kmalloc(size, GFP_KERNEL); // 分配内核内存

if (buffer) {

// 使用buffer进行相关操作

kfree(buffer); // 释放内存

}

代码段中的 kmalloc 函数用于在内核中分配内存,而 kfree 函数则用于释放内存。 GFP_KERNEL 标志指明了内存是从内核空间分配的。

3.1.2 分页和分段技术的原理与对比

分页和分段是两种主要的内存管理技术,它们各有特点和应用场景。分页技术通过将物理内存划分为固定大小的页(page),从而简化了内存的管理。操作系统会记录每个页的状态,并通过页表映射虚拟地址到物理地址。

分段技术则是将内存分为不同的段,每个段通常对应程序中的逻辑单元,如代码段、数据段等。每个段有自己的大小和位置属性,但与分页不同,段的大小并不一定相同。

// 分页和分段的对比表格

| 特性 | 分页 | 分段 |

|------------------|-----------------------|-----------------------|

| 地址划分 | 固定大小的页 | 可变大小的段 |

| 内存保护 | 每个页可以独立保护 | 每个段可以独立保护 |

| 内存碎片 | 有外部碎片问题 | 有外部碎片问题 |

| 映射方式 | 页表将虚拟地址映射到物理地址 | 段表将逻辑地址映射到物理地址 |

| 缓存策略 | 页表容易缓存 | 段表需要复杂管理 |

在实际应用中,分页和分段技术可以结合使用,比如在现代x86架构中,通过分段机制来提供虚拟地址空间的隔离,再通过分页机制来实现物理内存的映射和访问控制。

3.2 虚拟内存的实现原理

虚拟内存是一种内存管理技术,允许系统为每个进程提供比实际物理内存大得多的地址空间。通过将不常用的内存数据交换到磁盘上,系统可以使得每个进程都认为自己独占了整个内存空间。虚拟内存的实现涉及了页面置换算法和内存映射等关键技术。

3.2.1 页面置换算法与实现

当物理内存中没有足够的空间来加载进程请求的页时,页面置换算法便开始工作,选择一个较少使用的页进行淘汰,以腾出空间给新的页面使用。常见的页面置换算法有LRU(最近最少使用)、FIFO(先进先出)和CLOCK等。

// LRU算法的伪代码实现

void pageReplacementLRU(PageTable* pt) {

int referenceTime = 0;

for (int i = 0; i < pt->numPages; i++) {

pt->pages[i].referenceTime = referenceTime++;

pt->pages[i].frequency = 0;

}

while (true) {

// 检查是否有页面需要置换

// ...

// 如果需要,则使用LRU策略选择页面

int minTime = INT_MAX;

Page* victimPage = NULL;

for (int i = 0; i < pt->numPages; i++) {

if (pt->pages[i].frequency < pt->usageThreshold) {

if (pt->pages[i].referenceTime < minTime) {

minTime = pt->pages[i].referenceTime;

victimPage = &pt->pages[i];

}

}

}

// 置换选中的页面到磁盘

// ...

}

}

在上述伪代码中,每个页面都有一个引用时间和访问频率。当要选择一个页面进行置换时,会从引用时间最旧且访问频率最低的页面中选择。在实际系统中,需要维护相应的数据结构来支持页面置换算法。

3.2.2 内存映射和共享

内存映射是将虚拟内存地址映射到磁盘文件的过程,可以有效地处理大文件的内存访问。当进程访问一个映射到文件的内存页时,如果这个页不在内存中,操作系统会从文件中读取相应的页到物理内存中。

内存共享是一种优化技术,允许两个或多个进程访问同一物理内存区域。这样可以减少内存的复制和使用,提高资源的利用率。

graph LR

A[进程A] -->|映射共享| B[内存区域]

C[进程B] -->|映射共享| B

在mermaid流程图中展示了两个进程共享同一内存区域的过程。当进程A或进程B访问被共享的内存区域时,它们实际上是访问同一块物理内存。

3.3 内存管理优化策略

内存管理优化策略关注于提高内存的使用效率和系统的整体性能。主要的优化手段包括内存压缩、页面共享和大页内存使用等。

3.3.1 内存压缩技术

内存压缩是将内存中的空闲页进行合并,从而减少内存碎片化,并为应用程序提供更多的连续可用内存。内存压缩通常在系统内存紧张时执行。

3.3.2 页面共享和大页内存

页面共享是在内存管理中识别并合并完全相同的内存页,减少物理内存的使用。大页内存技术允许操作系统分配较大的内存页(如2MB或1GB),这样可以减少页表项的数量,提高内存访问速度。

在现代Linux系统中,可以使用 transparent_hugepage 特性来启用大页内存。这些技术的合理使用能够显著提高系统的内存管理效率和运行速度。

综上所述,内存管理作为操作系统的关键部分,涉及到了许多复杂的概念和技术。了解内存的分配和回收、分页和分段技术、以及虚拟内存的实现原理,对于深入掌握操作系统内存管理的精髓至关重要。同时,通过不断优化内存管理策略,可以进一步提升系统性能,为应用提供更高效的运行环境。

4. 文件系统设计与实现

4.1 文件系统的基础架构

4.1.1 文件系统的层次结构

文件系统是操作系统中负责管理数据的存储、检索、共享和保护的子系统。它的核心功能是提供一个逻辑框架,用于有效地组织和管理磁盘上的数据,使其容易被用户和应用程序访问。

文件系统的层次结构通常包括以下几个层次:

-

用户接口层 :这是用户与文件系统交互的界面,包括文件的创建、删除、读写操作等。这一层为用户提供了一个简单的抽象视图,隐藏了底层复杂的数据组织和存储细节。

-

逻辑文件系统层 :负责处理文件的逻辑结构和目录结构。这一层将文件视为一系列字节序列,并对文件名、文件属性等信息进行管理。

-

虚拟文件系统层 :VFS(Virtual File System)是一个抽象层,它为不同的文件系统提供统一的接口。它使得操作系统的其他部分和应用程序不需要关心文件系统是基于磁盘还是网络,抑或是其他媒体。

-

文件组织层 :负责将文件逻辑结构转换为物理结构,并进行文件的存储和检索。它通常涉及文件分配表、索引节点等数据结构。

-

物理介质访问层 :直接与物理存储介质交互,执行实际的数据读写操作。这一层通常涉及到硬件驱动程序,如磁盘驱动器或固态驱动器的驱动。

graph TB

A[用户接口层] --> B[逻辑文件系统层]

B --> C[虚拟文件系统层]

C --> D[文件组织层]

D --> E[物理介质访问层]

E --> F[物理存储介质]

通过这种层次结构设计,文件系统能够提供高度的模块化和灵活性。例如,当引入新的存储技术或媒体时,只需要在物理介质访问层进行更新而不必改动其他层。

4.1.2 目录和文件的基本操作

目录和文件的基本操作是文件系统对外提供服务的核心。这些操作包括但不限于:

- 创建文件 :在文件系统中新建一个文件实例。

- 删除文件 :从文件系统中移除指定文件。

- 读取文件 :从文件系统中检索文件数据。

- 写入文件 :将数据写入到文件中。

- 重命名文件 :修改文件的名称。

- 移动文件 :改变文件在文件系统中的位置。

- 复制文件 :在文件系统中创建文件的副本。

对于目录来说,还有额外的一些操作,如创建目录、删除目录、遍历目录项等。这些基本操作是构建在文件系统层次结构之上的,文件系统需要通过逻辑文件系统层和文件组织层来实现这些操作的细节。

4.2 高级文件系统特性

4.2.1 索引节点与文件权限管理

索引节点(inode)是文件系统中记录文件元数据(如文件大小、创建时间、权限和所有权等)的数据结构。每一个文件或目录在文件系统中都对应一个唯一的索引节点。

索引节点使得文件系统可以快速访问文件的元数据而不必读取整个文件内容。这样,对于大量文件的系统,查询文件属性的操作可以迅速完成。

文件权限管理是保证文件系统安全的重要机制。它规定了不同的用户或用户组对文件或目录可以执行的操作类型(读、写、执行)。文件权限通常包括以下几种:

- 读(r) :用户可以查看文件内容或目录列表。

- 写(w) :用户可以修改文件内容或在目录中创建、删除文件。

- 执行(x) :用户可以运行文件作为程序。

在类Unix系统中,文件权限通过用户、组和其他三个类别来管理,每个类别都可以被赋予读、写、执行的权限。例如,权限 rwxr-xr-x 意味着文件所有者可以读、写和执行该文件,文件所属组的成员可以读和执行,而其他用户也可以读和执行。

4.2.2 日志文件系统与RAID技术

日志文件系统是一种特殊类型的文件系统,它维护了一个日志(或事务日志),记录了对文件系统所做的更改。在出现系统故障时,这些日志可以用来恢复文件系统到一致状态。

日志文件系统的主要优势在于其提高了文件系统的可靠性和效率。常见的日志文件系统包括ext3、ext4、XFS和ReiserFS等。

RAID(冗余阵列独立磁盘)技术通过将数据分布在多个硬盘上,提供了数据冗余和提高了存储系统的性能。RAID可以以不同的方式配置,称为“级别”。常见的RAID级别包括RAID 0、RAID 1、RAID 5、RAID 6和RAID 10等。

- RAID 0 (条带化):将数据分散存储在两个或多个硬盘上,提高了性能,但没有冗余。

- RAID 1 (镜像):数据被写入两个硬盘,提供完整冗余。

- RAID 5 :至少需要三个硬盘,提供了数据冗余和不错的性能。

- RAID 6 :类似于RAID 5,但是可以承受两个硬盘故障。

- RAID 10 :结合了RAID 1的镜像和RAID 0的条带化,提供了高可靠性和性能。

在设计文件系统时,结合使用日志文件系统和RAID技术可以显著提高数据的完整性和系统的可用性。

4.3 文件系统的性能优化

4.3.1 缓存机制和预读写策略

文件系统的缓存机制使用内存来临时存储频繁访问的数据,目的是减少对物理存储介质的访问次数,从而提高系统性能。缓存可以是主动的,也可以是被动的。主动缓存会预读取用户可能需要的数据,而被动缓存则是在用户实际访问数据时才从磁盘加载到内存中。

预读写策略是一种优化技术,它预测用户对文件的操作模式,并提前将相关数据从磁盘读入缓存或将缓存数据写入磁盘。例如,当系统检测到用户顺序读取大文件时,它会预先读取接下来的数据块到缓存中。对于写操作,预写(Write-Ahead Logging)技术会在数据写入硬盘前,先写入日志文件中,从而确保在系统崩溃时数据的一致性。

4.3.2 磁盘调度算法与文件系统维护

磁盘调度算法决定了数据请求的顺序,目的是减少磁盘寻道时间,提高磁盘读写效率。常见的磁盘调度算法有:

- 先来先服务(FCFS) :按照请求到达的顺序执行。

- 最短寻道时间优先(SSTF) :选择与当前磁头位置最近的请求。

- 扫描算法(SCAN) :磁头像电梯一样从一个方向移动到另一个方向,服务沿途的请求。

- 循环扫描算法(C-SCAN) :与SCAN类似,但到达一端后返回另一端的起始点,不处理反方向的请求。

文件系统维护工作包括文件系统检查、修复、碎片整理等。这些操作可以确保文件系统的健康和数据的完整。比如,磁盘碎片整理工具可以重新排列磁盘上的文件和文件碎片,以减少读写操作的寻道时间,提高文件访问速度。

graph LR

A[文件系统检查与修复] --> B[磁盘碎片整理]

B --> C[性能分析与调优]

C --> D[文件系统升级与维护]

在实际应用中,合适的磁盘调度算法和定期的文件系统维护可以显著提升文件系统的性能和可靠性。

5. 设备驱动编写与系统交互

5.1 设备驱动的原理和分类

5.1.1 设备驱动的基本概念和架构

在操作系统中,设备驱动是连接硬件与软件的桥梁,其主要功能是处理特定硬件设备的I/O请求。驱动程序位于操作系统内核中,对内核提供一组标准化的接口,对硬件则通过特定的硬件协议进行通信。理解驱动程序的工作原理对于系统开发和维护至关重要。

驱动程序通常包括以下几个关键组成部分: - 初始化和清理代码:负责在驱动加载和卸载时执行必要的设置和清理工作。 - 设备操作函数:定义了对设备进行操作的一系列函数,如打开、读取、写入和关闭。 - 中断处理:负责响应设备的中断信号,处理中断请求。 - DMA支持:管理直接内存访问(DMA),优化数据传输效率。

驱动程序的架构设计要考虑到可扩展性、健壮性以及对硬件的兼容性。模块化的驱动设计可以有效地实现这些目标。

5.1.2 字符设备与块设备驱动特点

根据设备数据传输的方式和内核接口的不同,设备驱动主要分为字符设备驱动和块设备驱动两大类:

-

字符设备驱动:字符设备以字符为单位进行数据传输,数据流是线性的。典型的字符设备包括键盘、鼠标、串口等。它们通常通过文件系统中的设备文件来访问。

-

块设备驱动:块设备以数据块为单位进行读写,支持随机访问。常见的块设备有硬盘、SSD等。块设备通过文件系统进行管理,可以实现文件的创建、删除、读写等操作。

接下来,我们将详细讨论如何编写设备驱动程序,并介绍与系统交互的机制。

简介:操作系统实习是计算机科学领域的一项关键实践,特别是西北农林科技大学(简称“西农”)为学生提供了深入了解操作系统原理、设计思想和实现方法的机会。学生将学习包括进程管理、内存管理、文件系统和设备驱动在内的核心概念,并通过实际操作提升编程与调试技能。本项目涵盖了操作系统设计的各个方面,通过理论与实践相结合的方式,旨在培养学生具备设计和维护复杂系统的能力,强化编程技巧,为未来职业生涯打下坚实基础。

1040

1040

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?