深度卷积网络:实例探究

2.1 为什么要进行实例探究?

这周内容将了解一些现有的神经网络框架。

2.2 经典网络

该节介绍了用于计算机视觉的几个经典卷积神经网络,均来自于几篇经典文献,可以考虑阅读。

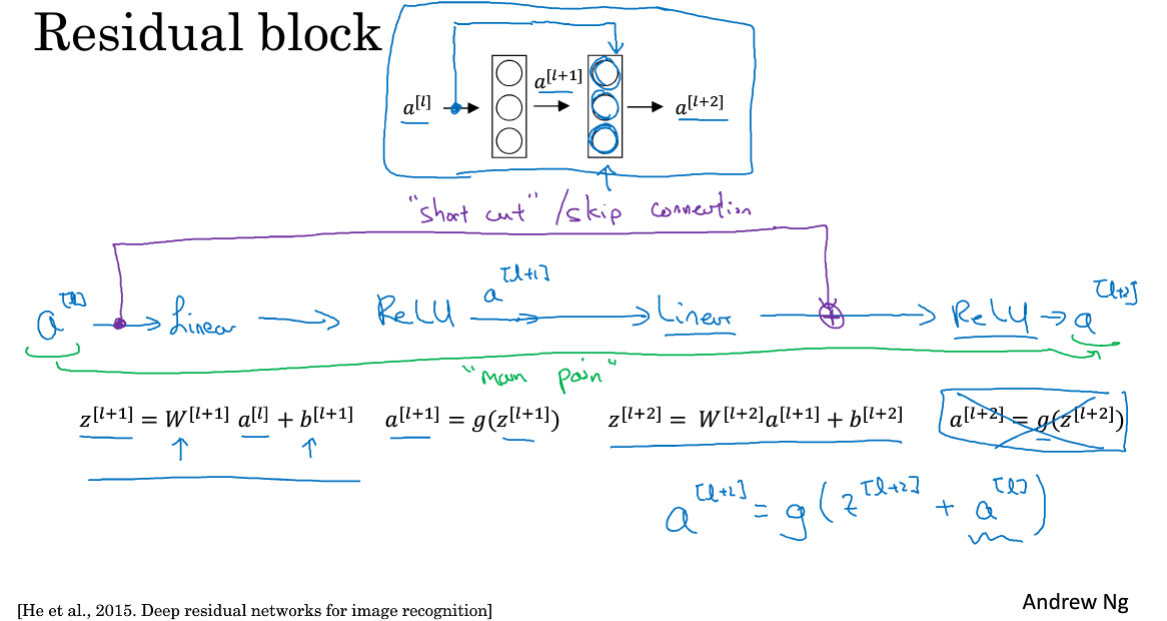

2.3 残差网络

残差网络是指在正向传播时不按照原有路线往前传播,而是采用一种“跳远连接”,从某一层直接传到更深层的线性计算后、ReLu激活前。

普通的深度神经网络容易产生梯度爆炸、梯度消失等问题,从而使得层数越多训练代价反而越高,而残差网络可以避免该问题。

2.4 残差网络为什么有用?

残差网络首先保证效率不低于简单的神经网络,也就是下图中推导的a[l] = a[l+2],残差块学习恒等函数非常容易,很多时候可以提升效率。(这节没太看懂)

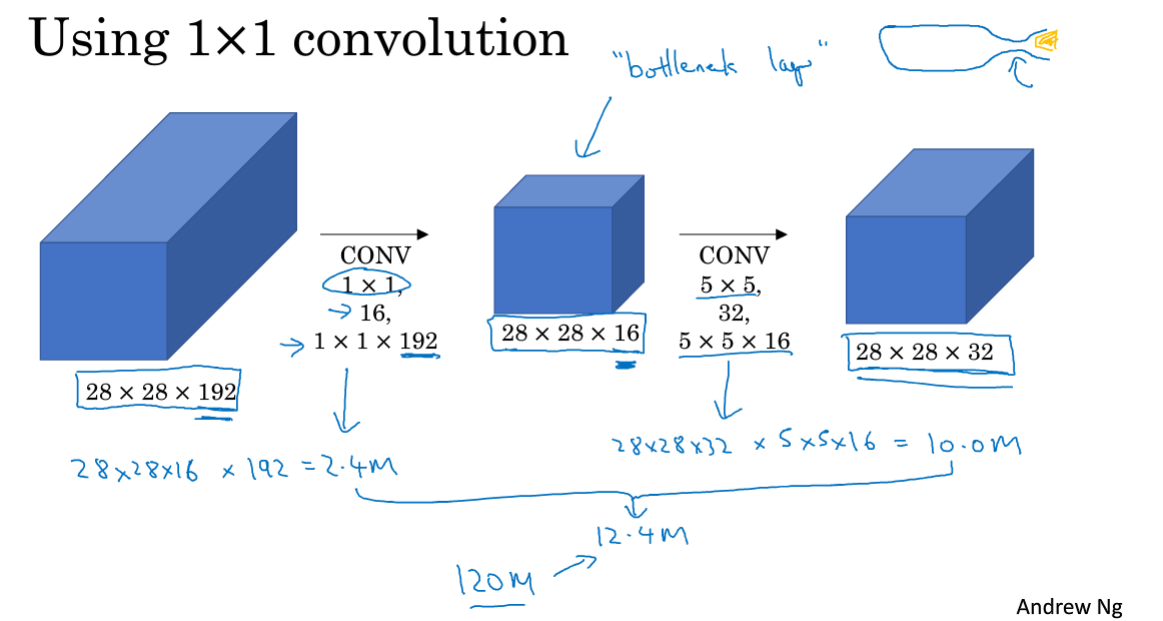

2.5 网络中的网络以及1x1卷积

1x1卷积就是过滤器大小为1,这在多通道的输入中有比较好的作用。

1x1卷积的作用:保持或减少通道数,甚至增加。

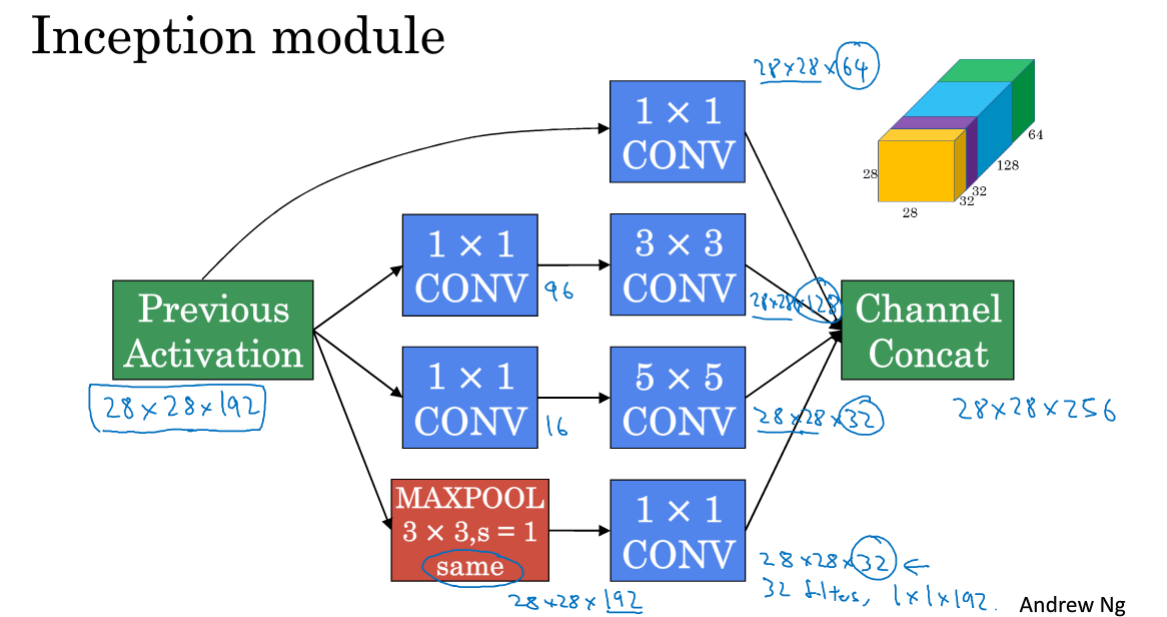

2.6 谷歌Inception网络简介

Inception网络是帮助自动确定过滤器大小,池化层参数大小的模块,它是通过把所有各类型输出拼接起来,最后让网络自动去学习最佳参数的机制。

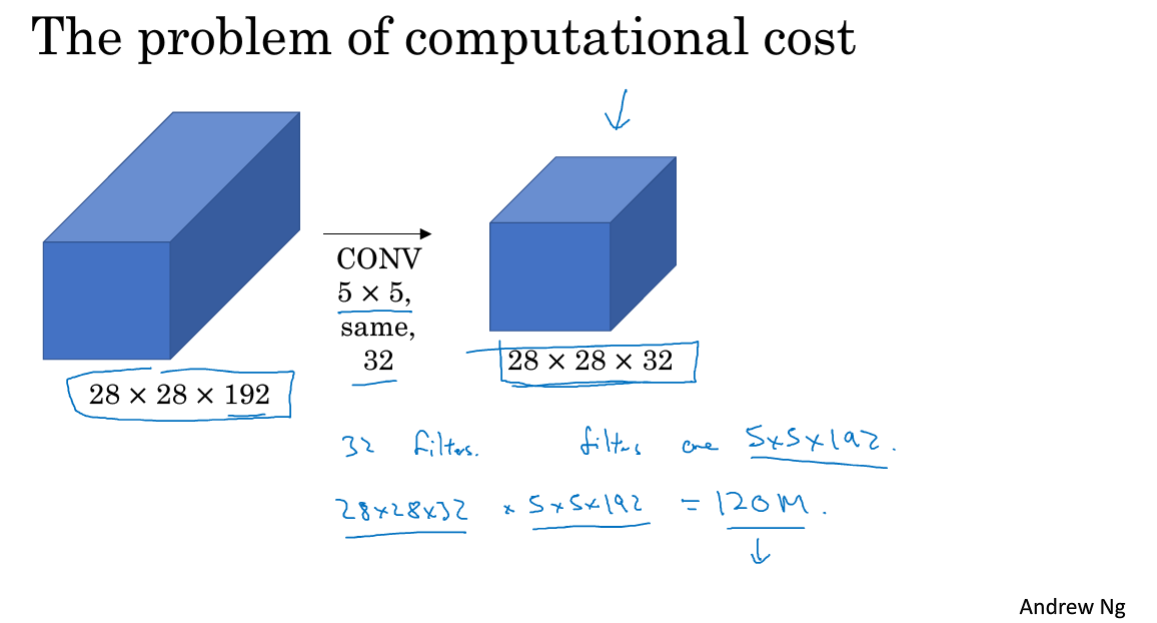

计算代成本:这里计算乘法运算的次数,输出层的总维度x过滤器维度x过滤器大小。

使用1x1卷积构建瓶颈层,可以大大降低计算成本。

2.7 Inception网络

下面是一个Inception模块:

下面是多个模块组成的Inception网络:

注意,这里除了各模块部分外,还有一些分支。其作用是确保隐藏层和中间层能参与特征计算,完成预测,避免网络过拟合。

2.8 使用开源的实现方案

在基本知识夯实以后,具体项目实施时,充分利用github,使用别人写好的一些框架直接运用到自己的项目里,事半功倍。

2.9 迁移学习

神经网络中的迁移学习强调的就是使用别人训练好的权重替代你的随机初始化,尤其是在你的数据集不够多的情况下,别人训练好的权重能够让你自己问题的训练更加快捷。

说白了就是借鉴别人的架构,站在巨人的肩膀上前进!

2.10 数据扩充

数据量不够的时候,除了去获取更多的数据外,往往还可以采取一些技巧进行数据扩充。

- 镜像翻转

- 随机裁剪

- 色彩转换

数据量很多时,进行数据扩充时可以多线程实现,各个图片采取不同的扩充办法。

2.11 计算机视觉现状

数据量较小时,需要手工工程,迁移学习也更受用;数据量较多时,着重于建立学习系统。

基准测试有几个小技巧:

- 训练多个神经网络,平均它们的输出

- 测试时在一个图片取不同的部分预测再平均其输出

最后依然是多使用开源的一些东西,事半功倍。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?