1.问题描述

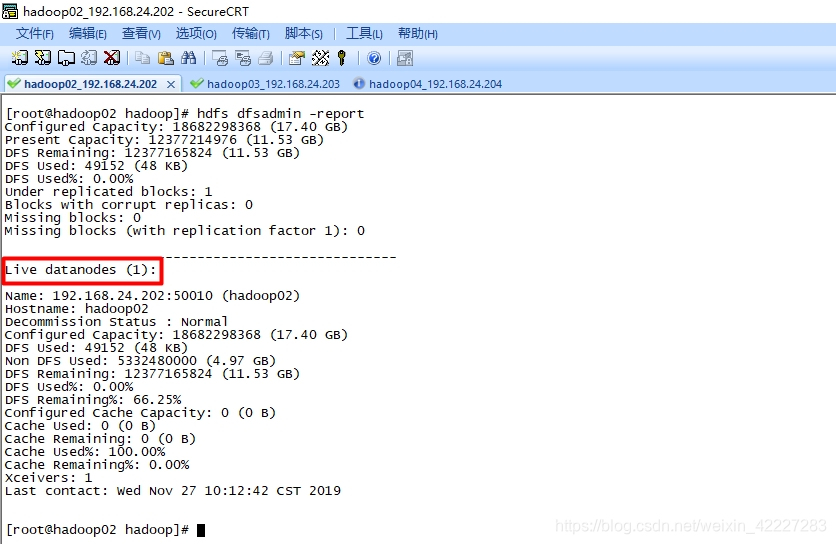

三台虚拟机(分别是hadoop02,hadoop03,hadoop04)集群所有数据节点都已经正常启动了,而通过命令hadoop dfsadmin -report 显示的 Live datanodes却只有1个。

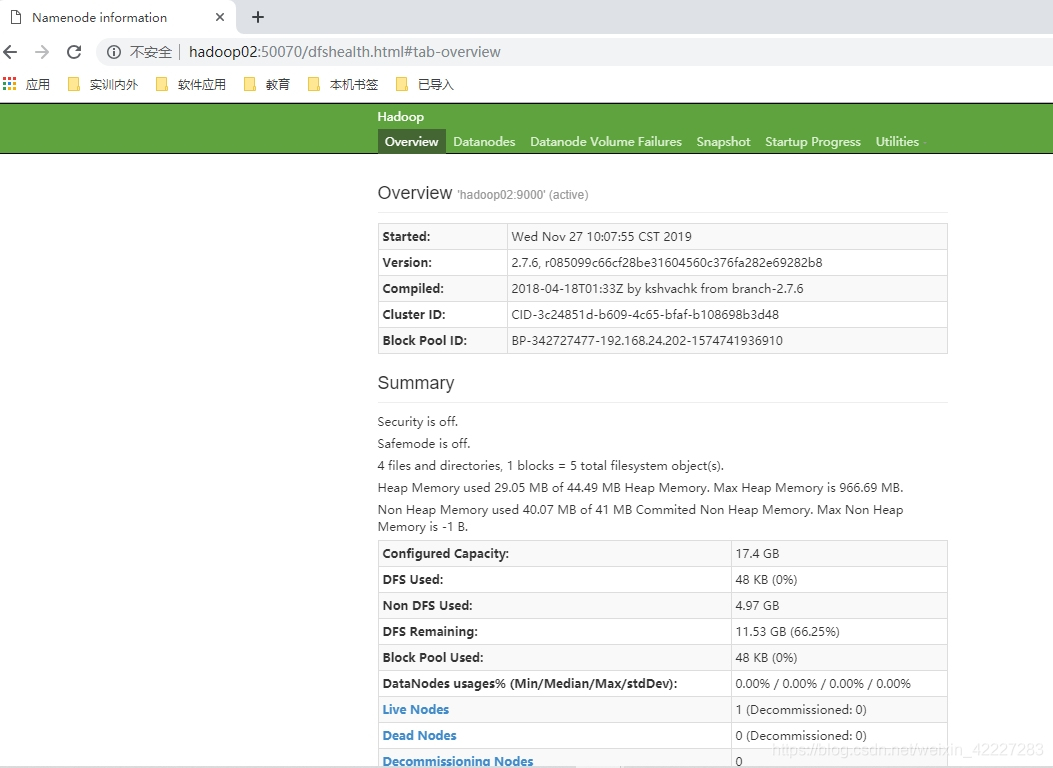

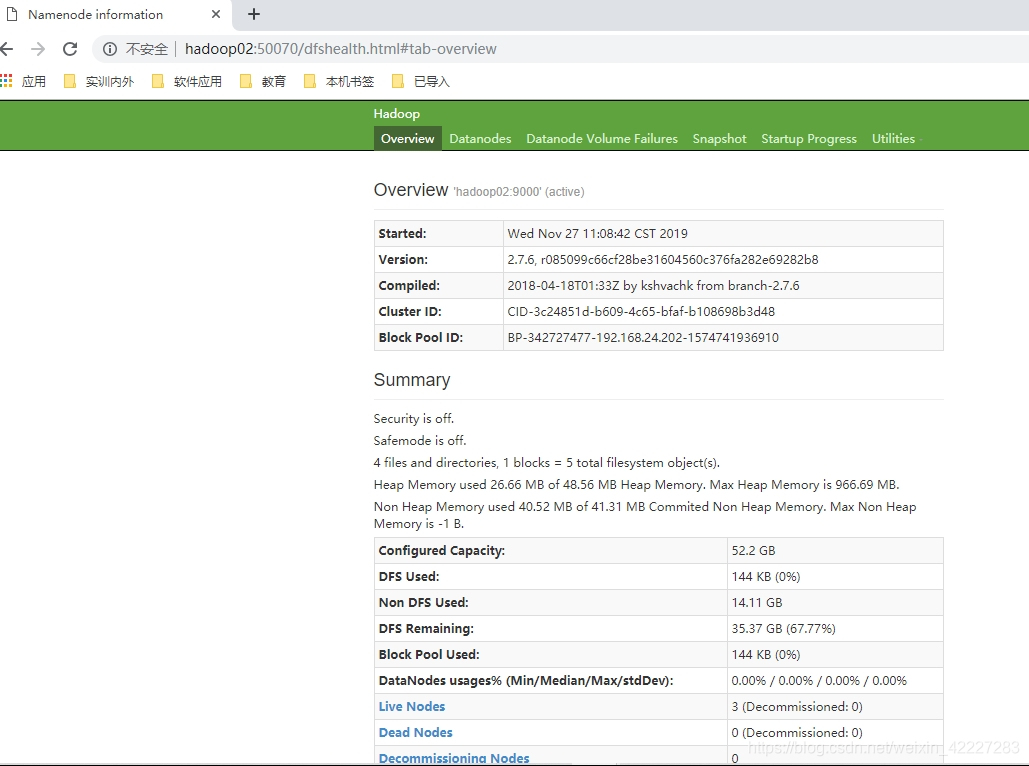

通过web页面查看http://hadoop02:50070,在Live Node那一栏也显示只有1个节点,而且只有主节点hadoop02。Live Nodes为1,Dead Nodes为0,没有显示其他节点存活。

2.解决过程与我的解决办法

2.1解决过程

上网查找了很多办法,包括:

- 重新格式化namenode,再正确配置clusterID,storageID和 datanodeUuid;

- 检查 /etc/hosts 正确配置;

- 检查防火墙是否关闭 firewall-cmd --state,查看selinux状态 getenforce

…

等等均无法正常解决该问题。

2.2我的解决办法

2.2.1问题发现

经过不断寻找调试与求证,发现了问题所在:

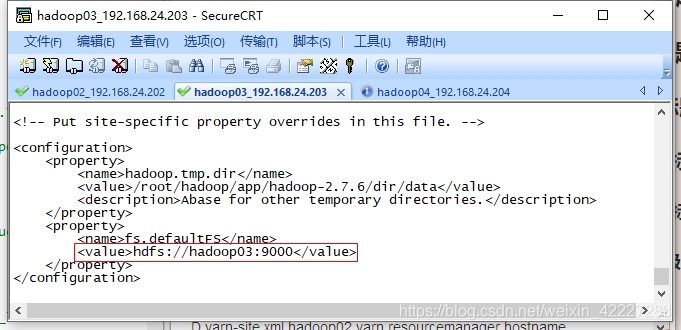

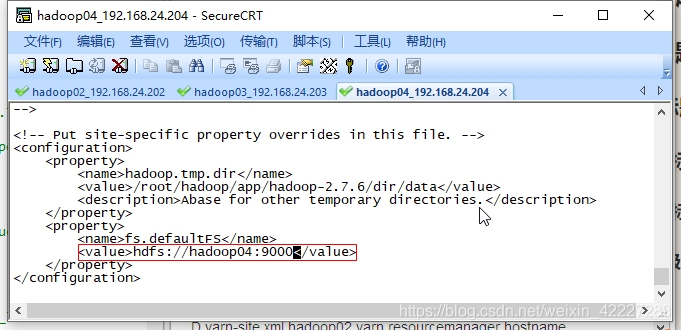

第二节点hadoop03和第三节点hadoop04核心文件core-site.xml文件系统配置,

与主节点hadoop02的core-site.xml文件配置不同

具体情况如下:

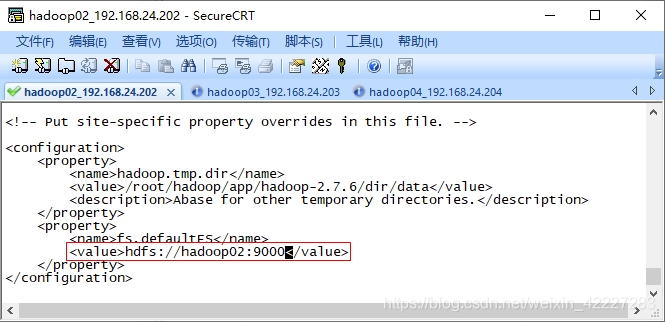

主节点hadoop02的core-site.xml

第二节点hadoop03的core-site.xml

第三节点hadoop04的core-site.xml

2.2.2问题解决

在hadoop安装目录下,输入

vi etc/hadoop/core-site.xml

将三个节点的核心文件core-site.xml配置为完全相同

主要是第2和第3节点的配置属性fs.defaultFS的值均为主节点hadoop02的value值

```core-site.xml

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>/root/hadoop/app/hadoop-2.7.6/dir/data</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop02:9000</value>

</property>

</configuration>

```

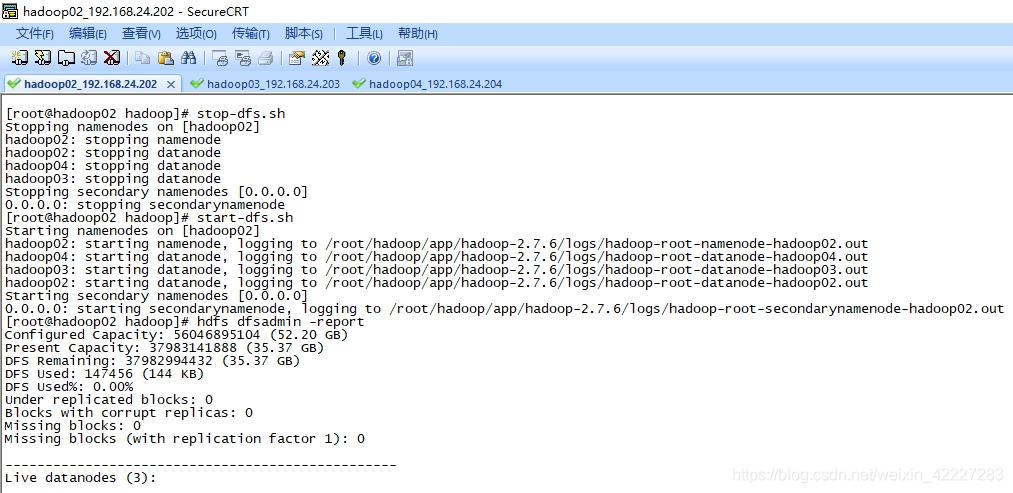

配置修改完成后重启 dfs

stop-dfs.sh

start-dfs.sh

节点启动完成后,命令hadoop dfsadmin -report 显示的 Live datanodes为3,达到预期

Web页面查看http://hadoop02:50070,在Live Node那一栏显示3个节点,,达到预期

以上,问题解决,希望可以帮助到大家

博客详细记录了Hadoop集群中,除主节点外的DataNode无法正常启动的问题及解决过程。通过调整各节点core-site.xml配置,特别是fs.defaultFS属性,使所有节点指向同一NameNode,成功解决了LivedataNodes只显示一个节点的问题。

博客详细记录了Hadoop集群中,除主节点外的DataNode无法正常启动的问题及解决过程。通过调整各节点core-site.xml配置,特别是fs.defaultFS属性,使所有节点指向同一NameNode,成功解决了LivedataNodes只显示一个节点的问题。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?