变形金刚已成功应用于视觉跟踪任务,显著提高了跟踪性能。为模拟长期依赖关系而设计的自我关注机制是《变形金刚》成功的关键。然而,自我注意缺乏对搜索区域中最相关信息的关注,容易被背景干扰。在本文中,我们通过稀疏注意机制来解决这个问题,将最相关的信息集中在搜索区域,从而实现更精确的跟踪。在此基础上,引入双头预测器,提高了前景背景分类和目标边界盒回归的精度,进一步提高了跟踪性能。大量的实验表明,在没有铃声和哨子的情况下,我们的方法在以40 FPS运行时,显著优于LaSOT、GOT-10k、TrackingNet和UAV123上的最先进方法。值得注意的是,与TransT相比,我们的方法的训练时间减少了75%。源代码和模型可以在https://github.com/fzh0917/SparseTT上找到。

视觉跟踪的目的是在给定目标的初始状态下预测其未来的状态。应用广泛,如人机交互、视频监控、自动驾驶等。现有的大多数方法都使用序列预测框架来解决跟踪问题,其中它们基于初始状态和先前状态来估计当前状态。因此,在每个时间片上给出准确的状态是很重要的,否则误差会累积而导致跟踪失败。研究人员在提高跟踪精度,即目标包围框的精度方面进行了大量的工作。然而,目标变形、部分遮挡、尺度变化等挑战仍然是阻碍其实现完美跟踪的巨大障碍。

原因可能是这些方法大多采用互相关操作来衡量目标模板与搜索区域之间的相似度,这可能会陷入局部最优。最近,TransT [Chen et al, 2021]和DTT [Y u通过用变压器替换相关性来提高跟踪性能[V aswani等人,2017]。

然而,使用变形金刚构建跟踪器会导致一个新的问题:变形金刚中的自注意全局视角导致主要信息(如搜索区域中的目标)聚焦不足,而次要信息(如搜索区域中的背景)聚焦过度,使前景与背景之间的边缘区域模糊,从而降低跟踪性能。

在本文中,我们通过集中于搜索区域的最相关信息来解决这个问题,这是用稀疏转换器实现的。与之前作品中使用的香草变形金刚不同[Chen et al, 2021;Y u et al ., 2021],稀疏变形器的设计聚焦于主信息,即使在目标严重变形、部分遮挡、尺度变化等情况下,目标的判别能力更强,目标的包围盒也更准确,如图1所示。

总的来说,这项工作的主要贡献有三个方面。

•我们提出了一个目标焦点网络,能够集中在搜索区域和感兴趣的目标上突出显示最相关信息的特征,以便更好地估计目标的状态。

•我们提出了一个基于稀疏Transformer的暹罗跟踪框架,该框架具有很强的处理目标变形、部分遮挡、尺度变化等的能力。

•大量的实验表明,当以40 FPS运行时,我们的方法优于LaSOT, GOT10k, TrackingNet和UA V123上的最先进方法,证明了我们方法的优越性。

这篇工作work的原因大概是因为只有相似特征提取的问题,虽然说,文中提到了有变形、遮挡等,但对于点云配准来説,旋转带来的特征变化是完全不能忽视的。也就是特征不是旋转不变的,这导致该方法很难直接用在点云配准中,也许加上几何约束会好些?

Siamese 追踪器。在暹罗式视觉跟踪器中,互相关被广泛用于测量目标模板与搜索区域之间的相似度,被广泛用于视觉跟踪。如朴素互相关[Bertinetto等人,2016],深度相互关[Li等人,2019;Xu等,2020],像素级互相关[Y an等,2021b],像素到全局匹配互相关[Liao等,2020],等。而互相关进行局部线性匹配过程,容易陷入局部最优[Chen et al, 2021]。此外,交叉相关捕获了相互关系,破坏了输入特征的语义信息,不利于目标边界的准确感知。

大多数连体跟踪器在处理目标变形、局部遮挡、尺度变化等方面仍有困难。

视觉跟踪中的变压器。近年来,变形金刚已成功应用于视觉跟踪领域。

借鉴DETR [Carion等人,2020]的灵感,STARK [Y an等人,2021a]将目标跟踪转换为边界框预测问题,并使用编码器-解码器转换器解决该问题,其中编码器对目标和搜索区域之间的全局时空特征依赖进行建模,解码器学习查询嵌入以预测目标的空间位置。它在视觉跟踪方面表现优异。TrDiMP [Wang等人,2021]设计了一个类似暹罗式的跟踪管道,其中两个分支分别由CNN主干构建,后面跟着一个Transformer编码器和一个Transformer解码器。这里的transformer用于增强目标模板和搜索区域。与以前的siamese跟踪器类似,TrDiMP应用互相关联来衡量目标模板与搜索区域之间的相似性,这可能会阻碍跟踪器的高性能跟踪。注意到这一缺点,TransT [Chen等人,2021]和DTT [Y u等人,2021]提出用Transformer代替互相关,从而生成融合特征而不是响应分数。

由于融合特征包含比响应分数更丰富的语义信息,这些方法比以前的暹罗跟踪更准确。

《变形金刚》中的自我关注擅长于建模长期依赖关系,这使得它善于捕捉全局信息,然而,它却缺乏对搜索区域中最相关信息的关注。为了进一步增强Transformer跟踪器,我们使用稀疏注意机制缓解了前面提到的自我注意缺陷。

这个想法的灵感来自[Zhao等人,2019]。我们调整了[Zhao等人,2019]中的稀疏Transformer以适应视觉跟踪任务,并提出了一种新的端到端连体跟踪器,具有编码器-解码器稀疏Transformer。在稀疏注意机制的驱动下,稀疏Transformer将注意力集中在搜索区域中最相关的信息上,从而更有效地抑制干扰跟踪的干扰背景。

Explicit sparse transformer: Concentrated attention through explicit selection.

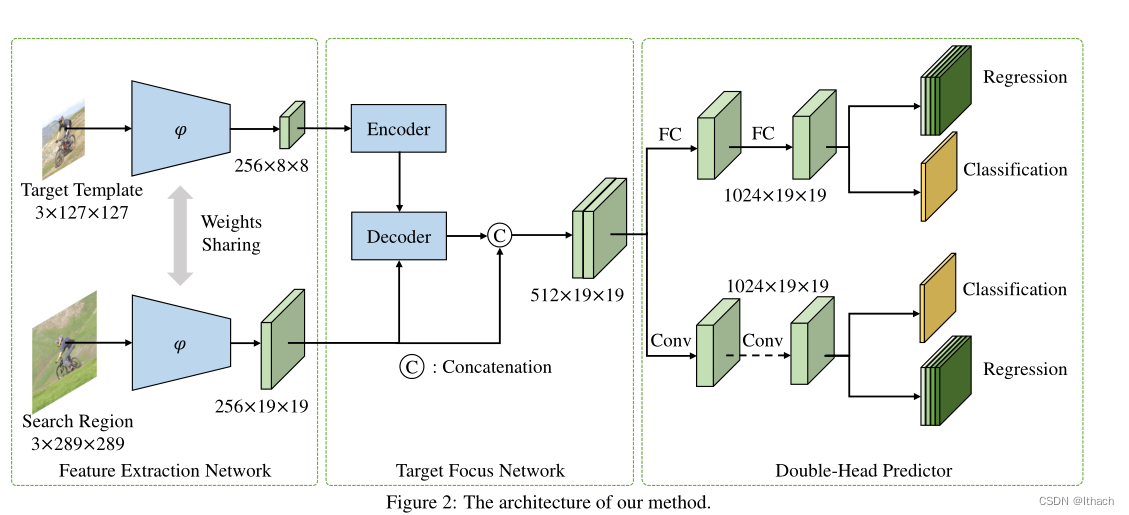

我们提出了一种视觉跟踪的暹罗架构,该架构由特征提取网络、目标聚焦网络和双头预测器组成,如图2所示。特征提取网络是一个权重共享的主干网络。利用稀疏变形器构建目标聚焦网络,生成目标聚焦特征。双头预测器区分前景和背景,输出目标的边界框。注意,我们的方法运行于在跟踪阶段没有在线更新的实时速度。

目标焦点网络采用稀疏Transformer构建,具有编码器-解码器架构,如图3所示。

编码器负责编码目标模板特性。解码器负责对搜索区域特征进行解码,生成以目标为中心的特征

编码器。编码器是目标聚焦网络中一个重要但非必需的组成部分。它由N个编码器层组成,其中每个编码器层将其前一个编码器层的输出作为输入。请注意,为了使网络能够感知空间位置信息,我们对目标模板特征添加了空间位置编码,并将其和输入编码器。

因此,第一编码器层将具有空间位置编码的目标模板特征作为输入。简而言之,它可以正式地表示为

其中Z∈RHtWt×C表示目标模板特征,P enc∈RHtWt×C表示空间位置编码,f ienc表示第i个编码器层,Y i−1enc∈RHtWt×C表示第(i−1)个编码器层的输出。Ht和Wt分别为目标模板特征图的高度和宽度。

在每个编码器层中,我们使用多头自注意(MSA)显式地建模目标模板特征的所有像素对之间的关系。其他操作与vanilla Transformer的编码器层相同[V aswani等人,2017]。

译码器。解码器是目标聚焦网络的重要组成部分。与编码器类似,解码器由M个解码器层组成。但与编码器层不同的是,每一解码器层不仅输入空间位置编码的搜索区域特征或其上一解码器层的输出,还输入编码器输出的编码后的目标模板特征。简而言之,可以正式表示为:

其中X∈RHsWs×C表示搜索区域特征,P dec∈RHsWs×C表示空间位置编码,Y Nenc∈RHtWt×C表示编码器输出的编码后的目标模板特征,f idec表示第i个解码器层,Y i−1 dec∈RHsWs×C表示第(i−1)个解码器层的输出。Hs和Ws分别为搜索区域特征图的高度和宽度。

与vanilla Transformer的解码器层不同[V aswani et al, 2017],所提出的稀疏Transformer的每个解码器层首先使用稀疏多头自注意(SMSA)计算X上的自注意,然后使用朴素多头交叉注意(MCA)计算Z和X之间的交叉注意。其他操作与香草变压器的解码器层相同[V aswani等人,2017]。形式上,所提出的稀疏Transformer的每个解码器层可以表示为:

稀疏多头自注意。为了提高前景背景的分辨能力,缓解前景边缘区域的模糊性,设计了稀疏多头自注意算法。具体而言,在naive MSA中,注意力特征的每个像素值都是由输入特征的所有像素值计算出来的,这使得前景边缘区域模糊。在我们提出的SMSA中,注意力特征的每个像素值只由与它最相似的K个像素值决定,这使得前景更集中,前景边缘区域更有判别力。

具体如图4中间所示,给定查询∈RHW ×C,键∈RC×H0W 0,值∈RH0W 0×C,我们首先计算查询与键之间所有像素对的相似度,并将相似度矩阵中不必要的令牌屏蔽掉。

然后,与图4左侧所示的朴素比例点积注意不同,我们只使用softmax函数对相似矩阵的每行中K个最大元素进行归一化。对于其他元素,我们将它们替换为0。最后,将相似矩阵与值进行矩阵乘法,得到最终结果。

这里是通过特征相似度直接对注意力矩阵中的元素直接赋0,而dynamic vit是根据某一个概率采样token。

点积注意,分别。我们可以看到,朴素比例点积注意放大了相对较小的相似度权重,这使得输出特征容易受到噪声和干扰背景的影响。然而,这个问题可以通过稀疏缩放点积注意显著缓解

图4的右上方和右下方显示了朴素点积注意和稀疏缩放下相似矩阵行向量的归一化示例。

现有的跟踪器大多采用全连通网络或卷积网络进行前景背景分类和目标边界盒回归,没有根据分类和回归任务的特点对头部网络进行深入分析和设计。受[Wu等人,2020]的启发,我们引入了一个双头预测器来提高分类和回归的准确性。具体如图2所示,它由两个全连通层组成的fc-head和由L个卷积块组成的convn -head组成。在培训中增加一些不集中的任务,以便进行额外的监督。在推理阶段,对于分类任务,我们将fc-head输出的分类分数与convn -head输出的分类分数进行融合;对于回归任务,我们只使用convn -head输出的预测偏移量。

这里的双头预测:推理阶段: 分数由mlp和conv预测,而偏移量只用conv预测。两个网络分别有分类损失和回归损失。

我们遵循[Xu等人,2020]生成分类分数和回归偏移量的训练标签。为了端到端的训练整个网络,目标函数为分类损失和回归损失的加权和,如下所示:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?