问题描述

我认为这其实是个分布式网络 中 如何 保证 数据传输完整性的问题。现在开发的web 服务大多是使用http上传或者下载文件,当然也有支持 ftp 服务器的,只不过较少。但不管使用方式,都是应用层的协议吧。那问题来了,如何在应用层保证数据传输的完整性呢?我们知道数据链路层 可以使用循环冗余(CRC)检验 数据的完整性,应用层是不是可以使用类似的方式呢?

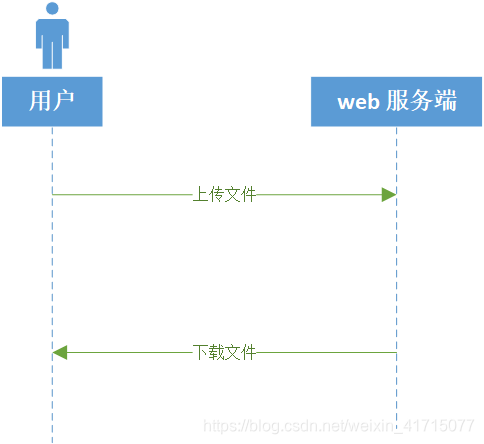

举个简单的应用场景来说明问题:用户上传或者下载文件。

一般文件的数据包比较大,那怎么保证数据传输没有问题呢。数据链路层的冗余校验可以保证在网络设备中传递数据的完整性,也就是在客户端的网卡和服务端的网卡之间传递的数据的绝大部分情况是完整性。哪什么什么情况会导致数据不完整?我认为有两种情况,

(1)丢包(Packet loss)是指一个或多个数据数据包(packet)的数据无法透过网上到达目的地。丢包与比特错误(bit error)与噪声(noise)所造成的虚假的数据包(spurious packets)是三个最主要的数字通信错误的原因。 丢包可能原因是多方面,包括在网上中由于多路径衰落(multi-path fading)所造成的信号衰减(signal degradation),或是因为通道阻塞造成的丢包(packet drop),再者损坏的数据包(corrupted packets)被拒绝通过,或有缺陷的网上硬件,网上驱动程序故障都可能造成丢包。此外,丢包也受信号的信噪比(SNR)的影响。

(2)网络波动,就是Flipping,一般在广域网才会提到,是由于线路的不稳定,出现时通时断或瞬断的现象。造成路由协议频繁进行计算,而这种变化要达到整个网络的路由统一,即达到路由收敛是需要一定时间的,在此期间路由选择是不准确的,造成网络传输受到影响,如果这种变化比较频繁,造成整个网络的较长时间的不稳定,就叫做网络波动;这个问题对整个网络的稳定是非常有害的,严重的时候会造成整个网络的瘫痪,尤其是在大型广域网络中,Flipping是会经常出现、不可避免的,这就需要路由协议对这种现象较好地处理,网络设计和调试人员,在设计和设备配置时,也可以采用多种技术,避免这种现象出现,提高网络的容错能力。

我们之前使用阿里云的时候,就遇到过这种情况。

怎么解决问题

遇到过这种情应该是在应用层使用类似数据链路层的方式—校验。先看下目前比较成熟的方式

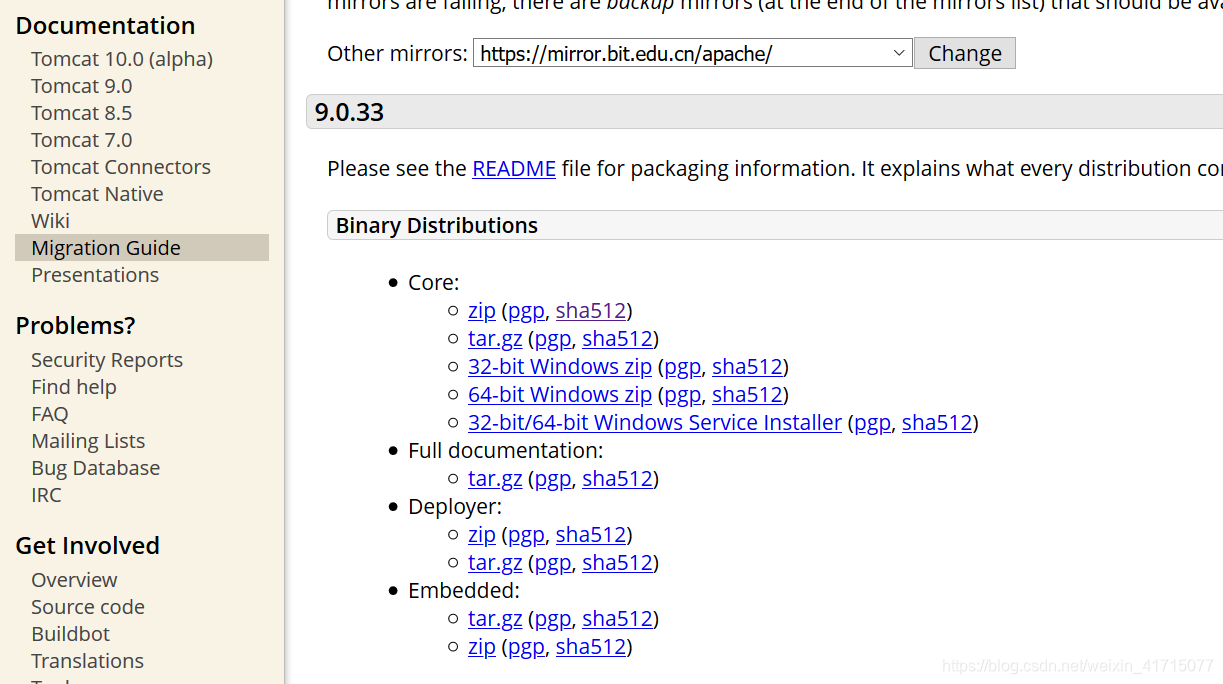

开源软件的下载:

tomcat使用pgp 和sha512摘要算法来验证文件的完整性。

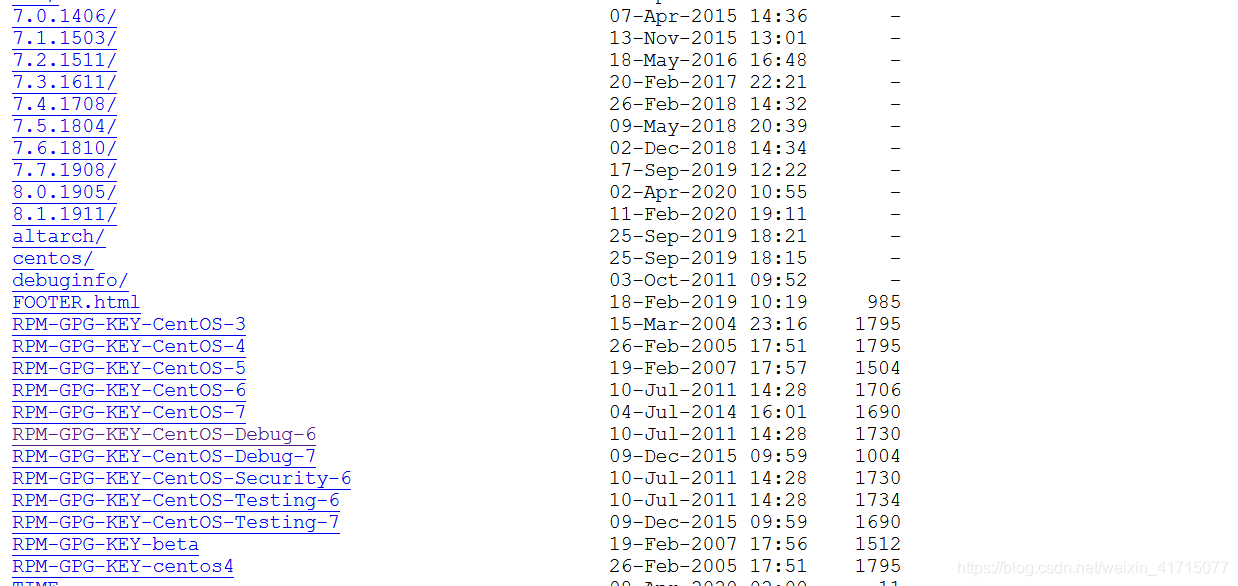

centos 也使用pgp 算法。

centos 也使用pgp 算法。

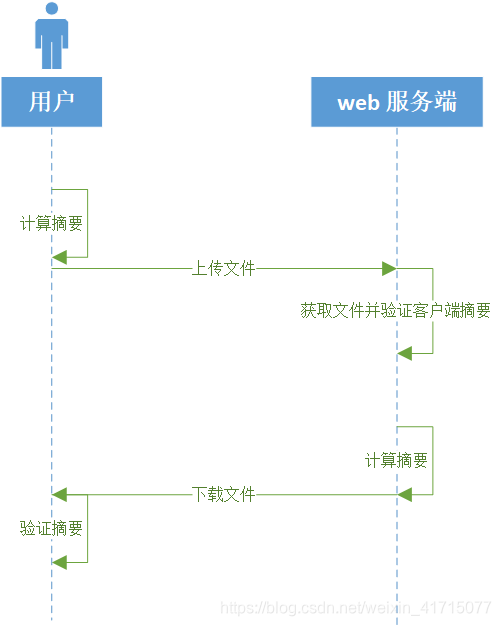

按照这个思路上面的应用场景,应该按照如下方式修改下。

按照这个思路上面的应用场景,应该按照如下方式修改下。

也就是数据的发送端要提供摘要给数据的接收端,数据接收端再根据预定的摘要算法来验证接收的数据是否完整。只不过着这个过程要做成自动化的,不应该由用户手动计算。

也就是数据的发送端要提供摘要给数据的接收端,数据接收端再根据预定的摘要算法来验证接收的数据是否完整。只不过着这个过程要做成自动化的,不应该由用户手动计算。

本文探讨了在分布式网络中,应用层如何确保数据传输的完整性,特别是在文件上传和下载过程中。文章分析了数据链路层与应用层的区别,讨论了丢包和网络波动对数据完整性的潜在影响,并介绍了使用PGP和SHA512摘要算法验证文件完整性的方法。

本文探讨了在分布式网络中,应用层如何确保数据传输的完整性,特别是在文件上传和下载过程中。文章分析了数据链路层与应用层的区别,讨论了丢包和网络波动对数据完整性的潜在影响,并介绍了使用PGP和SHA512摘要算法验证文件完整性的方法。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?