递归特征消除 (Recursive Feature Elimination)

递归消除特征法使用一个基模型来进行多轮训练,每轮训练后,移除若干权值系数的特征,再基于新的特征集进行下一轮训练。

sklearn官方解释:对特征含有权重的预测模型(例如,线性模型对应参数coefficients),RFE通过递归减少考察的特征集规模来选择特征。首先,预测模型在原始特征上训练,每个特征指定一个权重。之后,那些拥有最小绝对值权重的特征被踢出特征集。如此往复递归,直至剩余的特征数量达到所需的特征数量。

RFECV 通过交叉验证的方式执行RFE,以此来选择最佳数量的特征:对于一个数量为d的feature的集合,他的所有的子集的个数是2的d次方减1(包含空集)。指定一个外部的学习算法,比如SVM之类的。通过该算法计算所有子集的validation error。选择error最小的那个子集作为所挑选的特征。

from sklearn.feature_selection import RFE

from sklearn.linear_model import LogisticRegression

from sklearn.datasets import load_iris

iris = load_iris()

#递归特征消除法,返回特征选择后的数据

#递归特征消除法

#递归消除特征法使用一个基模型来进行多轮训练,每轮训练后,消除若干权值系数的特征,再基于新的特征集进行下一轮训练。使用feature_selection库的RFE类来选择特征的代码如下:

#参数estimator为基模型

#参数n_features_to_select为选择的特征个数7

#print(iris.data[0:5])

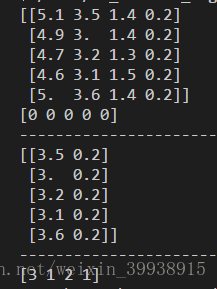

print(iris.data[0:5])

print(iris.target[0:5])

print("-----------------------------------")

selector = RFE(estimator=LogisticRegression(), n_features_to_select=2).fit(iris.data, iris.target)

data = selector.transform(iris.data)

print(data[0:5])

print("-----------------------------------")

print(selector.ranking_)

[3 1 2 1]

第1,3列的验证错误最小,特征选择第1,3列。

本文深入探讨了递归特征消除(RFE)与RFECV在特征选择中的应用,通过使用sklearn库的RFE类与LogisticRegression模型,演示了如何逐步剔除不重要特征,最终确定最优特征组合。

本文深入探讨了递归特征消除(RFE)与RFECV在特征选择中的应用,通过使用sklearn库的RFE类与LogisticRegression模型,演示了如何逐步剔除不重要特征,最终确定最优特征组合。

1526

1526

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?