最近发现很多QQ群和微信群里经常会有人问这么一个问题——“我安装TensorFlow GPU版本怎么总是提示CUDA版本不对或者cuDNN版本不对呢?”为了解决大家这个问题,我特意把TensorFlow1.2到最新版本所需要的CUDA和cuDNN对应的版本做了个整理,希望能够对大家有帮助。

要搭建TensorFlow的GPU版本,首先需要的必备条件就是一块能够支持CUDA的NVIDIA显卡,因为在搭建TensorFlow的GPU版本时,首先需要做的一件事就是安装其基础支持平台CUDA和其机器学习库cuDNN,然后在此基础上搭建TensorFlow GPU版本。

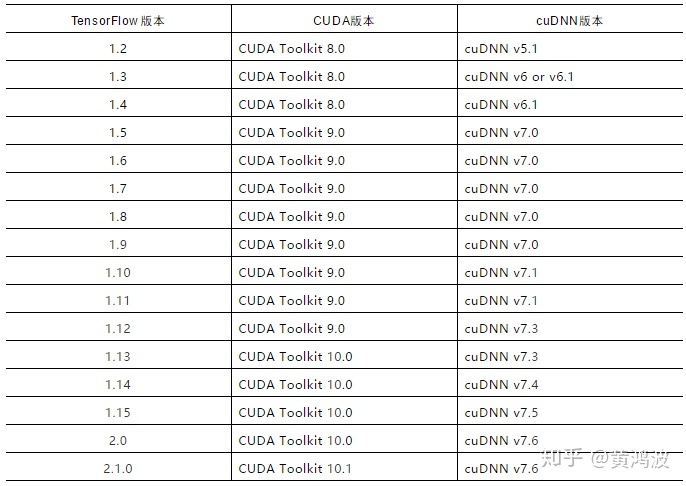

其次还要了解一下不同的TensorFlow版本所需要对应安装的CUDA和cuDNN版本是多少,因为在TensorFlow的GPU版本安装过程中,如果对应的CUDA版本和cuDNN版本不正确的话,是无法正常使用GPU来进行模型训练的。下表整理出了TensorFlow从1.2到最新版本的CUDA和cuDNN所对应的版本集合,希望对大家有帮助。

本文针对安装TensorFlow GPU版本时常见的CUDA和cuDNN版本不匹配问题,整理了从TensorFlow 1.2至最新版本所需CUDA及cuDNN版本对照表,帮助读者正确配置环境。

本文针对安装TensorFlow GPU版本时常见的CUDA和cuDNN版本不匹配问题,整理了从TensorFlow 1.2至最新版本所需CUDA及cuDNN版本对照表,帮助读者正确配置环境。

6347

6347

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?