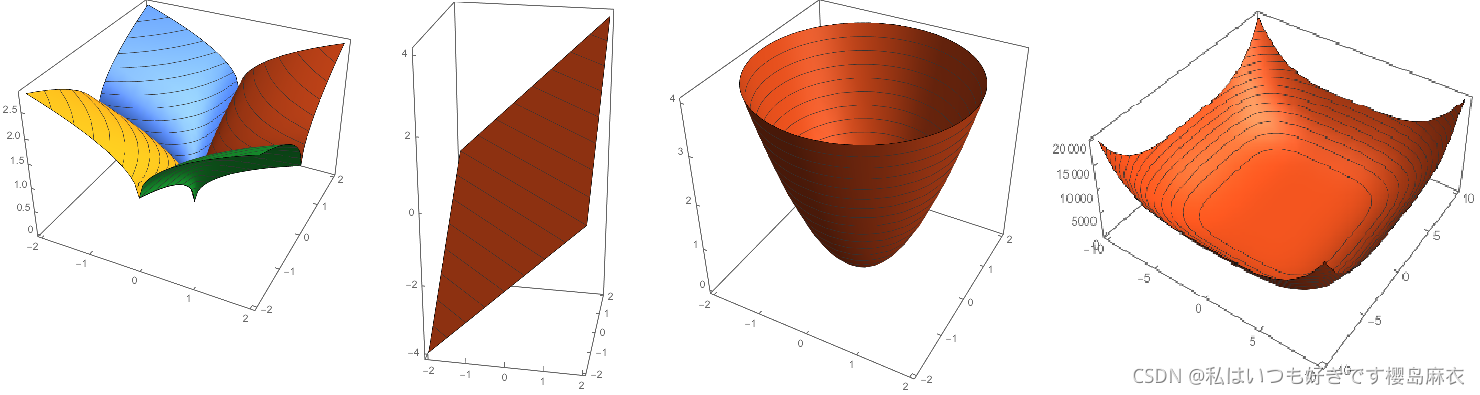

简介:正则化是机器学习和深度学习常用的规则化方法,目的是为了防止过拟合,降低参数的作用范围。从监督学习的角度来看,用来最小化目标函数,让模型更好的拟合数据。常见的范数在:零范数、一范数、二范数、迹范数、Frobenius范数和核范数等等

一:L1和L0范数

L0范数:是指向量中的非0的元素的个数。如果我们用L0来规范化一个参数矩阵W的话,就是期望W矩阵的大部分元素为0。即矩阵是稀疏的。

L1范数:是指向量中的各个元素之和,也称"稀疏规则算子(Lasso regularization)" 可以理解为L0范数的"最优凸近似",我们知道任何规范化算子,如果他在Wi=0的地方不可微,并且可以分解为一个"求和"的形式,那么这个规则化算子就可以实现稀疏。W的L1范数是绝对值,|w|在w=0处不可微。

监督学习梯度视角

定义目标函数:

Loss是损失函数,α是正则化系数。L1正则化是权值w的绝对值之和,所以J是不完全可微分(我理解是不连续肯定不可微)。那么就是不完全可导。我们在最小化Loss函数的时候,通过梯度下降求出损失函数的最小值。加上正则化之后就是求在L1约束下的最小值的解。(这里省去偏执b,我理解为正则化对b的更新没有影响)

梯度下降求导:

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?