本案例是在centos6.5上安装好hadoop2.6.4集群环境基础上进行的Hbase1.2.6分布式安装,hadoop分布式安装请参考《Apache Hadoop 分布式集群环境安装配置详细步骤》

解压安装:

在Master机器上进行操作:

进入文件所在目录: # cd /home/hadoop/下载

# tar -zxf hbase-1.2.6-bin.tar.gz -C /usr/local #解压并复制到目录

# mv /usr/local/hbase-1.2.6 /usr/local/hbase #更改文件夹名称

为用户给文件夹赋值: # cd /usr/local

# chown -R Hadoop ./hbase

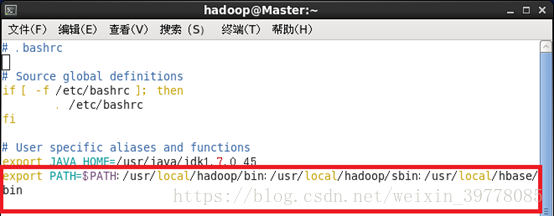

配置环境变量:

# vi ~/.bashrc

如果没有引入过PATH,则添加:

# export PATH=$PATH:/usr/local/hbase/bin

如果引入过,则追加:

重新加载文件: # source ~/.bashrc

版本验证: # /usr/local/hbase/bin/hbase version

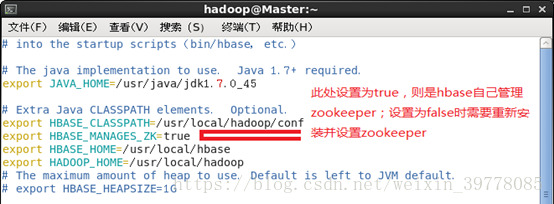

Hbase配置:

# vi /usr/local/hbase/conf/hbase-env.sh (分布式安装一般用重新安装的zookeeper,不用自带的)

# vi /usr/local/hbase/conf/regionservers

去掉localhost,添加Master、Slave1、Slave2

复制 hbase-default.xml 为 hbase-site.xml 并修改配置

关于优化(可略过)修改Hadoop hdfs-site.xml

注意其它的datanode也要进行修改

添加如下内容:

<property>

<name>dfs.datanode.max.xcievers</name>

<value>4096</value>

</property>

原因:

该参数限制了datanode所允许同时执行的发送和接受任务的数量,缺省为256,hadoop-defaults.xml中通常不设置这个参数。这个限制看来实际有些偏小,高负载下,DFSClient在put数据的时候会报could not read from stream的Exception

保存后把hbase分发到其他节点相应位置:

# scp –r /usr/local/hbase root@Slave1:/usr/local/

# scp –r /usr/local/hbase root@Slave2:/usr/local/

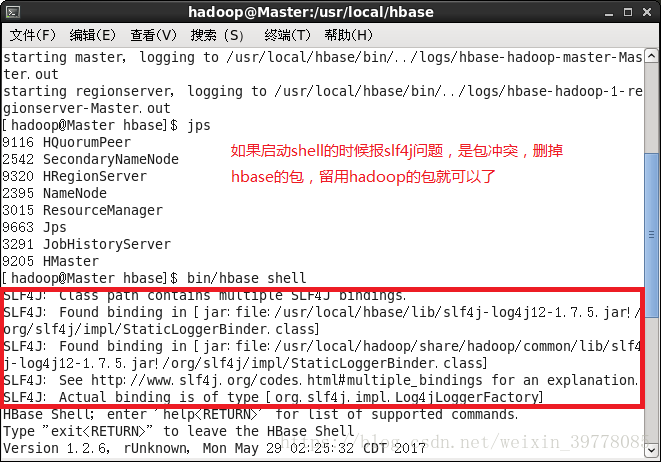

启动:hbase是基于hadoop,

启动zookeeper——启动hadoop——启动hbase

# start-hbase.sh

包冲突问题:

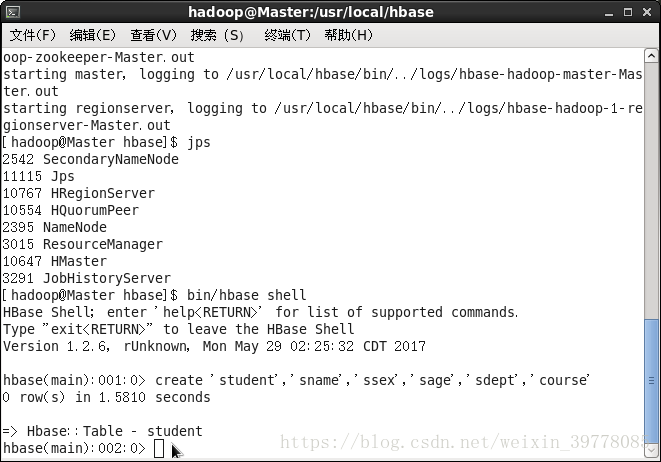

解决后重启启动,进入shell

至此,基于hadoop的hbase分布式安装完成…

本文详细介绍在CentOS 6.5上安装Hadoop 2.6.4集群环境下进行HBase 1.2.6分布式安装的步骤。包括解压安装、环境变量配置、HBase配置及优化等关键环节。

本文详细介绍在CentOS 6.5上安装Hadoop 2.6.4集群环境下进行HBase 1.2.6分布式安装的步骤。包括解压安装、环境变量配置、HBase配置及优化等关键环节。

891

891

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?