《从单个图像学习低光视频增强的时间一致性》

Motivation:作者认为一 一对应的视频数据集太难获取,有以下两点:

在这个基础上,作者提出了一种利用单图像通过预测光流的办法,来保证视频增强过程中的时序一致性方法。侧面说明,作者的这个算法只需要图像就可以训练,然后增强暗光视频。

通过对单图像的光流预测,可以利用单图像和光流融合,得到下一帧信息(有没有大佬这里看懂了,预测光流,你怎么知道图像中的对象的下一步动作??这不是猜嘛,不严谨啊!)。

接下来看算法架构(这个论文写作乱的一),

左侧(a) optial flow prediction , 右侧(b) Training and Testing。

左侧(a) optial flow prediction , 右侧(b) Training and Testing。

(a) optial flow prediction :

首先利用Detectron2对ground truth进行对象实例分割(作者认为分割过程中,总有一些点会产生运动,把这些运动的点随机选取十个,当作指导向量,用于CMP算法中的运动预测),然后对分割出的对象进行掩膜操作,得到掩膜后的图像,此时有2张图像,ground truth 和 masked image,两个图像放入CMP[1]算法中,估计光流。那么CMP是怎么估计光流的

接下来介绍一下CMP算法:

CMP算法:给予图像中对象几个指导向量,算法可以给出下一步的对象运动图。(所以结合(a)optial flow prediction 阶段,通过对图像中对象的实例分割产生几个向量,就表示下一步对象的运动,然后把ground truth 和 masked image放入到CMP算法,就可以得到光流了。)

[1] Xiaohang Zhan, Xingang Pan, Ziwei Liu, Dahua Lin, and Chen Change Loy. Self-supervised learning via conditional motion propagation. In Proceedings of the IEEE conference on computer vision and pattern recognition (CVPR), 2019. 3, 5 《基于运动分析的无监督学习》

f是optial flow, y是image, V是y上的指导向量。

Figure 2 分为3个步骤,细节如下:

分水岭算法将图像看作是地形学上被水覆盖的自然地貌,图像中的每一像素的灰度值表示该点的海拔高度,其每一个局部极小值及其影响区域称为集水盆地,两个集水盆地的边界则为分水岭。 (图像分割经常用)

(b) Training and Testing:

第二个阶段是一个孪生网络,为的是利用第一阶段生成的光流,来保证视频时序一致性。

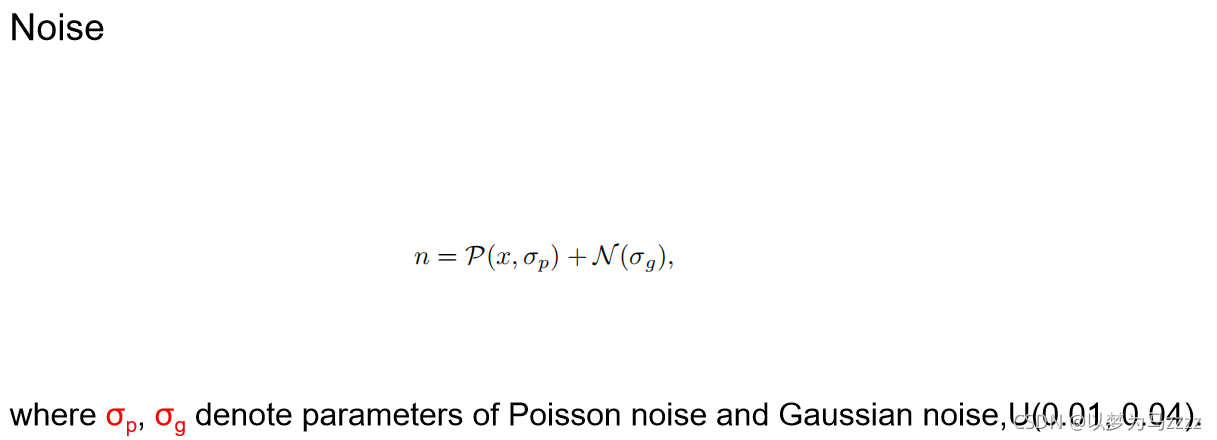

第一层:输入ground truth y1 经过伽马变换和高斯泊松噪声模型,得到近真实弱光图像x1 然后经过一个U-net 得到outpu:g(x1) 。g(x1) 与 y1 计算loss(保证弱光图像的增强)。

第二层:x1 和 第一阶段得到的光流图,经Warping操作,得到x2:

![]()

然后x2 经过U-net,得到Output,g(x2), 此时需要g(x1),g(x2)做一个时序性Loss, 然后g(x2)再和y2(y1和光流做Warping操作)做Loss。

接下来是Loss Function :

lamdba 的消融实验。看天空差距

介绍一下评价视频的几个指标:

最后是如何合成的x1:

最后是如何合成的x1:

结束。

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?