安装hive

1、将hive-0.13.1-cdh5.3.6.tar.gz使用WinSCP上传到sparkproject1的/usr/local目录下。

2、解压缩hive安装包:tar -zxvf hive-0.13.1-cdh5.3.6.tar.gz

3、重命名hive目录:mv hive-0.13.1-cdh5.3.6 hive

4、配置hive相关的环境变量

vi ~/.bashrc

export HIVE_HOME=/usr/local/hive

export PATH=$HIVE_HOME/bin

source ~/.bashrc

安装mysql

1、在sparkproject1上安装mysql。

2、使用yum安装mysql server。

yum install -y mysql-server

service mysqld start

chkconfig mysqld on

3、使用yum安装mysql connector

yum install -y mysql-connector-java

4、将mysql connector拷贝到hive的lib包中 cp /usr/share/java/mysql-connector-java-5.1.17.jar /usr/local/hive/lib

下载:https://mvnrepository.com/artifact/mysql/mysql-connector-java/5.1.17

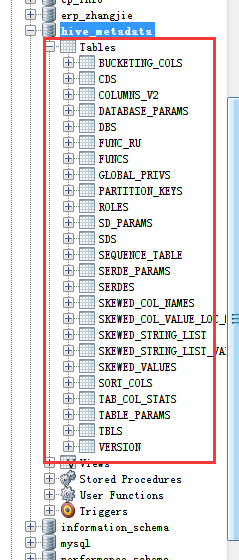

5、在mysql上创建hive元数据库,创建hive账号,并进行授权

create database if not exists hive_metadata;

--以下注意:第一个hive是用户名 第二个hive是密码 中间百分号是host的限制范围为所有,配置为localhost的话,则限制本地

grant all privileges on hive_metadata.* to 'hive'@'%' identified by 'hive';

grant all privileges on hive_metadata.* to 'hive'@'localhost' identified by 'hive';

grant all privileges on hive_metadata.* to 'hive'@'spark1' identified by 'hive';--spark1为主机名

flush privileges;

use hive_metadata;

grant all privileges on hive_metadata.* to 'hive'@'sparkproject1' identified by 'hive';

配置hive相关配置文件(使用默认debry的话默认不改以下配置就行)

| 配置hive-site.xml mv hive-default.xml.template hive-site.xml //hive元数据存放在mysql中,这里不使用hive原带的debry <property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://spark1:3306/hive_metadata?createDatabaseIfNotExist=true</value> </property> //包含元数据的数据存储的JDBC驱动类名称。默认值为org.apache.derby.jdbc.Embedded,这里配置jdbc,需要连接mysql。 <property> <name>javax.jdo.option.ConnectionDriverName</name> <value>com.mysql.jdbc.Driver</value> </property> //数据库用户名 <property> <name>javax.jdo.option.ConnectionUserName</name> <value>hive</value> </property> //数据库用户名的密码 <property> <name>javax.jdo.option.ConnectionPassword</name> <value>hive</value> </property>

扩展: Hive 将元数据存储在 RDBMS 中,一般常用 MySQL 和 Derby。默认情况下,Hive 元数据保存在内嵌的 Derby 数据库中,只能允许一个会话连接,只适合简单的测试。实际生产环境中不适用, 为了支持多用户会话,则需要一个独立的元数据库,使用 MySQL 作为元数据库,Hive 内部对 MySQL 提供了很好的支持。 |

| 配置hive-env.sh和hive-config.sh 创建hive-env.sh mv hive-env.sh.template hive-env.sh 修改hive-config.sh(后来我又配置单机版的,发现没有这个文件,就没有配) vi /usr/local/hive/bin/hive-config.sh export JAVA_HOME=/usr/java/latest export HIVE_HOME=/usr/local/hive export HADOOP_HOME=/usr/local/hadoop |

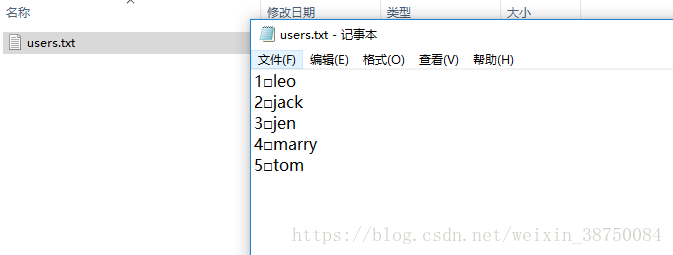

| 验证hive是否安装成功 直接输入hive命令,可以进入hive命令行 create table users(id int, name string) load data local inpath '/usr/local/users.txt' into table users select name from users |

users.txt

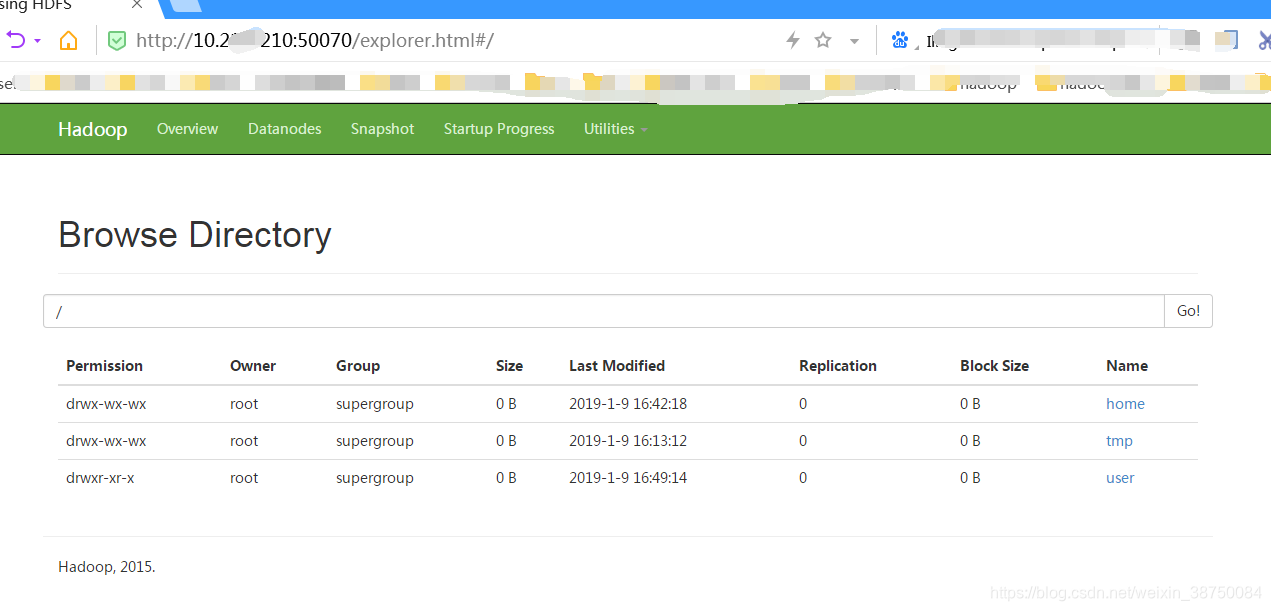

浏览:

本文详细介绍如何在Linux环境下安装并配置Hive,包括使用MySQL作为元数据库的步骤,以及必要的环境变量设置和配置文件调整。

本文详细介绍如何在Linux环境下安装并配置Hive,包括使用MySQL作为元数据库的步骤,以及必要的环境变量设置和配置文件调整。

818

818

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?