一、文献梳理

1、文献背景

为解决下述问题,需要高效的,少样本或零样本的网络压缩方法。

- CNN被广泛应用于CV任务,但需要大量计算资源支持,为满足移动计算需要进行神经网络的压缩

- 在现实应用,数据集往往很难获取

- 现有的零样本下的网络压缩,性能下降很多

2、研究成果

1)模型意义

- 提出了一个有效的无数据训练的办法;

- 有效的组合了GAN和教师-学生网络;

- 设计了适合于这篇文章中的GAN模型的总损失函数;

- 利用知识蒸馏将教师网络压缩为学生网络;

- 对多个数据集和多个经典网络进行了实验以证明有效性。

2)实验

- 实验一:(MNIST/HintonNet)+LeNet-5

- 实验二:模型简化实验

- 实验三:可视化结果

- 实验四:CIFAR+ResNet

- 实验五:CelebA+AlexNet

- 实验六:扩展实验

二、基础知识(传统压缩方法)

1、数据驱动压缩方法

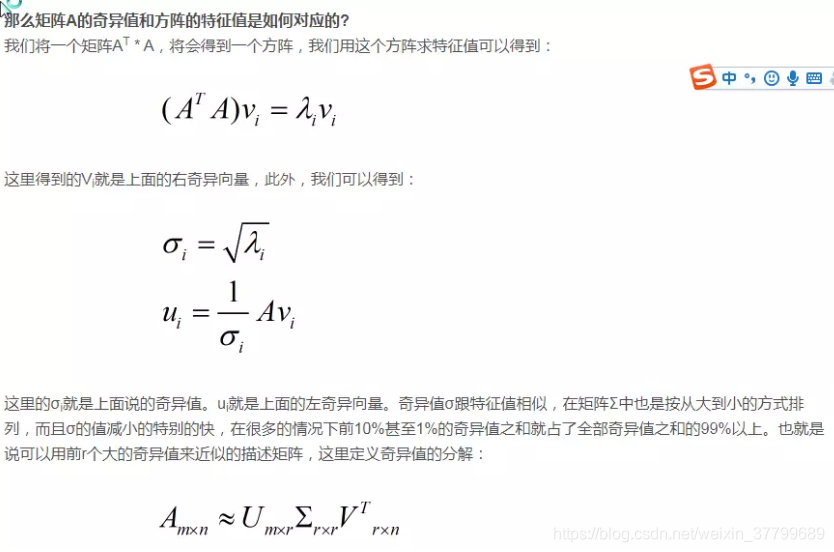

(1)奇异值分解

(2)剪枝、权重分层、哈夫曼编码

(3)相似神经元聚类

神经网络接收外界输入模式时,将会分为不同的对应区域,各区域对输入模式有不同的响应特征,而这个过程是自动完成的。其特点与人脑的自组织特性类似。导师学习网络。它通过自动寻找样本中的内在规律和本质属性,自组织,自适应地改变网络参数与结构。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1042

1042

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?