7.1 RAID磁盘冗余阵列

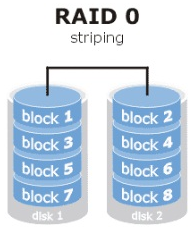

1. RAID 0

硬盘设备的读写性能会提升数倍,但是若任意一块硬盘发生故障将导致整个系统的数据都受到破坏。通俗来说,RAID 0技术能够有效地提升硬盘数据的吞吐速度,但是不具备数据备份和错误修复能力。

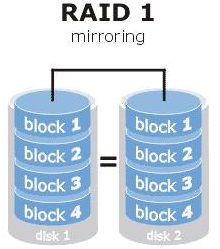

2. RAID 1

如果生产环境对硬盘设备的读写速度没有要求,而是希望增加数据的安全性时,就需要用到RAID 1技术了。

3. RAID 5

RAID5技术是把硬盘设备的数据奇偶校验信息保存到其他硬盘设备中。RAID 5磁盘阵列组中数据的奇偶校验信息并不是单独保存到某一块硬盘设备中,而是存储到除自身以外的其他每一块硬盘设备上,这样的好处是其中任何一设备损坏后不至于出现致命缺陷;图7-3中parity部分存放的就是数据的奇偶校验信息,换句话说,就是RAID 5技术实际上没有备份硬盘中的真实数据信息,而是当硬盘设备出现问题后通过奇偶校验信息来尝试重建损坏的数据。RAID这样的技术特性“妥协”地兼顾了硬盘设备的读写速度、数据安全性与存储成本问题。

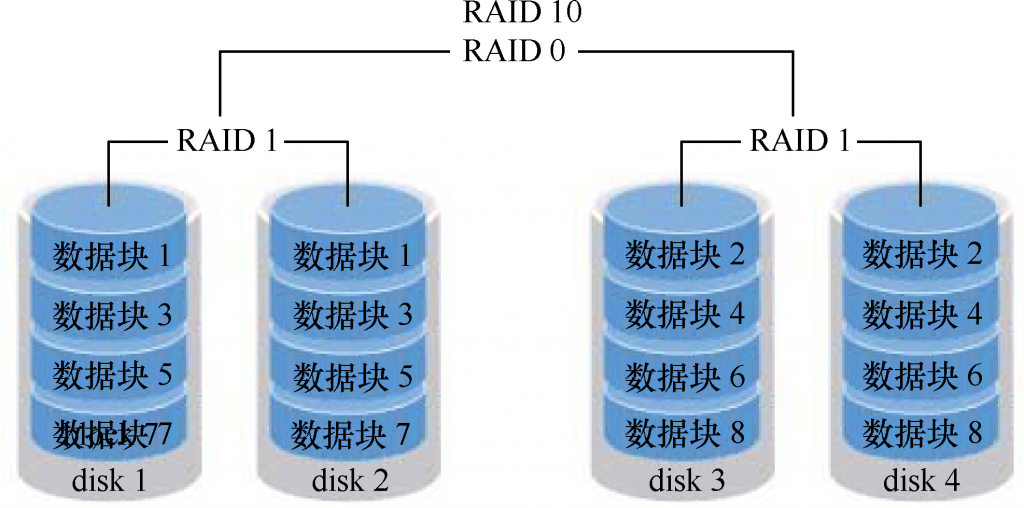

4. RAID 10

RAID 10技术需要至少4块硬盘来组建,其中先分别两两制作成RAID 1磁盘阵列,以保证数据的安全性;然后再对两个RAID 1磁盘阵列实施RAID 0技术,进一步提高硬盘设备的读写速度。这样从理论上来讲,只要坏的不是同一组中的所有硬盘,那么最多可以损坏50%的硬盘设备而不丢失数据。

7.1.1 部署

本文详细介绍了Linux中的RAID技术,包括RAID 0、1、5和10的特点与应用场景,以及如何部署、修复和管理RAID磁盘阵列。接着,文章深入讲解了LVM逻辑卷管理器,包括如何创建、扩容、缩容和删除逻辑卷,以及逻辑卷快照的使用。内容实用,适合Linux系统管理员学习。

本文详细介绍了Linux中的RAID技术,包括RAID 0、1、5和10的特点与应用场景,以及如何部署、修复和管理RAID磁盘阵列。接着,文章深入讲解了LVM逻辑卷管理器,包括如何创建、扩容、缩容和删除逻辑卷,以及逻辑卷快照的使用。内容实用,适合Linux系统管理员学习。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

266

266

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?