简介:Python36资源包提供了一个全面的Python开发环境,集成了Python 3.6版本和多个关键库,如IPython、Pandas、NumPy、Matplotlib和Django。IPython增强了交互式编程体验,Pandas和NumPy在数据处理和科学计算中发挥重要作用,Matplotlib是数据可视化的必备工具,Django则是强大的Web应用开发框架。此资源包旨在为用户提供所有必需的工具和库,帮助他们高效进行数据分析、Web开发等工作,并支持快速学习和项目搭建。

1. Python 3.6 版本介绍

Python 3.6作为在2016年发布的Python语言的一个重要版本,引入了多种新特性,旨在提升代码的可读性与性能。它的发布标志着Python语言发展的一个新阶段,吸引了广泛的开发者社区关注。

1.1 新特性概览

Python 3.6版本引入了几个影响深远的新特性,包括f-string、类型注解以及字典的有序性。这些改变不仅优化了开发者的编码体验,也使得Python在数据分析和科学计算中的应用更加广泛。

1.2 f-string的革命性改进

f-string提供了一种非常便捷的字符串格式化方式,通过在字符串前加上字母 f 并在花括号 {} 内直接嵌入表达式来实现。其性能相较于旧版本有显著提升,因此深受Python社区的喜爱。

1.3 字典的有序性

在Python 3.6之前,字典是无序的,意味着元素的存储顺序无法保证。新的版本改变了这一点,使得字典在内部以插入顺序维护键值对,这一特性对跟踪记录执行顺序或数据日志非常有帮助。

通过本章的介绍,我们揭开了Python 3.6的神秘面纱,揭示了它的新功能如何影响着代码编写和数据处理。在下一章中,我们将深入探讨IPython交互式shell,它作为Python开发中不可或缺的工具,提供了诸多增强功能以提高开发效率。

2. IPython交互式shell功能

2.1 IPython基础操作

2.1.1 IPython的安装与启动

IPython是一个强化的交互式Python shell,提供更丰富的输入输出功能和交互式数据处理能力。首先,我们需要进行IPython的安装,推荐使用pip进行安装,打开命令行工具,输入以下指令:

pip install ipython

安装完成后,启动IPython非常简单,只需在命令行中输入 ipython 并回车即可:

ipython

启动后,你会看到一个带有“In [1]:”提示符的交互式环境,表明你已经成功进入了IPython。

2.1.2 基本命令与快捷操作

在IPython中,你不仅可以执行标准的Python代码,还可以使用它提供的快捷命令。例如,使用 ? 可以获取关于对象的帮助信息:

object? # 查看object的帮助信息

使用 %quickref 可以查看IPython的快速引用卡片:

%quickref

快捷操作还包括使用上下箭头键翻阅历史命令,以及使用 Tab 键自动补全命令。

2.2 IPython的高级特性

2.2.1 补全与自动更正

IPython提供了非常有用的自动补全功能,当你输入代码的一部分并按下Tab键时,IPython会尝试完成你的输入。例如,如果你输入 strin 然后按下Tab键,它会根据上下文自动补全为 str 对象的方法列表。

此外,IPython还能进行自动更正。如果你打错字或输入一个不存在的命令,它会尝试理解你的意图并给出相应的建议。例如,如果你输入 frint ,IPython会尝试将其更正为 print 。

2.2.2 魔法命令详解

IPython中的“魔法命令”是一些内建的命令,使用前需要加一个百分号 % 。它们提供了一些特殊的功能。例如:

-

%lsmagic可以列出所有的魔法命令; -

%timeit可以测量代码段的执行时间; -

%matplotlib可以设置Matplotlib绘图模式。

下面是一个使用 %timeit 的例子:

%timeit range(1000).count(9)

# 输出执行时间的统计信息

2.2.3 代码调试与性能分析

IPython还支持一些代码调试功能。你可以使用 %debug 魔法命令启动一个交互式的调试器,它会在错误发生后立即启动。

而性能分析可以使用 %prun 魔法命令。它基于Python的cProfile模块,用于分析代码段的性能,找出代码瓶颈。使用方法如下:

%prun -l 5 -s cum time.sleep(1)

这条命令会执行 time.sleep(1) ,并展示前5个最耗费时间的函数调用。

IPython的这些高级特性使得它成为了Python开发者不可或缺的工具之一。通过这些功能,用户能够更加高效地编写和调试代码,同时也能够更好地了解和优化代码性能。在后面的章节中,我们将深入探讨IPython在数据处理和分析中的其他实用技巧。

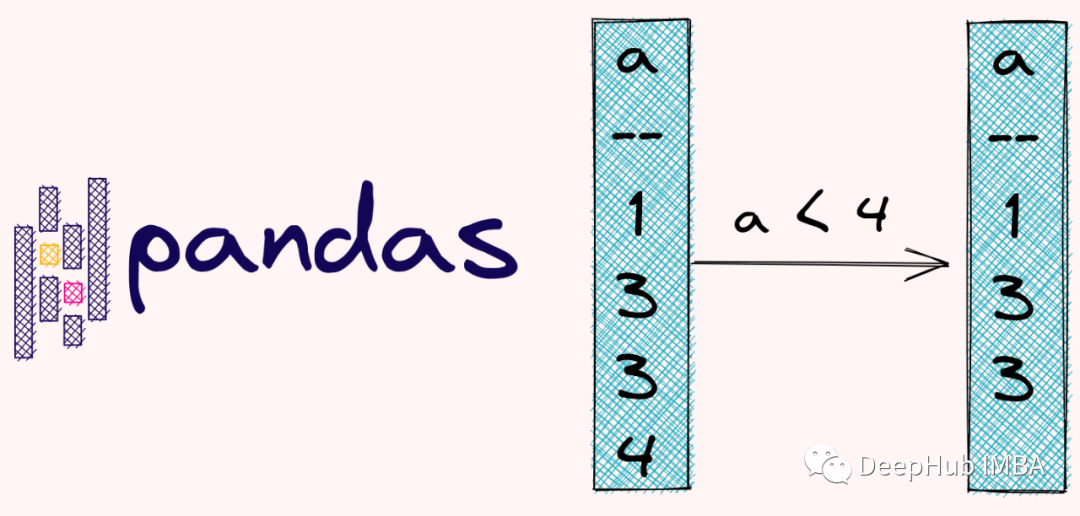

3. Pandas数据处理能力

3.1 Pandas基础

3.1.1 Series与DataFrame构建

Pandas库中的核心数据结构是 Series 和 DataFrame 。 Series 是一维的数组结构,可以包含任何数据类型(整数、字符串、浮点数、Python对象等),并带有索引标签。 DataFrame 是一个二维的表格型数据结构,可以看作是一个Series容器,它的每一列是一个Series,拥有同样的索引。

以下是创建 Series 和 DataFrame 对象的基本方法:

import pandas as pd

# 创建Series

series_data = pd.Series([1, 2, 3, 4], index=['a', 'b', 'c', 'd'])

# 创建DataFrame

data = {'column1': [1, 2, 3], 'column2': [4, 5, 6]}

df = pd.DataFrame(data, index=['a', 'b', 'c'])

print("Series:\n", series_data)

print("\nDataFrame:\n", df)

在创建 Series 时,可以通过 index 参数指定索引标签,如果不指定,则默认从0开始的整数索引。 DataFrame 的构造则需要一个字典,字典的键对应于DataFrame的列名,字典的值为列的数据。同样,也可以通过 index 参数来指定行索引。

3.1.2 数据导入与导出

数据导入与导出是数据处理中极为关键的步骤,Pandas支持多种格式的数据导入与导出,包括CSV、Excel、JSON等格式。这些功能极大地提高了数据处理的便利性。

使用 read_csv 函数导入CSV文件:

# 导入CSV文件到DataFrame

df_csv = pd.read_csv('example.csv', sep=',', header=0, index_col=None)

print(df_csv)

使用 to_csv 函数将DataFrame导出为CSV文件:

# 将DataFrame导出为CSV文件

df.to_csv('output_example.csv', index=False, encoding='utf-8')

在上述代码中, read_csv 的 sep 参数用于指定字段分隔符,默认是逗号。 header=0 指明第一行是列名, index_col=None 表示不将任何列作为行索引。 to_csv 函数的 index=False 参数防止将行索引写入到CSV文件中, encoding='utf-8' 确保字符编码为UTF-8格式。

数据导入导出的灵活性,使得Pandas可以轻松地与各种数据源进行交互,为数据处理提供了坚实的基础。

3.2 数据清洗与处理

3.2.1 缺失值处理

在处理实际数据时,经常会遇到缺失值的问题。缺失值可能是由于数据收集不完整或者某些记录中某些字段不适用而产生的。Pandas提供了多种方法来处理缺失值,如删除含有缺失值的行或列、填充缺失值等。

以下是如何识别和处理缺失值的示例代码:

import numpy as np

# 生成含有缺失值的DataFrame

df_with_missing = pd.DataFrame([[np.nan, 2, np.nan, 0],

[3, 4, np.nan, 1],

[np.nan, np.nan, np.nan, np.nan],

[np.nan, 3, np.nan, 4]],

columns=list('ABCD'))

# 使用dropna删除含有缺失值的行

df_dropped = df_with_missing.dropna(how='any')

# 使用fillna填充缺失值

df_filled = df_with_missing.fillna(value=10)

print("DataFrame with missing values:\n", df_with_missing)

print("After dropping rows with missing values:\n", df_dropped)

print("After filling missing values with 10:\n", df_filled)

在上述代码中, dropna 函数的 how='any' 参数表示如果一行中有任何 NaN 值就会被删除。 fillna 函数的 value 参数用于指定要填充的值,这里填充的是10。

处理缺失值是数据清洗过程中的重要步骤,适当的处理方法可以显著提高数据质量。

3.2.2 数据类型转换与映射

在数据处理中,数据类型转换是处理不同数据格式和确保数据一致性的重要手段。Pandas允许开发者将数据从一种类型转换为另一种类型,例如字符串到日期时间对象的转换。

数据映射则是将数据按照某种规则转换为新的值,常用方法包括使用 replace 进行简单的值替换,以及使用 map 和 apply 进行复杂的值转换。

以下是数据类型转换与映射的示例:

# 将字符串转换为日期时间类型

df['date_column'] = pd.to_datetime(df['date_column'], format='%Y-%m-%d')

# 使用replace方法进行简单的值替换

df['status_column'] = df['status_column'].replace('active', 1)

# 使用map方法根据字典进行值转换

status_mapping = {'active': 1, 'inactive': 0}

df['status_column'] = df['status_column'].map(status_mapping)

# 使用apply方法根据函数进行值转换

def convert_status_to_int(status):

return 1 if status == 'active' else 0

df['status_column'] = df['status_column'].apply(convert_status_to_int)

print("DataFrame after data type conversion and mapping:\n", df)

在上述代码中, to_datetime 函数用于将字符串转换为日期时间对象, replace 方法用于简单的值替换, map 方法用于根据给定的字典进行映射转换,而 apply 方法则允许应用任意函数进行更复杂的转换。

3.2.3 数据合并与重塑

在数据处理中,经常需要对多个数据集进行合并或者重新组织数据结构。Pandas提供了诸如 concat 、 merge 和 pivot 等函数来满足这些需求。

使用 concat 函数进行纵向合并:

df1 = pd.DataFrame({'A': ['A0', 'A1', 'A2'],

'B': ['B0', 'B1', 'B2']},

index=[0, 1, 2])

df2 = pd.DataFrame({'A': ['A3', 'A4', 'A5'],

'B': ['B3', 'B4', 'B5']},

index=[3, 4, 5])

# 使用concat进行纵向合并

df_combined = pd.concat([df1, df2])

print("DataFrame after concatenation:\n", df_combined)

使用 merge 函数进行横向合并:

left = pd.DataFrame({'key': ['foo', 'foo'], 'lval': [1, 2]})

right = pd.DataFrame({'key': ['foo', 'foo'], 'rval': [4, 5]})

# 使用merge进行横向合并

df_merged = pd.merge(left, right, on='key')

print("DataFrame after merge:\n", df_merged)

使用 pivot 函数进行数据重塑:

df = pd.DataFrame({'A': ['foo', 'foo', 'foo', 'bar', 'bar'],

'B': ['one', 'one', 'two', 'two', 'one'],

'C': [1, 2, 3, 4, 5],

'D': [5, 4, 3, 2, 1]})

# 使用pivot进行数据重塑

df_pivoted = df.pivot(index='A', columns='B', values='C')

print("DataFrame after pivot:\n", df_pivoted)

通过 concat 、 merge 和 pivot 函数的组合使用,可以灵活地对数据集进行合并、重组,从而满足数据处理的多样化需求。

4. NumPy科学计算支持

在现代的数据科学和机器学习领域,NumPy库几乎成为了事实上的标准工具。NumPy提供了高性能的多维数组对象以及用于处理数组的各种工具。本章将深入探讨NumPy的使用和内部机制,旨在让读者不仅能用NumPy进行基本的科学计算,还能理解和掌握其在复杂科学计算中的高级应用。

4.1 NumPy数组基础

NumPy的核心是它的N维数组对象,这是所有科学计算的基础。在这个小节中,我们将学习如何创建和操作NumPy数组,以及它们的基本运算。

4.1.1 创建与维度操作

NumPy数组的创建可以通过多种方式,最常见的是从Python列表转换而来,也可以通过NumPy的函数直接创建。创建数组后,维度操作是接下来要学习的技能。理解维度操作对于后续进行高效的数组计算至关重要。

import numpy as np

# 从Python列表创建一维数组

array_1d = np.array([1, 2, 3, 4])

# 创建二维数组

array_2d = np.array([[1, 2, 3], [4, 5, 6]])

# 获取数组的维度

print("Array 1D shape:", array_1d.shape)

print("Array 2D shape:", array_2d.shape)

# 修改数组的维度,转换为3x2的二维数组

reshaped_array = array_1d.reshape((3, 2))

print("Reshaped Array shape:", reshaped_array.shape)

在这个代码块中,我们创建了一维和二维数组,并使用 reshape 方法改变数组的形状。 shape 属性返回一个包含数组维度的元组。

4.1.2 数组的基本运算

NumPy数组支持元素级的运算,这为数值计算提供了极大的便利。数组的基本运算包括加法、减法、乘法、除法等。

# 数组元素级的加法

sum_array = array_1d + array_1d

# 数组元素级的乘法

mult_array = array_1d * array_1d

# 使用NumPy的运算函数

np_sum_array = np.add(array_1d, array_1d)

np_mult_array = np.multiply(array_1d, array_1d)

print("Element-wise Sum:", sum_array)

print("Element-wise Multiplication:", mult_array)

print("NumPy Add:", np_sum_array)

print("NumPy Multiply:", np_mult_array)

在上面的例子中,展示了数组元素级的加法和乘法操作,以及如何使用NumPy提供的 add 和 multiply 函数进行相同的计算。通过使用NumPy的内置函数,代码更加简洁且易于理解。

4.2 高级索引与广播

NumPy不仅支持基本的索引和切片,还支持高级索引和广播机制。高级索引允许我们使用数组或掩码进行复杂的索引操作,而广播机制则允许我们在不同形状的数组之间进行算术运算。

4.2.1 复杂索引技巧

NumPy的索引机制非常强大,可以使用布尔数组、整数数组、甚至数组的组合来进行复杂的索引操作。

# 创建一个布尔数组

bool_index = np.array([True, False, True, False])

# 使用布尔索引选择元素

selected_elements = array_1d[bool_index]

print("Boolean Indexing:", selected_elements)

使用布尔索引可以轻松地根据条件选择数组中的元素。这是数据筛选中非常有用的技术。

4.2.2 广播机制及其应用

NumPy的广播机制允许不同形状的数组在算术运算中使用。广播规则是通过扩展较小的数组维度来匹配较大数组的维度,从而使得两个数组可以在某个维度上进行算术运算。

# 创建两个形状不同的数组

small_array = np.array([1, 2, 3])

big_array = np.array([[1, 2, 3], [4, 5, 6]])

# 执行广播运算

broadcast_sum = small_array + big_array

print("Broadcasting Result:\n", broadcast_sum)

在上述示例中,一维数组 small_array 被自动广播到与二维数组 big_array 相同的形状,从而使得两个数组能够在行维度上进行加法运算。

4.3 NumPy在科学计算中的应用

NumPy的设计目标之一就是提供一个良好的科学计算基础。除了创建和操作数组,NumPy还内置了线性代数和统计分析相关的函数,使得进行科学计算更加直接和高效。

4.3.1 线性代数运算

NumPy提供了全面的线性代数支持,包括但不限于矩阵乘法、矩阵分解、特征值和特征向量的计算等。

# 创建两个数组作为线性代数运算的示例

A = np.array([[1, 2], [3, 4]])

B = np.array([[5, 6], [7, 8]])

# 矩阵乘法

product = np.dot(A, B)

# 计算矩阵的特征值和特征向量

eigenvalues, eigenvectors = np.linalg.eig(A)

print("Matrix Product:\n", product)

print("Eigenvalues:", eigenvalues)

print("Eigenvectors:\n", eigenvectors)

在上述代码中, dot 函数执行了两个数组的矩阵乘法,而 linalg.eig 函数计算了数组 A 的特征值和特征向量。

4.3.2 统计分析与随机数生成

NumPy也包含丰富的统计分析功能,可以方便地进行均值、方差、标准差等计算。除此之外,NumPy还可以生成各种随机数,用于模拟或数据分析。

# 生成一组随机数

random_numbers = np.random.rand(5)

# 计算随机数的均值和方差

mean_value = np.mean(random_numbers)

variance_value = np.var(random_numbers)

print("Random Numbers:", random_numbers)

print("Mean Value:", mean_value)

print("Variance Value:", variance_value)

在这里, random.rand 函数生成了一组均匀分布的随机数,然后使用 mean 和 var 函数计算了这些随机数的均值和方差。

通过上述内容,我们介绍了NumPy科学计算支持的核心概念和应用。NumPy库的使用是数据科学和机器学习领域的基石之一,掌握其使用方法对于进行高效的数值计算至关重要。在后续章节中,我们将进一步探索如何利用NumPy进行更高级的数据分析和科学计算任务。

5. Matplotlib数据可视化技巧

5.1 Matplotlib基础绘图

Matplotlib是Python中最常用的绘图库之一,它提供了一个类似MATLAB的绘图环境。在Matplotlib中,一张图(figure)可以包含一个或多个轴(axes),而轴是实际绘图的地方。通过轴,可以绘制各种类型的图表,比如线条图、条形图、散点图等。

图表类型与选择

选择合适的图表类型对于表达数据至关重要。Matplotlib支持多种图表,每个图表类型适用于展示不同种类的数据信息: - 线条图(Line Chart):用于展示趋势,例如时间序列数据。 - 条形图(Bar Chart):适合比较不同类别的数值大小。 - 饼图(Pie Chart):用于展示比例关系。 - 散点图(Scatter Plot):用来观察变量之间的关系。 - 直方图(Histogram):展示数据分布情况。 - 三维图形(3D Plot):适合展示三维数据集。

绘图函数与参数

Matplotlib提供了很多绘图函数,每个函数都有许多参数,允许用户自定义图表的各个方面。例如,绘制线条图可以使用 plt.plot() 函数。此函数的一些常用参数包括: - x :指定x轴的数据点。 - y :指定y轴的数据点。 - color :指定线条颜色。 - linestyle :指定线条样式。 - marker :指定数据点的标记样式。

下面是一个简单的线条图绘制示例:

import matplotlib.pyplot as plt

# 假设的年销售额数据

years = [2015, 2016, 2017, 2018, 2019, 2020]

sales = [30, 35, 42, 50, 60, 70]

# 绘制线条图

plt.plot(years, sales, color='blue', linestyle='-', marker='o')

# 添加标题和轴标签

plt.title('Annual Sales Trend')

plt.xlabel('Year')

plt.ylabel('Sales in $ Millions')

# 显示图例

plt.legend(['Sales'])

# 显示图形

plt.show()

通过调整参数,可以轻松定制图表的外观,以满足不同场景的展示需求。Matplotlib的强大之处在于其可扩展性,可以组合不同类型的图表和样式来创建复杂的可视化效果。在下一节,我们将探索如何进行高级图表定制。

简介:Python36资源包提供了一个全面的Python开发环境,集成了Python 3.6版本和多个关键库,如IPython、Pandas、NumPy、Matplotlib和Django。IPython增强了交互式编程体验,Pandas和NumPy在数据处理和科学计算中发挥重要作用,Matplotlib是数据可视化的必备工具,Django则是强大的Web应用开发框架。此资源包旨在为用户提供所有必需的工具和库,帮助他们高效进行数据分析、Web开发等工作,并支持快速学习和项目搭建。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?