简介:本文深入介绍了网络视频流实时传输的关键技术和FFmpeg多媒体处理框架的使用。RTP协议作为实时数据传输的标准协议,配合FFmpeg,为音视频的实时传输提供了高效解决方案。文章详细阐述了使用FFmpeg接收RTP视频流并进行解码显示的步骤,包括初始化RTP会话、连接RTP流、视频流解码、视频帧显示以及错误处理等。同时,对一个Android应用包"RemoteCamera_10190.apk"的分析提供了一个实际应用案例,说明了如何在Android设备上实现远程视频监控。

1. RTP实时传输视频流

在多媒体通信领域,实时传输协议(Real-time Transport Protocol, RTP)是用于传输实时数据(例如音频和视频)的关键技术。RTP是建立在用户数据报协议(User Datagram Protocol, UDP)之上的,确保了音频和视频流能够在IP网络上有效、实时地传输。本章节将重点介绍RTP的构成、特点以及如何实现高质量的视频流传输。

1.1 RTP协议的构成和特点

RTP由两部分组成:RTP数据协议和实时传输控制协议(RTCP)。RTP数据协议负责传输媒体数据,而RTCP则监控服务质量,并提供反馈信息。RTP的特点包括:

- 实时性:它通过时间戳和序列号支持媒体流的同步和排序。

- 灵活性:支持多种有效载荷格式,以适应不同的应用和编码。

- 可扩展性:允许在不影响现有应用的前提下添加新功能。

1.2 RTP在视频流中的应用

在视频流传输中,RTP是承载视频数据的载体。它通过定义统一的报文格式和处理机制,确保数据包可以快速地从发送端传输到接收端。关键步骤包括:

- 封装:将编码后的视频帧封装到RTP数据包中。

- 传输:通过UDP网络发送封装后的数据包。

- 解封装:接收端从RTP数据包中提取视频帧数据。

通过这些步骤,RTP在保证实时性和连续性的同时,也使得视频流能够在网络环境中有效地传播。随着RTP的使用,多媒体通信变得更加流畅和可靠,为实时视频通话、在线直播等应用场景提供了坚实的基础。

2. FFmpeg解码显示技术

FFmpeg是多媒体处理领域内的一个强大工具集合,其能够进行视频和音频的解码、编码、转码、复用、解复用和流处理等多种功能。在这一章,我们将深入了解FFmpeg在视频流处理中的解码显示技术,具体包括FFmpeg的基础架构、解码视频流的基本流程以及其在视频显示中的应用。

2.1 FFmpeg的基础架构和组成

2.1.1 FFmpeg库的构成

FFmpeg的构成主要是由几个核心库构成,其中包括libavcodec、libavformat、libavutil和libswscale等。每个库都扮演着不同的角色:

- libavcodec:包含所有视频编解码器的实现,以及音频编解码器。

- libavformat:提供封装格式的解析和生成能力,负责读取和写入多媒体数据流。

- libavutil:包含基础的工具函数、数据结构以及数学运算等通用工具。

- libswscale:负责像素格式转换以及色彩空间转换。

这些库协同工作,让开发者能够通过FFmpeg实现对多媒体数据的全面处理。

2.1.2 解码器的种类和特性

FFmpeg支持多种编解码器,包括但不限于H.264、H.265/HEVC、VP8、VP9、AV1等视频编码格式,以及AAC、MP3、FLAC等音频编码格式。每个解码器都有其特定的解码速度、质量、兼容性和硬件加速支持特性。

在选择解码器时,不仅要考虑到解码效率和质量,还需考虑目标平台的硬件加速能力。例如,x264是一个软件视频编码器,而NVIDIA的硬件加速解码器NvENC则可以在支持的NVIDIA显卡上高效运行。

2.2 FFmpeg解码视频流的基本流程

2.2.1 接收RTP数据包

在处理实时传输的视频流时,FFmpeg首先需要通过网络接口接收RTP数据包。这一步骤通常涉及到对网络套接字的设置和监听,然后读取RTP封装的数据包。RTP数据包通常通过UDP协议进行传输。

int fd = socket(AF_INET, SOCK_DGRAM, 0);

struct sockaddr_in addr;

memset(&addr, 0, sizeof(addr));

addr.sin_family = AF_INET;

addr.sin_port = htons(RTP_PORT);

addr.sin_addr.s_addr = htonl(INADDR_ANY);

bind(fd, (struct sockaddr *)&addr, sizeof(addr));

struct sockaddr_in src_addr;

socklen_t addrlen = sizeof(src_addr);

uint8_t buffer[1500];

int len = recvfrom(fd, buffer, sizeof(buffer), 0, (struct sockaddr *)&src_addr, &addrlen);

2.2.2 解封装和解码过程

接收RTP数据包之后,需要对数据包进行解封装和解码。解封装是指从RTP封装中提取出编码后的音视频数据。然后,通过选择合适的解码器来解码这些数据,得到原始的音视频帧。

AVPacket* packet = av_packet_alloc();

av_packet_from_data(packet, buffer, len);

av_packet_make_writable(packet);

AVCodec* codec = avcodec_find_decoder(AV_CODEC_ID_H264);

avcodec_open2(codec_ctx, codec, NULL);

if (avcodec_send_packet(codec_ctx, packet) < 0) {

// Handle error

}

AVFrame* frame = av_frame_alloc();

if (avcodec_receive_frame(codec_ctx, frame) < 0) {

// Handle error

}

在这段代码中,首先创建了一个 AVPacket 来存储RTP封装的数据。然后通过 avcodec_find_decoder 和 avcodec_open2 选择并初始化解码器。之后,将数据包发送给解码器,并接收解码后的原始帧。

2.3 FFmpeg在视频显示中的应用

2.3.1 显示设备的选择

在FFmpeg中,有多种显示设备可供选择,例如X11、SDL、DirectDraw、Vulkan、OpenGL等。每种显示设备都有其特点和使用场景。例如,SDL提供了跨平台的音频和视频输出能力,而DirectDraw通常用于Windows平台的视频显示。

AVDictionary* options = NULL;

av_dict_set(&options, "window_title", "FFmpeg Video Output", 0);

av_dict_set(&options, "sws_flags", "bicubic", 0);

if (avcodec_send_frame(codec_ctx, frame) < 0) {

// Handle error

}

AVFrame* out_frame = av_frame_alloc();

if (avcodec_receive_frame皮肤病 codec_ctx, out_frame) < 0) {

// Handle error

}

// Initialize the chosen display device

SDL_Init(SDL_INIT_VIDEO);

SDL_Window* window = SDL_CreateWindow("", SDL_WINDOWPOS_UNDEFINED, SDL_WINDOWPOS_UNDEFINED, frame->width, frame->height, 0);

2.3.2 同步机制实现

在视频播放过程中,同步机制非常重要。FFmpeg提供了基于时间戳的同步机制,可以确保音频和视频同步播放。此外,还可以利用FFmpeg的音视频同步算法来解决播放中可能出现的延迟问题。

// The time of the first decoded frame

int64_t first_pts = AV_NOPTS_VALUE;

if (first_pts == AV_NOPTS_VALUE)

first_pts = frame->pts;

double pts_time = frame->pts * av_q2d(cts->time_base);

AVFrame* sync_frame = av_frame_alloc();

if (avcodec_send_frame(codec_ctx, sync_frame) < 0) {

// Handle error

}

AVFrame* out_frame = av_frame_alloc();

if (avcodec_receive_frame(codec_ctx, out_frame) < 0) {

// Handle error

}

double out_time = out_frame->pts * av_q2d(cts->time_base);

double delay = 0;

if (out_time > pts_time + 0.02) {

delay = av_q2d(cts->time_base);

} else if (out_time < pts_time) {

delay = 0.1;

}

SDL_Delay(delay * 1000);

SDL_PollEvent(NULL);

在此段代码中,首先获取第一个解码帧的时间戳,并用于后续的同步计算。通过计算当前帧的时间戳与第一个帧的时间戳差值,得到需要延迟的时间,以确保视频帧的播放同步。使用 SDL_Delay 实现延迟操作,从而在播放过程中实现视频帧的同步。

本章节介绍的内容是FFmpeg技术的核心部分之一,通过了解和掌握FFmpeg的基础架构和组成、解码视频流的基本流程以及视频显示中的应用,我们可以更好地利用FFmpeg进行音视频流的处理和展示。

3. RTP与RTCP配合使用原理

3.1 RTP协议的概述

3.1.1 RTP数据包结构解析

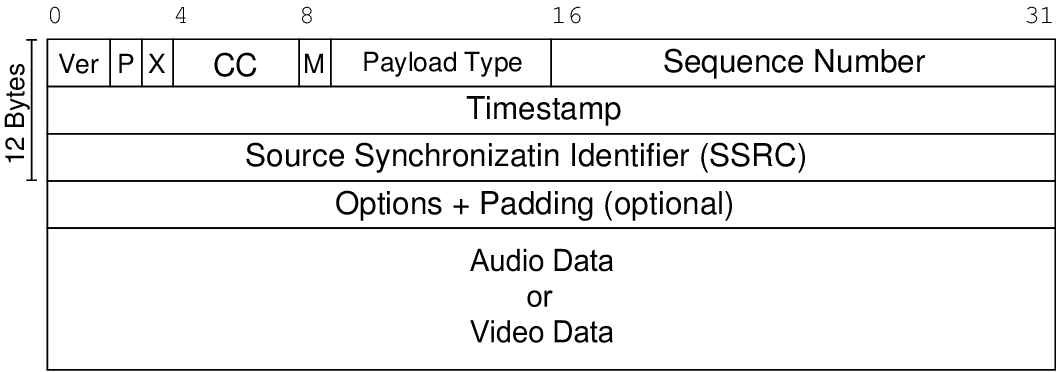

RTP(Real-time Transport Protocol)是一种网络协议,用于传输实时数据,例如音频和视频。RTP在应用层实现,通常运行在UDP上,其数据包结构包含以下几个关键部分:

- 负载类型(Payload type) :标识RTP负载内容的格式,例如G.711、G.723.1、MPEG1或MPEG2。

- 序列号 :序列号在每个RTP包中递增,用于排序以及检测丢包。

- 时间戳 :时间戳表示该RTP包数据的第一个字节的采样时间,用于同步。

- 同步源标识符(SSRC) :标识RTP流的同步源。

- 贡献源标识符(CSRC) :当一个数据流是由多个源头混合而成时,贡献源标识符用来标识所有贡献源。

|<-- 8 bits -->|<-- 8 bits -->|<-- 8 bits -->|<-- 8 bits -->|

| Payload Type | Sequence # | Timestamp | SSRC |

3.1.2 实时传输的特点

实时传输的特点主要体现在:

- 延迟 :RTP旨在尽量减少延迟,以保证实时性。

- 顺序 :RTP包可能到达接收端时乱序,需要通过序列号重排。

- 错误检测 :通过序列号,接收方可以检测丢包并做出适当处理。

- 多播/单播 :支持单播(一对一)和多播(一对多)传输。

3.2 RTCP协议的作用和机制

3.2.1 RTCP报文类型和功能

RTCP(Real-time Control Protocol)是RTP的配套协议,用于监控服务质量(QoS)并传输会话参与者信息。RTCP报文主要分为以下几种类型:

- SR(Sender Report) :发送端报告,提供发送端数据统计信息。

- RR(Receiver Report) :接收端报告,提供接收端的统计信息。

- SDES(Source Description Items) :源描述项,用于描述发送端或接收端的信息,如用户名称和邮件地址。

- BYE :结束会话,发送端或接收端离开时使用。

- APP :应用特定的RTCP包,用于定义特定应用的控制数据。

3.2.2 质量反馈和流量控制

RTCP通过周期性地发送控制信息,使得所有参与者获得会话质量的反馈。它提供了以下功能:

- 网络性能监控 :通过RTCP报文的接收统计,可以评估网络的丢包率、抖动、延迟等性能参数。

- 同步信息提供 :RTCP的SR和RR报文中包含的时钟域值可用于同步多个媒体流。

- 流量控制 :反馈机制还可以用于调整发送速率,以适应网络条件。

RTCP通过提供实时反馈,辅助RTP维护良好的传输质量,并允许动态调整传输参数以应对网络变化。

3.3 RTP与RTCP之间的关系

RTP和RTCP共同为实时数据传输提供了端到端的服务。RTP负责数据的实时传输,而RTCP则负责监控传输质量,提供控制反馈。这种分离的设计使得RTP专注于数据传输的有效性和效率,而RTCP则关注整体传输的稳定性和性能。两者配合使用,为高质量的多媒体通信提供了坚实的基础。

总结RTP和RTCP的配合使用原理,可以得出一个高层次的理解:RTP负责数据的实时传输,而RTCP通过周期性的控制报文提供反馈和控制,确保传输过程的质量和效率。这种机制使得多媒体通信能够在变化莫测的网络环境中,仍能提供可接受的用户体验。

4. RTP与UDP结合应用

4.1 UDP协议的特点和局限

用户数据报协议(UDP)是一种简单的无连接网络协议,广泛应用于需要低延迟和最小处理开销的实时数据传输。由于其轻量级的特性,UDP成为RTP(实时传输协议)传输层的首选。

4.1.1 无连接和面向报文的特性

UDP与TCP(传输控制协议)相反,它不建立连接,发送方和接收方之间不需要建立任何状态信息。这种特性使得UDP对于时间敏感的应用(如实时视频流、VoIP和在线游戏)特别有用,因为无需花费时间在连接建立上。

4.1.2 UDP在RTP中的应用

RTP通常基于UDP传输数据包。每个RTP数据包包含序列号和时间戳信息,用于同步和排序。UDP提供了一个简单快速的传输平台,而RTP则在此基础上增加实时数据传输所需的控制信息。不过,由于UDP本身不提供任何形式的可靠性保证,因此需要依赖于上层协议来解决数据包丢失、顺序错误等问题。

4.2 RTP在UDP基础上的优化策略

虽然UDP为RTP提供了良好的传输基础,但为了适应网络条件的不断变化和提高数据传输的可靠性,RTP在其基础上设计了多种优化机制。

4.2.1 丢包检测与重传机制

RTP本身不负责丢包检测和重传。这通常是上层应用或传输控制协议的任务。然而,在某些实时应用场景中,丢包重传可能影响到数据流的实时性,因此RTP允许通过应用层的协议(如RTCP)来实现这一功能。

4.2.2 序列号和时间戳的作用

序列号用于标识RTP数据包的顺序,这对于接收端重新排列接收到的数据包来说至关重要。时间戳则用于同步和声音的同步处理,允许数据包根据发送时的时间戳进行正确的时间同步。这些机制结合使用,极大地改善了数据传输的可靠性。

为了更直观地理解RTP与UDP的结合使用,我们可以参考下面的mermaid流程图来表示一个典型的RTP流如何在UDP层面上进行处理:

graph LR

A[开始] --> B{RTP数据包}

B --> C[封装进UDP数据报]

C --> D[发送至目的地]

D --> E{到达目的地}

E --> F[解析UDP数据报]

F --> G[提取RTP数据包]

G --> H[处理RTP数据]

在上述流程中,RTP数据包首先被封装进UDP数据报中,然后发送到目的地。到达目的地后,接收端会解析UDP数据报并提取RTP数据包,然后进行进一步处理。这个过程通过序列号和时间戳的使用,确保了数据的顺序性和同步性。

5. FFmpeg初始化RTP会话流程

5.1 FFmpeg网络组件的配置

5.1.1 网络接口的初始化

在使用FFmpeg库进行RTP会话的初始化之前,必须首先配置网络组件。网络接口初始化是一个重要的步骤,它涉及到准备网络传输所需的底层连接和数据包处理机制。在FFmpeg中,这通常通过AVFormatContext结构体中的network_context成员来管理。

网络接口初始化一般需要以下步骤:

- 创建AVFormatContext结构体,这是FFmpeg中用于封装输入输出流信息的结构。

- 调用

avformat_alloc_context()函数来分配一个AVFormatContext实例。 - 配置AVFormatContext的network_context字段,这涉及到设置回调函数来处理实际的网络I/O操作。

AVFormatContext* formatContext = avformat_alloc_context();

if (!formatContext) {

// 错误处理:内存分配失败

}

// 初始化网络组件

if (avformat_network_init() < 0) {

// 错误处理:网络初始化失败

}

在初始化网络组件时,FFmpeg会根据AVIOContext的读写函数,设置用于数据包接收和发送的回调函数,以便能够处理网络I/O操作。

5.1.2 连接参数的设置

一旦网络接口初始化完成,接下来就需要设置连接参数,这些参数包括目标RTP服务器的地址、端口以及其他相关配置。这一步骤是在创建RTP会话之前,确保FFmpeg可以正确地与服务器建立连接的关键。

在设置连接参数时,通常需要如下几个步骤:

- 创建一个指向AVFormatContext结构体的指针。

- 使用

av_dict_set()函数设置AVFormatContext结构体中的格式选项字典,如服务器地址、端口号、用户名和密码等。

// 设置目标服务器地址和端口

char* server_ip = "192.168.1.100";

char* server_port = "5004";

AVDictionary* options = NULL;

av_dict_set(&options, "rtsp_transport", "udp", 0); // 以UDP模式传输

av_dict_set(&options, "server", server_ip, 0);

av_dict_set(&options, "localport", server_port, 0);

// 使用设置的参数打开输入流

if (avformat_open_input(&formatContext, "rtsp://username:password@192.168.1.100:5004/stream", NULL, &options) < 0) {

// 错误处理:打开输入流失败

}

// 清理设置的选项字典

av_dict_free(&options);

在这段示例代码中,我们通过 av_dict_set() 函数指定了连接服务器时的地址、端口以及传输模式。请注意,在实际使用中,需要根据实际情况替换IP地址、端口号以及可能的认证信息。

5.2 RTP会话建立和管理

5.2.1 SDP协商过程

在建立RTP会话时,会涉及到会话描述协议(Session Description Protocol, SDP)的协商。SDP是用于描述多媒体会话的协议,它在初始化RTP会话时用于交换媒体传输参数。这包括但不限于音频和视频编解码器类型、采样率、采样大小、通道数、网络地址和端口号等。

SDP协商过程一般包括以下几个步骤:

- 创建一个AVFormatContext实例,并设置网络接口。

- 打开并读取输入流,这会触发FFmpeg与服务器进行SDP协商。

- 分析SDP信息,提取RTP会话所需的关键信息。

- 根据协商的结果,完成会话参数的设置。

// 打开并读取输入流

if (avformat_find_stream_info(formatContext, NULL) < 0) {

// 错误处理:无法找到流信息

}

// 获取第一个视频流索引

int videoStreamIndex = av_find_best_stream(formatContext, AVMEDIA_TYPE_VIDEO, -1, -1, NULL, 0);

if (videoStreamIndex < 0) {

// 错误处理:未找到视频流

}

// 打印一些会话信息,实际开发中应使用这些信息进行会话配置

AVFormatContext* context = formatContext; // 强制类型转换

for (unsigned int i = 0; i < context->nb_streams; i++) {

AVStream* stream = context->streams[i];

AVCodecParameters* codecParameters = stream->codecpar;

// 打印流信息,如编解码器类型、采样率等

}

在这段代码中,我们首先打开输入流并读取流信息,这会触发与服务器的SDP协商。然后,我们获取第一个视频流的索引,并遍历所有流来打印出相关信息。这些信息对于配置和管理RTP会话至关重要。

5.2.2 会话状态跟踪和维护

一旦成功建立RTP会话,FFmpeg会自动处理许多底层的网络和会话管理细节,如数据包的发送和接收。然而,在应用层,开发人员需要跟踪和维护会话的状态,确保RTP流的稳定传输和接收。

会话状态跟踪和维护包含以下几个方面:

- 定期检查流是否正在接收。

- 处理数据包的接收顺序和丢包情况。

- 优化和调整网络参数以应对网络状况的变化。

// 主循环中检查流的接收状态

AVPacket packet;

int ret;

while (av_read_frame(formatContext, &packet) >= 0) {

// 处理接收到的RTP数据包

// ...

av_packet_unref(&packet); // 释放数据包资源

}

if (ret == AVERROR_EOF) {

// 文件结束或网络流断开

} else if (ret < 0) {

// 读取数据包失败处理

}

在这段代码的主循环中, av_read_frame() 函数负责持续接收数据包。如果返回值为AVERROR_EOF,则表示文件结束或者网络流断开。其他负返回值通常表示读取数据包的错误,需要适当处理。

会话的维护通常涉及到调整缓冲区大小、处理网络抖动以及确保时间戳同步等。对于需要长期运行的应用程序,还应考虑到网络连接的恢复机制,以及在连接丢失时的重连策略。这些高级功能可能需要开发人员深入分析FFmpeg库的使用文档,并根据应用场景的具体需求进行定制开发。

6. FFmpeg解码视频流操作步骤

在本章中,我们将详细探讨如何使用FFmpeg库来解码实时传输视频流。我们将从输入流的捕获与解析开始,逐步深入到视频帧的解码处理以及色彩空间转换等关键步骤。以下内容将涵盖具体的操作步骤、代码解析、以及优化策略,以确保读者能够深入理解并实际应用这些知识。

6.1 输入流的捕获和解析

6.1.1 输入缓冲区的管理

视频流的捕获和解析首先涉及输入缓冲区的管理。输入缓冲区是处理数据流前的第一道屏障,它负责接收和暂存来自网络或文件的原始数据包。

参数说明

在进行输入缓冲区管理时,需要考虑的关键参数包括缓冲区大小、预分配的内存块数量等。这些参数可以根据视频数据包的大小、网络传输的稳定性和延迟等因素动态调整。

代码块示例与分析

// 创建输入缓冲区

AVIOContext *avio_ctx;

uint8_t *buffer;

int buffer_size = 1024 * 1024; // 假定缓冲区大小为1MB

buffer = av_malloc(buffer_size);

if (!buffer) {

// 处理内存分配失败

}

// 初始化AVIO上下文

avio_ctx = avio_alloc_context(buffer, buffer_size, 0, NULL, NULL, &read_packet, NULL);

// 设置AVFormatContext的pb成员以使用avio上下文

format_ctx->pb = avio_ctx;

// 读取数据包函数

int read_packet(void *opaque, uint8_t *buf, int buf_size) {

// 实现读取逻辑,例如从网络或文件读取数据

// 返回实际读取的字节数,或AVERROR_xxx错误代码

}

// 使用完毕后释放输入缓冲区

av_free(buffer);

avio_context_free(&avio_ctx);

上述代码展示了如何创建一个输入缓冲区,并通过 avio_alloc_context 函数将其与读取函数 read_packet 关联,该函数将被用作从输入源获取数据包。这些数据包后续将被解析为视频帧。

6.1.2 RTP数据包的解析过程

RTP数据包的解析是实时视频流处理的重要步骤。RTP (Real-time Transport Protocol) 数据包包含了音视频流的压缩数据,FFmpeg需要对其进行解析,才能进行后续的解码工作。

代码块示例与分析

// 创建RTP数据包

AVPacket *pkt = av_packet_alloc();

// 解析RTP数据包

// 这通常涉及读取输入缓冲区中的数据,并将其填入AVPacket结构

int read_rtp_packet(AVPacket *pkt, AVIOContext *avio_ctx) {

return av_read_frame(avio_ctx, pkt); // 使用libavformat提供的读取函数

}

// 释放AVPacket

av_packet_free(&pkt);

av_read_frame 函数通过指定的 AVIOContext 从输入源中读取数据包并填充到 AVPacket 结构中。解析后的RTP数据包随后会被送入解码流程。

6.2 视频帧的解码处理

6.2.1 解码器的选择和配置

解码器是解码视频流的关键组件。在FFmpeg中,解码器的选择需要根据视频编码格式来决定。在选择和配置解码器时,还需要考虑是否使用硬件加速以提高性能。

表格展示解码器特性

以下是几种常见的视频解码器及其主要特性:

| 解码器名称 | 编解码格式 | 硬件支持 | 性能 | 说明 | |-------------|------------|----------|------|------| | h264_qsv | H.264 | 是 | 高 | Intel QSV硬件加速支持 | | h264_v4l2m2m| H.264 | 是 | 中等 | V4L2多媒体接口支持 | | h264 | H.264 | 否 | 中等 | 软件解码 | | hevc_qsv | HEVC | 是 | 高 | Intel QSV硬件加速支持 | | hevc_v4l2m2m | HEVC | 是 | 中等 | V4L2多媒体接口支持 | | hevc | HEVC | 否 | 中等 | 软件解码 |

在选择解码器时,需要根据实际的硬件环境、性能需求及编解码格式来决定,上表提供了一个决策参考。

6.2.2 硬件加速与软件解码的抉择

在许多情况下,硬件加速可以显著提高解码性能。然而,根据应用场景的不同,软件解码仍有其独特的地位。选择硬件加速还是软件解码,需要根据性能需求和硬件资源情况来决定。

代码块示例与逻辑分析

AVCodec *codec;

AVCodecContext *codec_ctx;

// 查找解码器

codec = avcodec_find_decoder(AV_CODEC_ID_H264);

if (!codec) {

// 错误处理:未找到解码器

}

// 创建解码器上下文

codec_ctx = avcodec_alloc_context3(codec);

if (!codec_ctx) {

// 错误处理:内存分配失败

}

// 打开解码器

if (avcodec_open2(codec_ctx, codec, NULL) < 0) {

// 错误处理:无法打开解码器

}

// 使用解码器

// 这里可以进行解码操作,例如使用avcodec_send_packet和avcodec_receive_frame

// 关闭解码器并释放资源

avcodec_close(codec_ctx);

avcodec_free_context(&codec_ctx);

在上述代码中,我们首先查找适合H.264编码格式的解码器,然后创建解码器上下文,并打开解码器。在使用解码器进行实际的解码操作之后,我们需要关闭解码器并释放相关资源。选择硬件加速时,可以使用特定硬件支持的解码器,如 h264_qsv 。

6.2.3 解码操作的执行

解码操作是将压缩的数据包转换成视频帧的过程。这个过程通常涉及到发送包含编码数据的AVPacket给解码器,并从解码器接收解码后的AVFrame。

代码块示例与参数说明

// 将RTP数据包发送给解码器

if (avcodec_send_packet(codec_ctx, pkt) < 0) {

// 错误处理:发送包失败

}

// 从解码器接收解码后的帧

if (avcodec_receive_frame(codec_ctx, frame) < 0) {

// 错误处理:接收帧失败

}

在上述过程中的每一个步骤,都需要仔细的错误检查和处理,以确保解码过程的稳定和数据的正确性。解码得到的AVFrame包含了图像数据,可以用于进一步的处理或显示。

6.2.4 解码器性能优化

针对不同应用场景,解码器的性能优化策略也不同。常见的优化方法包括异步解码、多线程解码、选择合适的内存访问模式等。

代码块示例与逻辑分析

// 设置解码器上下文参数,例如使用多线程解码

codec_ctx->thread_count = 4; // 使用4个线程进行解码

// 启动异步解码模式

codec_ctx->active_thread_type = FF_THREAD_FRAME;

// 重新打开解码器以应用设置

if (avcodec_open2(codec_ctx, codec, NULL) < 0) {

// 错误处理:无法打开解码器

}

// 使用优化后的参数执行解码操作

在上述代码示例中,我们设置了使用多线程解码,并且启用了异步解码模式。这些优化可以显著提高解码性能,特别是在多核处理器上运行时。

在进行优化时,还需要考虑硬件资源限制、解码器特性以及实际应用场景。例如,在低功耗设备上,过多的线程可能会导致功耗过高,并影响解码性能。

在实际的视频流处理中,解码视频流操作步骤是一个不断迭代和优化的过程。合理的捕获和解析输入流,恰当的解码器选择与配置,以及持续的性能优化,都是达到高质量视频流解码的关键。

通过本章的介绍,读者应已对FFmpeg解码视频流的操作步骤有了全面的认识,并能基于这些知识构建起高效的视频处理系统。

7. 视频帧色彩空间转换与显示

在数字视频处理中,色彩空间转换是将视频帧从一种色彩格式转换为另一种色彩格式的过程,以便于在不同的显示设备和应用中获得最佳的显示效果。本章将深入探讨视频帧色彩空间转换的原理,介绍FFmpeg在视频帧显示方面所采用的技术,并讨论在处理RTP视频流时可能出现的错误处理和资源释放策略。

7.1 视频帧色彩空间转换原理

色彩空间转换是数字视频处理中的一项基本技术。不同的显示设备和视频编码标准常常使用不同的色彩格式。了解这些色彩格式并能够高效转换它们是实现高质量视频显示的基础。

7.1.1 常见色彩空间格式

- YUV色彩空间 : YUV是一种常用于视频信号的色彩表示方法。它将亮度信息(Y)与色度信息(UV)分开,允许降低带宽需求而不影响视频质量。

- RGB色彩空间 : RGB色彩空间代表红绿蓝三种基色,广泛应用于计算机显示器和图像处理。

- HSL/HSV色彩空间 : 这些色彩空间基于人类对色彩的感知,使得颜色调节和转换更为直观。

7.1.2 转换方法和算法

色彩空间转换可以通过线性或非线性方法来实现。线性转换通常涉及到矩阵乘法和向量转换。例如,YUV到RGB的转换可以通过以下公式实现:

R = Y + 1.140V

G = Y - 0.395U - 0.581V

B = Y + 2.032U

在FFmpeg中,色彩空间转换可以通过滤镜实现,例如使用 transpose 滤镜进行视频帧的旋转和色彩空间的转换。

7.2 FFmpeg视频帧的显示技术

FFmpeg提供了丰富的工具和接口,用于视频帧的捕获、处理和显示。在视频显示方面,图像渲染技术和显示接口的选择至关重要。

7.2.1 图像渲染技术

图像渲染通常涉及像素数据的处理和图像质量的优化。FFmpeg使用SDL(Simple DirectMedia Layer)库来处理图像的渲染和显示。

渲染视频帧的代码示例可能如下:

AVFrame *frame;

AVCodecContext *codec_context;

// 初始化SDL库和其他组件

SDL_Init(SDL_INIT_VIDEO | SDL_INIT_AUDIO | SDL_INIT_TIMER);

SDL_Window *window = SDL_CreateWindow(

"FFmpeg Video Player",

SDL_WINDOWPOS_UNDEFINED, SDL_WINDOWPOS_UNDEFINED,

codec_context->width, codec_context->height,

0

);

SDL_Renderer *renderer = SDL_CreateRenderer(window, -1, 0);

SDL_Texture *texture = SDL_CreateTexture(

renderer,

SDL_PIXELFORMAT_YV12,

SDL_TEXTUREACCESS_STREAMING,

codec_context->width,

codec_context->height

);

// ... 在解码循环中填充帧数据 ...

// 将解码后的帧数据发送到SDL

SDL_UpdateYUVTexture(

texture,

NULL,

frame->data[0], frame->linesize[0],

frame->data[1], frame->linesize[1],

frame->data[2], frame->linesize[2]

);

SDL_RenderClear(renderer);

SDL_RenderCopy(renderer, texture, NULL, NULL);

SDL_RenderPresent(renderer);

// 清理资源

SDL_DestroyTexture(texture);

SDL_DestroyRenderer(renderer);

SDL_DestroyWindow(window);

7.2.2 显示接口和方法选择

FFmpeg支持多种显示方法,包括但不限于X11、Direct3D、Vulkan等。选择合适的显示接口对于实现高效和高质量的视频显示至关重要。

在实际应用中,开发者可以根据目标平台的特性和性能需求来选择显示接口。

7.3 RTP流错误处理与资源释放

在实时传输过程中,不可避免地会遇到错误和异常情况。有效的错误处理机制和资源释放流程是确保系统稳定运行和及时恢复的关键。

7.3.1 错误检测和恢复机制

错误检测可以在不同层面上实现,包括RTP层、网络层和解码层。例如,RTP层可以通过RTCP报告进行丢包检测和反馈,而网络层可以通过TCP/IP协议栈提供的机制进行错误检测。

恢复机制可能包括错误隐藏、错误补偿、甚至重启RTP会话等。

7.3.2 资源清理和释放流程

资源的及时清理和释放可以避免内存泄漏和其他资源消耗问题。在FFmpeg中,通常需要在视频流结束或应用关闭时执行以下操作:

// 清理解码器上下文

avcodec_free_context(&codec_context);

// 清理图像和音频帧

av_frame_free(&frame);

// 清理音频转换器上下文

av_audio_convert_free(convert_ctx);

// 清理FFmpeg网络组件

avformat_network_deinit();

同时,确保关闭所有打开的文件描述符和SDL渲染器资源。

通过本章的讨论,我们深入了解了视频帧色彩空间转换的原理、FFmpeg的视频显示技术以及RTP流的错误处理和资源释放方法。这些内容对于任何希望构建高质量视频流处理和显示系统的开发者来说都是至关重要的。

简介:本文深入介绍了网络视频流实时传输的关键技术和FFmpeg多媒体处理框架的使用。RTP协议作为实时数据传输的标准协议,配合FFmpeg,为音视频的实时传输提供了高效解决方案。文章详细阐述了使用FFmpeg接收RTP视频流并进行解码显示的步骤,包括初始化RTP会话、连接RTP流、视频流解码、视频帧显示以及错误处理等。同时,对一个Android应用包"RemoteCamera_10190.apk"的分析提供了一个实际应用案例,说明了如何在Android设备上实现远程视频监控。

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?