简介:在自然语言处理中,分词是处理文本数据的关键步骤。本项目使用Java语言开发了一个简单的英文分词程序,旨在统计文本中单词的出现频率,帮助用户深入理解文本数据。程序可能使用基本的空格分词方法或借助高级分词库来处理复杂情况,如连字符或专有名词。统计词频时,会使用数据结构如HashMap来存储和排序单词及其频率,并利用JFreeChart库将统计结果可视化为图表。此外,程序可能引入了优化措施,如使用Trie数据结构和布隆过滤器,以提高处理效率和准确性。这个项目为学习Java编程、NLP和数据可视化提供了实用案例,强调了数据可视化在传达分析结果中的重要性。

1. 英文分词概念与实现

在自然语言处理(NLP)领域,英文分词(Tokenization)是一个基础而关键的步骤,它的目的是将连续的文本分割为具有明确意义的最小单位,即“词”或“标记”(token)。英文分词的重要性在于它能够为后续的文本分析和理解奠定基础,为词性标注、命名实体识别等任务提供支撑。

英文分词的定义和重要性

英文分词本质上是对文本进行切分,将句子、段落或文档等文本数据分解为单个词汇单元,以便于计算机处理和分析。分词的质量直接影响到后续处理的准确性和效率。

常见的英文分词方法

分词方法主要有以下几类:

基于规则的分词

这种分词方法依赖于一组预设的语法规则,例如空格分隔、标点符号处理等。它简单、直接,但缺乏灵活性,对于语言的多样性和复杂性适应性较差。

基于统计的分词

该方法依据统计模型进行分词,常见的算法包括隐马尔可夫模型(HMM)和条件随机场(CRF)。这类方法通常需要大量的训练数据以学习词汇边界和上下文信息,从而实现更加准确的分词。

基于深度学习的分词

利用神经网络模型如长短期记忆网络(LSTM)或Transformer结构进行分词,这类方法能够捕捉长距离依赖关系,分词效果较传统方法有显著提升,但需要强大的计算资源和大量训练数据。

分词实现的代码示例

以下将展示如何实现一个简单的英文分词器,并介绍如何使用现有的开源分词工具。

实现简单分词器

使用Python语言进行简单的分词处理示例如下:

# 简单分词器示例

import re

def simple_tokenizer(text):

# 使用正则表达式来分隔单词

return re.findall(r'\b\w+\b', text.lower())

sentence = "This is a simple tokenizer example."

tokens = simple_tokenizer(sentence)

print(tokens)

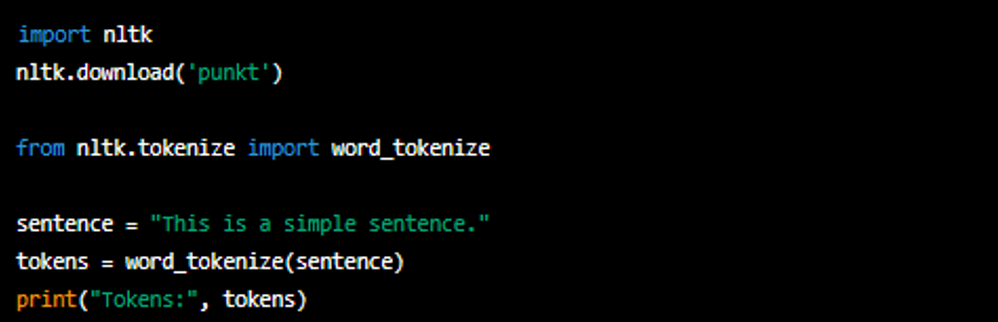

利用开源分词工具

有许多成熟的分词工具可供使用,例如NLTK(Natural Language Toolkit):

import nltk

from nltk.tokenize import word_tokenize

nltk.download('punkt')

sentence = "This is a NLTK tokenizer example."

tokens = word_tokenize(sentence)

print(tokens)

在选择和实现分词方法时,需要根据具体的应用场景和需求来决定。对于大多数NLP任务而言,使用成熟的开源分词工具是一个高效且可靠的选择。

2. 词频统计方法与应用

2.1 词频统计的原理

2.1.1 统计模型的基本构成

在处理自然语言文本时,词频统计作为基本的分析手段,其核心在于理解统计模型的基本构成。任何统计模型都可以抽象为以下三个部分:

- 数据源 :这是词频统计模型的输入,可以是任何文本数据,如书籍、文章、网页等。

- 处理单元 :这是统计模型的加工环节,包含分词、标注词性、消除停用词等步骤。

- 统计器 :负责记录和计算词频的模块,统计器通常需要处理数据结构以高效存储和检索词频信息。

这些部分共同作用,将文本数据转化为有序的词频信息,为进一步的文本分析提供支持。

2.1.2 词频的计算方法

词频,顾名思义,是指特定词在文本中出现的次数。计算词频的常见方法包括:

- 简单计数法 :遍历文本,每当遇到一个词,就对这个词的计数加一。

- 条件计数法 :在计数的基础上增加条件限制,如仅计算某个词性(名词、动词等)的词频。

- 加权计数法 :对词频进行加权,给予某些词更高的权重,例如在情感分析中,一些具有强烈感情色彩的词汇会被赋予更高的权重。

2.2 词频统计在文本分析中的应用

2.2.1 文本摘要生成

文本摘要的生成依赖于高频词汇的统计。基本步骤包括:

- 通过词频统计确定文本中的关键词和短语。

- 根据词频构建重要度评分。

- 选择评分最高的若干词语和短语组合成摘要。

这一方法简单直接,对于新闻、报告等结构化的文本尤为有效。

2.2.2 情感分析和主题识别

情感分析和主题识别均需对文本中词语的情感倾向和主题相关性进行量化。词频统计可以:

- 分析特定主题或情感表达的词频分布。

- 借助n-gram模型和TF-IDF权重计算来增强模型对语义的识别能力。

- 在监督学习的框架下,利用词频信息训练机器学习模型以进行更准确的情感判断和主题分类。

2.3 高级词频统计技术

2.3.1 n-gram模型

n-gram模型是文本处理中一种基于统计的语言模型,其基本思想是将文本分割为长度为n的连续字串(n-gram)。

- 无监督学习 :不需要人工标注的语料库,可以自动从大量文本中学习到语言的模式。

- 应用 :在搜索引擎、语音识别、机器翻译等领域都有广泛应用。

2.3.2 TF-IDF权重计算

TF-IDF(Term Frequency-Inverse Document Frequency)是一种用于信息检索与文本挖掘的常用加权技术。

- Term Frequency (TF) :表示词条在文档中出现的频率。

- Inverse Document Frequency (IDF) :衡量一个词的普遍重要性。如果一个词在一篇文章中出现频率高,但在其他文章中很少出现,则认为这个词具有很好的类别区分能力。

综合TF-IDF分数可以帮助我们识别出哪些词对文档的重要性更高,从而更好地用于文本分类、检索等任务。

下一章节将深入探讨Java语言在文本处理中的应用,从基础操作到优化策略,将为读者提供丰富的实战技巧和处理大型文本数据的方法。

3. Java语言在文本处理中的应用

在信息技术领域,文本处理是一项基础且重要的工作。Java作为一种功能强大的编程语言,提供了丰富的API和第三方库,使得文本处理任务变得更加简单高效。本章节将探讨Java在文本处理中的应用,从基础概念到实战技巧,再到处理大型文本数据的策略。

3.1 Java文本处理基础

Java提供了强大的字符串处理功能,包括但不限于拼接、替换、比较、分割和搜索字符串。同时,正则表达式作为文本处理的灵魂,它能够通过简单而强大的模式描述语言,处理复杂的文本匹配和抽取任务。

3.1.1 Java中的字符串和字符处理

在Java中,字符串是由不可变字符数组构成的。每个字符串实例都有许多用于处理字符串内容的方法,例如 length() , charAt() , substring() , concat() , replace() 等。这些方法极大地简化了字符串的处理过程。例如,以下代码展示了如何使用Java API来检查字符串是否以特定的子串结尾:

public static void main(String[] args) {

String text = "The quick brown fox jumps over the lazy dog";

String ending = "dog";

if (text.endsWith(ending)) {

System.out.println("The string ends with: " + ending);

}

}

3.1.2 正则表达式在文本处理中的应用

正则表达式是文本处理的强大工具,用于执行模式匹配和文本验证。Java的 java.util.regex 包提供了编译和执行正则表达式操作的类。下面的示例使用正则表达式查找字符串中所有的单词,并将它们转为大写输出:

import java.util.regex.Matcher;

import java.util.regex.Pattern;

public class RegexExample {

public static void main(String[] args) {

String text = "Hello world, welcome to Java regex!";

Pattern pattern = Pattern.compile("\\b[a-zA-Z]+\\b");

Matcher matcher = pattern.matcher(text);

while(matcher.find()) {

System.out.println(matcher.group().toUpperCase());

}

}

}

在这个例子中,正则表达式 \\b[a-zA-Z]+\\b 用于匹配由字母组成的一个或多个单词。

3.2 Java文本处理实战技巧

在实际应用中,文本处理往往涉及文件的读写,以及更复杂的文本操作。Java NIO(New Input/Output)是一个用于替代标准Java I/O API的库,它支持面向缓冲区的(Buffer-oriented)、基于通道的(Channel-based)I/O操作。

3.2.1 文本文件的读写操作

读写文本文件是日常开发中的常见需求。Java提供了简单易用的API来处理文件读写。以下是一个简单的文本文件读取示例:

import java.io.BufferedReader;

import java.io.FileReader;

import java.io.IOException;

public class ReadFileExample {

public static void main(String[] args) {

File file = new File("example.txt");

try (BufferedReader br = new BufferedReader(new FileReader(file))) {

String line;

while ((line = br.readLine()) != null) {

System.out.println(line);

}

} catch (IOException e) {

e.printStackTrace();

}

}

}

3.2.2 Java NIO在文本处理中的应用

Java NIO提供了不同的方式来处理数据,特别是当涉及到大量数据时。NIO中的Buffer、Channel和Selector组件协同工作,提供了一个高效的方式来读写数据。例如,使用NIO来处理大型文本文件,可以更好地控制内存使用和提高性能:

import java.io.IOException;

import java.nio.ByteBuffer;

import java.nio.channels.FileChannel;

import java.nio.file.Files;

import java.nio.file.Paths;

import java.nio.file.StandardOpenOption;

public class NIOFileExample {

public static void main(String[] args) {

try (FileChannel fileChannel = (FileChannel) Files.newByteChannel(

Paths.get("largefile.txt"), StandardOpenOption.READ)) {

ByteBuffer buffer = ByteBuffer.allocateDirect(1024);

while (fileChannel.read(buffer) > 0) {

buffer.flip();

while (buffer.hasRemaining()) {

System.out.print((char) buffer.get());

}

buffer.clear();

}

} catch (IOException e) {

e.printStackTrace();

}

}

}

3.3 Java处理大型文本数据

随着数据量的增加,文本处理方式也需要相应地进行调整。对于大型文本数据集,传统的方法可能无法高效处理,这时就需要采用一些策略来提升性能。

3.3.1 大数据环境下的文本处理策略

在处理大数据量的文本时,常见的策略包括:

- 流式处理:逐行或按块读取文件,而不是一次性加载整个文件到内存。

- 并行处理:利用多核处理器来分割任务,例如通过线程或并行流处理。

- 内存优化:选择合适的数据结构来减少内存使用。

3.3.2 使用Apache Commons Text等库提高处理效率

为了提高处理效率,可以采用开源库来辅助文本处理。Apache Commons Text库提供了很多针对字符串操作的扩展功能,例如 StringUtils 类提供了多种与字符串操作有关的静态方法。

import org.apache.commons.text.StringEscapeUtils;

public class CommonsTextExample {

public static void main(String[] args) {

String json = "{ \"name\": \"John\", \"age\": 30 }";

String unescapedJson = StringEscapeUtils.unescapeJson(json);

System.out.println(unescapedJson);

}

}

在上述代码中, StringEscapeUtils.unescapeJson 用于将转义的JSON字符串转换为可读的格式。

通过本章节的介绍,读者应能掌握Java在文本处理中的基础应用,以及实战技巧和处理大型数据的策略。接下来的章节将深入探讨数据可视化和算法优化措施,以进一步提升文本分析的效果和效率。

4. JFreeChart库的数据可视化

4.1 JFreeChart库概述

4.1.1 JFreeChart的安装和配置

JFreeChart 是一个开源的 Java 图形库,它用于创建各种图表,并且可以轻松地嵌入到各种 Java 应用程序中,特别是用于生成动态生成的数据图表,以及在 Web 应用程序中的使用。在详细介绍 JFreeChart 的应用之前,我们需要先了解如何安装和配置 JFreeChart 库。

- 安装 JFreeChart

安装 JFreeChart 通常意味着将其依赖的 jar 文件添加到项目的类路径中。对于使用 Maven 的项目,可以在项目的 pom.xml 文件中添加以下依赖:

xml <dependency> <groupId>org.jfree</groupId> <artifactId>jfreechart</artifactId> <version>1.5.3</version> <!-- Use the latest version --> </dependency>

如果是使用 Ant 或 Gradle 等其他构建工具,可以类似地添加相应的依赖项。

- 配置 JFreeChart

配置 JFreeChart 涉及到设置图表的标题、X轴标签、Y轴标签、图表颜色主题以及显示的数据集等。JFreeChart 的核心是 ChartFactory 类,它提供了一系列静态方法来创建不同类型的图表,比如折线图、柱状图、饼图等。

例如,创建一个简单的柱状图:

```java JFreeChart chart = ChartFactory.createBarChart( "Sample Bar Chart", // Chart title "Category", // Domain axis label "Value", // Range axis label dataset, // Data PlotOrientation.VERTICAL, // Plot orientation true, // Include legend true, // Tooltips false // URLs );

ChartPanel chartPanel = new ChartPanel(chart); // Add chartPanel to your JFrame or JDialog ```

上面的代码创建了一个垂直方向的柱状图,并将数据集 dataset 传入。 true 和 false 参数指定了是否包含图例、工具提示和 URL 链接。

4.1.2 JFreeChart的基本图形绘制

JFreeChart 提供了多种基本图形的绘制方法。开发者可以根据实际需求选择合适的图表类型。以下是一些常用的图表类型及其应用场景:

- 折线图 (Line Chart) : 用于展示数据随时间变化的趋势。

- 柱状图 (Bar Chart) : 展示不同类别的数据大小,便于比较。

- 饼图 (Pie Chart) : 用于展示各部分占总体的比例。

- 散点图 (Scatter Plot) : 用于研究两个变量之间的关系。

- 面积图 (Area Chart) : 强调趋势和数量之间的关系。

下面是一个使用 JFreeChart 创建折线图的示例代码:

XYDataset dataset = new XYSeriesCollection(series);

JFreeChart chart = ChartFactory.createLineChart(

"Sample Line Chart", // Chart title

"X-Axis Label", // X-axis label

"Y-Axis Label", // Y-axis label

dataset, // Dataset

PlotOrientation.VERTICAL, // Plot orientation

true, // Legend

true, // Tooltips

false // URLs

);

// Customize chart appearance

XYPlot plot = (XYPlot) chart.getPlot();

// Customize the plot further, like setting colors or adding background images

// Display the chart using a ChartPanel in your GUI application

在使用 JFreeChart 绘制任何图表时,首先需要创建一个适合该图表类型的数据集对象,例如 XYSeriesCollection 对于折线图和柱状图。然后,使用 ChartFactory 类的方法创建图表实例,并且可以进一步定制图表样式,例如颜色、图例位置以及背景样式等。

4.2 JFreeChart在文本分析中的应用

4.2.1 绘制词频统计图表

JFreeChart 是文本分析中数据可视化的强大工具,特别是在词频统计分析中。通过词频统计,我们可以获得文本数据中不同词语的出现频率,从而了解文本内容的重点。接下来,我们将使用 JFreeChart 来绘制一个词频统计的柱状图。

假设我们已经有了一个词频统计的 Map<String, Integer> 数据结构,我们可以将其转换为一个适合 JFreeChart 使用的 CategoryDataset 对象。下面是一个简化的代码示例:

// 假设 Map<String, Integer> wordCounts 已经包含词频统计结果

CategoryDataset dataset = DatasetUtilities.createCategoryDataset(

"Words", // Row key

wordCounts // Map with word frequencies

);

JFreeChart chart = ChartFactory.createBarChart(

"Word Frequency", // Chart title

"Word", // Category axis label

"Frequency", // Value axis label

dataset, // Dataset

PlotOrientation.VERTICAL, // Plot orientation

true, // Include legend

true, // Tooltips

false // URLs

);

// Customize the chart as needed

// ...

// Display the chart

ChartPanel chartPanel = new ChartPanel(chart);

// Add chartPanel to your GUI application for display

在上述代码中,我们创建了一个 CategoryDataset 对象,它包含了 wordCounts 中的数据,并将这个数据集传递给 ChartFactory.createBarChart() 方法来生成柱状图。之后,我们可以通过 JFreeChart 提供的 API 对图表的样式和外观进行调整。

4.2.2 制作动态更新的图表

在文本分析过程中,有时候我们希望能够动态地展示数据变化,比如实时词频统计或者随时间变化的情感分析。JFreeChart 也支持动态更新图表,使得数据可视化更为灵活。

假设我们有一个实时更新词频统计的应用场景,我们可以创建一个 TimeSeriesCollection 数据集,并在每次更新词频统计时,向这个数据集中添加新的数据点。

TimeSeriesCollection dataset = new TimeSeriesCollection();

TimeSeries series = new TimeSeries("Word Frequency");

// 假设每次更新时,我们得到新的词语和对应的频率

String word = ...;

double frequency = ...;

dataset.addSeries(series);

series.add(new Day(), new Double(frequency)); // 假设时间单位是天

在这个例子中,我们首先创建了一个 TimeSeriesCollection 实例,然后为每个新的词语创建一个 TimeSeries 对象。每当新的频率数据被计算出来后,我们更新 TimeSeries 对象,并刷新图表。JFreeChart 支持监听数据集的变化,从而实现图表的动态更新。

4.3 高级数据可视化技巧

4.3.1 自定义图表样式和颜色

JFreeChart 不仅提供基本图表的创建,还支持高度自定义的图表样式和颜色。通过调整图表的各种视觉属性,我们可以使得图表更加美观和易于理解。

使用 ChartFactory 创建的图表默认使用一些基本的主题样式,例如颜色、字体和图例样式。如果我们想要修改这些默认设置,可以通过图表的 getPlot() 方法来访问底层的绘图对象,并对其进行设置。

以下是一个自定义图表样式的简单例子:

// 创建图表

JFreeChart chart = ChartFactory.createBarChart(...);

// 自定义颜色主题

Paint red = new Color(200, 0, 0, 200); // 半透明红色

chart.setBackgroundPaint(red);

// 获取并自定义具体图表元素,如柱状图的笔触和填充颜色

XYPlot plot = (XYPlot) chart.getPlot();

XYItemRenderer renderer = plot.getRenderer();

renderer.setSeriesPaint(0, red);

上述代码将背景颜色修改为半透明红色,并将柱状图中的第一个数据集的颜色设置为同样的红色。这样可以使得图表更加突出和吸引人。

4.3.2 结合Web应用展示数据图表

在 Web 应用中展示数据图表时,JFreeChart 可以与流行的 Web 框架如 Spring MVC、JSF 或者其他框架结合使用。通常的步骤包括将 JFreeChart 生成的图表渲染成图片文件,然后将其嵌入到 Web 页面中。

假设我们要在 Spring MVC 应用中展示一个图表,可以使用以下步骤:

-

在 Controller 中生成图表 : ```java @RequestMapping(value="/chart", method=RequestMethod.GET) public void showChart(HttpServletResponse response) throws IOException { // ...生成图表的代码

// 将图表渲染到一个输出流中 OutputStream out = response.getOutputStream(); JFreeChart chart = ...; // 创建和配置图表 ChartUtils.writeChartAsPNG(out, chart, 800, 600); } ```

-

在 JSP 页面中显示图表 :

html <img src="chart" alt="图表" />

当用户访问对应的 URL /chart 时,图表会被动态生成,并作为一个 PNG 图片发送到客户端浏览器上展示。

在这个过程中,还可以添加更多的配置项,比如图片缓存、图表边框、标题字体样式等,以优化用户体验和页面性能。使用 Spring 的缓存支持,例如 @Cacheable ,可以缓存图表生成结果,提高应用的响应速度,特别是当同一个图表需要被频繁访问时。

5. 数据结构在优化文本分析中的使用

在文本分析领域,数据结构的选择对于性能有着深远的影响。恰当的数据结构不仅可以使代码更加高效,还可以提升分析的准确度和速度。本章节将深入探讨在文本分析中常用的几种数据结构,并通过实际案例来分析它们是如何优化性能的。

5.1 文本分析中常用的数据结构

文本分析是计算机处理自然语言的一种手段,而在这一过程中,数据结构是存储和处理文本数据的基础。以下两个数据结构在文本分析中尤为关键。

5.1.1 字典树(Trie)结构

字典树,又称为前缀树或Trie树,是一种用于快速检索字符串集合中字符串的树形数据结构。它能高效地实现对大量字符串的快速查找、插入和删除操作。

Trie树的实现原理

一个Trie树通常包含以下节点:

- 根节点:表示空字符串,不包含任何字符。

- 内部节点:表示Trie树中一个字符的前缀。

- 叶节点:表示一个完整的字符串。

每个节点包含一个哈希表或数组,以字母为索引,存储指向下一个节点的引用。以下是Trie树的简单实现:

class TrieNode {

TrieNode[] children;

boolean isEndOfWord;

char data;

public TrieNode(char data) {

this.data = data;

children = new TrieNode[26]; // 假设只有26个英文字母

isEndOfWord = false;

}

}

class Trie {

private TrieNode root;

public Trie() {

root = new TrieNode(' ');

}

public void insert(String key) {

TrieNode node = root;

for (int i = 0; i < key.length(); i++) {

int index = key.charAt(i) - 'a';

if (node.children[index] == null) {

node.children[index] = new TrieNode(key.charAt(i));

}

node = node.children[index];

}

node.isEndOfWord = true;

}

}

Trie树的逻辑分析

在 insert 方法中,我们遍历字符串的每个字符,并在Trie树中逐个插入字符。如果当前字符对应的子节点不存在,我们就创建一个新的TrieNode,并将其连接到父节点。当字符串的所有字符都被插入后,我们将最后一个节点的 isEndOfWord 标志设置为 true ,表示一个完整的字符串结束。

5.1.2 哈希表的应用

哈希表是一种通过哈希函数将键映射到存储位置的数据结构,它提供了常数时间的查找、插入和删除操作。在文本分析中,哈希表经常被用来存储单词及其出现的频率。

哈希表的实现通常依赖于一个大小固定的数组和一个哈希函数。哈希函数将键转换为数组的索引,而数组存储值。在处理文本时,可以使用哈希表来快速统计词频,识别重复单词等。

哈希表的代码实现

假设我们需要统计一段文本中的单词频率,可以用以下的哈希表实现:

import java.util.HashMap;

public class WordFrequency {

public HashMap<String, Integer> countFrequency(String text) {

HashMap<String, Integer> map = new HashMap<>();

String[] words = text.split("\\s+"); // 分割字符串获取单词数组

for (String word : words) {

if (!map.containsKey(word)) {

map.put(word, 1);

} else {

map.put(word, map.get(word) + 1);

}

}

return map;

}

}

哈希表的逻辑分析

首先,我们使用空格将输入的文本字符串分割成单词数组。然后,遍历单词数组,如果哈希表中不存在该单词,则将单词加入哈希表并设置计数为1。如果哈希表中已存在该单词,就将其计数加1。最终返回哈希表,其中包含了每个单词及其出现的频率。

5.2 数据结构在性能提升中的作用

在文本分析中,合适的算法和数据结构可以显著地提升程序的效率,减少不必要的计算和存储开销。

5.2.1 减少查找时间复杂度

在没有使用Trie树之前,如果需要查找某个字符串是否在一个集合中,我们可能需要对集合中的每个字符串进行逐一比较,时间复杂度为O(N),其中N是集合中字符串的数量。

通过Trie树,我们可以将查找时间复杂度降低到O(M),其中M是被查找字符串的长度。这是因为Trie树中每个字符仅遍历一次,并且通过字典树的前缀共享,大大减少了比较次数。

5.2.2 提升存储效率

哈希表通过键值对应存储数据,相比于数组或链表,哈希表在存储大量数据时更加高效。在文本分析中,我们通常需要存储大量的单词或字符串,使用哈希表可以减少重复字符串的存储,提高了内存使用效率。

5.3 实际案例分析

接下来我们通过两个案例来进一步分析字典树和哈希表在文本搜索优化和索引构建检索中的应用。

5.3.1 文本搜索优化

设想一个文本搜索的场景,我们需要在一个包含大量文档的数据库中快速找到包含某个特定关键词的文档。使用Trie树可以对所有关键词进行预处理,并构建一个前缀树。

当进行搜索时,我们可以从根节点开始,沿着前缀树的路径查找关键词,如果路径在某个点断开,那么就可以立即知道搜索的关键词不存在于数据库中。如果路径到达一个叶节点,那么搜索的关键词存在,并且可以迅速找到包含该关键词的文档列表。

5.3.2 索引构建和检索

在搜索引擎中,索引是一种重要的数据结构,它帮助快速检索文档。通常的做法是为文档中的每个单词创建索引,并记录单词出现的文档ID。这个过程可以使用哈希表来优化。

当一个新文档被索引时,我们遍历文档中的单词,并使用哈希表来记录每个单词出现的文档ID。如果单词已经存在于哈希表中,我们只需在对应的文档ID列表中添加新文档的ID。如果单词不存在,我们在哈希表中创建一个新条目,并初始化文档ID列表。

检索时,对于给定的搜索关键词,我们可以通过哈希表快速获得包含该关键词的所有文档ID列表,大大减少了检索时间。

6. 算法优化措施,例如Trie和布隆过滤器

6.1 Trie树在文本分析中的应用

Trie树,又称前缀树或字典树,是一种特殊的多叉树结构,用于高效检索字符串数据集中的键。它能够快速地插入和查找字符串,并且在文本分析中尤其有用。

6.1.1 Trie树的实现原理

Trie树的核心在于将一个字符串集组织成树形结构,其中节点表示单个字符,从根节点开始,到子节点的每条路径代表一个字符串。

在Trie树中,每个节点通常包含以下信息: - 指向子节点的指针数组(或链表),数组的大小通常为字符集的大小,例如ASCII字符集为256。 - 一个布尔值,用于标记某个节点是否为某个字符串的结尾。 - 可选的额外信息,例如每个字符出现的频率。

示例代码块展示了一个简单的Trie树的构建过程:

class TrieNode {

TrieNode[] children = new TrieNode[26]; // 假设只处理小写英文字母

boolean isEndOfWord;

public void insert(String word) {

TrieNode node = this;

for (char c : word.toCharArray()) {

if (node.children[c - 'a'] == null)

node.children[c - 'a'] = new TrieNode();

node = node.children[c - 'a'];

}

node.isEndOfWord = true;

}

public boolean search(String word) {

TrieNode node = this;

for (char c : word.toCharArray()) {

if (node.children[c - 'a'] == null)

return false;

node = node.children[c - 'a'];

}

return node.isEndOfWord;

}

public boolean startsWith(String prefix) {

TrieNode node = this;

for (char c : prefix.toCharArray()) {

if (node.children[c - 'a'] == null)

return false;

node = node.children[c - 'a'];

}

return true;

}

}

6.1.2 Trie树在词频统计中的优化案例

Trie树可以在处理文本数据时提高搜索和统计的效率。例如,在搜索引擎的自动完成功能中,可以利用Trie树快速定位到以特定前缀开头的词条,并统计它们的频率。

一个简单的优化案例是,在构建Trie树时同时记录每个节点的词频信息。这样,在搜索时就能直接获取到具有相同前缀的词的频率,无需再对每个词进行遍历统计。

6.2 布隆过滤器的原理和应用

布隆过滤器是一种空间效率极高的概率型数据结构,用于判断一个元素是否在一个集合中。它的特点是判断不存在的效率高,判断存在的效率相对较低(有一定误判率),且无法从布隆过滤器中删除元素。

6.2.1 布隆过滤器的构建和使用

布隆过滤器的构建主要依赖于以下几个参数: - 位数组的大小(m) - 预期插入元素的数量(n) - 选择的k个独立的哈希函数

构建步骤如下: 1. 初始化一个位数组,所有位初始值为0。 2. 选择k个哈希函数,每个哈希函数将元素哈希到位数组中。 3. 将元素插入布隆过滤器时,用k个哈希函数对元素进行哈希,并将对应位数组中的位设置为1。

使用时,一个元素是否可能存在于集合中的判断方式如下: 1. 对元素使用k个哈希函数进行哈希。 2. 检查对应位置的位是否都是1。 3. 如果有一个位置不是1,则元素一定不存在于集合中。

布隆过滤器的误判率取决于位数组大小、哈希函数数量和预期插入元素数量。误判率计算公式为: (1 - e^(-kn/m))^k ,其中 e 为自然对数的底数。

6.3 其他优化算法的探讨

6.3.1 后缀数组和后缀树的应用

后缀数组和后缀树是处理字符串的高级数据结构,它们能够高效地解决许多与字符串相关的复杂问题,如重复子串查找、最长公共前缀等问题。

6.3.2 分布式计算和MapReduce在文本分析中的角色

分布式计算框架,如Apache Hadoop和Apache Spark,通过MapReduce等编程模型,能够处理大规模数据集。在文本分析中,它们可以并行处理文本文件的不同部分,显著提高处理速度和效率。

简介:在自然语言处理中,分词是处理文本数据的关键步骤。本项目使用Java语言开发了一个简单的英文分词程序,旨在统计文本中单词的出现频率,帮助用户深入理解文本数据。程序可能使用基本的空格分词方法或借助高级分词库来处理复杂情况,如连字符或专有名词。统计词频时,会使用数据结构如HashMap来存储和排序单词及其频率,并利用JFreeChart库将统计结果可视化为图表。此外,程序可能引入了优化措施,如使用Trie数据结构和布隆过滤器,以提高处理效率和准确性。这个项目为学习Java编程、NLP和数据可视化提供了实用案例,强调了数据可视化在传达分析结果中的重要性。

9734

9734

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?