简介:微机原理是计算机科学的基础课程,详细解析了个人计算机的构造和工作原理,涵盖了计算机系统概述、数据表示、CPU结构、存储层次、I/O系统、总线系统、汇编语言、运行模式及系统接口等多个核心知识点。本课件深入讲解这些概念,旨在帮助学生和专业人士提升对计算机硬件及软件设计的理解和问题排查能力。

1. 计算机系统概述

1.1 计算机系统定义

计算机系统是一个复杂的电子设备集合,旨在按照预定的程序处理数据和执行各种计算任务。它由硬件和软件两个主要部分构成,硬件提供物理结构,而软件则为硬件提供运行指令和控制程序。

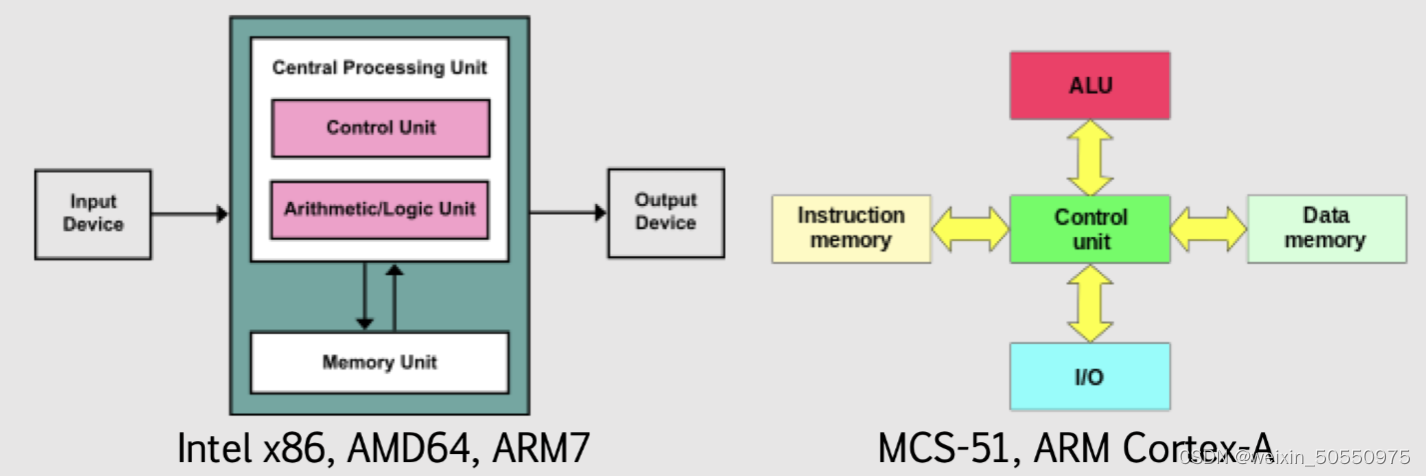

1.2 计算机系统组成

一个典型的计算机系统包括输入设备、中央处理器(CPU)、内存、存储设备和输出设备。它们共同协作完成数据的输入、处理、存储和输出等功能。

1.3 计算机系统功能

计算机系统的基本功能包括数据处理、数据存储、程序控制和数据通信。这些功能能够支撑从基础计算到复杂的数据分析和处理任务。

1.4 计算机系统发展

随着技术的进步,计算机系统经历了从大型机到个人电脑,再到现在的移动设备和云计算平台的演变。每一代的发展都带来了性能的提升和应用范围的扩展。

计算机系统作为信息时代的基石,其发展和变化不断推动着社会的进步与创新。下一章节,我们将深入探讨二进制和数据表示的基础知识。

2. 二进制和数据表示

2.1 二进制基础

在计算机世界中,一切信息的处理、存储和传输,都建立在二进制的基础之上。二进制数系统是最为计算机硬件所接受和使用的数据表示方式。理解二进制数系统,是深入学习计算机系统不可或缺的一环。

2.1.1 二进制数的定义和运算规则

二进制数系统只使用两个数字0和1来表示数值,这种表示方式与传统十进制数(使用0-9)或八进制数(使用0-7)相比,简化了电子电路设计,因为电子设备(如晶体管)天然适合于进行两种状态(开/关,对应二进制中的1/0)的切换。

在二进制运算中,基本的运算规则与十进制类似,但有所简化。加法规则如下: - 0 + 0 = 0 - 1 + 0 = 1 - 1 + 1 = 10(逢二进一)

减法规则也遵循类似的逻辑: - 0 - 0 = 0 - 1 - 0 = 1 - 1 - 1 = 0 - 0 - 1 = 1 (借位)

乘法和除法运算则是在此基础上进行扩展,但核心思想与十进制运算一致。

2.1.2 二进制与十进制的转换方法

二进制与十进制之间的转换是日常工作中常见的操作,特别是在处理IP地址、网络协议、文件权限等场景时。

-

二进制转十进制 :从最低位(最右边)开始,将每个二进制位乘以2的幂次方(从0开始),然后将结果相加。例如,二进制数

1101转换为十进制是1*2^3 + 1*2^2 + 0*2^1 + 1*2^0 = 8 + 4 + 0 + 1 = 13。 -

十进制转二进制 :使用连续除以2的方法,将十进制数除以2,记录下余数,然后继续用商除以2,直到商为0为止。将所有余数倒序排列即得二进制数。例如,十进制数

13转换为二进制是1101。

2.2 数据表示

数据在计算机中的表示不仅仅局限于数字,它还涵盖了字符、图像、音频等多种类型的数据。各种类型的数据都需要通过一定的编码标准来进行存储和处理。

2.2.1 数据的存储单位及其换算

数据存储的基本单位是比特(bit),代表一个二进制位。随后是字节(Byte),一个字节由8个比特组成。在更大的数据量级中,我们通常使用KB(千字节)、MB(兆字节)、GB(吉字节)、TB(太字节)、PB(拍字节)等单位,它们之间的换算关系是1024倍(2的10次方)。

- 1KB = 1024 Bytes

- 1MB = 1024 KB

- 1GB = 1024 MB

- 1TB = 1024 GB

- 1PB = 1024 TB

2.2.2 字符编码标准和应用

字符编码标准为计算机提供了表示文本信息的方法。最著名的字符编码标准之一是ASCII码,它使用7个比特来表示128个字符(包括大小写字母、数字和一些特殊符号)。由于其局限性(只能表示128个字符),无法涵盖包括中文在内的多种语言。

随着计算机技术的全球化,更高级的编码标准如Unicode应运而生。Unicode旨在为世界上每种语言中的每个字符都分配一个唯一的编码,目前有多个版本,如UTF-8、UTF-16等。在不同的编码标准中,字符的存储和表示方式会有所不同,但对于最终用户来说,这些差异是透明的。

Unicode中的UTF-8编码由于其对ASCII码的兼容性及可变长度的特性,已成为互联网上最常用的编码标准。例如,中文字符在UTF-8编码中通常占用3个字节,而英文字符占用1个字节,这使得UTF-8能够灵活地适应不同语言的编码需求。

3. CPU结构与工作原理

3.1 CPU的基本概念

3.1.1 CPU的组成和功能

中央处理单元(CPU)是计算机系统的核心,负责解释和执行程序中的指令。一个CPU主要由运算器、控制器、寄存器组和高速缓冲存储器(Cache)组成。

- 运算器(ALU) :负责执行所有的算术和逻辑运算。

- 控制器(CU) :从内存中取出指令,并解释指令含义,然后指挥计算机各部分协同工作以执行指令。

- 寄存器组 :是CPU内部非常快速的小型存储区域,用于保存暂时数据,如运算过程中的中间结果、内存地址等。

- 高速缓冲存储器(Cache) :位于CPU与主内存之间,用于临时存储频繁访问的数据和指令,以减少CPU访问主内存的次数,加快数据读取速度。

3.1.2 CPU的性能指标和选择标准

CPU性能指标对于衡量和选择CPU至关重要,主要的性能指标包括:

- 主频 :CPU内核工作的时钟频率,单位是Hz,是衡量CPU运算速度的直接指标。

- 核心数 :指CPU内集成的处理器核心的数量,多核心可以同时处理更多的任务。

- 缓存大小 :CPU内部的Cache容量,缓存越大,能存储更多的指令和数据,提高CPU的处理效率。

- 制造工艺 :决定CPU的物理尺寸和能耗,先进的制造工艺可以带来更低的功耗和更高的集成度。

- 支持的指令集 :CPU支持的指令集越丰富,可以执行更多类型的运算,通常包括多媒体、虚拟化等指令集。

选择CPU时,通常需要根据具体的应用场景和预算来决定。例如,对于需要进行大量计算和数据密集型任务的服务器,通常需要选择多核心、大缓存的CPU;而游戏用户则可能更重视高主频以获取更好的游戏体验。

3.2 CPU工作原理

3.2.1 CPU的运算逻辑单元(ALU)和控制单元(CU)

CPU的运算逻辑单元(ALU)和控制单元(CU)共同协作,完成数据处理和控制任务。

- 运算逻辑单元(ALU) :是执行所有算术和逻辑操作的部件。当ALU接收到操作数和指令代码后,根据指令代码完成相应的计算,然后将结果输出。ALU的工作是CPU执行指令的基础。

- 控制单元(CU) :负责整个CPU的控制工作,它从内存中取出指令,然后对指令进行译码,之后发出一系列控制信号指挥其他部件按照指令的要求协同工作。CU是CPU指挥系统,确保数据按正确的路径在不同部件间传输。

3.2.2 指令周期和流水线技术

CPU工作可以通过一个周期性的流程来理解,即指令周期,它包括取指令、指令译码、执行指令和写回结果四个阶段。

- 取指令(Fetch) :从内存中获取即将执行的指令。

- 指令译码(Decode) :对取回的指令进行分析,确定执行该指令需要的操作。

- 执行指令(Execute) :执行指令对应的操作,可能是算术运算、逻辑运算、数据传输等。

- 写回结果(Write-back) :将执行结果写回到寄存器或内存中。

在现代CPU中,为了提高效率,广泛采用流水线技术。流水线将指令周期分成若干个更小的步骤,使得不同指令可以在不同的阶段同时进行,从而在一个周期内完成多条指令的处理。

flowchart LR

A[取指令] --> B[指令译码]

B --> C[执行指令]

C --> D[写回结果]

D --> A

以上是一个简化的CPU流水线示意图,实际的CPU流水线技术要复杂得多,会涉及多个执行单元和分支预测等高级特性。每级流水线完成后,该指令前移至下一级,而下一条指令则进入该流水线级,实现了指令的并行处理。

在流水线技术的应用中,如何处理数据冲突、控制冲突和结构冲突,成为影响CPU性能的关键因素。为了优化这些冲突,现代CPU引入了多种高级技术,例如分支预测、动态调度、乱序执行等,这些将在后续章节进一步讨论。

下一章节,我们将探讨存储层次结构,了解主存、辅存和缓存的概念及其区别,并分析虚拟存储技术与内存分配策略。

4. 存储层次结构

存储是计算机系统中的关键组成部分,它负责数据和程序的持久化存储。合理的存储层次结构可以确保数据存储的高效性和可靠性。本章将深入探讨存储层次结构的概念、分类、技术指标和性能,以及存储管理的策略和算法。

4.1 存储器分类和特性

在深入探讨存储管理之前,首先需要了解存储器的基本分类以及它们各自的特点和区别。

4.1.1 主存、辅存和缓存的概念和区别

存储器根据其作用和特性,主要分为三类:主存(内存)、辅存和缓存。

-

主存(内存) :计算机的主存,或称为RAM(随机存取存储器),是与CPU直接交互的存储器。CPU在执行程序时,会将需要的数据和指令加载到内存中进行处理。主存的特点是访问速度快,但是其容量有限且价格相对较高。

-

辅存 :辅存主要用于长期存储大量数据,例如硬盘驱动器(HDD)、固态驱动器(SSD)和光盘等。辅存的特点是容量大,价格相对便宜,但是其访问速度比主存慢得多。

-

缓存 :缓存位于CPU和主存之间,用来暂时存放CPU近期可能用到的数据,以减少内存的访问次数,从而加快CPU的数据处理速度。缓存具有非常快的访问速度,但其容量相对较小。

它们之间的主要区别在于速度、容量和成本。缓存的速度最快,容量最小,成本最高;而辅存的速度最慢,容量最大,成本最低。

4.1.2 存储器的技术指标和性能分析

衡量存储器性能的关键技术指标包括速度、容量、成本和可靠性。

-

速度 :速度通常以访问时间(存取时间)和数据传输率来衡量。缓存通常具有纳秒级的访问时间,而硬盘的访问时间可能需要几毫秒。

-

容量 :容量是指存储器能够存储数据的最大量。硬盘和SSD的容量可以从几十GB到几个TB不等,而内存的容量通常在几个GB到数十GB之间。

-

成本 :成本是每单位容量的价格。缓存的成本最高,随后是内存,而硬盘的成本最低。

-

可靠性 :可靠性包括存储器的故障率和数据保护能力。通常辅存的可靠性设计更为复杂,例如使用RAID技术保护数据。

通过比较这些指标,可以更好地理解不同存储器在不同应用场景下的优势和限制。

4.2 存储管理

为了提高存储资源的利用率,需要对存储资源进行有效的管理。本节将讨论虚拟存储技术以及内存分配策略和页替换算法。

4.2.1 虚拟存储技术

虚拟存储技术是现代计算机系统中广泛使用的一种存储管理技术。它将硬盘空间作为内存的扩展,使得程序可以访问比实际物理内存更大的地址空间。

虚拟存储通过页表(page table)机制实现地址映射。页表记录了虚拟地址到物理地址的映射关系。当程序访问一个虚拟地址时,CPU通过页表找到相应的物理地址,并访问实际的内存或硬盘空间。

虚拟存储的优势在于:

- 提高内存利用率:程序可以使用比实际物理内存更大的地址空间。

- 程序的可重定位性:允许将程序的不同部分放在物理内存的不同位置。

- 程序的保护:各进程的内存空间相互隔离,增强了系统的安全性。

4.2.2 内存分配策略和页替换算法

内存分配策略和页替换算法是管理内存的两个重要方面。

-

内存分配策略 :它决定如何将物理内存分配给正在运行的进程。常见的内存分配策略包括固定分区分配、动态分区分配和伙伴系统。

-

页替换算法 :当物理内存不足时,页替换算法决定哪些内存页(页面)被调出内存。常用的页替换算法有先进先出(FIFO)、最近最少使用(LRU)和时钟算法(clock/clock with hands)等。

页替换算法的选择对系统的性能有着直接的影响。例如,LRU算法在理论上可以提供较好的性能,因为它倾向于替换长时间未使用的页面。然而,实现LRU算法可能会带来较高的开销,因此在实践中可能会采用更加高效的近似算法。

接下来的部分将继续深入探讨存储管理,包括虚拟存储技术的实现细节以及内存分配策略和页替换算法的具体应用。

请注意,由于篇幅限制,本章节内容的详细讨论将在后续部分展开。

[待续...]

5. 输入/输出系统

5.1 I/O接口与设备

5.1.1 I/O端口的概念和分类

I/O端口是计算机系统中用于实现数据输入输出功能的硬件接口,它允许数据在计算机内部和外部设备之间流动。I/O端口可以被看作是一系列寄存器,它们能够提供设备控制、状态监测以及数据交换的通道。I/O端口通常分为两种类型:独立I/O端口和内存映射I/O端口。

独立I/O端口与CPU地址空间分开,拥有自己独立的地址空间。CPU通过特殊的输入输出指令来访问这些端口。这些指令包括IN和OUT指令,它们直接对I/O端口进行读写操作。在这种情况下,CPU可以使用I/O指令来区分内存操作和I/O操作。

内存映射I/O则是将I/O端口地址映射到CPU的内存地址空间中,使得对这些I/O设备的访问就像访问内存一样,使用普通的内存访问指令。这种方式简化了I/O操作,但是可能会牺牲一部分内存空间。

I/O端口的设计需考虑端口号、端口大小(8位、16位、32位等)、以及端口类型(只读、只写或读/写)。端口设计还必须遵循计算机系统的I/O协议,以便正确地与外部设备进行数据交换。

5.1.2 常见的I/O设备及其特点

在计算机系统中,I/O设备种类繁多,每种设备都有其特定的功能和特点。以下列举了几种常见的I/O设备:

- 键盘和鼠标:作为最常见的输入设备,键盘允许用户输入文本信息,而鼠标则用于指针控制和图形用户界面操作。

- 显示器:是输出设备中的主要部分,用于显示图像、文字、视频等视觉信息。

- 打印机:将计算机生成的文档和图像转换成纸质形式输出。

- 硬盘驱动器和固态驱动器:作为存储设备,负责存储和检索数据。

- 网络接口卡(NIC):提供计算机网络连接功能,使计算机能够通过网络与其他设备通信。

每种设备都有其特定的接口标准,例如USB、HDMI、SCSI和PCIe。在设计I/O系统时,这些接口标准必须得到充分考虑,以确保兼容性和性能。

5.2 I/O控制技术

5.2.1 程序控制I/O和直接存储器访问(DMA)

程序控制I/O和DMA是两种不同的数据传输方式,它们在I/O操作中扮演着重要的角色。

程序控制I/O也称为编程控制I/O,是一种简单的I/O操作方式。在这种方式中,CPU直接参与数据的读写过程。CPU通过不断检查I/O端口的状态位(如忙标志位)来决定是否可以读写数据。当设备准备就绪时,CPU执行相应的I/O指令。这种方式简单易实现,但效率较低,因为CPU必须在等待设备就绪的过程中浪费时间。

; 假设INstructions for checking the status of a device

WAIT: IN AL, STATUS_PORT ; Read the status into AL

TEST AL, READY_BIT ; Test whether the device is ready

JZ WAIT ; If not ready, jump back to WAIT

; At this point, the device is ready and we can proceed with the data transfer

相对于程序控制I/O,DMA技术允许数据直接在内存和I/O设备之间进行传输,无需CPU的干预。当设备准备好数据传输时,它通过DMA控制器向CPU发出请求。CPU响应请求后,将系统总线的控制权交给DMA控制器。DMA控制器接管总线,直接控制数据传输,完成后将总线控制权交还给CPU。

这种方式大大提高了数据传输的效率,尤其是在处理大块数据时。DMA减少了CPU的负担,使得CPU可以专注于其他计算任务。

5.2.2 中断驱动I/O和I/O通道技术

中断驱动I/O和I/O通道技术是两种提升I/O操作效率的机制。

中断驱动I/O利用中断机制来通知CPUI/O操作已经完成。当I/O设备完成数据传输或达到某个状态时,它会向CPU发送一个中断信号。CPU响应中断,执行相应的中断服务程序来处理数据,然后继续执行主程序。这种机制可以减少CPU的等待时间,提高系统的响应性和吞吐量。

// Pseudocode for handling an interrupt

void interrupt_handler() {

// Identify the device that caused the interrupt

Device device = identify_device();

// Perform necessary processing for the device

process_device(device);

// Send an acknowledgement to the device

send_acknowledgement(device);

// Clear the interrupt flag so that further interrupts can be handled

clear_interrupt_flag();

}

I/O通道技术进一步扩展了中断驱动I/O的概念。在这种机制下,通道控制器拥有一定的处理能力,可以在没有CPU直接参与的情况下控制多个设备。CPU为I/O通道设置好参数,并指示其开始操作,然后通道控制器接管数据传输任务。CPU仅在通道完成任务后进行处理。这种技术常用于大型计算机系统,能够实现高效的数据处理。

flowchart LR

A[CPU] -->|设置参数| B[通道控制器]

B -->|控制I/O设备| C[数据传输]

C -->|完成| B

B -->|通知| A

综上所述,I/O控制技术的选择需要根据系统需求和设备特性来定。程序控制I/O适用于简单或低速设备,而DMA和中断驱动I/O适用于高速或大量数据传输的场景。I/O通道技术则适用于需要高度并行操作的复杂系统。

6. 总线系统

6.1 总线的基本概念

6.1.1 总线的功能和分类

总线系统是计算机系统中用于实现各个部件之间数据、地址和控制信号传递的基础架构。总线的主要功能包括数据传输、设备控制、地址识别和电源分配等。它确保了计算机内部各组件之间以及与外部设备的通信。

总线根据其连接的不同设备或部件,可以分为内部总线和外部总线:

- 内部总线 (Internal Bus):连接CPU内部各寄存器、运算器、控制器等部件。它们通常属于专用总线,例如控制总线、地址总线和数据总线。

- 外部总线 (External Bus):连接计算机内部与外部设备,如打印机、键盘、鼠标等。常见的外部总线标准包括USB、PCI、SATA等。

在设计上,总线系统倾向于支持模块化扩展,允许在不更改核心系统的情况下添加新设备,这对于维护和升级计算机系统至关重要。

6.1.2 总线标准和性能指标

总线标准规定了总线的电气特性和协议规范,使得不同制造商生产的设备能够相互通信。它包括了诸如信号电平、时序、数据传输速率和连接器的物理结构等要素。

性能指标主要取决于总线的宽度、速度、容量和同步性:

- 总线宽度 (Bus Width):表示可以同时传输的位数,比如8位、16位、32位或64位。

- 总线速度 (Bus Speed):表示数据传输的速率,通常用MHz表示。

- 总线容量 (Bus Bandwidth):可以理解为总线的数据吞吐能力,与总线宽度和速度有关。

- 同步性 (Synchronous vs. Asynchronous):同步总线在同一时钟信号控制下工作,而异步总线则在无时钟信号的情况下操作。

随着技术的发展,总线标准也在不断更新。例如,PCI Express (PCIe) 现在广泛应用于显卡、高速网卡等设备的连接,其传输速率远高于早期的PCI总线。

6.2 总线通信机制

6.2.1 同步与异步通信

同步通信要求所有的数据传输都在一个共同的时钟信号下进行,各部件的时序严格对应。这意味着系统中有一个统一的时钟来控制数据的发送和接收。同步通信的优点在于传输速度快、稳定且容易同步,但缺点是时钟信号的传播延迟可能会限制总线的性能。

异步通信无需统一的时钟信号,通过请求和应答信号来控制数据传输的时序。它允许数据在不需要时钟线同步的情况下传输,这使得设计更加灵活,但是它可能会比同步通信慢一些,并且控制逻辑更为复杂。

在现代计算机系统中,通常采用混合模式,即总线的某些部分使用同步通信,而其他部分采用异步方式。

6.2.2 总线仲裁和定时控制

当多个设备需要使用同一条总线时,就需要总线仲裁机制来决定哪个设备有权使用总线。常见的总线仲裁方法有集中式仲裁和分布式仲裁:

- 集中式仲裁 :有一个独立的仲裁器控制所有设备的总线请求和授权。

- 分布式仲裁 :没有独立的仲裁器,各个设备之间通过竞争获得总线控制权。

总线的定时控制通常由总线控制器或相关的控制逻辑实现,这涉及到信号的同步、时序控制、传输确认等。一个良好的定时控制机制能够减少总线的冲突,提高总线的利用率,从而提升整个系统的性能。

在计算机系统的设计中,总线仲裁和定时控制对于保证数据传输的高效性和可靠性起着关键作用。

7. 汇编语言与系统接口

汇编语言是与硬件紧密相关的低级语言,它允许程序员直接与计算机硬件进行交互。为了充分利用计算机系统的硬件资源,了解汇编语言是很有必要的。本章节将探讨汇编语言的基础知识、编程实例以及如何通过系统接口与硬件进行交互。

7.1 汇编语言基础

7.1.1 汇编语言的语法结构

汇编语言使用助记符来表示机器语言指令,这使得它比机器语言更易于理解和编写。每条汇编指令通常由三部分组成:

- 标签(可选):标识指令的位置,用于跳转指令的目标地址。

- 操作码(opcode):指示要执行的操作,如加法、减法等。

- 操作数(operand):指出操作的输入数据、输出数据或数据的位置。

汇编语言的语句通常在一行内完成,指令之间用分号 ; 或者新行分隔。例如,一个简单的汇编指令可能是这样的:

mov ax, 1 ; 将数值1移入AX寄存器

add ax, bx ; 将BX寄存器的值加到AX寄存器中

7.1.2 基本指令集和编程实例

汇编语言指令集包含了各种操作硬件的基本指令。一些基础指令包括数据传输指令(如 MOV )、算术指令(如 ADD 、 SUB )、逻辑指令(如 AND 、 OR )、控制转移指令(如 JMP 、 CALL )等。下面是一个简单的汇编程序,实现两个数相加的功能:

section .text

global _start

_start:

mov eax, 5 ; 将数值5移入EAX寄存器

mov ebx, 3 ; 将数值3移入EBX寄存器

add eax, ebx ; 将EAX和EBX寄存器的值相加,结果存回EAX

; 在这里,EAX = 8

7.2 系统接口编程

系统接口编程涉及使用操作系统提供的接口与硬件进行交互,这包括BIOS和DOS中断调用、以及将高级语言与汇编语言混合使用的技巧。

7.2.1 BIOS和DOS中断调用

BIOS和DOS中断调用是早期系统编程中常用的接口方式,它们提供了一组预定义的功能,比如屏幕显示、磁盘操作、系统时间获取等。在汇编语言中,中断调用通过 INT 指令来执行,后面跟一个中断号。

例如,下面的汇编代码调用BIOS中断 0x10 来显示字符 'A' :

section .text

global _start

_start:

mov ah, 0x0E ; BIOS文本输出功能

mov al, 'A' ; 要显示的字符

mov bh, 0x00 ; 页面号

mov bl, 0x07 ; 属性(亮白色)

int 0x10 ; 调用视频中断服务

7.2.2 高级语言与汇编语言的混合编程技巧

在现代编程实践中,通常会将汇编语言与高级语言混合使用,以实现特定的性能优化或者硬件操作。混合编程的关键在于正确地在两种语言间传递参数和控制流程。

一种常见的方法是使用内联汇编,这是嵌入在高级语言代码中的汇编指令。例如,在C语言中使用内联汇编:

int a = 10;

int b = 20;

__asm {

mov eax, a ; 将变量a的值移入EAX

add eax, b ; 将变量b的值加到EAX

mov c, eax ; 将结果存储回变量c

}

通过这种混合编程的方式,可以利用高级语言的强大功能和汇编语言对硬件的精细控制,实现更加灵活和高效的系统编程。

汇编语言作为最接近硬件的编程语言之一,提供了强大的灵活性和控制能力。掌握其基础知识和系统接口编程技巧,对于深入理解计算机系统工作原理,以及开发高性能应用程序都至关重要。

简介:微机原理是计算机科学的基础课程,详细解析了个人计算机的构造和工作原理,涵盖了计算机系统概述、数据表示、CPU结构、存储层次、I/O系统、总线系统、汇编语言、运行模式及系统接口等多个核心知识点。本课件深入讲解这些概念,旨在帮助学生和专业人士提升对计算机硬件及软件设计的理解和问题排查能力。

350

350

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?