1. 概念

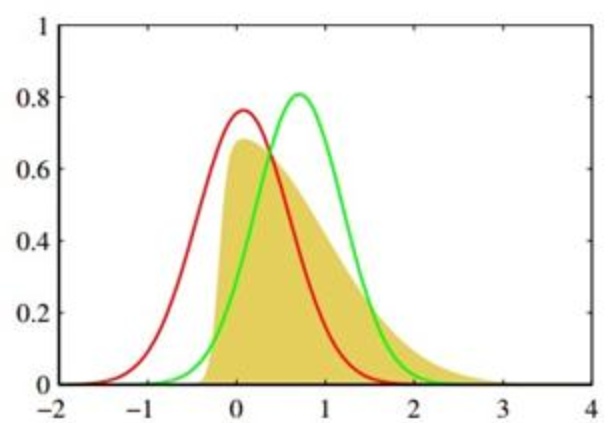

考虑某个未知的分布 p(x),假定用一个近似的分布 q(x) 对它进行建模。如果我们使用 q(x) 来建立一个编码体系,用来把 x 的值传给接收者,那么由于我们使用了q(x)而不是真实分布p(x),平均编码长度比用真实分布p(x)进行编码增加的信息量(单位是 nat )为:

这被称为分布p(x)和分布q(x)之间的 相对熵(relative entropy)或者KL散 度( Kullback-Leibler divergence )。

也就是说,当我们知道真实的概率分布之后,可以给出最有效的编码。如果我们使用了不同于真实分布的概率分布,那么我们一定会损失编码效率,并且在传输时增加的平均额外信息量至少等于两个分布之间的KL散度。

注意, 这不是一个对称量,即

现在要证明的是KL散度满足

设实直线上的函数f(x) 是一个非负函数,且:

如果 g 是任意实可测函数且函数

注意到,-ln x 是严格的凸函数且

令

把公式(2)形式的 Jensen 不等式应用于公式(1)给出的 KL散度,直接可得

只有 q(x) = p(x) 对于所有 x 都成立时,等号才成立,

因此我们可以把 KL 散度看做两个分布 p(x) 和 q(x)之间不相似程度的度量。 3. 最小化 Kullback-Leibler 散度等价于最大化似然函数

假设我们想要对未知分布p(x) 建模,可以试着使用一些参数分布

通过最小化 p(x) 和

如果已经观察到了服从分布 p(x) 的有限数量的训练点集

公式(4)右侧的第二项与

因此最小化KL散度等价于最大化似然函数。

4. KL散度的测度论定义

如果

由Radon–Nikodym theorem,

参考资料:

[1] PRML

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?