简介:本文介绍如何使用Python实现大文件的高效传输,专注于通过Socket和TCP协议进行数据传输,提供了服务器端和客户端的代码实现。教程详细解释了TCP的可靠性、文件信息处理、性能优化方法如非阻塞I/O、多线程、断点续传,以及如何运行脚本和解决常见问题。

1. Python大文件传输概述

1.1 Python与大文件传输

在信息技术的快速发展下,数据传输的高效性与稳定性变得日益重要。Python作为一种高级编程语言,凭借其简洁的语法和强大的库支持,在处理大文件传输方面表现出色。从简单的本地文件复制到复杂的网络文件传输,Python都能提供高效、稳定的解决方案。

1.2 大文件传输的挑战

然而,大文件传输面临着众多挑战。网络带宽限制、服务器性能瓶颈以及传输过程中的数据完整性与安全性都是需要重点关注的问题。针对这些问题,本文将从Python的网络编程层面深入探讨,如何借助标准库和第三方库来实现高效且稳定的大文件传输。

1.3 本文的目标与内容

本文将全面介绍Python在大文件传输中的应用,涵盖网络协议的选择、Socket编程原理及实现、性能优化技巧、断点续传技术等关键环节。通过对这些关键知识点的讲解,帮助读者掌握在复杂网络环境中实现高效大文件传输的能力。

2. ```

第二章:TCP协议基础

2.1 TCP协议简介

2.1.1 TCP协议特点

传输控制协议(TCP)是一种面向连接的、可靠的、基于字节流的传输层通信协议。它的主要特点包括:

- 面向连接 :在数据传输之前,需要建立一条连接,并在数据传输完毕后,释放这个连接。

- 可靠性 :通过序列号、确认应答、重传机制、校验和等来确保数据包的正确传输。

- 流量控制 :通过滑动窗口协议来控制数据流的速率,防止发送方发送得过快导致接收方来不及处理。

- 拥塞控制 :通过动态调整数据包发送速率来避免网络中的拥塞。

- 全双工通信 :允许数据在两个方向上同时传输,是双向的。

2.1.2 TCP与UDP的区别

TCP和用户数据报协议(UDP)都是传输层的协议,但它们在多个方面存在差异:

- 连接方式 :TCP是面向连接的协议,而UDP是无连接的。

- 可靠性 :TCP提供可靠的数据传输,保证数据正确无误地到达目的地;而UDP不保证数据包的到达。

- 顺序 :TCP保证数据包顺序,即使它们到达的顺序不同,接收方也会按照发送的顺序重组数据;UDP不保证数据包的顺序。

- 效率与开销 :由于TCP需要建立连接、保证可靠性等,效率比UDP低,开销更大。

- 应用场景 :TCP适用于需要保证数据完整性和顺序的场景,如文件传输、邮件发送等;UDP适用于对实时性要求高的场景,如视频会议、在线游戏等。

2.2 TCP三次握手与四次挥手

2.2.1 三次握手过程解析

TCP连接的建立需要通过三次握手的过程,其具体步骤如下:

- 第一次握手 :客户端发送一个带有SYN标志的TCP段到服务器,并进入SYN_SEND状态。这个TCP段包含客户端的初始序列号。

- 第二次握手 :服务器接收到客户端的SYN包后,发送一个带有SYN标志和ACK标志的TCP段作为应答,并进入SYN_RECV状态。这个TCP段同样包含服务器的初始序列号。

- 第三次握手 :客户端收到服务器的SYN+ACK包后,发送一个ACK包到服务器,然后进入ESTABLISHED状态。服务器收到客户端的ACK后,也进入ESTABLISHED状态,完成三次握手。

2.2.2 四次挥手过程解析

TCP连接的释放需要经过四次挥手的过程,具体步骤如下:

- 第一次挥手 :客户端发送一个FIN标志的TCP段到服务器,表示客户端已经没有数据要发送了,并进入FIN_WAIT_1状态。

- 第二次挥手 :服务器收到客户端的FIN包后,发送一个ACK包作为应答,并进入CLOSE_WAIT状态。

- 第三次挥手 :服务器准备好释放连接后,发送一个带有FIN标志的TCP段到客户端,并进入LAST_ACK状态。

- 第四次挥手 :客户端收到服务器的FIN包后,发送一个ACK包作为应答,并进入TIME_WAIT状态。服务器收到客户端的ACK包后,释放连接。

2.3 TCP传输可靠性机制

2.3.1 流量控制

流量控制的目的是防止发送方发送数据过快,导致接收方来不及处理。TCP使用滑动窗口协议来实现流量控制:

- 发送方维护一个发送窗口,表示在未收到确认之前可以发送的字节数。

- 接收方维护一个接收窗口,表示在未通知发送方之前可以接收的字节数。

- 当接收方处理完数据后,会将接收窗口的大小信息发送给发送方,发送方根据这个信息调整自己的发送窗口。

2.3.2 拥塞控制

拥塞控制的目的是避免过多的数据注入到网络中,导致网络中的路由器或链路过载。TCP使用以下四种算法来实现拥塞控制:

- 慢开始 :当主机开始传输数据时,先发送少量数据,观察网络的响应。

- 拥塞避免 :当确认拥塞窗口达到阈值时,改用线性增长方式逐渐增大拥塞窗口。

- 快重传 :如果接收到对一个已发送的数据包的重复ACK,可能表明丢失了一个数据包,TCP快速重传丢失的数据包。

- 快恢复 :在快重传之后,执行快恢复算法,调整阈值为慢开始阈值的一半,然后开始拥塞避免算法。

通过以上机制,TCP确保了网络的稳定性和数据的可靠性。

# 3. Socket服务器端代码实现(`socker_server.py`)

## 3.1 Socket编程基础

### 3.1.1 Python中的Socket API

Python的socket库提供了标准的BSD socket API接口,允许开发者轻松地编写网络服务端和客户端程序。通过使用socket库,我们可以创建套接字(sockets),通过指定的IP地址和端口来监听、连接和发送接收数据。

下面是一个简单的socket服务器端API使用示例:

```python

import socket

# 创建一个socket对象

server_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

# 绑定地址和端口

server_socket.bind(('localhost', 12345))

# 开始监听

server_socket.listen(5)

print('Server is listening on localhost:12345')

在这段代码中,首先导入socket模块,然后创建一个socket对象。 AF_INET 表示使用IPv4地址, SOCK_STREAM 表示基于TCP协议的socket。接着,使用 bind() 方法将套接字绑定到指定的IP地址和端口上。 listen() 方法用于监听连接请求。

3.1.2 面向连接的Socket编程

面向连接的Socket编程主要使用TCP协议,它是一种面向连接的、可靠的、基于字节流的传输层通信协议。TCP保证数据包的顺序、准确性和完整性,因此非常适合传输大量数据。

以下是一个简单的面向连接的Socket通信的示例:

# 接受连接

client_socket, client_address = server_socket.accept()

print(f"Connected by {client_address}")

try:

while True:

# 接收数据

data = client_socket.recv(1024)

if not data:

break

# 处理数据...

# 发送数据

client_socket.sendall(b"Data received")

finally:

# 关闭连接

client_socket.close()

在这个例子中,服务器使用 accept() 方法等待客户端的连接。接收到连接后,服务器进入一个循环,使用 recv() 方法接收来自客户端的数据。如果接收到的数据为空,表示客户端已断开连接,循环结束。服务器使用 sendall() 向客户端发送确认消息,并最终关闭连接。

3.2 服务器端代码实现细节

3.2.1 创建Socket和绑定地址

在编写服务器端代码时,首先要创建一个socket对象,并为这个socket指定一个IP地址和端口号。这个地址和端口号就是服务器的标识,客户端通过这个标识来连接服务器。

# 创建socket对象

server_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

# 绑定地址和端口

server_socket.bind(('0.0.0.0', 9999))

在这里, 0.0.0.0 表示监听所有可用的网络接口。 9999 是服务器监听的端口号。将socket绑定到地址和端口之后,服务器开始监听来自客户端的连接请求。

3.2.2 监听连接请求

服务器创建socket并绑定地址后,需要调用 listen() 方法来监听连接请求。 listen() 方法告诉socket库我们准备接收连接请求了。

# 开始监听连接请求

server_socket.listen(5)

print('Server is listening for connections...')

listen(5) 中的数字5表示在接收新的连接请求之前,服务器可以拥有五个排队的未处理连接。一旦接收到一个新的连接请求,服务器就可以派生一个新的线程或进程来处理该连接,而主服务器继续监听其他连接请求。

3.2.3 接受客户端连接

服务器运行在监听状态时,需要接受来自客户端的连接。 accept() 方法会阻塞服务器,直到一个新的连接到来。

# 接受客户端连接

client_socket, client_address = server_socket.accept()

print(f"Received connection from {client_address}")

accept() 方法返回两个值,第一个是新的socket对象,用于与客户端通信;第二个是一个包含客户端地址的元组。这允许服务器处理多个并发连接,因为服务器主socket继续监听,而新创建的socket用于处理特定的客户端连接。

3.2.4 数据接收与发送

一旦服务器接受到一个连接请求,它就需要与客户端进行数据交换。数据的发送与接收通过 recv() 和 sendall() 方法完成。

# 接收数据

data = client_socket.recv(1024)

print(f"Received {len(data)} bytes: {data}")

# 发送数据

client_socket.sendall(b"Server acknowledged your request")

recv(1024) 方法接收最多1024字节的数据,如果数据不足1024字节,它返回实际接收的数据长度。 sendall() 方法用于发送数据,确保所有请求的数据都被发送。

3.3 服务器端代码实现示例

下面是一个完整的服务器端代码实现示例,该示例中服务器接收客户端发送的文件,并将其存储到服务器本地。

import socket

def main():

# 创建socket对象

server_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

# 绑定地址和端口

server_socket.bind(('0.0.0.0', 9999))

# 开始监听连接请求

server_socket.listen(5)

print('Server is listening for connections...')

while True:

# 接受客户端连接

client_socket, client_address = server_socket.accept()

print(f"Received connection from {client_address}")

with client_socket as sock:

while True:

# 接收数据

data = sock.recv(1024)

if not data:

break

# 这里可以将接收到的数据写入文件等操作

# 发送数据

sock.sendall(b"Data received and processed")

if __name__ == '__main__':

main()

该示例展示了如何使用Python的socket模块创建一个简单的TCP服务器,这个服务器能够接受客户端的连接请求,接收客户端发送的数据,并发送响应信息给客户端。在实际应用中,接收的数据可能是一个文件,服务器需要将其写入到磁盘中,这将在后续章节中详细讨论。

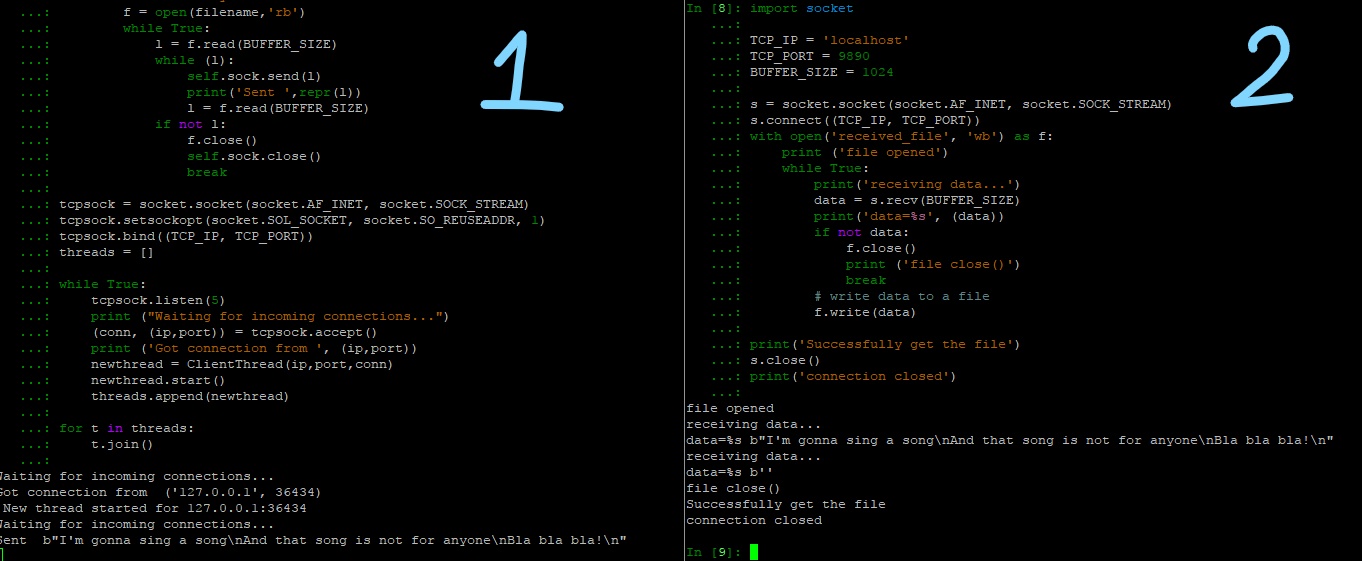

4. Socket客户端代码实现( socker_client.py )

4.1 客户端编程要点

4.1.1 连接到服务器

连接到服务器是客户端编程的首要任务。通常,这涉及到指定服务器的IP地址和端口号,然后使用Socket API创建一个到服务器的连接。以下是一个典型的TCP连接代码示例:

import socket

def connect_to_server(host, port):

# 创建一个socket对象

client_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

try:

# 连接到服务器

client_socket.connect((host, port))

print(f"成功连接到服务器 {host}:{port}")

return client_socket

except Exception as e:

print(f"连接失败: {e}")

return None

# 使用函数连接到服务器

client_socket = connect_to_server('127.0.0.1', 12345)

4.1.2 发送和接收数据

连接成功后,客户端可以使用socket发送请求或数据到服务器,并接收服务器的响应或数据。下面的代码示例展示了如何发送和接收数据:

def send_and_receive_data(sock):

try:

# 发送数据

message = "Hello, Server!"

sock.sendall(message.encode('utf-8'))

# 接收数据

data = sock.recv(1024).decode('utf-8')

print(f"服务器响应: {data}")

except Exception as e:

print(f"数据传输失败: {e}")

# 使用已连接的socket发送和接收数据

if client_socket:

send_and_receive_data(client_socket)

4.2 客户端代码实现步骤

4.2.1 创建Socket

创建Socket是网络通信的第一步,Python的 socket 模块提供了丰富的函数来完成这一步骤。

import socket

def create_socket():

# 创建socket对象

s = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

return s

client_socket = create_socket()

4.2.2 连接到服务器

连接到服务器的代码如上述4.1.1小节所示。

4.2.3 文件数据的读取与传输

对于大文件的传输,我们通常需要将文件分割成多个块,并且在传输过程中,接收方需要有确认机制以保证文件完整性。以下代码展示了如何实现这一过程:

def send_file(sock, file_path):

# 读取文件数据

with open(file_path, 'rb') as file:

chunk_size = 1024 # 1KB

while True:

chunk = file.read(chunk_size)

if not chunk:

break

# 发送文件块

sock.sendall(chunk)

print("文件传输完成")

# 调用函数发送文件

send_file(client_socket, 'example.txt')

4.2.4 关闭连接

数据传输完成后,正确地关闭连接是非常重要的,以释放系统资源。

def close_socket(sock):

if sock:

sock.close()

# 关闭之前创建的socket

close_socket(client_socket)

综上所述,客户端的实现涉及到了与服务器的连接,数据的发送与接收,以及文件的传输等多个步骤。在实现这些功能时,需要注意异常处理,确保程序的健壮性。在下一章节中,我们将讨论性能优化技巧,这些技巧将帮助我们提高客户端在文件传输过程中的效率和稳定性。

5. 性能优化技巧(非阻塞I/O、多线程/多进程、异步I/O模型)

5.1 非阻塞I/O在大文件传输中的应用

5.1.1 非阻塞I/O的概念

非阻塞I/O是一种I/O操作方式,它允许程序在等待I/O操作完成时继续执行其他任务,而不是挂起程序的执行。这在处理大文件传输时尤其有用,因为它可以减少等待时间,提高程序的响应性。

在非阻塞I/O模式下,当程序尝试执行I/O操作时,如果数据还没有准备好,操作系统会立即返回一个错误代码,而不是让程序暂停等待。程序必须检查操作是否成功,并在必要时重新尝试。这要求程序能够处理部分成功的I/O操作和错误状态,但这可以显著提高并发性和效率,特别是在网络通信和文件操作等场景。

5.1.2 提高传输效率的方法

要提高大文件传输的效率,可以采用以下策略:

-

使用非阻塞套接字 :在Socket编程中,可以通过设置套接字选项,将套接字模式设置为非阻塞。这样,读写操作在数据未准备好时不会阻塞程序执行,而是可以立即得到控制权返回给程序。程序可以检查操作的返回状态,并继续处理其他任务。

-

缓冲管理 :在非阻塞I/O中,使用合适的缓冲策略可以避免频繁的小数据包传输,通过积累数据到一定量后再进行传输可以减少系统调用的次数。

-

事件循环和回调函数 :利用事件循环机制来监听I/O事件。当I/O操作可执行时,事件循环会调用预先注册的回调函数来处理I/O事件,这样可以避免线程阻塞等待I/O完成。

-

使用支持异步I/O的库 :某些编程语言和框架提供了高级的异步I/O支持,如Python的

asyncio库。这些库隐藏了事件循环和回调函数的复杂性,使得编写非阻塞I/O代码更加容易和高效。

通过实施这些策略,我们可以构建一个高效的大文件传输系统,它能够在处理大文件传输时保持高响应性和低延迟。

5.2 多线程/多进程在文件传输中的应用

5.2.1 多线程的优势与实现

多线程是一种编程技术,它允许在单个程序中同时执行多个线程。每个线程可以看作是程序中的一个轻量级进程。在文件传输中,多线程可以用来并发地处理不同的任务,如同时处理多个客户端请求或分片处理大文件传输。

多线程的优势

-

提高资源利用率 :多线程允许多个任务同时执行,可以更好地利用CPU资源,尤其是在CPU密集型和I/O密集型操作混合的任务中。

-

增强用户体验 :多线程可以实现异步操作,对于客户端来说,可以无感知地进行大文件传输,而不是等到整个文件下载完成。

-

灵活的并发控制 :通过线程池的管理,可以精确控制并发线程的数量,避免无限制的线程创建导致的资源耗尽问题。

多线程的实现

Python中的 threading 模块提供了丰富的接口来创建和管理线程。下面是一个简化的示例代码,展示了如何使用Python的 threading 模块来并发地传输文件的一部分。

import threading

import socket

def send_file_part(data, conn):

conn.sendall(data)

def thread_transfer(file_path, host, port, offset, size):

with open(file_path, 'rb') as file:

file.seek(offset)

data = file.read(size)

with socket.socket(socket.AF_INET, socket.SOCK_STREAM) as conn:

conn.connect((host, port))

thread = threading.Thread(target=send_file_part, args=(data, conn))

thread.start()

thread.join() # 等待线程完成

# 使用多个线程来并发传输文件的不同部分

threads = []

file_size = os.path.getsize(file_path)

block_size = 1024 * 1024 # 1MB

for i in range(0, file_size, block_size):

thread = threading.Thread(target=thread_transfer, args=(file_path, host, port, i, block_size))

threads.append(thread)

thread.start()

for thread in threads:

thread.join() # 等待所有线程完成

这个例子中,我们定义了一个 send_file_part 函数,它负责发送文件的一部分。然后我们定义了一个 thread_transfer 函数,它创建一个线程来调用 send_file_part 函数。最后,我们创建了多个线程,每个线程负责文件的一个分片,从而实现了并发地传输大文件。

5.2.2 多进程的优势与实现

多进程类似于多线程,但是它涉及的是创建多个进程来执行任务。每个进程都有自己的内存空间,因此与多线程相比,它不会受到全局解释器锁(GIL)的限制,更适合CPU密集型任务。在文件传输中,特别是涉及到文件加密、压缩或其他需要大量计算的任务时,多进程可以提供更好的性能。

多进程的优势

-

独立的内存空间 :每个进程有自己独立的内存空间,这减少了数据共享带来的潜在问题。

-

更高的并发性 :因为进程之间是独立的,所以可以实现更高级别的并发处理。

-

避免GIL限制 :对于Python这种解释性语言,多进程可以避免由于全局解释器锁(GIL)导致的线程执行效率问题。

多进程的实现

Python的 multiprocessing 模块提供了创建和管理进程的接口。下面是一个使用 multiprocessing 模块来并发地处理文件不同部分的简单示例:

import multiprocessing

import socket

def send_file_part(data, conn):

conn.sendall(data)

def process_transfer(file_path, host, port, offset, size):

with open(file_path, 'rb') as file:

file.seek(offset)

data = file.read(size)

with socket.socket(socket.AF_INET, socket.SOCK_STREAM) as conn:

conn.connect((host, port))

conn.sendall(data)

def main(file_path, host, port):

file_size = os.path.getsize(file_path)

block_size = 1024 * 1024 # 1MB

processes = []

for i in range(0, file_size, block_size):

p = multiprocessing.Process(target=process_transfer, args=(file_path, host, port, i, block_size))

processes.append(p)

p.start()

for p in processes:

p.join()

if __name__ == '__main__':

main(file_path='large_file.zip', host='127.0.0.1', port=12345)

在这个例子中,我们定义了一个 process_transfer 函数,它负责打开文件、读取数据并发送。然后我们使用 multiprocessing.Process 创建了多个进程,并发地将文件的不同部分传输到服务器。这种方式特别适合在多核CPU上运行,可以显著提高文件传输的效率。

5.3 异步I/O模型与事件驱动

5.3.1 异步I/O模型介绍

异步I/O模型是一种不同于传统的同步I/O的操作方式,它允许程序发起一个I/O操作,然后立即返回继续执行其他任务。当I/O操作完成时,操作系统会通知程序,并提供数据或错误信息。这种方式使得程序可以同时执行多个I/O密集型任务而无需阻塞等待。

异步I/O的核心在于事件循环和回调机制。当一个异步操作被发起时,它不会等待操作完成。相反,程序会继续执行,直到操作完成后的回调函数被触发。这允许程序在等待I/O操作完成的同时执行其他操作,从而实现更高的并发性和效率。

5.3.2 事件驱动编程的优势

事件驱动编程是一种编程范式,它主要依赖于事件的触发来驱动程序执行。在事件驱动模型中,事件循环负责监听各种事件(如鼠标点击、键盘输入、I/O操作完成等),并根据事件的类型调用相应的事件处理程序。

事件驱动的优势

-

更高的并发性 :事件驱动模型通过事件循环机制来处理多个并发事件,它不需要为每个任务创建独立的线程或进程,因此资源消耗更低。

-

响应式设计 :事件驱动模型天然支持响应式编程模式,程序状态更新是基于事件的触发,这对于构建交互式用户界面和网络应用特别有用。

-

代码可维护性 :由于事件驱动模型通常将任务分解为一系列事件处理程序,这使得代码结构更清晰,逻辑更易于理解。

Python的 asyncio 库是实现异步I/O编程的工具,它提供了一个事件循环以及构建异步应用程序所需的其他实用功能。下面是一个简单的异步I/O示例,展示如何使用 asyncio 库来并发地发起多个网络请求:

import asyncio

async def download_file(url):

print(f"Downloading {url}")

# 这里用一个协程代替实际的下载操作

await asyncio.sleep(2)

print(f"Finished downloading {url}")

async def main(urls):

tasks = [download_file(url) for url in urls]

await asyncio.gather(*tasks)

if __name__ == '__main__':

urls = ['http://example.com/file1.zip', 'http://example.com/file2.zip', 'http://example.com/file3.zip']

asyncio.run(main(urls))

在这个例子中,我们定义了一个 download_file 的异步函数来模拟下载文件的操作。然后我们在 main 函数中为每个URL创建了一个协程,并使用 asyncio.gather 函数并发地执行这些协程。这种方式可以有效地处理大量的I/O密集型任务,如同时处理多个大文件下载。

在本章节中,我们深入探讨了性能优化的多个方面,从非阻塞I/O到多线程/多进程的实现,再到异步I/O模型与事件驱动。这些优化技术不仅适用于大文件传输,也能广泛应用于需要高效I/O操作的各种应用场景中。通过实施这些策略,开发者能够构建出既快速又灵活的应用程序。

6. 断点续传技术介绍

6.1 断点续传原理

6.1.1 断点续传的需求背景

在大文件传输的场景中,网络中断或客户端异常退出是常见问题,传统的文件传输方法在遇到这些问题时,需要重新从头开始传输整个文件,这不仅消耗了大量的网络资源,同时也影响了用户的体验。为了解决这个问题,断点续传技术应运而生。该技术允许文件传输在中断后,从上次停止的地方继续传输,而不需要重新开始,大大提高了数据传输的效率和可靠性。

6.1.2 断点续传的工作原理

断点续传的核心原理是将大文件分割成多个小块(文件切片),在传输过程中记录已经成功传输的数据块,一旦传输中断,下次传输时只需从最后一个未传输成功的数据块开始继续传输,直至所有数据块全部成功传输完成。通常,这个信息会被存储在本地或服务器端的一个日志文件中。

6.2 断点续传的实现方法

6.2.1 文件切片传输

文件切片是断点续传的基础,通过以下步骤实现文件的切片传输:

- 首先确定文件的总大小,以及每个切片的大小。

- 为每个切片分配一个唯一标识(如序号)。

- 对文件进行遍历,逐个切片读取文件内容并进行传输。

- 在传输过程中记录每个切片的传输状态,成功或失败。

这里给出一个简单的Python代码示例,展示如何将大文件进行切片:

def slice_file(file_path, slice_size):

slice_count = 0

with open(file_path, 'rb') as f:

while True:

bytes_read = f.read(slice_size)

if not bytes_read:

break

slice_count += 1

slice_name = f"{file_path}.slice{slice_count}"

with open(slice_name, 'wb') as slice_file:

slice_file.write(bytes_read)

return slice_count

# 使用示例

file_path = 'large_file.zip'

slice_size = 1024 * 1024 # 假设每个切片大小为1MB

total_slices = slice_file(file_path, slice_size)

print(f"文件被切分成 {total_slices} 个切片。")

在这个代码块中,我们定义了一个 slice_file 函数,它接收要切片的文件路径和每个切片的大小,然后将文件切分成指定大小的多个切片,并将它们存储在当前文件夹中。

6.2.2 记录与读取传输进度

记录传输进度是断点续传的另一个关键部分,可以通过维护一个列表或字典结构来实现。以下是一个简单的记录和读取传输进度的逻辑实现:

# 记录传输进度

progress_file = 'progress.txt'

with open(progress_file, 'w') as pf:

pf.write(f"{total_slices}\n")

for i in range(1, total_slices + 1):

pf.write(f"{i}成功\n")

# 读取传输进度

def read_progress(progress_file):

if not os.path.exists(progress_file):

return 0

with open(progress_file, 'r') as pf:

lines = pf.readlines()

return len(lines) - 1

# 使用示例

completed_slices = read_progress(progress_file)

print(f"已完成 {completed_slices} 个切片的传输。")

在此代码段中,我们首先创建一个 progress.txt 文件来存储传输进度。每次成功传输一个切片后,我们在文件中记录一个标记。 read_progress 函数用于读取当前完成的切片数量。

通过组合文件切片和进度记录的实现,我们可以实现一个基本的断点续传功能。在实际应用中,还需要考虑异常处理、多线程或异步传输等高级功能以提高性能和用户体验。

7. 运行脚本说明和问题解决( 使用必看.txt )

7.1 脚本安装与部署

7.1.1 Python环境配置

在开始运行脚本之前,确保你的计算机已经安装了Python环境。Python可以从官方网站下载并安装。此外,你可能还需要安装一些额外的库,比如 requests 用于网络请求, threading 用于多线程支持等。可以通过以下命令安装所需的第三方库:

pip install requests

pip install pyyaml

确保所有的依赖都已经安装完毕后,接下来进行脚本的配置。

7.1.2 运行前的准备工作

在运行服务器端( socker_server.py )和客户端( socker_client.py )脚本之前,需要对脚本进行一些配置。通常包括设置服务器地址、端口以及可能的其他参数。以下是一些配置文件的示例:

# server_config.yaml

server_ip: '0.0.0.0'

server_port: 12345

log_level: 'INFO'

# client_config.yaml

server_ip: '192.168.1.100'

server_port: 12345

file_path: '/path/to/large/file'

脚本运行时会根据这些配置文件来初始化服务器或客户端。

7.2 常见问题解析与解决

7.2.1 错误排查与调试

在大文件传输过程中,可能会遇到各种各样的问题,比如连接超时、文件损坏等。问题排查的流程一般如下:

- 查看日志 : Python脚本通常会输出日志信息,根据日志中的错误信息定位问题。

- 网络诊断 : 使用命令如

ping和telnet来测试网络连通性。 - 代码审查 : 对代码逻辑进行仔细审查,确保没有明显的错误。

# 示例:使用日志记录错误

import logging

logging.error('连接服务器时发生错误: %s', error)

7.2.2 性能瓶颈分析

大文件传输时,性能瓶颈可能出现在网络带宽、服务器处理能力或者磁盘I/O上。对性能瓶颈的分析可以使用如下方法:

- 使用工具如

iftop或nethogs来监控网络流量。 - 分析CPU和内存使用情况,例如使用

htop或top。 - 对文件系统进行基准测试,如

bonnie++或fio。

性能瓶颈的分析通常需要结合实际的硬件环境和网络状况进行。

7.2.3 安全性考虑与防范措施

大文件传输时还需要考虑安全性问题。以下是几个常见的安全性考虑和相应的防范措施:

- 数据加密 : 使用SSL/TLS来保证传输过程中的数据安全。

- 身份验证 : 确保只有授权的用户可以连接到服务器进行文件传输。

- 防止DoS攻击 : 对服务器的连接请求进行速率限制和IP白名单配置。

# 示例:使用SSL/TLS加密

import ssl

context = ssl.create_default_context(ssl.Purpose.CLIENT_AUTH)

context.load_cert_chain(certfile="path/to/certfile", keyfile="path/to/keyfile")

请注意,安全性配置是必须要详细审查并根据实际情况来定制的。

请在部署和使用脚本之前,确保已经仔细阅读本章节内容,并按照脚本的配置需求进行了正确的设置。如遇到问题,请参照上述问题排查和解决方法进行处理。

简介:本文介绍如何使用Python实现大文件的高效传输,专注于通过Socket和TCP协议进行数据传输,提供了服务器端和客户端的代码实现。教程详细解释了TCP的可靠性、文件信息处理、性能优化方法如非阻塞I/O、多线程、断点续传,以及如何运行脚本和解决常见问题。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?