Paper link: https://arxiv.org/abs/1703.00573

Blog link: http://www.offconvex.org/2017/03/30/GANs2/

Github: https://github.com/PrincetonML/MIX-plus-GANs

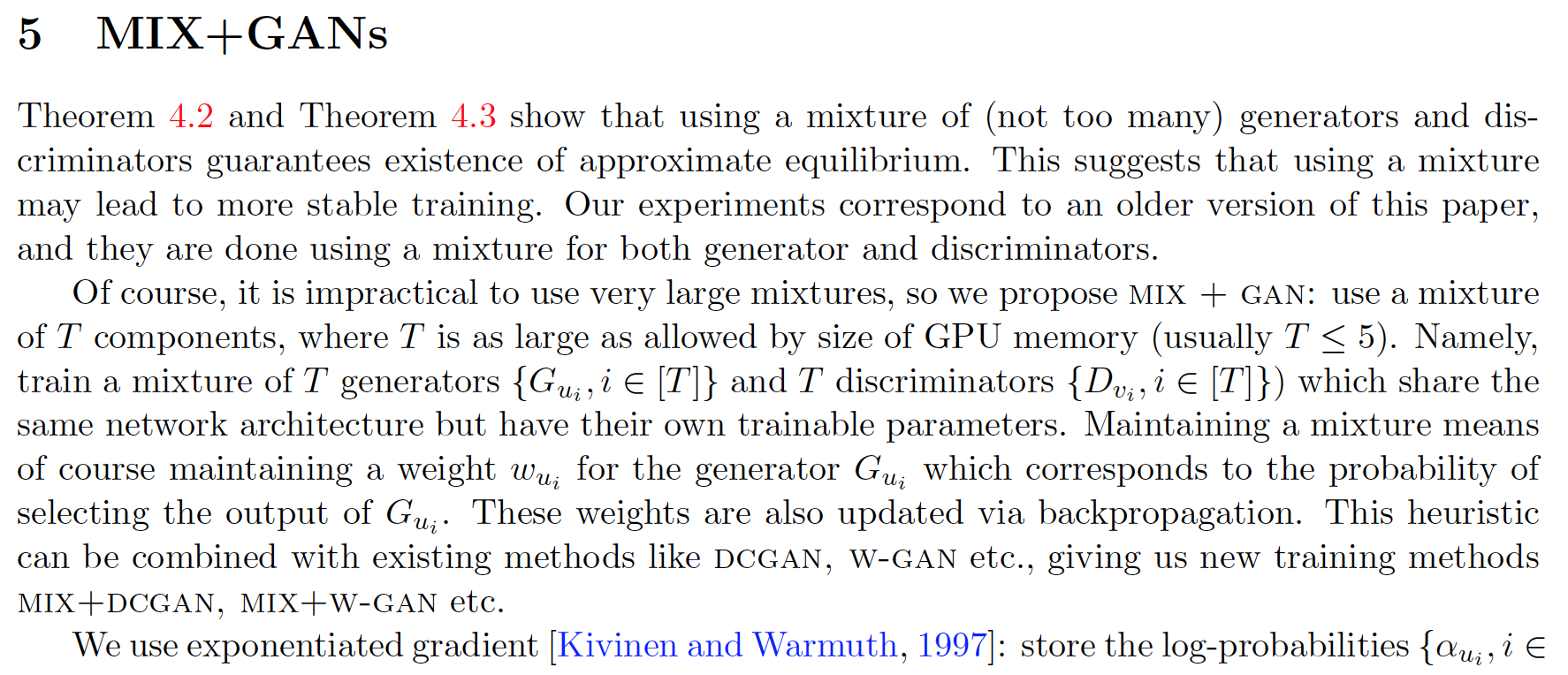

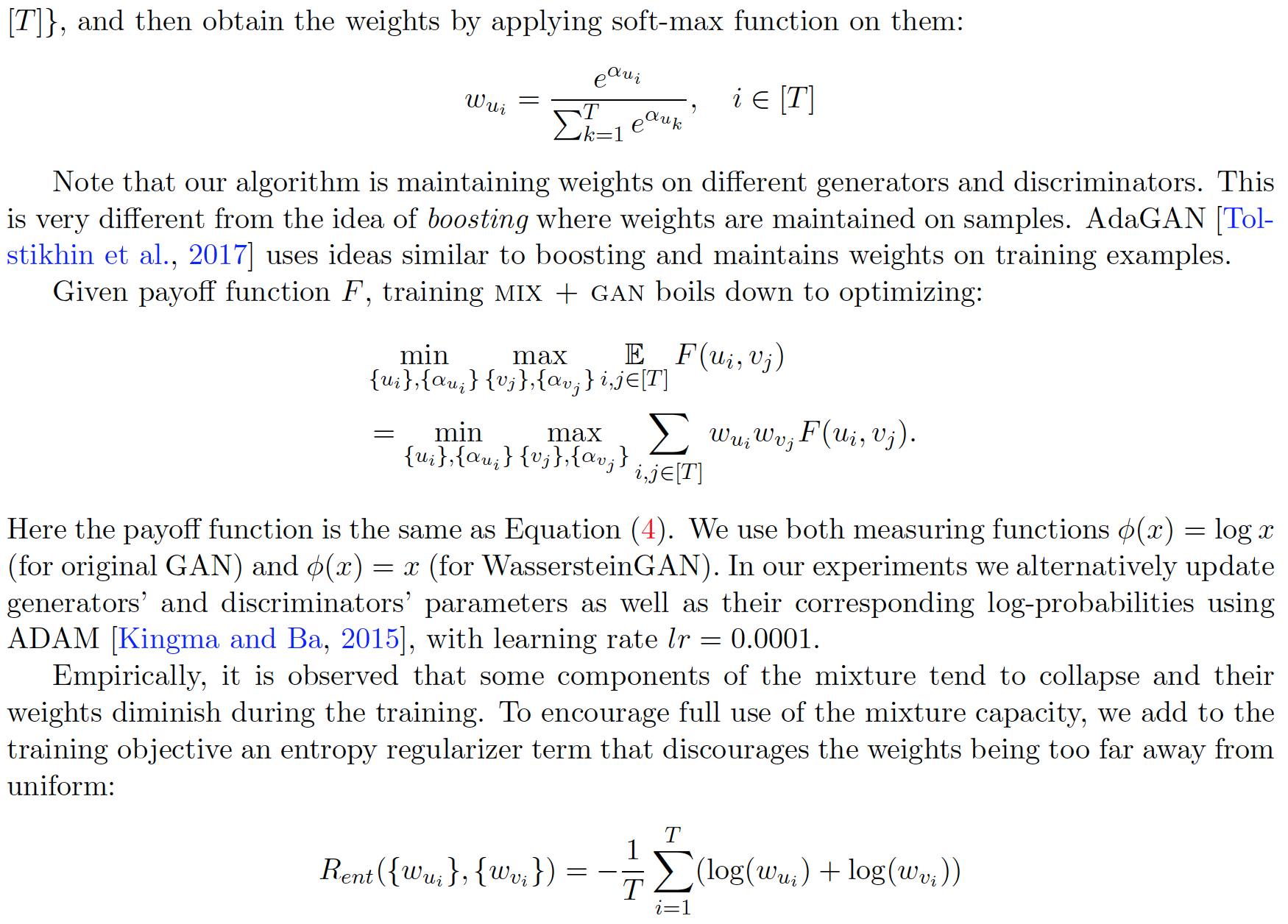

作者指出原先的工作都假设Discriminator有无限的表示能力,但是其实当Discriminator表示能力有限的时候,Generator只需要拟合一部分训练数据就能把损失函数降到比较小的值。这说明扩大训练样本对于训练GAN没有太大的作用,而且Generator的diversity也受到了限制。作者提出了MIX+GAN的模型,一个是增强了Discriminator的能力,一个是让其训练能够收敛到一个波动范围内的均衡点。作者在算法中加入熵正则项,防止混合模型坍缩为单个模型。理论分析很多,但个人感觉实验效果也不是很明显。

本文探讨了在生成对抗网络(GAN)中,当判别器表示能力受限时,生成器仅需拟合部分训练数据即可使损失函数达到较低值的现象。通过引入MIX+GAN模型增强判别器能力,并加入熵正则项来维持模型多样性,从而实现更稳定的训练过程。

本文探讨了在生成对抗网络(GAN)中,当判别器表示能力受限时,生成器仅需拟合部分训练数据即可使损失函数达到较低值的现象。通过引入MIX+GAN模型增强判别器能力,并加入熵正则项来维持模型多样性,从而实现更稳定的训练过程。

977

977

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?