三、可解释性人工智能

我列举了很多不同的研究问题,比如说人工智能的迁移问题、人工智能情感研究方面的问题,还有可解释性人工智能,即我怎么理解这个艺术。我先就可解释性人工智能方面给大家一个引子。

(1)为什么需要可解释性人工智能

我认为其实人工智能和艺术有共同点。比如,你问一个艺术家什么是艺术,他们每个人都有不同的解释;再比如,当看到一幅名画时,我们答不上来它为什么有名,需要专家给我们解释。

类似的,从人工智能角度来讲,很多时候都是以黑匣子的方式,只是用它,但是不知道为什么会这样子。所以从这方面角度来讲,人工智能与艺术现在对于可解释性方面确确实实是一个非常大的难点。

(2)可解释性人工智能为什么重要

打个比方,在医疗AI方面,当我们给医生建造一个预测糖尿病的模型,病人可能不太相信模型,他们会有疑问,为什么我有糖尿病,而另外一个人没有。从这个角度上来讲,可解释性人工智能很重要。

另外就是信任问题。说一个经典的例子,一篇KDD2016有关于LIME算法的文章讲到:其实机器很容易被愚弄。文章中做了一个非常有趣的事情,收集了100张哈士奇的照片,想要机器区分它和狼,狼的照片里面都有雪作为背景,哈士奇照片里是非雪的背景,最后机器认为有雪的地方里面的动物就是狼。这极端地颠覆了我们的常识,也说明了为什么我们需要可解释性的人工智能。

通过可解释人工智能,有可能提高人们对艺术的理解。什么时候、什么样的作品能让人们产生美感,以及知道这个时候我们如何地评价和估价艺术作品,从这些角度来讲,其实可解释性是非常重要的。

(3)可解释性人工智能的方法

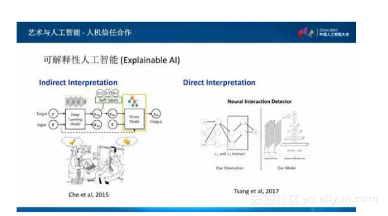

关于可解释性人工智能大概可以分为两种,一种是关于间接解释,利用的办法是解释预测结果,看一看深度网络是怎样做预测的。比如,可以看看在深度学习里面,哪些特征是非常重要的,或者改变一下网络的构造,使它能够解释这个模型。

在间接解释这方面,我的研究成果里运用了模仿学习:主要想法是说我们可以先用一种深度学习的办法,去建一个模型;之后可以通过小数点后面的值,大概判断出它的不同区间的预测。通过这种办法把数据放在简单的模型里面,我们用的是一些决策树的模型,这样的模型比较容易解释,同时又能够模仿,这是非常好的方法。

直接解释方面,有一种神经交互的检测系统,我们可以通过深度学习的模型看一下不同的特征之间是怎么样交互的,通过这种交互就能够得到正确的方程式。这样也能够帮助我们解释。

很多时候大家都在问,十年之后什么工作会被人工智能取代?我认为艺术是最有创作性的工作,它很难被取代。

所以,我认为将来人工智能与艺术的结合主要还是人机信任合作,在提供可解释性、可迁移性、可靠性方面能够进行长足的发展。这样我们能够同时利用机器擅长的方面和人擅长的方面,创作最好的艺术。

(本报告根据速记整理)

本文探讨了可解释性人工智能的重要性,特别是在艺术领域的应用。通过解释AI的决策过程,可以帮助人们更好地理解和评估艺术作品的价值。此外,还介绍了实现可解释性的两种方法:间接解释和直接解释,并强调了这对建立人机信任的重要性。

本文探讨了可解释性人工智能的重要性,特别是在艺术领域的应用。通过解释AI的决策过程,可以帮助人们更好地理解和评估艺术作品的价值。此外,还介绍了实现可解释性的两种方法:间接解释和直接解释,并强调了这对建立人机信任的重要性。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?