CodeMix中的任务与tasks.json

工具(如编译器,链接器和构建系统)用于自动化构建,运行测试和部署等过程。 虽然这些工具通常从IDE外部的命令行执行,但在Tasks支持下,可以在IDE中运行这些进程。 对于执行构建和验证的工具,这些工具报告的问题由CodeMix选取并显示在IDE中。

注意:使用任务不是必需的 - 用户可能不需要创建任务,也不需要手动修改tasks.json文件。 例如,CodeMix自动在Angular和TypeScript项目中创建任务,并将它们与构建管道集成。 强烈建议在继续之前请先阅读CodeMix中的构建管道和验证。

创建tasks.json文件

tasks.json文件必须存在于 /.vscode目录中。 可以手动创建此文件,然后使用内容辅助来帮助添加或编辑任务。

tasks.json用于Angular项目的示例:

使用Gulp为JavaScript项目示例tasks.json

与CodeMix Build Pipeline集成

codemix / lifecycle属性确定CodeMix如何将任务与构建管道集成 - 有关详细信息,请参阅下表。 即使没有生命周期属性,还有其他智能可以自动将某些TypeScript或shell任务集成到构建管道中,但为了清晰起见,建议添加此值。

常见的task.json属性

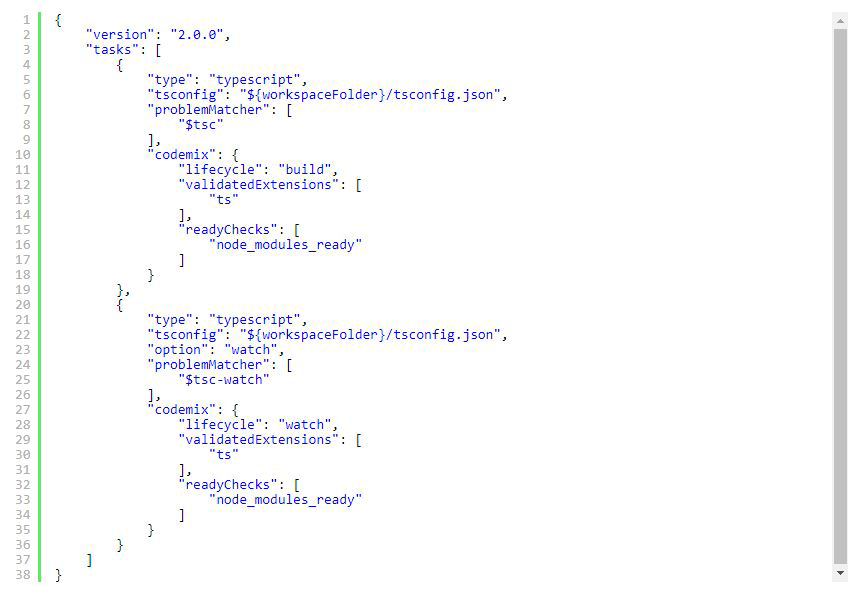

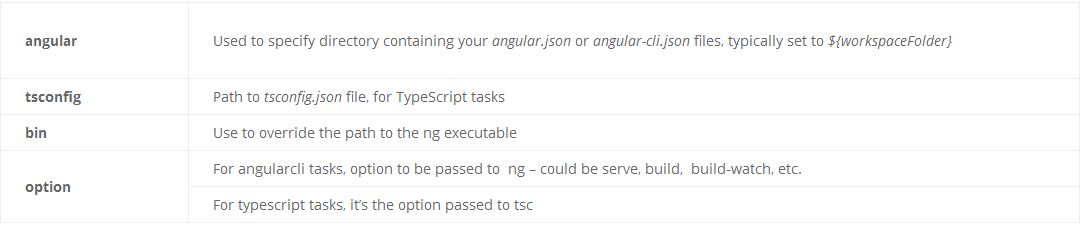

Angular和TypeScript task.json属性

除了上述属性之外,Angular和TypeScript项目还使用其他属性。

运行任务

要从命令选项板运行任务,请按Ctrl / Cmd + Shift + P,选择任务:运行任务命令,然后从显示的列表中选择所需任务。 与构建管道集成的任务通常会自动执行。 有关更多详细信息,请参阅CodeMix中的构建管道和验证。

有关任务的更多信息,请阅读VS Code文档。

本文深入解析了CodeMix中的任务系统与tasks.json文件的使用,阐述了如何在IDE中自动化构建、测试和部署流程,特别关注Angular和TypeScript项目中的任务集成,以及CodeMix如何智能地与构建管道协作。

本文深入解析了CodeMix中的任务系统与tasks.json文件的使用,阐述了如何在IDE中自动化构建、测试和部署流程,特别关注Angular和TypeScript项目中的任务集成,以及CodeMix如何智能地与构建管道协作。

5369

5369

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?