服务器上已经有了 hadoop2.7.2环境,这次只用配置spark1.6就可以。

服务器操作系统为centOS6.5

1、安装Scala

下载地址:http://www.scala-lang.org/download/

注:我下载的是scala-2.11.8.tgz

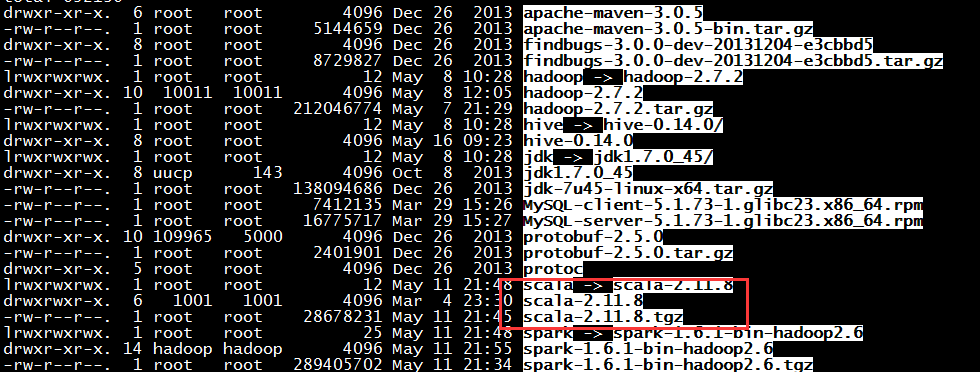

将压缩上传至/usr/local 目录

-

解压缩

tar -zxvf scala-2.11.8.tgz-

做软联接

ln -s scala-2.11.8 scala -

设置环境变量

vim /etc/profile

#追加如下内容

export SCALA_HOME=/usr/scala/scala-2.11.7

export PATH=$PATH:$SCALA_HOME/bin-

使环境变量生效

source /etc/profile-

测试环境变量设置

scala -version2、Spark安装与配置

下载: http://spark.apache.org/downloads.html

下载的版本:spark-1.6.1-bin-hadoop2.6.tgz

将压缩文件上传至/usr/local 目录

- 解压缩

tar -zxvf spark-1.6.1-bin-hadoop2.6.tgz- 做软联接

ln -s spark-1.6.1-bin-hadoop2.6.tgz spark- 设置环境变量

vim /etc/profile

#追加如下内容

export SPARK_HOME=/usr/spark

export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin- 使环境变量生效

source /etc/profile- 测试环境变量设置

spark-shell --version-

配置Spark

- 修改spark-env.sh

cd /usr/local/spark/conf/

cp spark-env.sh.template spark-env.sh

vi spark-env.sh

#追加如下内容

export SCALA_HOME=/usr/local/scala

export JAVA_HOME=/usr/local/jdk

export SPARK_MASTER_IP=192.168.31.213

export SPARK_WORKER_MEMORY=1024m

export HADOOP_CONF_DIR=/usr/local/hadoop/etc/hadoop- 启动Spark

start-all.sh

#停止命令 stop-all.sh -

提交任务到Spark集群

spark-submit --master spark://192.168.31.213:7077 --class 主函数入口 --name 自己起个名称 jar包的全路径

例:spark-submit --master spark://192.168.31.213:7077 --class cn.crxy.dataming.tfidf.TFIDF --name tfidf tfidf.jar - 提交任务到yarn中

spark-submit --master yarn-cluster --class cn.crxy.dataming.tfidf.TFIDF --name tfidf tfidf.jar - 使用web查看任务运行状态 http://192.168.31.213:8088/

本文详细介绍了如何在已配置好的Hadoop2.7.2环境的CentOS6.5服务器上安装和配置Spark1.6。内容包括Scala的安装、Spark的安装与配置步骤,以及环境变量的设置方法。此外还提供了启动Spark集群及提交任务到Spark集群或YARN中的命令示例。

本文详细介绍了如何在已配置好的Hadoop2.7.2环境的CentOS6.5服务器上安装和配置Spark1.6。内容包括Scala的安装、Spark的安装与配置步骤,以及环境变量的设置方法。此外还提供了启动Spark集群及提交任务到Spark集群或YARN中的命令示例。

740

740

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?