前言

神经网络具有很强的学习能力和自适应自组织能力,而且随着隐含层的数量增大学习能力也将变得更强,因此目前很多场景都使用神经网络,比如深度学习,我们更熟悉的就是阿法狗。

关于神经网络

神经网络已经有很多变种,比如卷积神经网络、循环神经网络等等。

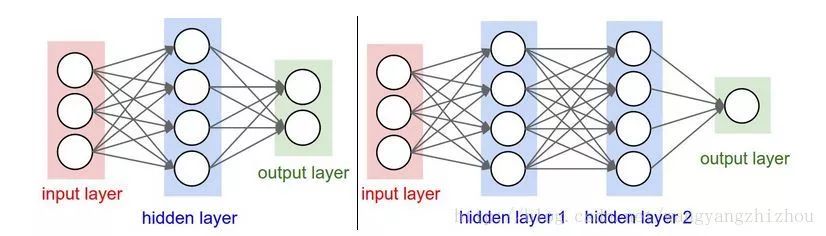

感知器是一种最基础的神经网络,他只有输入层和输出层,感知器只能处理线性可分问题,而对于非线性问题就需要多层神经网络。一般如下图所示,有多个层,比如左边的包含输入层、隐层和输出层,而右边的则包含了两个隐层。每层的神经元与下一神经元全互连,同层之间的神经元不会相连,输入层用于接收输入,经过隐层加工后再到输出层加工并输出。

这里写图片描述

如何训练多层网络

对于多层网络我们常用误差逆传播算法来训练,而我们最常见的BP神经网络指的是使用误差逆传播来训练的多层前馈神经网络。除此之外其他类型的神经网络也可能会用误差逆传播算法来训练。

总的来说,误差逆传播是使用梯度下降法,通过反向传播不断调整神经网络中各个权重从而使输出层的误差平方和最小。

可视化实验

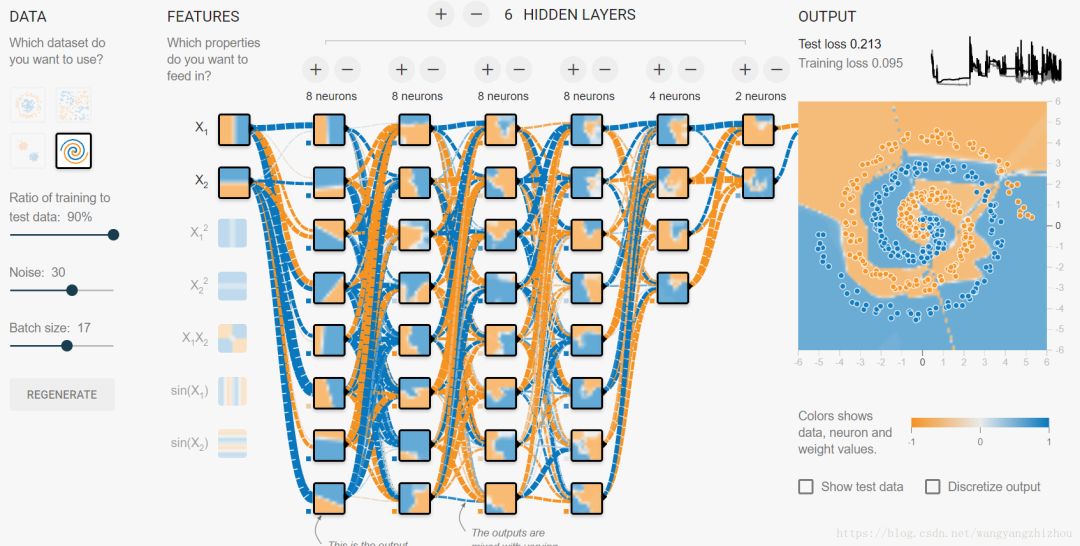

TensorFlow 提供了一个试验演示平台可以让我们通过可视化更好理解神经网络,地址是 https://playground.tensorflow.org 。

下面两种较简单的分类模型,图中可以看到通过训练后能将两个类别区分开。输入特征我们选择x1和x2,共有两层隐含层,分别有4个神经元和2个神经元。

如果我们的数据集是比较复杂的,则需要更多隐含层,比如下面,

这个过程中还可以看到每层每个神经元的输出输入,另外还可以自己控制一步步训练,通过这个实验平台能帮助初学者理解神经网络的原理及过程,可以玩玩。

当真正开始学习的时候难免不知道从哪入手,导致效率低下影响继续学习的信心。(学习交流加我微信 bbbl12138)

但最重要的是不知道哪些技术需要重点掌握,学习时频繁踩坑,最终浪费大量时间,所以有有效资源还是很有必要的。

447

447

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?