简介:FFmpeg在Android平台为开发者提供强大的音视频处理能力,涵盖编解码、容器格式解析、软硬解码切换、音频重采样和视频转换等关键功能。本项目介绍如何集成FFmpeg到Android应用,包括编译库、解封装、解码、硬解支持、音频重采样、视频转换和测试代码的使用,为音视频应用开发提供完整流程的实践指南。

1. Android平台上FFmpeg的应用和重要性

1.1 FFmpeg在Android中的应用概述

FFmpeg是一个非常强大的多媒体处理框架,广泛应用于音视频的转码、流媒体处理和各种多媒体数据的封装解封装等任务。在Android平台上,FFmpeg更是扮演了核心角色,尤其是在开发需要处理音视频流的应用时,例如直播、视频播放器等。利用FFmpeg,开发者能够以较少的代码实现复杂的多媒体处理功能,提高开发效率,同时保证处理性能。

1.2 FFmpeg的重要性

在移动设备上,资源有限,处理音视频文件需要非常高效的算法和优化。FFmpeg由于其高度优化的代码和丰富的编解码器支持,成为移动多媒体应用开发的首选。它支持几乎所有的音视频格式和编解码器,以及流媒体协议,为开发者提供了极大的灵活性和可能性。无论是在性能优化、功能扩展还是在兼容性方面,FFmpeg都显示出了其不可替代的重要性。

1.3 Android开发者如何从FFmpeg中受益

对于Android开发者来说,将FFmpeg集成到应用中可以大大简化多媒体处理的复杂性。开发者可以不直接与底层的多媒体数据打交道,而是通过FFmpeg提供的丰富API,快速实现音视频的录制、编辑、编码、解码以及转换等功能。此外,FFmpeg的高度可定制化也意味着开发者可以根据应用需求裁剪库大小,优化性能,满足不同场景下的需求,这对于资源有限的移动设备来说,至关重要。

2. FFmpeg库在Android上的集成流程

2.1 FFmpeg库的准备工作和环境搭建

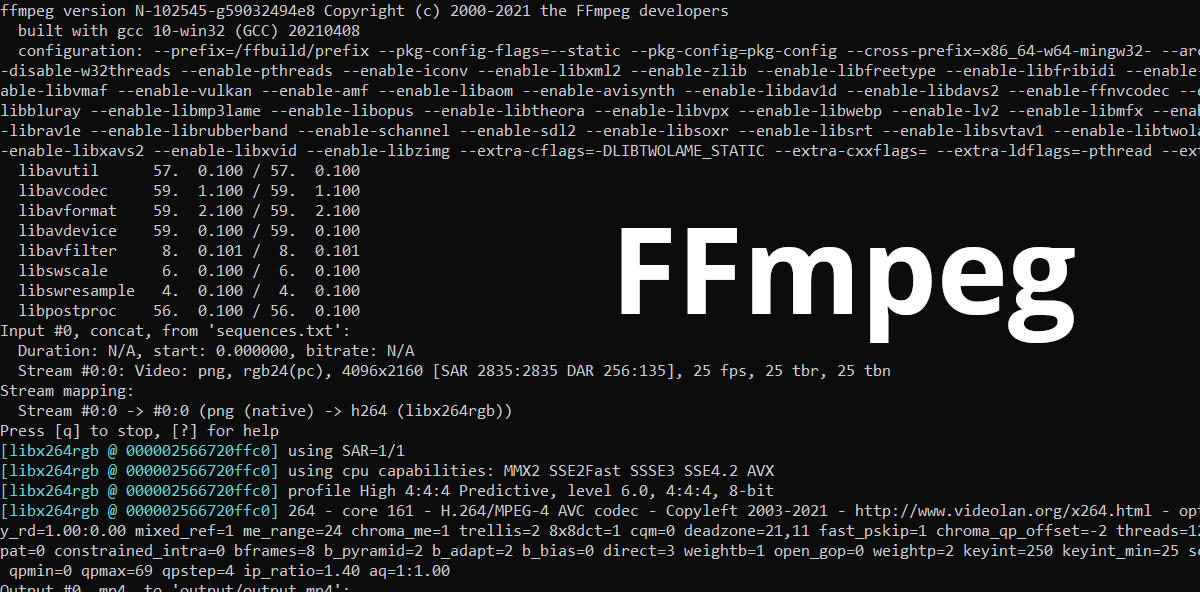

2.1.1 下载和编译FFmpeg库

在开始集成FFmpeg库到Android项目之前,开发者首先需要下载FFmpeg的源码并进行编译。FFmpeg是一个非常强大的开源多媒体处理框架,支持广泛的音视频格式,通过其提供的命令行工具可以轻松地完成多媒体文件的转码、复用和解码等操作。

下载FFmpeg源码可以通过官方网站或者使用Git版本控制系统克隆最新版本。以下是克隆最新稳定版FFmpeg源码的Git命令:

git clone --depth 1 git://***/ffmpeg.git ffmpeg

克隆完毕后,开发者需要根据Android平台的需求进行编译。编译FFmpeg通常需要使用交叉编译工具链。这里我们使用 ndk-build 命令行工具进行编译。具体步骤如下:

- 确保Android NDK环境已经搭建完毕,可以通过Android Studio中的SDK Manager进行安装。

- 进入FFmpeg源码目录,创建用于存放编译产物的目录。

mkdir android-ffmpeg

cd android-ffmpeg

- 使用

ndk-build进行编译:

ndk-build

执行完上述命令后,将生成对应的 .so 文件,这些动态库文件可以被集成到Android项目中。

2.1.2 配置Android开发环境

在集成FFmpeg到Android项目之前,需要对Android开发环境进行适当的配置,以确保可以顺利使用FFmpeg库。以下是配置开发环境的主要步骤:

- 安装Android Studio,这是官方推荐的Android开发IDE,提供了良好的代码编辑和调试功能。

- 配置Android SDK,安装对应版本的系统镜像,以便能够模拟不同版本的Android系统。

- 设置环境变量,确保编译工具链(如

ndk-build)能够被命令行识别。 - 在Android Studio中创建新的Android项目,或者打开现有的项目进行后续步骤。

开发者需要在项目的 build.gradle 文件中添加FFmpeg的.so库文件,配置如下:

android {

// ...

sourceSets {

main {

jniLibs.srcDirs = ['src/main/libs']

}

}

// ...

}

同时,在项目的 build.gradle 中还需要配置CMake或ndk-build,以便能够处理C/C++源码。由于这里我们使用的是通过ndk-build编译得到的.so文件,因此不需要添加额外的CMake配置。

2.2 FFmpeg库的集成方法

2.2.1 集成FFmpeg库到Android项目

在成功编译并准备好了FFmpeg的动态库文件后,就需要将这些库文件集成到Android项目中。这一过程主要分为以下几个步骤:

- 将

.so文件复制到Android项目的src/main/jniLibs/<ABI>目录下,其中<ABI>指特定的CPU架构,如armeabi-v7a、arm64-v8a等。 - 在项目中声明native方法,以便能够在Java代码中调用FFmpeg的API。这通常通过JNI(Java Native Interface)完成。

- 编写C/C++代码,加载FFmpeg库,并在其中声明需要调用的FFmpeg功能函数。

示例代码片段如下:

extern "C" {

#include <libavformat/avformat.h>

}

JNIEXPORT void JNICALL

Java_com_example_myffmpegapp_MainActivity_loadFFmpegLibrary(JNIEnv *env, jobject thiz) {

av_register_all();

// 在此处可以调用FFmpeg的其他函数

}

在Java代码中,需要声明native方法,并加载对应的.so文件:

public class MainActivity extends AppCompatActivity {

static {

System.loadLibrary("ffmpeg"); // 确保加载的库名称与.so文件匹配

}

// 声明native方法

public native void loadFFmpegLibrary();

@Override

protected void onCreate(Bundle savedInstanceState) {

super.onCreate(savedInstanceState);

setContentView(R.layout.activity_main);

// 调用native方法加载FFmpeg库

loadFFmpegLibrary();

}

}

2.2.2 配置和优化FFmpeg库

集成FFmpeg库到Android项目后,开发者还需要进行一些配置和优化以确保库的正确使用和项目的性能优化。

-

库配置优化 :在

build.gradle中可以配置abiFilters来指定支持的CPU架构,避免将不必要架构的库文件打包到APK中,从而减小APK的体积。gradle android { defaultConfig { ndk { abiFilters 'armeabi-v7a', 'arm64-v8a', 'x86', 'x86_64' } } } -

性能优化 :在代码中可以通过调整FFmpeg的编解码参数来优化性能,比如线程数、缓冲大小等。这些参数的设置需要根据实际应用场景来决定。

cpp av_dict_set(&options, "threads", "4", 0); // 设置线程数为4 -

资源管理 :合理管理FFmpeg的资源使用,比如在适当的时候释放解码器、解复用器等资源,避免内存泄漏。

-

错误处理 :编写详细的错误日志,以便在出现问题时能够快速定位问题所在。FFmpeg提供了丰富的错误代码信息,这些信息对问题的诊断非常有帮助。

2.3 FFmpeg库的调试和优化

2.3.1 常见问题及解决方式

在使用FFmpeg进行多媒体处理时,开发者可能会遇到一些常见的问题。以下是一些问题的描述和解决方案:

- 库文件不兼容 :确保所使用的FFmpeg版本与Android项目的编译环境相兼容。使用

ndk-build时,对应的NDK版本需要与FFmpeg源码支持的版本相匹配。 - 权限问题 :处理音视频文件可能需要读写存储的权限,确保在AndroidManifest.xml中添加了必要的权限声明。

- 编解码错误 :检查FFmpeg版本与处理的媒体格式是否匹配,确保库文件没有损坏且支持相应的编解码器。

2.3.2 性能优化方法

性能优化是集成FFmpeg到Android项目中不可或缺的一步。以下是一些优化方法:

- 多线程编解码 :FFmpeg支持多线程编解码,合理设置线程数可以提升编解码的效率。

- 缓冲区管理 :调整缓冲区大小,避免不必要的内存分配和释放,减少内存消耗。

- CPU亲和性 :设置CPU亲和性可以让FFmpeg运行在特定的CPU核心上,减少上下文切换,提升性能。

- 异步处理 :在可能的情况下,使用异步处理来避免界面阻塞。

// 示例:设置多线程编解码

av_dict_set(&options, "thread_type", "slice", 0);

在优化过程中,开发者需要不断地测试、分析性能瓶颈,并应用相应的优化策略。同时,考虑到不同Android设备的性能差异,优化策略可能需要在多个设备上进行验证。

以上章节详尽地介绍了FFmpeg库在Android上集成的准备工作、集成方法、调试与优化。通过细致的步骤讲解和代码示例,确保读者能够清楚地了解FFmpeg的集成流程,并能够根据自身项目的实际需求进行适当的调整。

3. 多媒体容器格式的解析方法

3.1 容器格式的基本概念和分类

3.1.1 容器格式的定义和作用

在数字多媒体领域,容器格式(也称为封装格式)扮演着重要角色。容器格式定义了一种数据结构,用于存储和传输音视频内容、字幕、元数据等多媒体数据。它不涉及内容的压缩算法,只规定了如何将这些数据打包在一起。容器格式的作用就像是一个文件夹,它将不同类型的文件(音频、视频、字幕等)组织在一起,使它们可以在不同的设备和应用上顺利地播放和传输。

一个多媒体容器格式的例子是MP4,它是一种广泛使用的格式,用于存储音频和视频流。它不仅能够存储压缩后的数据,还可以嵌入诸如封面图片、标题、章节标记等元数据。

3.1.2 常见的多媒体容器格式

多媒体容器格式多种多样,每种都有其特点和适用场景。以下是几种常见的多媒体容器格式:

- MP4 (MPEG-4 Part 14) : 非常通用的格式,广泛用于互联网视频流和数字电视。

- MKV (Matroska) : 功能强大的开源格式,支持多种音视频编码和字幕。

- AVI (Audio Video Interleave) : 微软开发的早期格式,兼容性好,但较老旧。

- FLV (Flash Video) : 主要用于Adobe Flash Player的视频播放,但随着Flash的淘汰,其使用率下降。

- WebM : 开源且免版税,主要由Google支持,专为Web设计。

3.2 容器格式的解析方法

3.2.1 使用FFmpeg解析容器格式

使用FFmpeg解析容器格式是相对简单的过程。FFmpeg内置了对主流多媒体容器格式的支持,通过其提供的命令行工具和API,用户可以轻松地读取和处理多媒体文件。

解析过程主要涉及FFmpeg的 ffmpeg 命令行工具,通过指定输入文件和选择适当的命令参数来提取容器内的数据。例如,要读取MP4文件中的视频流,可以使用以下命令:

ffmpeg -i input.mp4 -vn -acodec copy output.aac

这个命令会从 input.mp4 文件中提取音频流,并将其转换为AAC格式输出到 output.aac 文件中。参数 -i 用于指定输入文件, -vn 表示不处理视频流, -acodec copy 表示不重新编码音频流,直接复制。

3.2.2 容器格式解析的实例和解析

为了详细展示解析过程,我们将以解析一个MKV文件为例。假设我们有文件 example.mkv ,我们想要提取其中的视频流和音频流。首先,我们使用FFmpeg命令来获取流信息:

ffmpeg -i example.mkv

执行上述命令后,FFmpeg会输出该MKV文件中包含的所有流的信息,通常包括视频、音频和字幕的编码格式和语言。得到流信息后,我们可以选择需要提取的流进行操作。比如,提取视频流和英语音频流,可以使用如下命令:

ffmpeg -i example.mkv -map 0:v:0 -map 0:a:1 -c copy output.mp4

这个命令中, -map 参数用于指定要复制的流。 0:v:0 表示第一个视频流, 0:a:1 表示第二个音频流(通常第一个是主音频,第二个可能是评论或其他语言)。 -c copy 表示采用直接复制的方式,不进行转码处理,这样可以保持原始质量并提高处理速度。

通过以上步骤,我们不仅了解了如何使用FFmpeg解析容器格式,还学习了如何利用命令行工具输出容器内部的信息,以及如何提取特定的流。对于更复杂的任务,FFmpeg还提供了丰富的API用于编程,可以实现更加定制化的解决方案。

4. 音视频数据的解码过程

4.1 音视频解码的基本概念和流程

4.1.1 解码的概念和重要性

解码是将压缩过的音视频数据还原为原始数据格式的过程。在数字媒体播放过程中,解码显得尤为重要,因为数字视频和音频通常在传输和存储时进行压缩以减少所需的存储空间和传输带宽。压缩后的数据需要通过解码过程转换为可被播放设备或软件所理解的格式。

4.1.2 解码的基本流程

音视频解码通常涉及以下几个步骤:

- 读取编码数据 :从存储或网络流中获取压缩的音视频数据包。

- 同步音频与视频数据 :由于音视频可能被分别编码,解码过程需要确保两者同步播放。

- 解压缩数据 :对获取的数据包应用相应的解压缩算法恢复为原始的音视频数据。

- 格式转换 :将解压缩后的数据转换成播放器可以处理的格式,如将YUV格式转换为RGB格式以显示视频。

- 输出音视频数据 :将格式化后的数据输出到音频系统或视频输出设备。

4.2 音视频解码的实现方法

4.2.1 使用FFmpeg进行音视频解码

FFmpeg是一个强大的多媒体框架,用于处理音视频数据的编码、解码、转码和流媒体。使用FFmpeg进行音视频解码通常涉及到以下几个步骤:

- 初始化FFmpeg解码器 :为音视频数据选择合适的解码器,并初始化解码器上下文。

- 数据包的解码 :将压缩的音视频数据包送入解码器进行解码。

- 数据包和帧的处理 :处理解码器输出的数据帧,包括必要的数据格式转换和同步。

- 资源清理 :解码完成后,清理解码器上下文等资源。

下面是一个使用FFmpeg进行音视频解码的代码示例:

AVFormatContext *pFormatCtx = NULL;

AVCodecContext *pCodecCtx = NULL;

AVCodec *pCodec = NULL;

AVFrame *pFrame = NULL;

AVPacket packet;

int video_stream_index = -1;

// 打开输入文件

if (avformat_open_input(&pFormatCtx, filename, NULL, NULL) != 0)

return -1; // Couldn't open file

// 检索流信息

if (avformat_find_stream_info(pFormatCtx, NULL) < 0)

return -1; // Couldn't find stream information

// 查找视频流

if ((video_stream_index = av_find_best_stream(pFormatCtx, AVMEDIA_TYPE_VIDEO, -1, -1, &pCodec, 0)) < 0)

return -1; // Didn't find a video stream

// 获取视频流的解码器上下文

pCodecCtx = pFormatCtx->streams[video_stream_index]->codec;

pCodec = avcodec_find_decoder(pCodecCtx->codec_id);

// 打开解码器

if (avcodec_open2(pCodecCtx, pCodec, NULL) < 0)

return -1; // Could not open codec

while (av_read_frame(pFormatCtx, &packet) >= 0) {

if (packet.stream_index == video_stream_index) {

// 解码视频帧

avcodec_decode_video2(pCodecCtx, pFrame, &frameFinished, &packet);

if (frameFinished) {

// 处理解码后的视频帧

// ...

}

}

av_packet_unref(&packet);

}

// 清理

avcodec_close(pCodecCtx);

avformat_close_input(&pFormatCtx);

av_frame_free(&pFrame);

4.2.2 音视频解码的实例和解析

上述代码示例展示了一个基本的音视频解码流程,其中涉及到的关键点包括:

- AVFormatContext :用于存储流媒体文件的格式信息。

- AVCodecContext :表示编解码器的上下文信息。

- AVCodec :指向实际编解码器的指针。

- AVFrame :用于保存解码后的视频帧数据。

代码中使用 avformat_open_input 来打开输入文件, av_find_best_stream 来查找视频流, avcodec_find_decoder 选择合适的解码器,以及 avcodec_decode_video2 进行视频解码。需要注意的是,在实际应用中,解码后需要处理的不仅有视频帧,还可能有音频帧,因此需要同时处理音频流。

在实际应用中,可能还需要考虑到错误处理、日志记录、性能优化等问题,这些都需要在使用FFmpeg库进行音视频解码时进行额外的处理。

5. 软硬解码的实现和优化

5.1 软硬解码的基本概念和区别

5.1.1 软解码和硬解码的概念和区别

在处理多媒体数据时,解码是将压缩的音视频数据还原为可播放格式的关键步骤。解码的实现方式主要分为软解码和硬解码。

软解码依赖于CPU来处理解码任务,即通过软件程序来实现解码算法。这种方法的灵活性很高,可以处理各种不同的编码格式,并且通常不需要额外的硬件支持。然而,软解码对CPU的计算能力要求较高,可能会消耗大量系统资源,从而影响设备的其他操作和性能。

硬解码则是利用专门的硬件解码器进行解码处理,例如GPU、DSP或专用的视频解码器芯片。这类解码方式的优势在于效率高,且对CPU资源占用较少,有助于提升整体的播放性能,尤其是在移动设备上。不足之处在于硬件解码器通常支持的编解码格式有限,并且在不同设备之间可能存在兼容性问题。

5.1.2 软硬解码的应用场景和选择

软硬解码各有优势和局限,因此选择哪一种解码方式,通常取决于实际的应用需求、设备特性以及特定场景。

- 对于支持多种编解码格式的需求,或者在没有硬件解码器支持的设备上,软解码是必须的选择。

- 如果对播放性能有较高要求,且设备具备高效的硬件解码器,那么硬解码将是一个更佳的选择。

- 在资源受限的环境下,如移动设备,硬件解码器因其高效率而受到青睐。

5.2 软硬解码的实现方法和优化

5.2.1 使用FFmpeg实现软硬解码

FFmpeg作为一个强大的多媒体处理框架,支持软解码和硬解码的实现。其通过不同的解码器(Decoder)来支持不同的解码方式,其中硬件解码器通常以特定的库形式存在,例如在Android上广泛使用的 libstagefright (已废弃)、 OpenMAX 或 MediaCodec API。

在使用FFmpeg进行软硬解码时,需要指定对应的解码器名称,例如使用 -vcodec 参数来指定软解码器或硬解码器。例如,硬解码可能需要指定 h264_mediacodec ,而软解码可能使用 libx264 。

# 使用硬件解码器进行解码

ffmpeg -i input.mp4 -c:v h264_mediacodec output.mp4

# 使用软件解码器进行解码

ffmpeg -i input.mp4 -c:v libx264 output.mp4

5.2.2 软硬解码的优化方法和实例

在选择使用软硬解码后,优化解码性能和质量也是一个重要的环节。以下是一些常见的优化方法:

- 线程优化 :利用多线程对解码任务进行分解,可以提高解码效率,尤其是在软解码场景中。

- 缓冲区管理 :合理管理输入和输出缓冲区可以减少等待时间,提升解码流程的平滑性。

- 硬件加速 :对于硬件解码,确保硬件加速被启用,可以使用

-hwaccel参数。 - 性能分析 :使用FFmpeg内置的性能分析工具,如

-stats参数,可以帮助开发者了解解码过程中的性能瓶颈。

# 开启硬件加速

ffmpeg -i input.mp4 -c:v h264_mediacodec -hwaccel vaapi output.mp4

具体的优化实例通常需要针对不同的设备和编解码格式进行调整。例如,在使用 MediaCodec API时,可以调整缓冲区大小、帧率等参数以达到最优的解码效果。

在实践中,开发者可以根据应用需求、目标平台的性能特点,以及用户设备的实际能力,灵活运用以上优化方法,以实现软硬解码的最佳效果。

6. 音频重采样技术

音频重采样是数字信号处理中的一个常见需求,尤其是在进行不同格式音频流的转换或者音质改善时。在Android平台上,通过FFmpeg库可以非常方便地实现音频的重采样。

6.1 音频重采样的基本概念和技术原理

6.1.1 音频重采样的定义和意义

音频重采样是指将音频数据从一个采样率转换到另一个采样率的过程。这一技术在数字音频领域非常重要,因为不同的播放设备可能支持的采样率不同。例如,CD的标准采样率为44.1kHz,而一些专业音频设备可能使用48kHz或更高。通过音频重采样,可以在不同的播放环境中保持音频质量的一致性。

音频重采样不仅可以转换采样率,还可以用于处理音频流的其他属性,如通道数(从立体声转换为单声道,或者相反)和采样格式(如从8位无符号转换为16位有符号)。这种技术在处理不同格式的音频文件和流媒体时至关重要。

6.1.2 音频重采样的技术原理和方法

音频重采样的技术原理基于奈奎斯特采样定理,该定理指出,为了避免混叠现象,采样率应至少为信号中最高频率成分的两倍。在实际操作中,音频重采样需要考虑插值算法和滤波器设计,以确保转换过程中音频质量不会出现显著下降。

常见的音频重采样方法包括线性插值、多项式插值和最优化滤波器等。其中,最优化滤波器方法能提供最高的音频质量,但计算复杂度也相对较高。FFmpeg中使用的是高效的滤波器和插值算法,可以平衡性能和音频质量。

6.2 音频重采样的实现和优化

6.2.1 使用FFmpeg实现音频重采样

在Android平台上,使用FFmpeg进行音频重采样,首先需要了解其API的使用方法。以下是一个简单的代码示例,展示了如何使用FFmpeg API进行音频重采样:

#include <libswresample/swresample.h>

// 初始化SwrContext

SwrContext *init_swr_context(int src_rate, int src_format, int src_ch_layout, int dst_rate, int dst_format, int dst_ch_layout) {

SwrContext *ctx = swr_alloc();

av_opt_set_int(ctx, "in_channel_count", av_get_channel_layout_nb_channels(src_ch_layout), 0);

av_opt_set_int(ctx, "out_channel_count", av_get_channel_layout_nb_channels(dst_ch_layout), 0);

av_opt_set_int(ctx, "in_sample_rate", src_rate, 0);

av_opt_set_int(ctx, "out_sample_rate", dst_rate, 0);

av_opt_set_sample_fmt(ctx, "in_sample_fmt", src_format, 0);

av_opt_set_sample_fmt(ctx, "out_sample_fmt", dst_format, 0);

if (swr_init(ctx) < 0) {

fprintf(stderr, "Failed to initialize the re-sampling context\n");

return NULL;

}

return ctx;

}

// 重采样处理函数

void resample_audio(AVFrame *frame, SwrContext *swr_ctx, int dst_rate, int dst_format, int dst_ch_layout) {

uint8_t *out_buffer = av_malloc(frame->nb_samples * av_get_bytes_per_sample(dst_format) * av_get_channel_layout_nb_channels(dst_ch_layout));

av_frame_get_buffer(frame, 0);

int out_count = swr_convert(swr_ctx, &out_buffer, frame->nb_samples, (const uint8_t **)frame->extended_data, frame->nb_samples);

if (out_count < 0) {

fprintf(stderr, "Error while converting\n");

return;

}

// 处理重采样后的数据

// ...

}

在这个示例中,首先通过 init_swr_context 函数初始化 SwrContext ,然后在 resample_audio 函数中,使用这个上下文进行实际的重采样操作。需要注意的是,这段代码需要与FFmpeg库一起编译,并且需要根据实际情况调整输入输出参数。

6.2.2 音频重采样的优化方法和实例

音频重采样的优化可以从多个维度进行,如内存使用效率、CPU使用率和算法复杂度。为了优化内存使用,可以使用固定大小的缓冲区来存储重采样后的数据。CPU使用率可以通过选择更高效的算法(例如使用Intel的IPP库)来降低。算法复杂度的优化往往涉及到更高级的数学方法和硬件加速。

FFmpeg支持多种音频重采样优化算法,开发者可以针对不同的应用场景选择合适的算法。例如,对于移动设备,可以使用FFmpeg的硬件加速功能,或者选择耗电较少的算法以延长设备使用时间。

下面是一个实际的重采样优化案例,展示了如何在Android应用中集成FFmpeg来实现音频重采样,并针对移动设备进行性能优化:

// Java层的封装方法,调用底层FFmpeg重采样实现

public byte[] resampleAudio(byte[] inputBytes, int inputRate, int inputChannels, int inputFormat, int outputRate, int outputChannels, int outputFormat) {

// 1. 将输入字节数据转换为AVFrame

AVFrame inputFrame = convertBytesToAVFrame(inputBytes, inputRate, inputChannels, inputFormat);

// 2. 初始化SwrContext

SwrContext swrCtx = initSwrContext(inputRate, inputChannels, inputFormat, outputRate, outputChannels, outputFormat);

// 3. 执行重采样并获取输出字节

byte[] outputBytes = resampleData(inputFrame, swrCtx);

// 4. 清理资源

av_frame_free(&inputFrame);

swr_free(&swrCtx);

return outputBytes;

}

这个方法结合了前面提到的C层代码,以及在Android平台上的Java层封装。它演示了如何将输入的音频数据转换为AVFrame,进行重采样,并将结果转换回Java层可处理的字节数据。优化措施包括内存缓冲区的管理、错误处理和资源清理。通过这样的封装,Android开发者可以轻松地将音频重采样功能集成到他们的应用程序中。

通过上述的实现和优化,可以在Android设备上高效地进行音频重采样处理,提高应用的性能和用户体验。

7. 视频转换及其处理

7.1 视频转换的基本概念和技术原理

7.1.1 视频转换的定义和意义

视频转换是将一种视频格式转换为另一种视频格式的过程。在Android平台上,视频转换的应用场景非常广泛,例如,在线视频播放器需要将多种格式的视频转换为统一格式进行播放,或者用户想要在个人设备上将下载的视频转换为适合自己设备播放的格式等。视频转换的意义在于它可以打破视频格式的限制,为用户提供更好的观看体验。

7.1.2 视频转换的技术原理和方法

视频转换技术原理是通过读取原始视频文件中的视频和音频数据流,然后按照目标格式重新编码。转换过程中可能涉及解码、过滤和重新编码等步骤。其中,解码是将压缩的视频数据转换为未压缩的帧数据;过滤可以进行如帧速率调整、分辨率调整等处理;重新编码则是将处理后的帧数据编码为目标格式。

视频转换的方法主要有以下几种: - 使用内置的多媒体框架API进行转换。 - 使用FFmpeg库进行转换。 - 结合其他库如X264或GPU加速API进行优化。

7.2 视频转换的实现和优化

7.2.1 使用FFmpeg实现视频转换

使用FFmpeg实现视频转换是目前最普遍和有效的方法。以下是通过FFmpeg实现视频转换的基本命令行示例:

ffmpeg -i input.mp4 -c:v libx264 -c:a aac -b:v 1M -b:a 128k output.mp4

在这个命令中: - -i input.mp4 指定输入文件。 - -c:v libx264 指定视频编码器为H.264。 - -c:a aac 指定音频编码器为AAC。 - -b:v 1M 设置视频比特率为1 Mbps。 - -b:a 128k 设置音频比特率为128 kbps。 - output.mp4 指定输出文件。

7.2.2 视频转换的优化方法和实例

视频转换过程中的优化方法主要包括: - 选择合适的编码器,如使用libx264进行高效视频编码。 - 并行处理多个视频流,减少转换时间。 - 优化编码设置,如调整关键帧间隔来平衡文件大小和质量。

以下是一个使用FFmpeg对视频进行转码并优化的高级示例,同时展示了如何提高转换速度并保持输出视频质量:

ffmpeg -i input.mp4 -c:v libx264 -preset fast -x264-params no-scenecut -c:a copy output.mp4

在这个命令中,使用 -preset fast 参数快速编码视频, -x264-params no-scenecut 参数告诉x264编码器不要在场景变化时插入关键帧,这可以提高编码速度。 -c:a copy 表示直接复制音频流,不需要重新编码,节省时间且不损失音频质量。

需要注意的是,转码过程对CPU和内存的要求较高,特别是在处理高分辨率视频或开启硬件加速时,更需要充足的系统资源。因此,在进行视频转换时,优化参数选择尤为重要。在实际应用中,应根据需要转换视频的具体情况选择合适的优化策略。

简介:FFmpeg在Android平台为开发者提供强大的音视频处理能力,涵盖编解码、容器格式解析、软硬解码切换、音频重采样和视频转换等关键功能。本项目介绍如何集成FFmpeg到Android应用,包括编译库、解封装、解码、硬解支持、音频重采样、视频转换和测试代码的使用,为音视频应用开发提供完整流程的实践指南。

1979

1979

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?