使用Pytorch框架进行深度学习任务,特别是分类任务时,经常会用到如下:

import torch.nn as nn

criterion = nn.CrossEntropyLoss().cuda()

loss = criterion(output, target)

即使用torch.nn.CrossEntropyLoss()作为损失函数。

那nn.CrossEntropyLoss()内部到底是啥??

nn.CrossEntropyLoss()是torch.nn中包装好的一个类,对应torch.nn.functional中的cross_entropy。

此外,nn.CrossEntropyLoss()是nn.logSoftmax()和nn.NLLLoss()的整合(将两者结合到一个类中)。

nn.logSoftmax()

定义如下:

从公式看,其实就是先softmax在log。

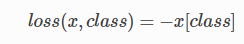

nn.NLLLoss()

定义如下:

此loss期望的target是类别的索引 (0 to N-1, where N &#

本文详细解析了Pytorch中的CrossEntropyLoss函数,包括其内部实现原理,如何整合nn.LogSoftmax()和nn.NLLLoss()。同时,通过实例展示了如何处理one-hot编码的target,以及CrossEntropyLoss与nn.LogSoftmax()+nn.NLLLoss()计算结果的等价性。文章还补充了torch.nn和torch.nn.functional中相关函数的对应关系。

本文详细解析了Pytorch中的CrossEntropyLoss函数,包括其内部实现原理,如何整合nn.LogSoftmax()和nn.NLLLoss()。同时,通过实例展示了如何处理one-hot编码的target,以及CrossEntropyLoss与nn.LogSoftmax()+nn.NLLLoss()计算结果的等价性。文章还补充了torch.nn和torch.nn.functional中相关函数的对应关系。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?