LangFlow企业内训课程设计助手

在企业加速推进AI落地的今天,一个现实问题日益凸显:如何让非技术背景的员工也能真正“动手”参与大模型应用的设计与实验?许多公司组织了多轮AI培训,但学员往往止步于听懂概念,一旦涉及代码实践便望而却步。环境配置失败、依赖包冲突、API调用错误……这些技术门槛让原本充满期待的学习过程变成一场“调试噩梦”。

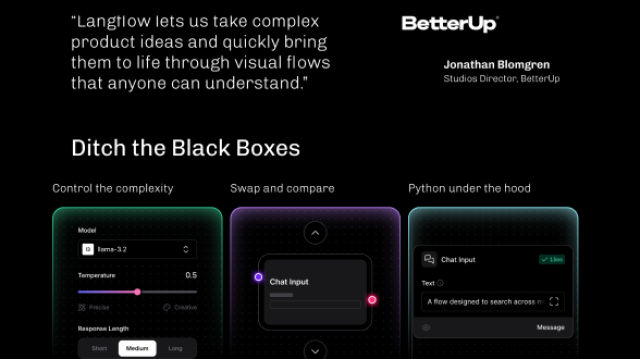

正是在这种背景下,LangFlow 的出现提供了一种全新的可能。它不是又一个复杂的开发框架,而是一个将LangChain“可视化”的图形化工作台——就像Figma之于UI设计师,LangFlow让业务人员也能像搭积木一样构建自己的AI应用。更重要的是,它正在悄然改变企业内训的教学范式。

可视化为何能重塑AI教学?

传统基于代码的LangChain培训,常常从from langchain import ...开始,讲师需要花大量时间解释链式调用机制、内存管理逻辑和工具调度流程。但对于刚接触LLM的学员来说,这些抽象概念如同黑箱:数据从哪里来?经过了什么处理?最终如何输出?缺乏直观感知,导致理解断层。

而LangFlow通过“节点+连线”的方式,把整个工作流暴露出来。每一个组件都是一个可视化的积木块,每一条连接线都代表数据的真实流向。这种设计看似简单,实则击中了认知学习的核心——具象化理解先于抽象掌握。

想象一下,当学员第一次看到“文档加载器”节点输出的内容被切分成若干文本块,再经由“嵌入模型”转化为向量存入“向量数据库”,最后由“LLM”结合检索结果生成回答时,他们不再只是被动接受术语,而是亲眼见证了信息流动的全过程。这种“看得见”的学习体验,极大降低了认知负荷。

更关键的是,LangFlow支持实时预览。修改提示词后无需重启脚本,点击运行即可查看效果;更换不同的LLM节点,能立刻对比输出差异。这种即时反馈机制,鼓励学员大胆尝试、主动探索,形成了真正的“试错式学习”闭环。

从代码到画布:LangFlow是如何工作的?

LangFlow本质上是一个前端驱动的声明式编程环境。它的运作可以分为三层:

首先是交互层。用户在浏览器中拖拽节点、连接端口、填写参数,所有操作都在图形界面上完成。这些节点覆盖了LangChain生态中的核心模块:LLM模型、提示模板、记忆组件、检索链、智能体工具、向量存储等。每个节点都有明确的功能标识和输入输出接口,就像电子元件一样即插即用。

其次是配置层。用户的操作会被序列化为JSON格式的工作流定义文件。这个文件不仅记录了节点类型和参数值,还描述了完整的拓扑结构——谁连接谁、数据如何流转。这种“配置即代码”的设计,使得整个流程可版本化、可共享、可复现。

最后是执行层。当用户触发运行时,LangFlow后端会解析JSON配置,动态生成对应的LangChain Python对象,并按照连接顺序依次执行。比如一个RetrievalQA流程,会被转换为RetrievalQA.from_chain_type(...)的实际调用。整个过程对用户透明,他们只需关注“做什么”,而不必操心“怎么做”。

这正是其强大之处:既保留了LangChain的完整能力,又屏蔽了底层实现细节。即便是复杂的RAG系统,也可以通过几个节点的组合快速搭建出来。

例如,下面这段手动实现的RAG代码:

from langchain_community.llms import OpenAI

from langchain_community.vectorstores import FAISS

from langchain_community.embeddings import HuggingFaceEmbeddings

from langchain.chains import RetrievalQA

from langchain.text_splitter import RecursiveCharacterTextSplitter

# 加载嵌入模型

embedding_model = HuggingFaceEmbeddings(model_name="all-MiniLM-L6-v2")

# 构建向量库

texts = ["LangFlow是一款可视化LangChain工具", "可用于快速构建LLM应用"]

text_splitter = RecursiveCharacterTextSplitter(chunk_size=50, chunk_overlap=10)

doc_chunks = text_splitter.create_documents(texts)

vectorstore = FAISS.from_documents(doc_chunks, embedding_model)

# 创建检索问答链

retriever = vectorstore.as_retriever()

llm = OpenAI(temperature=0)

qa_chain = RetrievalQA.from_chain_type(

llm=llm,

chain_type="stuff",

retriever=retriever,

return_source_documents=True

)

# 执行查询

result = qa_chain.invoke({"query": "LangFlow有什么用途?"})

print(result["result"])

在LangFlow中,仅需四个节点连接即可完成:

- HuggingFace Embeddings → FAISS Vector Store

- OpenAI LLM + RetrievalQA Chain ← 检索器输入

用户只需填写API密钥、chunk大小等参数,其余均由系统自动处理。这种效率提升不仅仅是省了几行代码,更是改变了人与技术之间的互动模式。

当LangFlow走进企业课堂:一次真实的培训变革

我们曾协助某科技公司设计一场面向产品经理的AI应用实训课,主题是“构建客服问答机器人”。过去类似课程常因环境问题导致三分之一学员无法完成实操。这次我们决定完全基于LangFlow开展教学。

课程一开始,讲师并没有讲解任何API或类库,而是直接打开LangFlow界面,在画布上拖入五个节点:

1. Document Loader:用于加载公司产品手册PDF;

2. Text Splitter:设置分块大小为500字符;

3. Embedding Model:选用本地部署的中文嵌入模型;

4. Vector Store:初始化FAISS索引;

5. RetrievalQA Chain:接入通义千问作为LLM。

然后用连线将它们串联起来,形成一条清晰的数据流水线。整个过程不到三分钟,一个具备知识检索能力的问答系统原型就完成了。

接下来,学员被要求导入预设的JSON流程文件,开始动手实验。他们可以自由调整参数,比如尝试将chunk_size从500改为800,观察答案完整性是否提升;或者替换不同的prompt模板,看看能否引导模型给出更规范的回答。

最令人惊喜的是,有位从未写过Python代码的产品经理,居然主动尝试添加了一个ConversationBufferMemory节点,实现了多轮对话记忆功能。她后来分享说:“以前看别人讲memory机制总觉得抽象,现在看到‘记忆’真的作为一个独立模块存在,而且能开关测试,一下子就明白了它的作用。”

这种“低门槛高上限”的特性,正是LangFlow在培训场景中的独特优势。它允许初学者从模仿开始,逐步过渡到创新,而不会因为一次报错就丧失信心。

如何避免“看起来很美”的陷阱?

尽管LangFlow带来了显著便利,但在实际部署中仍需注意几个关键问题,否则容易陷入“演示惊艳、落地困难”的窘境。

安全是第一道防线

最常见也最危险的问题是API密钥泄露。很多用户习惯直接在节点中填写OpenAI Key或其他敏感凭证,一旦流程文件被导出分享,就可能导致严重安全事件。正确的做法是通过环境变量注入,或由后端服务代理API调用,前端只传递标识符。

更好的方案是集成企业SSO系统,实现统一身份认证。这样不仅能控制访问权限,还能记录操作日志,满足合规审计要求。

性能不能忽视

LangFlow默认每次请求都会重新执行整条链路,若对接的是收费且延迟较高的大模型API,频繁调试可能迅速耗尽配额。建议启用缓存机制,对相同输入缓存输出结果;同时限制并发请求数,防止突发流量触发限流。

对于本地运行场景,推荐使用轻量级嵌入模型(如all-MiniLM-L6-v2),既能保证语义质量,又能适应资源受限环境。

教学需要精心设计

虽然LangFlow降低了操作难度,但并不意味着可以“放任自流”。我们发现,如果没有引导,学员很容易陷入无目的点击,缺乏系统性认知。

因此,我们在课程中引入了“注释节点”(Note Node),在关键位置添加说明文字,帮助学员理解设计意图。例如,在连接检索器与LLM时标注:“此处实现RAG架构,确保回答基于真实文档而非模型幻觉”。

此外,还设置了“错误模拟模式”——故意提供一个参数配置错误的流程模板,让学员动手排查问题。这种逆向训练有效提升了他们的系统调试能力。

知识沉淀才是长期价值

单次培训的效果有限,真正的价值在于形成可复用的知识资产。我们建议企业建立标准化的流程模板库,按部门、项目、应用场景分类管理。每个模板附带简要说明和适用场景,新人入职时可直接导入使用。

配合Git进行版本控制,不仅能追踪变更历史,还能支持多人协作优化。久而久之,这套系统就会演变为企业的“AI方法论中枢”,推动最佳实践的持续积累与传播。

超越工具本身:LangFlow带来的深层影响

LangFlow的价值远不止于“少写代码”。它正在重新定义企业内部的技术协作方式。

在过去,AI项目的启动往往需要组建专门的技术团队,业务方只能提出需求,等待排期开发。而现在,产品经理可以在一天内自己搭建出原型,带着可运行的demo去和技术团队讨论优化方向。这种“先做再谈”的模式,极大提升了沟通效率。

更重要的是,它激发了全员参与创新的热情。当我们看到销售、运营甚至HR同事也开始尝试构建自动化工具时,就能意识到:AI民主化不再是口号,而是正在发生的现实。

未来,随着更多行业专用组件的涌现——比如财务分析工具、法律条款比对器、客户情绪识别模块——LangFlow有望成为企业级AI工作流的操作系统。它不仅服务于培训,还将深入到日常运维、产品设计、客户服务等多个环节,成为组织智能化转型的基础设施之一。

技术的终极目标不是制造壁垒,而是消除隔阂。LangFlow所做的,正是把复杂留给自己,把简单交给用户。而这,或许才是AI普及最关键的一步。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

672

672

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?