简介:FFmpeg是一个功能强大的开源多媒体处理工具,本资料将介绍如何使用它将MP4视频文件转换为JPG图片格式。转换过程包括选择特定帧,设置时间戳,以及如何自定义输出图片的质量和命名。此外,还包含了如何在应用程序中集成FFmpeg C/C++库进行视频帧提取的源代码方案,适用于视频预览、截图和图像分析等场景。

1. FFmpeg概述与功能

1.1 FFmpeg简介

FFmpeg是一个开源的多媒体框架,包含了一系列的库和工具,用于处理几乎所有已知的音频和视频格式。其强大的功能不仅限于转换、处理和录制音频和视频,还包括对流媒体的支持、网络传输以及复杂的过滤器链。

1.2 FFmpeg的功能特性

FFmpeg的核心特性包括但不限于:

- 编解码器支持 :提供各种编解码器支持,包括常见的音视频编解码。

- 格式支持 :可以处理多种容器格式,如MP4、AVI、MKV等。

- 过滤器 :强大的多媒体数据过滤系统,支持对视频和音频进行各种效果处理。

- API接口 :提供丰富的API接口,使得开发者可以在自己的应用中集成FFmpeg的功能。

1.3 FFmpeg的应用场景

由于FFmpeg的多功能性,它在多媒体行业有着广泛的应用:

- 视频编辑工具 :FFmpeg为视频编辑软件提供了强大的后端支持。

- 流媒体服务 :可用于搭建直播平台或流媒体服务器。

- 转码服务 :适用于各种媒体内容的转码和格式转换需求。

- 数据分析 :在多媒体数据分析和内容摘要中也扮演着重要角色。

FFmpeg因其稳定、高效的性能,以及灵活的扩展性,已成为IT行业和相关领域专业人士的得力工具。随着技术的不断演进,FFmpeg也在持续更新,以满足多媒体领域日益增长的需求。

2. MP4和JPG格式的区别和特点

2.1 媒体格式的基本概念

2.1.1 MP4与JPG的编码原理

MP4和JPG是两种广泛使用的多媒体文件格式,分别用于音频/视频内容和静态图像内容的存储和传输。理解它们的编码原理有助于更好地掌握如何在多媒体应用中使用这些格式。

MP4(MPEG-4 Part 14)是一种数字多媒体容器格式,用于存储视频、音频以及字幕等数据。MP4文件格式通常包含多个轨道,每个轨道可以包含视频、音频或文本信息。MP4的编码原理主要基于MPEG-4视频压缩标准和AAC音频压缩标准。视频部分通过帧间预测、变换编码、熵编码等技术压缩,而音频部分则通过高效率的编码算法如AAC实现。

JPG(Joint Photographic Experts Group)是一种用于压缩连续色调静态图像的文件格式,广泛用于互联网上。JPG的编码原理基于离散余弦变换(DCT),它能够将图像从空间域转换到频率域,然后通过量化和熵编码(通常是霍夫曼编码)来实现压缩。JPG压缩是可逆的,但会造成一定量的信息丢失,即损失压缩。因此,JPG格式不适合用于需要保留完整数据的应用。

2.1.2 格式在多媒体处理中的应用

MP4作为容器格式,它的应用不仅限于存储视频内容,它还常用于互联网流媒体传输、数字电视广播和移动设备上的多媒体内容播放。MP4格式支持多种编解码器,使得它具有很好的兼容性和灵活性。

另一方面,JPG格式由于其高压缩比和良好的图像质量,是网络上图像分享的标准格式。它经常被用在数字摄影、网页设计以及任何需要高图像质量和较小文件大小的场景中。

2.2 MP4格式的解析

2.2.1 MP4容器结构

MP4文件是一个由一系列的box(容器)组成的树状结构,每个box包含了不同类型的数据或信息。MP4的顶层容器通常包含三个主要的子容器: moov (元数据), mdat (媒体数据)和 udta (用户数据)。

-

moovbox存储了视频、音频轨道的元数据,比如时长、帧率等信息,以及编解码器信息。 -

mdatbox包含了媒体文件的实际数据,也就是视频和音频的样本。 -

udtabox是一个可选容器,用于存放任何由用户定义的数据。

这种结构允许MP4文件在传输过程中,部分信息可以丢失而不会影响整个文件的播放,因为最重要的元数据通常位于文件的开始部分。

2.2.2 MP4音视频流的编解码技术

MP4支持多种音视频编解码器,使得它能够处理不同类型的媒体内容。在视频编解码方面,常见的编解码器有H.264、H.265/HEVC等。视频流通常通过编解码器进行压缩以减小文件大小,同时也保持了合理的图像质量。

音频编解码技术,如AAC、MP3等,用于音频流的压缩和解压缩。音频编解码器会利用人耳听觉的限制,去除那些我们不易察觉的声音信息,从而降低数据量。

2.3 JPG格式的解析

2.3.1 JPG图像压缩标准

JPG格式采用了色彩子采样、量化、以及霍夫曼编码等技术来减小图像文件的大小。色彩子采样可以减少颜色信息的存储量,量化则丢弃了部分视觉上不易察觉的信息,霍夫曼编码则对数据进行无损压缩。

JPG使用了基于人类视觉系统的压缩算法,所以它特别适合用于那些对图像质量要求不是极端苛刻的场合。由于压缩过程中会舍弃数据,当对JPG图片进行多次编辑和保存时,图像质量会逐渐下降。

2.3.2 JPG文件格式的特点和应用场景

JPG格式的一个重要特点是它支持不同的压缩级别,用户可以在文件大小和图像质量之间做出选择。对于网络分享、电子邮件附件、在线图像存储等场景,JPG格式是理想的,因为它的压缩机制能够显著减小文件大小,同时保持较高的视觉质量。

JPG的另一个特点是它支持全色域,也就是说它能够表示几乎所有颜色,这使得它非常适合用于摄影图像和复杂的图像内容。然而,JPG不适合用于需要精确颜色重现的场合,如科学图像、艺术作品的复制品等,此时应考虑使用其他格式如PNG或TIFF。

以上内容详细解析了MP4和JPG格式的基本概念、容器结构、编解码技术、压缩标准和应用场景等,为后续章节的FFmpeg命令行操作和视频流处理技术的应用打下了基础。接下来,我们将探讨如何使用FFmpeg命令行工具进行MP4到JPG的转换,以及如何处理和优化转换过程中的关键参数和视频帧的选择。

3. FFmpeg命令行转换MP4到JPG的语法和参数

在进行多媒体文件处理时,FFmpeg是一个不可或缺的强大工具。尤其是在转换视频文件到静态图像序列的场景中,FFmpeg提供了灵活的命令行参数来满足用户的多样化需求。本章节将深入探讨FFmpeg在命令行环境下转换MP4到JPG格式时所涉及的基础语法和关键参数,帮助用户实现高效准确的媒体文件处理。

3.1 FFmpeg转换命令的基础语法

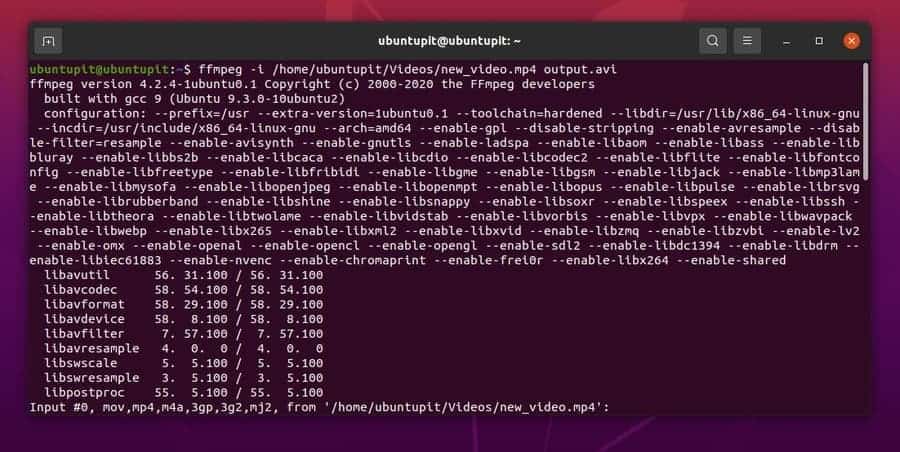

3.1.1 命令行工具的安装与配置

首先,确保FFmpeg已经被正确安装在您的系统中。根据不同的操作系统,安装方法会有所差异。以Linux系统为例,可以通过包管理器安装,如在Ubuntu中使用以下命令:

sudo apt update

sudo apt install ffmpeg

在安装完成后,可以在终端运行 ffmpeg -version 来检查FFmpeg是否安装成功。如果输出了FFmpeg的版本信息,则表示安装无误。

3.1.2 转换命令的基本结构

转换命令的基本结构遵循这样的模式:

ffmpeg -i input.mp4 -vf fps=1 output-%03d.jpg

这里, -i 参数用于指定输入文件, -vf 是“video filter”的缩写,用于指定视频滤镜, fps=1 表示设置帧率为每秒1帧, output-%03d.jpg 则定义了输出文件的命名模板。

3.2 关键参数详解

3.2.1 输入输出文件参数

在FFmpeg的转换命令中, -i 参数后跟上输入文件是必须的。而输出文件的参数则稍显灵活,可以通过 -o 参数直接指定输出文件名,或者使用命名模板来定义输出文件序列。

ffmpeg -i input.mp4 -o output.jpg

或者使用命名模板:

ffmpeg -i input.mp4 output-%03d.jpg

3.2.2 视频编解码器选择与参数设置

当需要指定输出图片的格式时,可以通过 -vcodec 参数来指定视频编解码器。例如,要将输出设置为PNG格式,可以使用:

ffmpeg -i input.mp4 -vcodec png output.png

此外,还可以通过 -q:v 参数设置压缩质量,例如:

ffmpeg -i input.mp4 -q:v 2 output.jpg

这里的 -q:v 2 表示设置JPEG图片的质量为2。

3.2.3 框率控制与时间戳同步

在转换过程中,控制输出图片的帧率是常用需求。可以通过 -r 参数设置输出的帧率,例如:

ffmpeg -i input.mp4 -r 1 output-%03d.jpg

这表示将视频转换为每秒输出1帧的图片序列。另外,确保转换过程中的时间戳保持同步,可以通过 -sameq 参数来维持质量:

ffmpeg -i input.mp4 -sameq output-%03d.jpg

-sameq 参数将确保转换过程中使用与原始视频相同的编码质量。

以上是FFmpeg命令行转换MP4到JPG格式的基本语法和关键参数。通过灵活运用这些参数,可以精确控制输出的细节,满足不同的处理需求。接下来的章节,我们将进一步深入探讨如何使用FFmpeg进行更高级的操作,例如选择视频帧和设置时间戳,以及如何调整输出图片的质量和命名模板。

4. 使用FFmpeg选择视频帧和设置时间戳

视频内容处理的一个核心任务是精确选择特定的视频帧进行分析、处理或转换。FFmpeg 提供了丰富的工具和参数来实现这一目的。在本章节中,我们将详细探讨如何使用 FFmpeg 选择视频帧和设置时间戳,以及这些功能在实际应用中的具体应用。

4.1 视频帧选择的策略

视频帧是视频流的基本组成单位,根据是否包含完整的视频信息,帧可以被分为关键帧(I帧)和非关键帧(P帧和B帧)。理解这两者之间的区别,对于视频数据的处理至关重要。

4.1.1 关键帧与非关键帧的区别

关键帧(I帧)是一个包含完整图像信息的帧,它不依赖于任何帧即可独立解码。关键帧是压缩视频中的参考点,用于重新同步视频流,或者在播放时快速跳转到一个特定时间点。而非关键帧(P帧和B帧)则是依赖于其他帧进行编码和解码的帧,它们压缩了图像的运动信息,不包含完整的图像数据。

4.1.2 帧率转换与帧选择实例分析

在视频转换过程中,帧率转换是一个常见的需求。例如,将30fps(帧每秒)的视频转换为60fps,或者相反,需要从原始视频中选择合适的帧来达到预期的帧率。

ffmpeg -i input.mp4 -vf "fps=24" output.mp4

该命令使用 -vf 参数和 fps 过滤器来改变输出视频的帧率,这里我们将其设置为24fps。通过调整过滤器中的参数,我们可以精确控制输出视频的帧率。

# 选择第2秒的关键帧

ffmpeg -ss 00:00:02 -i input.mp4 -vframes 1 -c:v copy keyframe.jpg

上面的例子中, -ss 参数用来指定开始寻找关键帧的位置, -vframes 1 表示仅输出一个帧, -c:v copy 告诉 FFmpeg 直接复制该帧的数据而不是重新编码,这样可以保留关键帧的原始质量。

4.2 时间戳的作用与设置

时间戳是视频处理中的另一个重要概念,它记录了视频帧或音轨数据包的特定位置,与帧率紧密结合,用于精确同步视频和音频。

4.2.1 时间戳的基本概念

每个视频帧或音频数据包都有一个与之关联的时间戳,它表示该帧或数据包应该在何时被解码和呈现。时间戳通常以秒为单位,对于精确控制视频流中的特定帧或数据包非常有用。

4.2.2 时间戳的精确控制方法

FFmpeg 提供了多种方式来精确控制时间戳,从指定输出帧的时间戳到使用过滤器进行时间戳调整等。

# 设置特定帧的时间戳为0

ffmpeg -i input.mp4 -vf "setpts=0" output.mp4

在上面的例子中, setpts 过滤器被用来设置视频流中所有帧的时间戳为0,这可以用于某些特定场景,比如将视频的播放点回退到开始位置。

4.2.3 时间戳与帧选择的结合使用

将时间戳的设置与帧选择结合起来,可以实现许多复杂的视频处理需求。

# 从输入视频中提取特定时间戳的帧

ffmpeg -ss 00:00:10 -i input.mp4 -vframes 1 -vf "setpts=PTS-STARTPTS" frame.jpg

此示例命令组合了 -ss 参数和 setpts 过滤器。首先, -ss 参数用于寻找输入视频中10秒处的帧,然后 -vframes 1 保证只输出一个帧,最后 setpts=PTS-STARTPTS 过滤器将提取帧的时间戳设置为相对于输入流的开始位置。

结合时间和帧的选择操作,我们可以构建非常灵活的视频处理流程,用于满足多样化的媒体处理需求。

5. 调整输出图片质量和命名模板

5.1 图片质量的调整技巧

5.1.1 压缩率与质量的平衡

在使用 FFmpeg 进行视频到图片的转换时,一个关键的考虑因素是如何在压缩率和图片质量之间找到平衡。压缩率越高,意味着文件尺寸越小,但图像细节的损失也可能越大,反之亦然。通常,图片的压缩是通过设置编码器的参数来控制的,比如对于 JPEG 格式,可以通过调整质量参数( -q:v 或 -qscale:v )来控制压缩率。

5.1.2 高质量输出的参数设置

为了获得高质量的图片输出,我们可能需要牺牲一些文件大小。在 FFmpeg 中,可以通过设置 -q:v 1 到 -q:v 10 来获得不同程度的质量,其中 1 是最高质量,10 则接近最低。需要注意的是,较低的数值表示较高的质量。除了直接使用质量参数外,还可以选择合适的编码器和编码格式来达到高质量输出。例如,使用 PNG 格式进行无损压缩,或者使用高质量的 H.264 编码参数。

5.2 命名模板的设计与应用

5.2.1 文件命名策略的重要性

在自动化处理大量图片时,有效的文件命名策略是至关重要的。合理的命名策略不仅能够帮助我们更好地组织和检索图片,还可以通过编码信息来快速识别图片的属性,如时间戳、帧数或视频源等。一个好的命名策略将减少人工干预的需求,提高工作效率。

5.2.2 自定义命名模板与批量处理

通过 FFmpeg 的命名模板功能,可以实现高度自定义的文件命名策略。命名模板中可以包含各种变量,如 %d (表示输出流序号), %03d (表示帧序号,前面补零到三位数)等。这允许用户根据实际需求,设计出既符合逻辑又能有效区分的文件命名规则。

例如,使用命名模板 -f image2 "output_%03d.jpg" ,输出文件将会按照帧序号命名,如 output_001.jpg , output_002.jpg 等。这在批量处理视频截图时,提供了极大的便利。

5.2.3 时间戳与帧选择的结合使用

命名模板同样可以与时间戳结合使用,以确保每个输出的图片都有与之对应的时间信息。这在分析视频帧或进行时间轴定位时特别有用。通过 -vf "setpts=PTS-STARTPTS" 参数,可以将时间戳重置到视频开始时的值,然后通过命名模板反映该时间戳。

例如,结合时间戳的命名模板可能如下: -f image2 "frame_%04d_%t.jpg" ,这将会生成像 frame_0001_00:01:00.000.jpg 这样的文件名,其中包含了帧序号和时间戳。

graph TD;

A[开始批量转换视频帧] --> B[确定命名模板参数]

B --> C[应用命名模板至FFmpeg命令]

C --> D[执行FFmpeg转换命令]

D --> E[检查输出文件命名和格式]

E --> F[批量处理完成]

示例代码块

下面是一个使用 FFmpeg 命令转换视频帧并应用自定义命名模板的示例:

ffmpeg -i input.mp4 -vf "fps=1,scale=320:-1" -vsync 0 "frame_%03d.png"

该命令解释如下:

-

-i input.mp4: 指定输入视频文件。 -

-vf "fps=1,scale=320:-1": 设置视频滤镜,其中fps=1表示每秒输出一帧,scale=320:-1表示将视频缩放到宽度为 320px,高度自动调整。 -

-vsync 0: 禁用视频同步,可以避免输出帧中可能出现的重复。 -

"frame_%03d.png": 指定输出文件命名模板,%03d为一个占位符,表示帧号,前面补零到三位数。

执行上述命令后,将按照指定的命名模板导出视频的每一帧为一个图片文件,命名为 frame_001.png , frame_002.png 等。

6. FFmpeg C/C++库的应用和API调用

6.1 FFmpeg C/C++库的集成基础

6.1.1 库的安装与配置

FFmpeg 是一个非常强大的跨平台的视频处理框架,它不仅提供了功能丰富的命令行工具,还提供了一组完备的C/C++库。开发者可以通过这些库在自己的程序中实现视频的编解码、转码、过滤等功能。对于想要在应用程序中集成FFmpeg功能的开发者而言,安装和配置这些库是第一步。

安装FFmpeg库一般分为两个步骤:安装FFmpeg的编译环境和将库集成到你的项目中。

首先,确保你的系统上安装了FFmpeg。对于大多数Linux发行版,你可以通过包管理器安装。例如,在Ubuntu上可以使用以下命令:

sudo apt update

sudo apt install ffmpeg libavcodec-dev libavformat-dev libavutil-dev

对于Windows系统,你可以从FFmpeg官网下载预编译的二进制文件,或者使用MSYS2等工具进行源代码的编译安装。

一旦FFmpeg库安装完成,你需要在你的开发环境中配置编译选项,将FFmpeg的头文件和库文件包含进去。这通常在项目的Makefile或CMakeLists.txt中进行设置。例如,在一个基于Makefile的C++项目中,你可能会添加如下行:

INCLUDE_PATHS := -I/usr/include/ffmpeg

LIBRARY_PATHS := -L/usr/lib/x86_64-linux-gnu

LIBRARIES := -lavformat -lavcodec -lavutil -lswscale

这些设置指明了编译器在编译时应该去哪里查找FFmpeg的头文件和库文件,并指定链接时需要链接的FFmpeg库。

6.1.2 API调用的基本流程

一旦FFmpeg库安装配置完毕,你就可以开始在你的代码中调用API进行视频处理了。FFmpeg提供了非常丰富的API来处理视频和音频数据,但所有操作的起点通常是初始化。

在开始实际的编解码工作前,你需要初始化FFmpeg库。这包括注册所有的编解码器、网络协议、解复用器等组件。在C++中,你通常会调用 av_register_all() 函数来完成初始化。

extern "C" {

#include <libavcodec/avcodec.h>

#include <libavformat/avformat.h>

}

int main() {

av_register_all();

// 进行后续操作,例如打开文件、读取音视频流等

return 0;

}

初始化后,通常会涉及到打开媒体文件、读取和解析音视频流、解码和编码数据包、过滤和转码等操作。这些操作往往依赖于一系列的API调用,每个API的调用都有其特定的使用场景和参数设置。

接下来,你可以根据具体的应用需求,调用对应的API接口。例如,打开一个视频文件并读取其音视频流,你需要执行如下操作:

AVFormatContext* pFormatContext = avformat_alloc_context();

if (avformat_open_input(&pFormatContext, "input.mp4", nullptr, nullptr) != 0) {

// 文件打开失败处理

}

if (avformat_find_stream_info(pFormatContext, nullptr) < 0) {

// 流信息获取失败处理

}

// 读取数据包等后续操作

6.2 功能函数详解与示例代码

6.2.1 视频文件读取与解码

在FFmpeg的C/C++库中,视频文件的读取和解码涉及到几个主要的功能函数。关键的步骤包括打开媒体文件、读取音视频流信息、读取数据包、解码数据包以及释放资源。

以下是一个简单的示例,展示了如何使用FFmpeg库打开一个视频文件,并读取其中的数据包进行解码:

// 打开媒体文件

if (avformat_open_input(&pFormatContext, "input.mp4", nullptr, nullptr) != 0) {

// 错误处理

}

if (avformat_find_stream_info(pFormatContext, nullptr) < 0) {

// 错误处理

}

// 找到第一个视频流的索引

int video_stream_index = av_find_best_stream(pFormatContext, AVMEDIA_TYPE_VIDEO, -1, -1, nullptr, 0);

if (video_stream_index < 0) {

// 错误处理

}

// 获取视频流的解码器上下文

AVCodecContext* pCodecContext = pFormatContext->streams[video_stream_index]->codec;

// 查找解码器

AVCodec* pCodec = avcodec_find_decoder(pCodecContext->codec_id);

if (pCodec == nullptr) {

// 错误处理

}

// 打开解码器

if (avcodec_open2(pCodecContext, pCodec, nullptr) < 0) {

// 错误处理

}

AVPacket packet;

while (av_read_frame(pFormatContext, &packet) >= 0) {

// 判断是否为视频数据包

if (packet.stream_index == video_stream_index) {

// 解码视频数据包

int response = avcodec_send_packet(pCodecContext, &packet);

if (response < 0) {

// 错误处理

}

while (response >= 0) {

AVFrame* pFrame = av_frame_alloc();

response = avcodec_receive_frame(pCodecContext, pFrame);

if (response == AVERROR(EAGAIN) || response == AVERROR_EOF) {

av_frame_free(&pFrame);

break;

} else if (response < 0) {

// 错误处理

}

// 此处可以处理解码后的视频帧pFrame

av_frame_free(&pFrame);

}

}

av_packet_unref(&packet);

}

// 释放资源

// ...

这段代码演示了如何使用FFmpeg的API打开一个视频文件,找到视频流,并循环读取和解码数据包。在整个过程中,错误处理是必不可少的一部分,以确保程序的健壮性。

6.2.2 图片捕获与编码输出

图片捕获通常是指从视频中提取某一帧的图像。FFmpeg提供了丰富的API来实现这一功能。我们可以使用 av_frame_alloc 来分配一个新的帧结构体,然后使用解码器解码视频帧填充到该结构体中。最后,我们可以将解码得到的帧编码为特定格式的图片文件。

以下是一个简单的示例,展示了如何从视频流中提取一帧并将其编码为JPG格式的图片:

// 假设pCodecContext是已经设置好的解码器上下文

AVFrame* pFrame = av_frame_alloc();

AVPacket packet;

while (av_read_frame(pFormatContext, &packet) >= 0) {

if (packet.stream_index == video_stream_index) {

if (avcodec_send_packet(pCodecContext, &packet) == 0) {

while (avcodec_receive_frame(pCodecContext, pFrame) == 0) {

// 成功解码一帧,此处处理pFrame指向的视频帧

// ...

// 保存帧为JPG图片

AVCodecContext* pCodecCtx = pCodecContext;

AVFrame* pFrameYUV = pFrame;

int numBytes;

unsigned char* buffer = nullptr;

int got_output = 0;

// 寻找最适合的编码器

AVCodec* pCodec = avcodec_find_encoder(AV_CODEC_ID_MJPEG);

AVCodecContext* pCodecCtxYUV = avcodec_alloc_context3(pCodec);

avcodec_get_context_defaults3(pCodecCtxYUV, pCodec);

avcodec_open2(pCodecCtxYUV, pCodec, nullptr);

// 设置编码参数

pCodecCtxYUV->bit_rate = 400000;

pCodecCtxYUV->width = pCodecCtx->width;

pCodecCtxYUV->height = pCodecCtx->height;

pCodecCtxYUV->time_base = {1, 1};

pCodecCtxYUV->framerate = {30, 1};

pCodecCtxYUV->gop_size = 10;

pCodecCtxYUV->pix_fmt = AV_PIX_FMT_YUVJ420P;

// 分配帧缓冲区

av_image_alloc(buffer, numBytes, pCodecCtxYUV->width, pCodecCtxYUV->height, AV_PIX_FMT_YUVJ420P, 16);

av_image_fill_arrays(pFrameYUV->data, pFrameYUV->linesize, buffer, AV_PIX_FMT_YUVJ420P, pCodecCtxYUV->width, pCodecCtxYUV->height, 16);

// 编码过程

AVPacket pkt;

av_init_packet(&pkt);

pkt.data = nullptr;

pkt.size = 0;

int i = 0, ret = 0;

ret = avcodec_send_frame(pCodecCtxYUV, pFrameYUV);

while (ret >= 0) {

ret = avcodec_receive_packet(pCodecCtxYUV, &pkt);

if (ret == AVERROR(EAGAIN) || ret == AVERROR_EOF) {

break;

} else if (ret < 0) {

av_log(nullptr, AV_LOG_ERROR, "Error while encoding\n");

goto end;

}

got_output = 1;

// 从这里可以将编码后的数据写入文件或进行其他处理

// ...

}

end:

if (got_output) {

// 写入文件或进行其他处理

}

av_packet_unref(&pkt);

avcodec_free_context(&pCodecCtxYUV);

av_freep(&buffer);

av_image_free(pFrameYUV->data);

}

}

}

av_packet_unref(&packet);

}

这段代码演示了如何从视频流中提取一帧图像,然后使用FFmpeg的编码器将其编码为JPEG格式的图片。这里简化的处理流程中,涉及到的编码器初始化、帧缓冲区的分配、帧数据的填充等步骤都是实际操作中的关键部分。

通过上面的示例,我们可以看到FFmpeg提供的API调用具有一定的复杂性,但是对于掌握视频处理技术的开发者而言,这些API提供了一种强大的手段,可以灵活地进行视频流的读取、解码、编码和输出。

请注意,上面的代码只是一个简化的示例,实际使用中还需要进行详尽的错误处理和资源管理,以确保应用程序的稳定运行和资源的正确释放。

7. 视频流的处理和流编号指定

在数字视频处理中,流编号是一个关键概念,它帮助我们区分和操作多个音频或视频流。正确处理流编号不仅能够让视频内容更丰富,还能在转换和编辑视频时提高效率和准确性。

7.1 视频流处理技术概述

7.1.1 流媒体处理的基本原理

流媒体技术指的是以数据流的方式实时传输媒体内容的技术。在处理视频时,流媒体通常涉及多个数据流,如视频流、音频流,有时还包括字幕流等。流媒体处理的基本原理在于将这些流同步地处理,以保证最终播放的视频内容在时间上的连续性。

7.1.2 视频流的同步与异步处理

视频流的同步是指确保不同流之间在播放时保持时间上的对齐。异步处理则涉及到处理流时,它们可以独立进行,不必保持时间上的严格对齐。在某些情况下,如音视频不同步时,需要特别注意流的同步处理。

7.2 流编号的应用与实例

7.2.1 流编号的定义与作用

流编号是FFmpeg中用于标识不同流的一个整数标识符。每个流都有一个唯一的编号,通过这些编号,我们可以指定特定流进行操作,如解码、转码、过滤等。正确使用流编号可以让我们精确地控制视频处理过程中的每一个细节。

7.2.2 在视频转换中指定和使用流编号

7.2.2.1 指定特定流进行转换

当使用FFmpeg进行视频转换时,我们可能会遇到仅需要转换某个特定流(比如音频或视频流)的情况。通过流编号,我们可以轻松实现这一点。以下是使用FFmpeg命令行进行流指定转换的示例:

ffmpeg -i input.mp4 -map 0:v:0 output_video.mp4 # 提取第一个视频流并保存

ffmpeg -i input.mp4 -map 0:a:1 output_audio.m4a # 提取第二个音频流并保存

在以上命令中, -map 选项后跟的是输入文件索引和流编号。第一个示例中, 0:v:0 表示第一个输入文件中的第一个视频流,而第二个示例中, 0:a:1 表示第一个输入文件中的第二个音频流。

7.2.2.2 混合多个流

有时候我们需要将多个视频或音频流混合到一个文件中。例如,我们有一个视频文件,其中包含两个视频流和一个音频流,我们想将其中一个视频流和音频流合并成一个新的视频文件。我们可以通过以下命令实现:

ffmpeg -i input.mp4 -map 0:v:1 -map 0:a:0 output_combined.mp4

在这个例子中, -map 0:v:1 表示选择第一个输入文件中的第二个视频流, -map 0:a:0 表示选择第一个输入文件中的第一个音频流。这样,我们就可以将特定的视频和音频流混合在一起。

通过以上实例,可以看出流编号在视频处理中的重要性。通过指定正确的流编号,我们可以实现对视频内容的精细控制,无论是单独提取音频、视频流还是将它们混合在一起。掌握流编号的使用,对于高级视频处理工作是必不可少的。

在接下来的章节中,我们将进一步探索FFmpeg在视频流处理中的高级应用,例如视频帧过滤、转码参数优化等,以提高视频处理的效率和质量。

简介:FFmpeg是一个功能强大的开源多媒体处理工具,本资料将介绍如何使用它将MP4视频文件转换为JPG图片格式。转换过程包括选择特定帧,设置时间戳,以及如何自定义输出图片的质量和命名。此外,还包含了如何在应用程序中集成FFmpeg C/C++库进行视频帧提取的源代码方案,适用于视频预览、截图和图像分析等场景。

706

706

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?