简介:OpenCV(开源计算机视觉库)是一个强大的计算机视觉库,提供了丰富的图像处理和视觉算法,支持多种编程语言,并广泛应用于多个领域。本教程旨在帮助初学者掌握OpenCV的基础知识和应用,包括安装配置、图像处理、特征检测、物体检测以及机器学习和深度学习集成。通过动手实践项目,初学者将能巩固理论知识,提高操作技能。

1. OpenCV简介

OpenCV,即Open Source Computer Vision Library,是一个开源的计算机视觉和机器学习软件库。它由超过2500个优化算法组成,涵盖广泛的计算机视觉应用,如面部识别、手势识别、人体运动跟踪、立体视觉、视频分析、图像分割、特征提取等。

自2000年由英特尔公司发起,如今它已经发展成为一个活跃的开源项目,由社区和企业共同支持和维护。OpenCV拥有易于使用的C++、Python和Java等语言接口,并支持Windows、Linux、OS X、iOS和Android等操作系统。

OpenCV不仅是计算机视觉研究者的利器,也逐渐成为工程师和爱好者们的首选工具,它将复杂的视觉算法简化为直观的API调用,极大地促进了计算机视觉技术的普及和应用。

2. 安装与配置

在深入了解OpenCV之前,必须确保你已经正确安装了该库,并对其配置进行了适当的设置。本章节将详细介绍如何在不同的操作系统上安装OpenCV,并且为你的开发环境配置好所需的依赖项。

2.1 环境准备

2.1.1 系统要求

OpenCV可以在多种操作系统上运行,包括但不限于Windows、Linux和macOS。然而,为了确保最佳的开发体验,我们推荐使用以下配置作为最低系统要求:

- 操作系统 : Windows 7/8/10, Ubuntu 16.04+, macOS 10.10+

- 处理器 : 最好是支持SSE2指令集的多核处理器

- 内存 : 2GB及以上,根据你的项目需求,可能需要更大

- 开发工具 : 选择合适的开发环境,例如Visual Studio 2015或更高版本(对于Windows),或GCC/G++(对于Linux和macOS)

- Python : 3.6及以上版本,如果你打算使用Python接口

2.1.2 开发工具选择

在开始安装OpenCV之前,选择一个合适的开发工具至关重要。对于初学者来说,易于上手的集成开发环境(IDE)是最佳选择,例如Visual Studio Code、PyCharm或Eclipse。经验丰富的开发者可能会更倾向于使用命令行工具。

2.2 安装步骤详解

2.2.1 从源代码编译安装

编译安装OpenCV可以让你获得最新版本的库以及最佳性能。以下是编译安装的基本步骤:

- 首先,安装必要的依赖项。对于Ubuntu系统,你可以使用以下命令:

bash sudo apt-get install build-essential cmake git libgtk2.0-dev pkg-config libavcodec-dev libavformat-dev libswscale-dev - 下载OpenCV源代码。访问 OpenCV官方GitHub页面 进行下载。

- 解压下载的源代码包,并进入解压后的目录。

- 创建一个构建目录并进入:

bash mkdir build && cd build - 使用CMake配置项目:

bash cmake -D CMAKE_BUILD_TYPE=RELEASE -D CMAKE_INSTALL_PREFIX=/usr/local .. - 编译源代码:

bash make -j8

其中-j8表示使用8个线程并行编译以加速构建过程。 - 安装OpenCV:

bash sudo make install - 验证安装是否成功,可以使用以下命令:

bash pkg-config --modversion opencv4

2.2.2 使用包管理器安装

许多操作系统提供了包管理器来简化安装过程。以Ubuntu为例,你可以使用以下命令安装OpenCV:

- 更新包管理器:

bash sudo apt-get update - 安装OpenCV:

bash sudo apt-get install python3-opencv

或者如果你需要安装OpenCV的完整开发包:

bash sudo apt-get install libopencv-dev

如果你使用的是Python,确保使用 pip 安装相应的Python包:

pip install opencv-python

对于其他操作系统,你可以查找对应系统的OpenCV包管理器安装指南。

2.3 配置环境与验证

2.3.1 环境变量配置

安装完OpenCV后,你可能需要配置环境变量,以便能够在任何目录下使用OpenCV。以Linux为例,你可以通过在 .bashrc 或 .bash_profile 文件中添加以下行来配置环境变量:

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/usr/local/lib

然后更新你的终端:

source ~/.bashrc

对于Windows,你可能需要将OpenCV的 bin 目录添加到系统的PATH变量中。

2.3.2 验证OpenCV安装

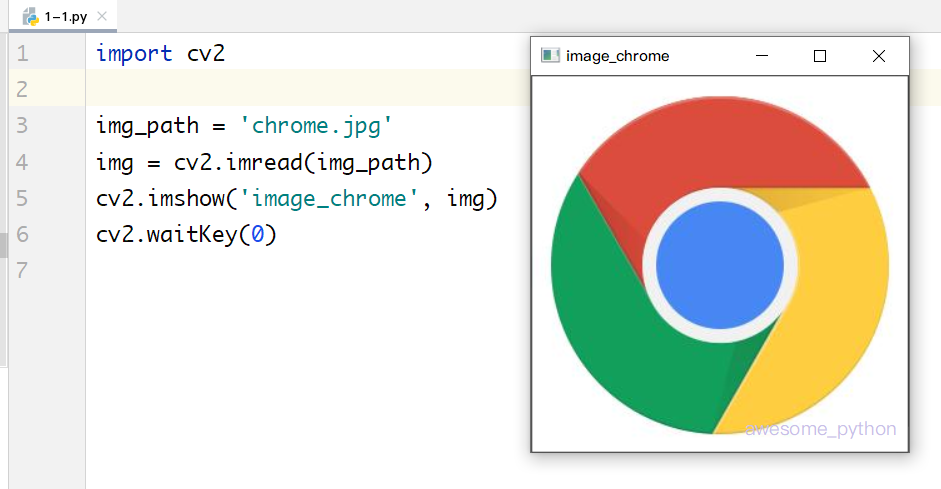

为了验证OpenCV是否正确安装,可以创建一个简单的Python脚本来加载一个图像并显示它:

import cv2

img = cv2.imread('path_to_image.jpg')

cv2.imshow('Window', img)

cv2.waitKey(0)

cv2.destroyAllWindows()

如果没有任何错误发生,并且你的图像显示出来了,那么恭喜你,OpenCV已经正确安装并且可以开始使用了!

2.3.3 配置IDE

大多数集成开发环境(IDE)都允许你配置项目设置,以便在其中直接使用OpenCV。以Visual Studio Code为例,你需要在项目根目录下创建一个名为 .vscode 的文件夹,并在其中创建一个名为 settings.json 的文件。然后添加以下内容:

{

"python.pythonPath": "path_to_your_python_interpreter",

"python.linting.enabled": true,

"python.linting.pylintEnabled": false,

"python.linting.flake8Enabled": true

}

确保将 python.pythonPath 设置为指向你的Python解释器路径。

以上步骤将帮助你完成OpenCV的安装和配置过程,并开始使用这个功能强大的库。接下来,你将能够探索OpenCV提供的广泛功能,包括图像处理、特征检测、机器学习等。

3. 基本概念与核心数据结构

3.1 图像基础知识

3.1.1 图像的表示方法

图像的表示通常基于矩阵,每个像素点包含在矩阵中的特定位置,并赋予了特定的数值来表示颜色。在计算机中,图像可以是灰度图、二值图、彩色图等。灰度图像仅需要一个通道来表示不同的亮度,而彩色图像通常需要三个通道(RGB)来表示不同的颜色。图像的深度是指每个像素能够表示的颜色数,它与位数有关,比如8位图像每个通道可以表示256种不同的值。

使用OpenCV时,图像被表示为 cv::Mat 对象,可以包含任意数量的通道和任意的位深度。图像读入后会分配一个内存块,并创建一个对应的 cv::Mat 对象,包含图像数据以及关于这个数据的元数据(如行数、列数、通道数、数据类型等)。

// 示例代码:读取图像并显示其属性

#include <opencv2/opencv.hpp>

#include <iostream>

int main() {

cv::Mat image = cv::imread("path_to_image.jpg"); // 读取图像

if(image.empty()) {

std::cout << "Image not loaded properly." << std::endl;

return -1;

}

std::cout << "Image size: " << image.size() << std::endl; // 输出图像大小

std::cout << "Number of channels: " << image.channels() << std::endl; // 输出通道数

cv::imshow("Loaded Image", image); // 显示图像窗口

cv::waitKey(0); // 等待任意键

return 0;

}

在上述代码中,使用 cv::imread 函数加载图像,然后通过 size() 和 channels() 函数分别获取图像尺寸和通道数,并输出到控制台。

3.1.2 颜色空间转换

颜色空间转换是图像处理中的一个重要概念,它指的是在不同的颜色表示模型之间转换。常见的颜色空间包括RGB、HSV、YCrCb等。例如,HSV颜色空间更接近人类对颜色的感知方式,因此它在颜色跟踪和阈值处理中更为有用。

在OpenCV中,颜色空间转换可以通过 cvtColor 函数实现。例如,将RGB图像转换为HSV空间:

cv::Mat image; // 假设已经加载了一个RGB图像到image变量中

cv::Mat hsvImage;

cv::cvtColor(image, hsvImage, cv::COLOR_BGR2HSV); // RGB到HSV的转换

转换后可以对HSV空间的各个通道进行独立的阈值处理,以达到特定的图像分割效果。

3.2 核心数据结构解析

3.2.1 Mat对象的理解和应用

cv::Mat 是OpenCV中的核心数据结构,用于存储图像和其他多维数组。 cv::Mat 可以包含图像的全部信息,包括数据头(包含图像的尺寸、类型、步长等)和指向实际数据的指针。

在实际应用中,经常使用 cv::Mat 来分配和释放图像数据。它可以动态地创建、拷贝、赋值。此外, cv::Mat 可以被引用,这意味着多个变量可以共享同一个数据头,但它们指向的数据可能是不同的。

cv::Mat image = cv::imread("path_to_image.jpg"); // 创建Mat对象来存储图像数据

cv::Mat imageROI = image(cv::Rect(10, 10, 100, 100)); // 创建一个图像区域的引用

imageROI = cv::Scalar(0, 0, 255); // 修改引用区域的颜色值

上面的代码中, imageROI 是对 image 的一个区域的引用,修改 imageROI 的内容同样会影响原图 image 中相应的区域。

3.2.2 矩阵操作和性能优化

cv::Mat 类提供了丰富的矩阵操作函数,包括矩阵初始化、赋值、算术运算、矩阵运算等。这些操作都进行了优化,可以有效利用硬件资源,特别是多核CPU,进行并行处理。

性能优化在实际应用中至关重要。对于大规模矩阵运算,可以使用OpenCV提供的优化函数,如 gemm (矩阵乘法)、 reduce (降维运算)等。为了进一步提升性能,还可以考虑使用GPU加速和优化库(如OpenCL、CUDA)。

cv::Mat A = cv::Mat::ones(1000, 1000, CV_32F); // 创建一个1000x1000的全1矩阵

cv::Mat B = cv::Mat::eye(1000, 1000, CV_32F); // 创建一个1000x1000的单位矩阵

cv::Mat C; // 结果矩阵

cv::gemm(A, B, 1.0, cv::Mat(), 0.0, C, cv::GEMM_1_T); // 计算A * B的转置

在这个例子中, cv::gemm 函数计算了两个矩阵的乘积,并将结果存储在 C 中。 cv::GEMM_1_T 参数指定了第二个矩阵的转置。这些操作可以处理复杂的数学运算,同时保持高效的执行速度。

4. 图像处理技巧

4.1 常用图像处理操作

图像处理是一门古老而又充满活力的科学,它是数字图像分析和计算机视觉领域的基础。在本章节中,我们将探讨一些常用的图像处理操作,旨在帮助读者理解如何利用OpenCV进行图像滤波、去噪、几何变换等操作。

4.1.1 图像滤波和去噪

图像在采集过程中,由于传感器、传输和存储等多种原因,往往会受到各种噪声的影响。图像滤波是一种有效的图像预处理手段,用于去除噪声、平滑图像或增强图像中的特定特征。在OpenCV中,提供了多种滤波器来满足不同的需求。

实现图像滤波

使用OpenCV中的高斯滤波来平滑图像:

import cv2

import numpy as np

# 加载图像

image = cv2.imread('noisy_image.jpg', cv2.IMREAD_GRAYSCALE)

# 创建一个高斯模糊核,5x5大小,标准差1.5

gaussian_blur = cv2.GaussianBlur(image, (5, 5), 1.5)

# 显示原图像和滤波后的图像

cv2.imshow('Original', image)

cv2.imshow('Gaussian Blur', gaussian_blur)

# 等待按键,然后关闭所有窗口

cv2.waitKey(0)

cv2.destroyAllWindows()

去噪算法应用

OpenCV还提供了一些去噪算法,例如中值滤波和双边滤波。中值滤波特别适用于去除盐和胡椒噪声,而双边滤波则在去除噪声的同时保留边缘信息。

# 中值滤波

median_blur = cv2.medianBlur(image, 5)

# 双边滤波

bilateral_blur = cv2.bilateralFilter(image, d=9, sigmaColor=75, sigmaSpace=75)

# 显示滤波结果

cv2.imshow('Median Blur', median_blur)

cv2.imshow('Bilateral Filter', bilateral_blur)

cv2.waitKey(0)

cv2.destroyAllWindows()

高斯滤波通过一个卷积核对图像的每个像素进行加权平均,以此达到去噪和模糊的效果。中值滤波则将每个像素的值替换为其邻域内所有像素值的中值,这有助于消除孤立的噪点。双边滤波则考虑了像素间的空间邻近度和像素值之间的相似度,是一种边缘保护的滤波方法。

4.1.2 图像的几何变换

图像的几何变换是通过对图像中的像素点位置进行重新映射来改变图像形状的操作。几何变换广泛应用于图像校正、图像配准等场景。在OpenCV中,我们使用 cv2.warpAffine 和 cv2.getPerspectiveTransform 等函数来实现这些变换。

实现图像仿射变换

def affine_transformation(image):

rows, cols = image.shape[:2]

# 构建仿射变换矩阵

affine_matrix = cv2.getRotationMatrix2D((cols/2, rows/2), 45, 1)

# 应用仿射变换

affine_image = cv2.warpAffine(image, affine_matrix, (cols, rows))

return affine_image

# 加载图像

image = cv2.imread('original_image.jpg')

# 进行仿射变换

transformed_image = affine_transformation(image)

# 显示原图和变换后的图像

cv2.imshow('Original Image', image)

cv2.imshow('Affine Transformation', transformed_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

在上述代码中, getRotationMatrix2D 函数用于生成仿射变换矩阵,它能够定义旋转的中心点、旋转角度以及缩放比例。 warpAffine 函数则利用该矩阵将输入图像进行变换。这种变换不仅包括了旋转,还包括了平移和缩放。

接下来,我们将详细探讨图像增强技术,包括直方图均衡化和对比度亮度调整等方法。

4.2 图像增强技术

图像增强是通过改进图像质量来达到更佳视觉效果的技术。它包括但不限于提升图像的局部或全局对比度、调整亮度、提高细节可见度等。在本节中,我们将集中讨论直方图均衡化和对比度亮度调整。

4.2.1 直方图均衡化

直方图均衡化是一种通过拉伸图像的直方图分布来改善图像对比度的方法。在OpenCV中, cv2.equalizeHist 函数提供了直方图均衡化的功能。

应用直方图均衡化

import matplotlib.pyplot as plt

def histogram_equalization(image):

# 将图像转换为灰度图

gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 应用直方图均衡化

equalized_image = cv2.equalizeHist(gray_image)

return equalized_image

# 加载图像并应用直方图均衡化

image = cv2.imread('low_contrast_image.jpg')

equalized_image = histogram_equalization(image)

# 显示原图和均衡化后的图像

cv2.imshow('Original Image', image)

cv2.imshow('Equalized Image', equalized_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

4.2.2 对比度和亮度调整

对比度调整改变了图像中不同亮度级别间的差异,而亮度调整则是改变整个图像的亮度分布。OpenCV没有直接提供调整对比度和亮度的函数,但可以通过调整像素值来实现。

实现对比度和亮度调整

def adjust_contrast_brightness(image, alpha, beta):

"""

alpha: 对比度控制 (1.0-3.0)

beta: 亮度控制 (0-100)

"""

# 将图像转换为浮点类型

adjusted_image = cv2.convertScaleAbs(image, alpha=alpha, beta=beta)

return adjusted_image

# 设置对比度和亮度参数

alpha = 1.5 # 对比度提高50%

beta = 30 # 亮度提高30

# 加载图像并调整对比度和亮度

image = cv2.imread('original_image.jpg')

adjusted_image = adjust_contrast_brightness(image, alpha, beta)

# 显示调整后的图像

cv2.imshow('Adjusted Image', adjusted_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

在上述代码中, convertScaleAbs 函数用于调整图像的对比度和亮度。通过设置 alpha 参数,可以改变图像的对比度; beta 参数则用于调整图像的整体亮度。通过这种方式,可以使得图像更加清晰或更适合观察者的视觉偏好。

在本章的后面部分,我们将进一步探讨特征检测方法,包括边缘检测和关键点检测与描述符技术。这些技术是图像处理领域中更高层次的操作,它们通常用于提取图像中的重要特征,以进行后续的识别、分类和匹配等任务。

5. 特征检测方法

5.1 边缘检测技术

边缘检测是计算机视觉和图像处理领域中的一个基础任务,它的目的是标识出图像中亮度变化明显的点。边缘通常对应于物体的边界,因此是提取物体形状信息的重要步骤。

5.1.1 Canny边缘检测

Canny边缘检测器是一种流行的边缘检测算法,由John F. Canny于1986年提出。Canny边缘检测器的目标是满足三个主要目标:良好的检测、准确的定位以及最小的响应。为此,算法分为几个步骤:

- 噪声降低:使用高斯模糊等方法对图像进行滤波,减少噪声对边缘检测的影响。

- 计算梯度幅值和方向:使用Sobel算子检测图像在垂直和水平方向的梯度,计算梯度幅值和方向。

- 非极大值抑制:仅保留局部梯度幅值最大的点,抑制其他点。

- 双阈值检测和边缘连接:通过设置高低阈值,保留强边缘的同时,将相邻的弱边缘连接起来。

代码示例:

import cv2

import numpy as np

# 读取图像

img = cv2.imread('example.jpg', cv2.IMREAD_GRAYSCALE)

# 使用高斯模糊进行降噪

blurred = cv2.GaussianBlur(img, (5, 5), 0)

# 使用Canny算子进行边缘检测

edges = cv2.Canny(blurred, 100, 200)

# 显示结果

cv2.imshow('Canny Edges', edges)

cv2.waitKey(0)

cv2.destroyAllWindows()

解释:

- cv2.imread 用于加载图像。

- cv2.GaussianBlur 用于降低图像噪声。

- cv2.Canny 实现Canny边缘检测算法,第一个参数是待处理的图像,第二个参数是低阈值,第三个参数是高阈值。

5.1.2 Sobel算子和Scharr算子

Sobel算子和Scharr算子是边缘检测的另一种方法,它们通过计算图像像素点的一阶导数来获取边缘信息。Sobel算子使用的是近似微分算子来突出图像中特定方向的边缘。Scharr算子是Sobel算子的一种变体,提供了更好的旋转不变性和对角线敏感性。

代码示例:

# 计算Sobel算子的x方向导数

sobel_x = cv2.Sobel(img, cv2.CV_64F, 1, 0, ksize=5)

# 计算Sobel算子的y方向导数

sobel_y = cv2.Sobel(img, cv2.CV_64F, 0, 1, ksize=5)

# 计算Scharr算子的x方向导数

scharr_x = cv2.Scharr(img, cv2.CV_64F, 1, 0)

# 计算Scharr算子的y方向导数

scharr_y = cv2.Scharr(img, cv2.CV_64F, 0, 1)

解释:

- cv2.Sobel 和 cv2.Scharr 用于计算图像的Sobel和Scharr边缘导数。第一个参数是输入图像,第二个参数是输出图像的数据类型,第三个参数和第四个参数分别指定了求导的方向,第五个参数是核的大小,越大则平滑度越高。

5.2 关键点检测与描述符

关键点检测旨在找到图像中重要的特征点,描述符则对这些点进行描述,使得特征点在图像中的位置、尺度和旋转等变化具有一定的不变性。

5.2.1 SIFT和SURF算法解析

尺度不变特征变换(Scale-Invariant Feature Transform,SIFT)和加速稳健特征(Speeded-Up Robust Features,SURF)是两种著名的关键点检测与描述算法。

SIFT算法通过以下步骤来检测和描述关键点:

- 尺度空间极值检测:在不同尺度空间中寻找像素点的极值点,作为潜在的关键点。

- 关键点定位:精确定位关键点的位置和尺度。

- 方向分配:给每个关键点分配一个或多个方向参数。

- 关键点描述子的生成:基于关键点邻域内的像素信息生成特征描述子。

SURF算法与SIFT类似,但在计算效率上有显著的提高,主要通过以下技术实现:

- 使用Box Filter近似SIFT中的高斯滤波,加速卷积操作。

- 利用积分图减少计算量。

- 采用Hessian矩阵的行列式作为极值点的近似检测。

- 用64维的特征向量描述关键点。

代码示例:

# 创建SIFT检测器

sift = cv2.SIFT_create()

# 使用SIFT检测关键点和描述符

keypoints, descriptors = sift.detectAndCompute(img, None)

# 绘制关键点

sift_img = cv2.drawKeypoints(img, keypoints, None)

cv2.imshow('SIFT Keypoints', sift_img)

cv2.waitKey(0)

cv2.destroyAllWindows()

解释:

- cv2.SIFT_create 用于创建SIFT检测器。

- detectAndCompute 函数用于检测关键点并计算它们的描述符。

- drawKeypoints 用于将检测到的关键点绘制在原图上。

5.2.2 ORB和其他快速特征检测

Oriented FAST and Rotated BRIEF(ORB)是一种结合了FAST关键点检测和BRIEF描述符的特征检测算法,其优点是计算速度快,具有旋转不变性,且免费提供。

ORB算法的关键点检测采用FAST算法,并在检测到的特征点上添加方向信息。描述符则使用BRIEF算法,但通过旋转图像来增强旋转不变性。

代码示例:

# 创建ORB检测器

orb = cv2.ORB_create()

# 使用ORB检测关键点和描述符

keypoints, descriptors = orb.detectAndCompute(img, None)

# 绘制关键点

orb_img = cv2.drawKeypoints(img, keypoints, None)

cv2.imshow('ORB Keypoints', orb_img)

cv2.waitKey(0)

cv2.destroyAllWindows()

解释:

- cv2.ORB_create 用于创建ORB检测器。

- detectAndCompute 函数同样用于检测关键点并计算它们的描述符。

- drawKeypoints 用于将检测到的关键点绘制在原图上。

ORB算法在许多实时应用中,如增强现实(AR)和机器人导航,提供了一个非常有效且实用的特征检测方案。它既保留了关键点的快速提取,又保证了特征描述的准确性,且由于其开源和免费的特性,被广泛应用于工业界。

6. 物体检测技术

物体检测是计算机视觉中的核心问题之一,它旨在定位出图像或视频中的物体并识别其类别。在过去的几十年中,物体检测技术经历了从传统的基于规则的方法到现代的基于深度学习的方法的演变。本章将介绍几种常用的物体检测技术,并探讨它们的原理和应用。

6.1 面向对象的检测方法

面向对象的检测方法通常涉及统计学习,其中最常见的有HOG+SVM检测器和Haar级联分类器。这些方法利用图像中的形状、纹理等特征,并通过训练得到的模型来识别物体。

6.1.1 HOG+SVM检测器

HOG+SVM检测器是一种广泛使用的人体检测方法,它基于特征描述符直方图的方向梯度(Histogram of Oriented Gradients,HOG)和支持向量机(Support Vector Machine,SVM)分类器。

原理 :HOG特征描述符通过计算局部区域内的梯度直方图来捕捉边缘信息。这些梯度直方图在空间上被分成小单元格,每个单元格内的梯度信息被量化到一定的方向区间。这些局部梯度直方图在较大的块中被连接起来,形成块的特征描述符。通过归一化块的特征描述符来增强对光照变化的鲁棒性。

应用 :SVM是一种二分类器,它通过在高维空间中找到一个最优超平面来最大化类别之间的边界。将HOG特征描述符输入到SVM分类器中,可以实现对检测目标的有效分类。

代码示例 :

import cv2

from skimage.feature import hog

from skimage import exposure

import numpy as np

def detect_with_hogsvm(image_path):

# 读取图片

image = cv2.imread(image_path, cv2.IMREAD_GRAYSCALE)

# 计算HOG特征

fd, hog_image = hog(image, orientations=8, pixels_per_cell=(16, 16),

cells_per_block=(1, 1), visualize=True, channel_axis=-1)

fd = fd / np.linalg.norm(fd) # 归一化

# 使用SVM分类器进行预测(此处假设已有训练好的SVM模型)

# model = load_trained_svm_model() # 加载训练好的SVM模型

# prediction = model.predict(fd)

return hog_image

# hog_image = detect_with_hogsvm('path_to_image')

6.1.2 Haar级联分类器

Haar级联分类器是一种基于机器学习的快速目标检测方法,广泛应用于人脸检测。

原理 :该方法使用Haar特征对图像进行检测,Haar特征包含边缘特征、线特征、中心环绕特征等。这些特征可以简单、快速地从图像中提取,并且计算效率高。级联分类器由多个简单的分类器组成,这些分类器按照从强到弱的顺序排列,逐级剔除大部分的负样本。

应用 :在物体检测中,级联分类器使用图像金字塔来处理不同大小的物体,并通过多个级联的弱分类器最终确定物体的位置。

代码示例 :

import cv2

def detect_with_haarcascade(image_path):

# 加载预训练的Haar级联人脸检测器

face_cascade = cv2.CascadeClassifier(cv2.data.haarcascades + 'haarcascade_frontalface_default.xml')

# 读取图片并转换为灰度图

image = cv2.imread(image_path)

gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 进行物体检测

faces = face_cascade.detectMultiScale(gray_image, scaleFactor=1.1, minNeighbors=5, minSize=(30, 30))

# 标记检测到的人脸

for (x, y, w, h) in faces:

cv2.rectangle(image, (x, y), (x+w, y+h), (255, 0, 0), 2)

return image

# image_with_faces = detect_with_haarcascade('path_to_image')

# cv2.imshow('Detected Faces', image_with_faces)

# cv2.waitKey(0)

# cv2.destroyAllWindows()

6.2 实时物体跟踪

实时物体跟踪在安全监控、交通监控、人机交互等领域有广泛应用。它不仅要求快速准确地定位物体,还要能够适应环境的变化。

6.2.1 背景减除方法

背景减除是物体跟踪中最简单的一种方法,它假设背景是相对静止的,并从当前帧中减去背景信息。

原理 :通过对视频序列中一系列背景帧求平均或中值,建立背景模型,然后将当前帧与背景模型相减,通过阈值分割得到前景物体的掩膜。

应用 :这种方法适用于背景相对固定的场景,但对光照变化、摄像头移动等较为敏感。

代码示例 :

import numpy as np

import cv2

def background_subtraction(image_path):

# 创建背景减除器对象

backSub = cv2.createBackgroundSubtractorMOG2()

# 读取视频帧

cap = cv2.VideoCapture(image_path)

while cap.isOpened():

ret, frame = cap.read()

if not ret:

break

# 更新背景模型,并获取前景掩膜

fgMask = backSub.apply(frame)

# 显示结果

cv2.imshow('Frame', frame)

cv2.imshow('Foreground Mask', fgMask)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cap.release()

cv2.destroyAllWindows()

# background_subtraction('path_to_video')

6.2.2 光流跟踪算法

光流跟踪算法是一种基于像素运动估计的方法,可以用于追踪视频中的动态物体。

原理 :光流法基于光流方程,假设视频中的像素点在连续的帧之间会有运动,通过这些运动信息可以估计像素点的速度,进而追踪整个物体。

应用 :光流跟踪适用于相机和物体都在运动的情况,但是当物体速度过快或者纹理过于单一,导致无法准确估计光流时,效果不佳。

代码示例 :

import cv2

def optical_flow_tracking(image_path):

# 读取视频

cap = cv2.VideoCapture(image_path)

ret, prev_frame = cap.read()

prev_gray = cv2.cvtColor(prev_frame, cv2.COLOR_BGR2GRAY)

hsv = np.zeros_like(prev_frame)

hsv[..., 1] = 255

# 设置光流参数

feature_params = dict( maxCorners = 500,

qualityLevel = 0.3,

minDistance = 7,

blockSize = 7 )

optical_params = dict( winSize = (15, 15),

maxLevel = 2,

criteria = (cv2.TERM_CRITERIA_EPS | cv2.TERM_CRITERIA_COUNT, 10, 0.03))

# 创建光流对象

corners = cv2.goodFeaturesToTrack(prev_gray, mask = None, **feature_params)

while True:

ret, frame = cap.read()

if not ret:

break

frame_gray = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)

# 计算光流

next_corners, status, error = cv2.calcOpticalFlowPyrLK(prev_gray, frame_gray, corners, None, **optical_params)

# 选择好的点

good_new = next_corners[status == 1]

good_old = corners[status == 1]

# 连接好的点

for i, (new, old) in enumerate(zip(good_new, good_old)):

a, b = new.ravel()

c, d = old.ravel()

hsv[..., 0] = 0

hsv[..., 1] = 255

hsv[..., 2] = 0

mask = np.zeros_like(prev_frame)

mask = cv2.line(mask, (a, b), (c, d), 255, 2)

rgb = cv2.cvtColor(mask, cv2.COLOR_HSV2BGR)

prev_frame = cv2.addWeighted(prev_frame, 1.0, rgb, 0.8, 0)

# 更新上一帧图像

hsv[..., 0] = 0

hsv[..., 1] = 255

prev_gray = frame_gray

cv2.imshow('Optical Flow', prev_frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

cv2.destroyAllWindows()

cap.release()

# optical_flow_tracking('path_to_video')

以上就是第六章的全部内容。通过介绍面向对象的检测方法和实时物体跟踪的实现,我们可以看到OpenCV提供的工具箱在物体检测领域是如何帮助开发者从理论到实践的快速转化的。接下来的章节中,我们将继续深入探讨如何将OpenCV与机器学习和深度学习相结合,以及如何在实际项目中应用这些知识。

7. 机器学习与深度学习集成

OpenCV不仅是一个图像处理库,它还包含了丰富的机器学习和深度学习模块,使得开发者可以在同一个环境中进行复杂的视觉任务处理和模式识别。本章将探讨如何在OpenCV中使用这些高级功能,以及如何将深度学习模型集成到我们的应用程序中。

7.1 OpenCV中的机器学习模块

7.1.1 分类器的训练和应用

OpenCV中包含多个机器学习算法,用于分类任务。这些算法包括k最近邻(k-NN)、支持向量机(SVM)、决策树和随机森林等。使用OpenCV训练一个分类器通常涉及以下步骤:

- 准备数据集 :数据集应该被分为特征(通常是一个二维数组)和标签(一个一维数组)。

- 选择并设置机器学习算法 :根据问题的类型和数据集的特性选择合适的算法,并对其进行配置。

- 训练模型 :使用数据集对算法进行训练,构建模型。

- 评估模型 :使用保留的测试数据集对模型进行评估。

- 模型应用 :将训练好的模型用于新的数据进行预测。

下面是一个使用OpenCV的SVM进行分类的简单示例代码:

import numpy as np

import cv2

# 加载数据集(特征和标签)

X = np.load('features.npy')

y = np.load('labels.npy')

# 创建SVM分类器

clf = cv2.ml.SVM_create()

clf.setType(cv2.ml.SVM_C_SVC)

clf.setKernel(cv2.ml.SVM_RBF)

clf.setTermCriteria((cv2.TERM_CRITERIA_MAX_ITER, 100, 1e-6))

# 训练模型

clf.train(np.float32(X), cv2.ml.ROW_SAMPLE, np.float32(y))

# 应用模型

sample = np.array([[10, 20]], np.float32)

result = clf.predict(sample)

print('Predicted class:', result[1])

7.1.2 聚类和回归分析

聚类和回归分析是机器学习的其他重要组成部分。OpenCV中的机器学习模块也支持这些分析:

- 聚类分析 :用于将数据集划分为多个组或“簇”。OpenCV提供了K均值聚类算法。

- 回归分析 :用于预测连续数值。支持线性回归和逻辑回归等。

以下是使用K均值进行聚类的示例代码:

import numpy as np

import cv2

# 创建数据

data = np.load('data.npy', allow_pickle=True)

# 创建K均值聚类器,k为簇的数量

criteria = (cv2.TERM_CRITERIA_EPS + cv2.TERM_CRITERIA_MAX_ITER, 100, 0.2)

k = 2

ret, labels, centers = cv2.kmeans(data, k, None, criteria, 10, cv2.KMEANS_RANDOM_CENTERS)

# 输出簇中心

print(centers)

7.2 深度学习集成实践

OpenCV 3.3以后的版本增加了对深度学习的支持,通过OpenCV的 dnn 模块,我们可以加载预训练的模型并使用自己的数据进行训练。

7.2.1 使用OpenCV加载预训练的深度模型

预训练的模型可以直接用于图像识别、对象检测等任务。以下是如何使用OpenCV加载一个预训练的深度学习模型的示例:

import cv2

# 加载预训练的网络

net = cv2.dnn.readNetFromCaffe('deploy.prototxt', 'bvlc_googlenet.caffemodel')

# 读取要进行分类的图像

image = cv2.imread('image.jpg')

blob = cv2.dnn.blobFromImage(image, 1.0, (224, 224), (104, 117, 123))

# 设置网络输入

net.setInput(blob)

# 运行前向检测

out = net.forward()

# 分析输出结果

# ...(此处省略输出分析代码)

7.2.2 自定义深度学习网络和训练

如果需要从头开始创建和训练自己的深度学习模型,可以使用 dnn 模块。首先需要构建模型架构,然后将数据喂入模型进行训练。由于OpenCV的深度学习模块仍处于发展阶段,与TensorFlow或PyTorch等专业深度学习框架相比,其灵活性和功能可能有所限制,但它非常适合快速原型开发和嵌入式设备应用。

import cv2

import numpy as np

# 设定网络层参数

layer_params = []

# ...(此处省略设定层参数代码)

# 构建网络

net = cv2.dnn.Net()

for layer_params in layer_params:

net.addLayer(*layer_params)

# 设置输入数据并训练网络

# ...(此处省略训练代码)

# 保存训练好的模型

net.save('my_model.caffemodel')

本章重点介绍了如何在OpenCV中利用其机器学习和深度学习模块来完成分类器训练、聚类和回归分析以及如何使用深度神经网络。这些高级功能扩展了OpenCV的能力,使其不仅适用于传统图像处理任务,而且能够进行更复杂的视觉识别工作。在下一章中,我们将通过实际项目案例,进一步探讨如何将OpenCV应用于实践。

简介:OpenCV(开源计算机视觉库)是一个强大的计算机视觉库,提供了丰富的图像处理和视觉算法,支持多种编程语言,并广泛应用于多个领域。本教程旨在帮助初学者掌握OpenCV的基础知识和应用,包括安装配置、图像处理、特征检测、物体检测以及机器学习和深度学习集成。通过动手实践项目,初学者将能巩固理论知识,提高操作技能。

26万+

26万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?