转自:http://my.oschina.net/hanzhankang/blog/200275

附:各种操作的逻辑执行图 https://github.com/JerryLead/SparkInternals/blob/master/markdown/2-JobLogicalPlan.md

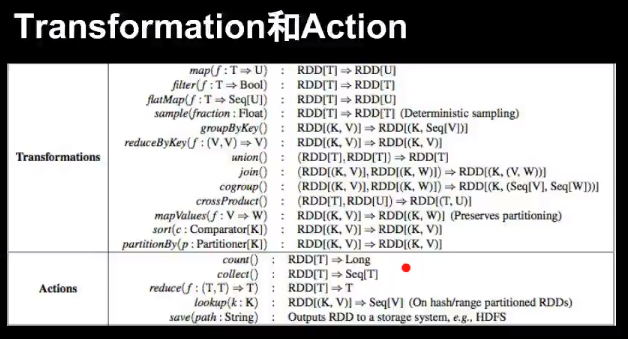

本文提供的是0.7.3版本中的action和transformation接口,RDD提供了两种类型的操作:transformation和action

1. transformation是得到一个新的RDD,方式很多,比如从数据源生成一个新的RDD,从RDD生成一个新的RDD

2. action是得到一个值,或者一个结果(直接将RDD cache到内存中)

所有的transformation都是采用的懒策略,就是如果只是将transformation提交是不会执行计算的,计算只有在action被提交的时候才被触发。下面介绍一下RDD的常见操作:(注意是dataset还是RDD)

transformation操作:

| map(func):对调用map的RDD数据集中的每个element都使用func,然后返回一个新的RDD,这个返回的数据集是分布式的数据集 filter(func) : 对调用filter的RDD数据集中的每个元素都使用func,然后返回一个包含使func为true的元素构成的RDD flatMap(func):和map差不多,但是flatMap生成的是多个结果 mapPartitions(func):和map很像,但是map是每个element,而mapPartitions是每个partition mapPartitionsWithSplit(func):和mapPartitions很像,但是func作用的是其中一个split上,所以func中应该有index sample(withReplacement,faction,seed):抽样 union(otherDataset):返回一个新的dataset,包含源dataset和给定dataset的元素的集合 distinct([numTasks]):返回一个新的dataset,这个dataset含有的是源dataset中的distinct的element groupByKey(numTasks):返回(K,Seq[V]),也就是hadoop中reduce函数接受的key-valuelist reduceByKey(func,[numTasks]):就是用一个给定的reduce func再作用在groupByKey产生的(K,Seq[V]),比如求和,求平均数 sortByKey([ascending],[numTasks]):按照key来进行排序,是升序还是降序,ascending是boolean类型 join(otherDataset,[numTasks]):当有两个KV的dataset(K,V)和(K,W),返回的是(K,(V,W))的dataset,numTasks为并发的任务数 cogroup(otherDataset,[numTasks]):当有两个KV的dataset(K,V)和(K,W),返回的是(K,Seq[V],Seq[W])的dataset,numTasks为并发的任务数 cartesian(otherDataset):笛卡尔积就是m*n,大家懂的 |

action操作:

| reduce(func):说白了就是聚集,但是传入的函数是两个参数输入返回一个值,这个函数必须是满足交换律和结合律的 collect():一般在filter或者足够小的结果的时候,再用collect封装返回一个数组 count():返回的是dataset中的element的个数 first():返回的是dataset中的第一个元素 take(n):返回前n个elements,这个士driver program返回的 takeSample(withReplacement,num,seed):抽样返回一个dataset中的num个元素,随机种子seed saveAsTextFile(path):把dataset写到一个text file中,或者hdfs,或者hdfs支持的文件系统中,spark把每条记录都转换为一行记录,然后写到file中 saveAsSequenceFile(path):只能用在key-value对上,然后生成SequenceFile写到本地或者hadoop文件系统 countByKey():返回的是key对应的个数的一个map,作用于一个RDD foreach(func):对dataset中的每个元素都使用func |

在spark新版中,也许会有更多的action和transformation,可以参照spark的主页

hadoop提供的接口只有map和reduce函数,spark是mapreduce的扩展,提供两类操作,而不是两个,使使用更方便,开发时的代码量会尽量的被spark的这种多样的API减少数十倍

本文详细解析了Apache Spark中Resilient Distributed Dataset (RDD) 的两种核心操作:Transformation 和 Action。Transformation用于创建新的RDD,而Action则用于获取结果。文中深入探讨了这些操作的具体实现和应用,包括如何利用它们进行数据过滤、映射、分组等高级数据处理任务,并解释了懒执行策略的概念。此外,还介绍了如何通过Action操作如reduce、collect和count等来获取和聚合数据集中的信息。

本文详细解析了Apache Spark中Resilient Distributed Dataset (RDD) 的两种核心操作:Transformation 和 Action。Transformation用于创建新的RDD,而Action则用于获取结果。文中深入探讨了这些操作的具体实现和应用,包括如何利用它们进行数据过滤、映射、分组等高级数据处理任务,并解释了懒执行策略的概念。此外,还介绍了如何通过Action操作如reduce、collect和count等来获取和聚合数据集中的信息。

617

617

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?