1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)词频统计。

首先开启相关的程序,hadoop、hbase

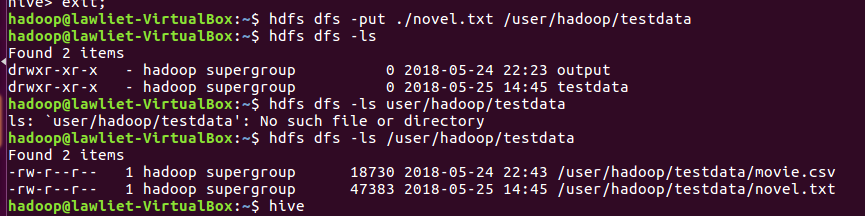

使用hdfs命令把下载的英文长篇小说复制进hdfs文件夹中

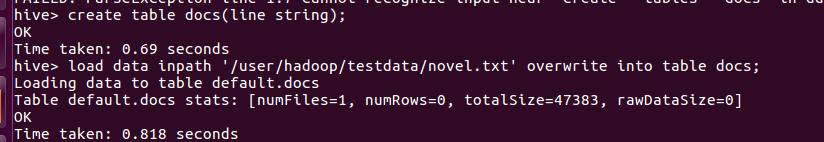

然后打开hive命令行将hdfs中的长篇小说加入数据表

然后查看数据表中的数据

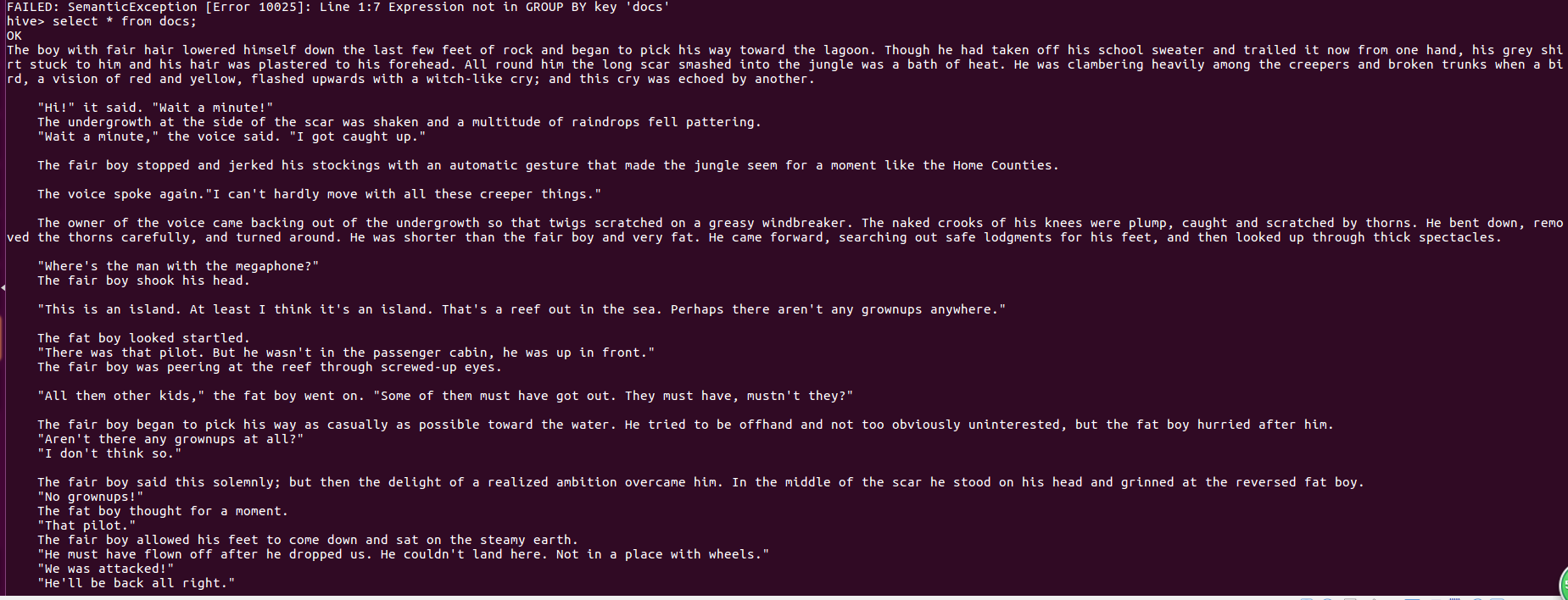

然后使用相关的命令进行词频统计

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

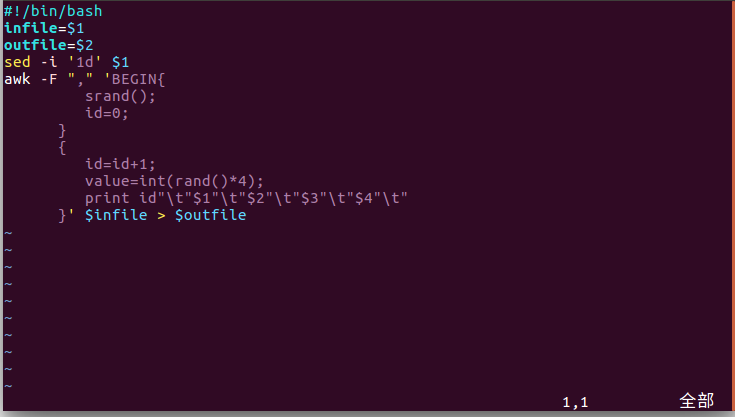

部分步骤重复了就不说了,接下来就是使用一个脚本,把在主机中制作的csv文件进行预处理

然后建表,查看

本文介绍如何使用Hive对爬虫产生的文本文件进行词频统计,并对CSV文件进行数据分析的过程。首先通过HDFS加载数据,接着利用Hive进行处理,包括创建表和执行查询。此外还分享了一些预处理技巧。

本文介绍如何使用Hive对爬虫产生的文本文件进行词频统计,并对CSV文件进行数据分析的过程。首先通过HDFS加载数据,接着利用Hive进行处理,包括创建表和执行查询。此外还分享了一些预处理技巧。

453

453

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?