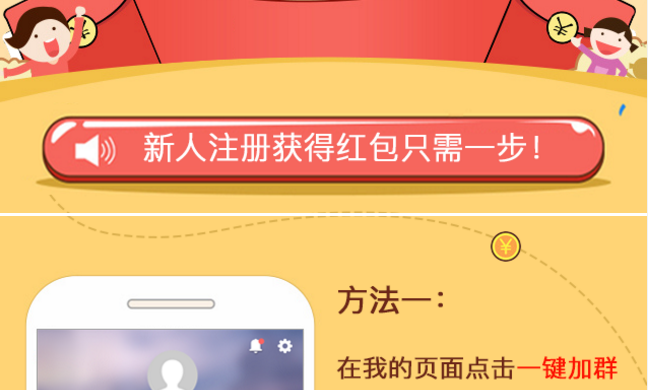

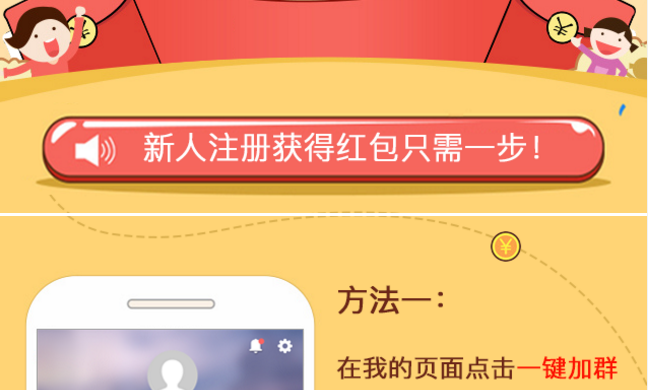

有时候会有这样的页面,整个页面也就是几张切好的图片组成,但是把这些图片使用代码拼接好,又总会出现图片间有白条的问题,如下图:

解决方法:给图片的父容器添加 line-height:

有时候会有这样的页面,整个页面也就是几张切好的图片组成,但是把这些图片使用代码拼接好,又总会出现图片间有白条的问题,如下图:

解决方法:给图片的父容器添加 line-height:

转载于:https://www.cnblogs.com/xyyt/p/6084583.html

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?