引言

在当今数据驱动的商业环境中,企业业务数据通常存储在MySQL等关系型数据库中,但当数据量增长到千万级甚至更高时,直接在MySQL中进行复杂分析会导致性能瓶颈。本文将详细介绍如何将MySQL业务数据迁移到大数据平台,并通过Spark等工具实现高效的离线分析流程。

一、整体架构设计

1.1 技术栈选择

核心组件:

-

数据抽取:Sqoop、Flink CDC

-

数据存储:HDFS、Hive

-

计算引擎:Spark、Hive

-

调度系统:Airflow

-

可视化:Superset

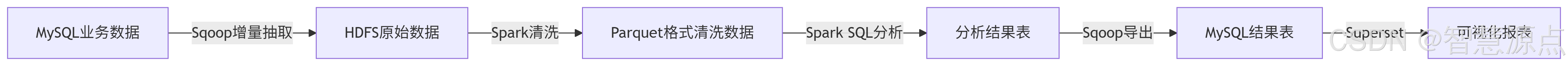

1.2 流程概览

二、数据抽取实战

2.1 Sqoop全量导入最佳实践

#!/bin/bash

# sqoop_full_import.sh

DB_URL="jdbc:mysql://mysql-host:3306/prod_db"

USERNAME="etl_user"

PASSWORD="secure_password"

TABLE_NAME="orders"

HDFS_PATH="/data/raw/${TABLE_NAME}_$(date +%Y%m%d)"

sqoop import \

--connect $DB_URL \

--username $USERNAME \

--password $PASSWORD \

--table $TABLE_NAME \

--target-dir $HDFS_PATH \

--compress \

--compression-codec org.apache.hadoop.io.compress.SnappyCodec \

--fields-terminated-by '\001' \

--null-string '\\N' \

--null-non-string '\\N' \

--m 8关键参数说明:

-

--compress:启用压缩 -

--fields-terminated-by '\001':使用不可见字符作为分隔符 -

--m 8:设置8个并行任务

2.2 增量同步方案对比

| 方案 | 适用场景 | 优缺点 |

|---|---|---|

| Sqoop增量 | T+1批处理 | 简单但需要维护last-value |

| Flink CDC | 近实时同步 | 复杂但支持精确一次语义 |

| 时间戳触发器 | 业务系统有更新时间字段 | 依赖业务表设计 |

三、数据清洗与转换

3.1 Spark清洗标准化流程

import org.apache.spark.sql.*;

public class DataCleaningJob {

public static void main(String[] args) {

// 初始化SparkSession

SparkSession spark = SparkSession.builder()

.appName("JavaDataCleaning")

.config("spark.sql.parquet.writeLegacyFormat", "true")

.getOrCreate();

// 1. 读取原始数据

Dataset<Row> rawDF = spark.read()

.format("parquet")

.load("/data/raw/orders");

// 2. 数据清洗转换

Dataset<Row> cleanedDF = rawDF

// 处理空

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2494

2494

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?