文章大纲

简介

深度学习分为:

- 训练

- 推理

两个部分,目前很多资料最关系的是训练

TensorRT 简介

TensorRT是NVIDIA推出的一个高性能的深度学习推理框架,可以让深度学习模型在NVIDIA GPU上实现低延迟,高吞吐量的部署。TensorRT支持Caffe,TensorFlow,Mxnet,Pytorch等主流深度学习框架的部署。TensorRT底层为C++库,NVIDIA为其提供了C++ API和Python API,主要在NVIDIA GPU以实现高性能的推理(Inference)加速。

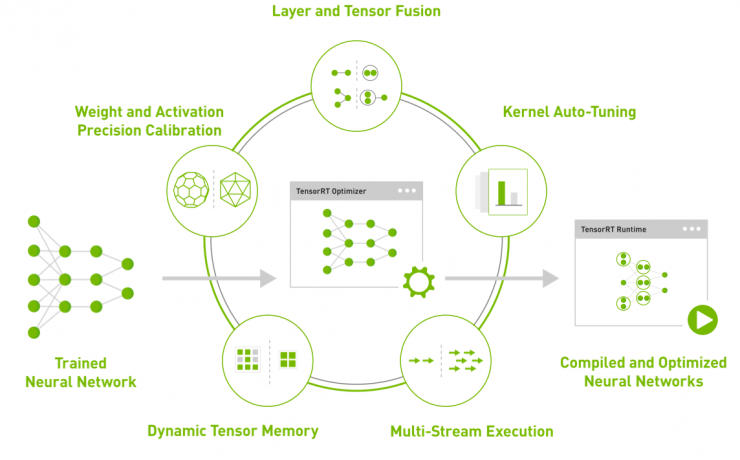

下图简要展示了TensorRT推理加速的机制:

TensorRT主要进行了以下操作,以实现模型运行速度的提升:

订阅专栏 解锁全文

订阅专栏 解锁全文

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?