创建dataframe

import org.apache.spark.sql.types._

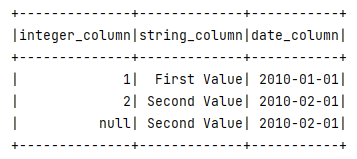

val schema = StructType(List(

StructField("integer_column", IntegerType, nullable = true),

StructField("string_column", StringType, nullable = true),

StructField("date_column", DateType, nullable = true)

))

val rdd = spark.sparkContext.parallelize(Seq(

Row(1, "First Value", java.sql.Date.valueOf("2010-01-01")),

Row(2, "Second Value", java.sql.Date.valueOf("2010-02-01")),

Row(null, "Second Value", java.sql.Date.valueOf("2010-02-01"))

))

官方的方法

df_fill.toJSON.collectAsList.toString

自定义格式

package utils

import org.apache.spark.sql.DataFrame

object MyDataInsightUtil {

def dataFrame2Json(data:DataFrame,num:Int=10)={

val dftopN = data.limit(num)

val arr = dftopN.collect().map(x=>x.toSeq.mkString("\"","\",\"","\"")).mkString("|")

val columnName = (dftopN.columns.mkString("\"","\",\"","\""))

(columnName+"|"+ arr)

}

}

结果:

填充后结果

“integer_column”,“string_column”,“date_column”|“1”,“First Value”,“2010-01-01”|“2”,“Second Value”,“2010-02-01”|"-3",“Second Value”,“2010-02-01”

原始结果

“integer_column”,“string_column”,“date_column”|“1”,“First Value”,“2010-01-01”|“2”,“Second Value”,“2010-02-01”|“null”,“Second Value”,“2010-02-01”

本文介绍如何使用Spark创建DataFrame,并提供了将DataFrame转换为特定格式JSON的方法。通过自定义函数实现DataFrame到JSON的转换,展示了填充后的JSON结果及原始JSON结果。

本文介绍如何使用Spark创建DataFrame,并提供了将DataFrame转换为特定格式JSON的方法。通过自定义函数实现DataFrame到JSON的转换,展示了填充后的JSON结果及原始JSON结果。

1086

1086