一、下载Hadoop安装包

sudo wget http://mirrors.hust.edu.cn/apache/hadoop/core/hadoop-2.7.7/hadoop-2.7.7.tar.gz

二、 解压Hadoop到目录

sudo tar -zxvf hadoop-2.7.7.tar.gz -C ../apache/

三、配置文件

1)、core-site.xml配置如下:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/home/hadoop/program/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

2)、mapred-site.xml.template配置如下:

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

</property>

</configuration>

3)、hdfs-site.xml配置如下:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/home/hadoop/program/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/home/hadoop/program/hadoop/tmp/dfs/data</value>

</property>

</configuration>

其中dfs.namenode.name.dir和dfs.datanode.data.dir的路径可以自由设置,最好在hadoop.tmp.dir的目录下面。

补充,如果运行Hadoop的时候发现找不到jdk,可以直接将jdk的路径放置在hadoop.env.sh里面,具体如下:export JAVA_HOME="/usr/local/java/jdk1.8.0_60"

四、运行Hadoop

1.初始化HDFS系统

在hadop2.7.7目录下使用如下命令:

./bin/hdfs namenode -format

2.启动服务进程

#开启namenode和datanode

./sbin/start-dfs.sh

#开启yarn

./sbin/start-yarn.sh

#开启日志服务

./sbin/mr-jobhistory-daemon.sh start historyserver

3、问题处理

错误信息

20/05/09 11:12:36 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

glibc版本问题,按如下更新后可以

[root@test common]# tar -xf glibc-2.17.tar.gz

[root@test common]# cd glibc-2.17

[root@test glibc-2.17]# mkdir build; cd build

[root@test build]# ../configure --prefix=/usr --disable-profile --enable-add-ons --with-headers=/usr/include --with-binutils=/usr/bin

[root@test build]# make -j 8

[root@test build]# make install

[root@test common]# strings /lib64/libc.so.6 | grep GLIBC

会看到下面的结果

GLIBC_2.2.5

GLIBC_2.2.6

GLIBC_2.3

GLIBC_2.3.2

GLIBC_2.3.3

GLIBC_2.3.4

GLIBC_2.4

GLIBC_2.5

GLIBC_2.6

GLIBC_2.7

GLIBC_2.8

GLIBC_2.9

GLIBC_2.10

GLIBC_2.11

GLIBC_2.12

GLIBC_2.13

GLIBC_2.14

GLIBC_2.15

GLIBC_2.16

GLIBC_2.17

GLIBC_PRIVATE

————————————————

参考:https://blog.youkuaiyun.com/u010003835/article/details/81127984

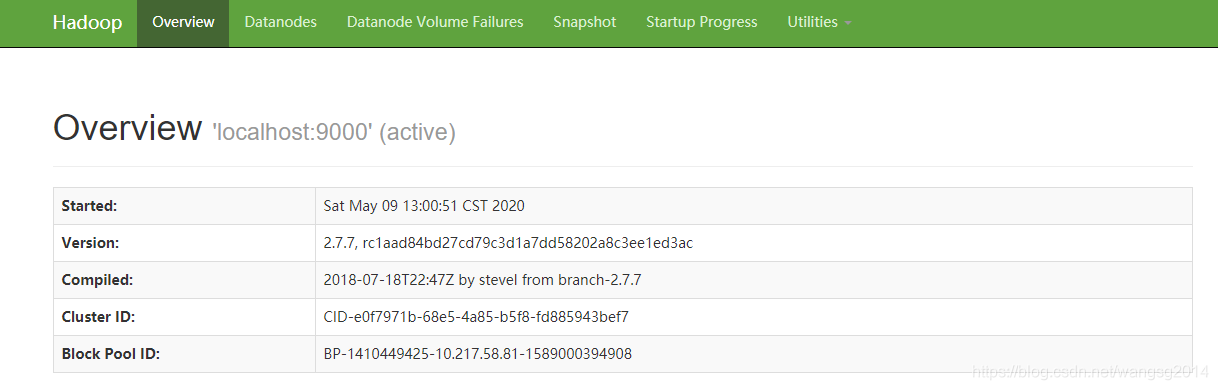

4、查看WEB UI

在浏览器中输入http://localhost:50070,即可查看相关信息,如下图:

参考:https://www.cnblogs.com/hello-/articles/9600269.html

5、word count测试

./bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.7.jar wordcount /test/words /test/wordout

附:常见问题汇总

1、启动时namenode启动失败原因,可能没有执行下面操作

bin/hdfs namenode -format

附:常用操作命令:

1、离开安全模式方法:执行以下命令即可

bin/hadoop dfsadmin -safemode leave

#启动和停止服务,提示弃用,代替使用下面命令

./sbin/start-all.sh

./sbin/stop-all.sh

#新的启用

./sbin/start-dfs.sh

./sbin/start-yarn.sh

#新的停止

./sbin/start-dfs.sh

./sbin/start-yarn.sh

#开启日志服务(start-all or stop all 不包括该服务)

./sbin/mr-jobhistory-daemon.sh start historyserver

#停止日志服务(start-all or stop all 不包括该服务)

./sbin/mr-jobhistory-daemon.sh stop historyserver

#查看集群名称

bin/hdfs getconf -confKey fs.defaultFS

2、Hadoop日志设置

export HADOOP_ROOT_LOGGER=DEBUG,console

export HADOOP_ROOT_LOGGER=INFO,console

本文提供Hadoop2.7.7的详细安装步骤,涵盖下载、解压、配置文件修改,以及运行和服务启动。解决常见问题如JDK路径设置和glibc版本更新,并附上查看WEBUI及wordcount测试方法。

本文提供Hadoop2.7.7的详细安装步骤,涵盖下载、解压、配置文件修改,以及运行和服务启动。解决常见问题如JDK路径设置和glibc版本更新,并附上查看WEBUI及wordcount测试方法。

316

316

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?