1 Dockerfile,需要定义一个Dockerfile,Dockerfile定义了进程需要的一切东西。Dockerfile涉及的内容包括执行代码或者是文件、环境变量、依赖包、运行时环境、动态链接库、操作系统的发行版、服务进程和内核进程(当应用进程需要和系统服务和内核进程打交道,这时需要考虑如何设计namespace的权限控制)等等;

2 Docker镜像,在用Dockerfile定义一个文件之后,docker build时会产生一个Docker镜像,当运行 Docker镜像时,会真正开始提供服务;

3 Docker容器,容器是直接提供服务的。

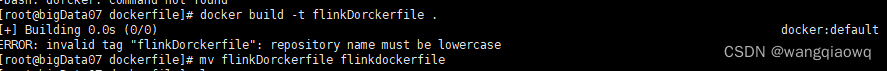

1、文件名要小写

2、

$ docker build -t mybuilder:v1 -f ./build/Dockerfile .

//-t:指定新建的Dockerfile名称

//-f:指定该dockerfile的位置

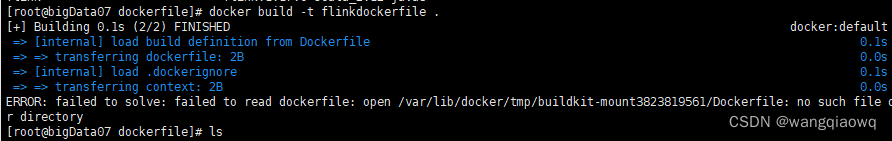

3、docker build -t flink16 -f /opt/dockerfile/flinkdockerfile .

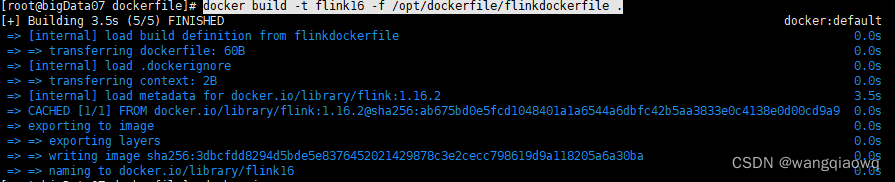

4、docker images

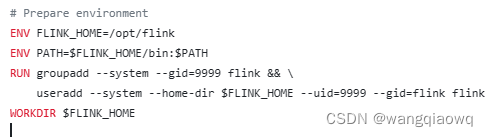

5、 flink docker代码

flink-docker/1.15/scala_2.12-java8-ubuntu/Dockerfile at master · apache/flink-docker · GitHub

# 使用官方的 Flink 基础镜像作为基础

FROM flink:1.14.6

#

## 定义工作目录

WORKDIR /opt/flink/lib

#

# 将本地依赖的 JAR 包添加到目录

COPY /opt/flink/flink-1.14.6/lib/dlink-client-1.14-0.7.3.jar .

COPY /opt/flink/flink-1.14.6/lib/dlink-client-base-0.7.3.jar .

COPY /opt/flink/flink-1.14.6/lib/dlink-common-0.7.3.jar .

COPY /opt/flink/flink-1.14.6/lib/dlink-metadata-base-0.7.3.jar .

COPY /opt/flink/flink-1.14.6/lib/dlink-metadata-doris-0.7.3.jar .

COPY /opt/flink/flink-1.14.6/lib/dlink-metadata-mysql-0.7.3.jar .

COPY /opt/flink/flink-1.14.6/lib/dlink-metadata-sqlserver-0.7.3.jar .

COPY /opt/flink/flink-1.14.6/lib/druid-1.2.8.jar .

COPY /opt/flink/flink-1.14.6/lib/flink-connector-jdbc_2.12-1.14.6.jar .

COPY /opt/flink/flink-1.14.6/lib/flink-dist_2.12-1.14.6.jar .

COPY /opt/flink/flink-1.14.6/lib/flink-doris-connector-1.14_2.12-1.1.1.jar .

COPY /opt/flink/flink-1.14.6/lib/flink-faker-0.5.3.jar .

COPY /opt/flink/flink-1.14.6/lib/flink-shaded-guava-30.1.1-jre-16.0.jar .

COPY /opt/flink/flink-1.14.6/lib/flink-shaded-hadoop-3-uber-3.1.1.7.2.9.0-173-9.0.jar .

COPY /opt/flink/flink-1.14.6/lib/flink-sql-connector-mysql-cdc-2.3.0.jar .

COPY /opt/flink/flink-1.14.6/lib/flink-sql-connector-sqlserver-cdc-2.3.0.jar .

COPY /opt/flink/flink-1.14.6/lib/flink-table_2.12-1.14.6.jar .

COPY /opt/flink/flink-1.14.6/lib/HikariCP-4.0.3.jar .

COPY /opt/flink/flink-1.14.6/lib/jackson-datatype-jsr310-2.13.4.jar .

COPY /opt/flink/flink-1.14.6/lib/mysql-connector-java-8.0.28.jar .

然后执行命令

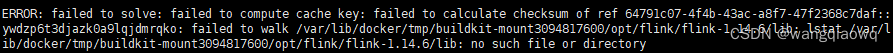

docker build -t flink14 -f /opt/dockerfile/flinkdockerfile .

COPY 指令将从构建上下文目录中 <源路径> 的文件/目录复制到新的一层的镜像内的 <目标路径> 位置。

<目标路径> 可以是容器内的绝对路径,也可以是相对于工作目录的相对路径(工作目录可以用 WORKDIR 指令来指定)。

目标路径不需要事先创建,如果目录不存在会在复制文件前先行

创建缺失目录。

COPY <源路径>... <目标路径>

COPY ["<源路径1>",... "<目标路径>"]

正确:

COPY ./package.json /app/

COP

文章详细介绍了如何使用Dockerfile定义Flink环境,包括添加依赖JAR包,设置权限,并构建Docker镜像。接着讨论了在Kubernetes中遇到的问题,如ErrImagePull异常,以及如何解决,包括配置registry以允许不安全连接和修改DockerRegistry。最后,提到了FlinkSession集群的Kubernetes部署过程。

文章详细介绍了如何使用Dockerfile定义Flink环境,包括添加依赖JAR包,设置权限,并构建Docker镜像。接着讨论了在Kubernetes中遇到的问题,如ErrImagePull异常,以及如何解决,包括配置registry以允许不安全连接和修改DockerRegistry。最后,提到了FlinkSession集群的Kubernetes部署过程。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

607

607

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?