一、安装准备

hadoop-2.6.0-cdh5.14.2.tar.gz

hadoop-native-64-2.6.0.tar

hbase-1.2.0-cdh5.14.2.tar.gz

hive-1.1.0-cdh5.14.2.tar.gz

MySQL-client-5.6.46-1.el7.x86_64.rpm

MySQL-server-5.6.46-1.el7.x86_64.rpm

zookeeper-3.4.6.tar.gz

jdk-8u221-linux-x64.tar.gz

mysql-connector-java-5.1.0-bin.jar

cd / 切换至根目录

新建一个软件包(专门用来放安装包):mkdir soft

切换至soft目录:cd soft

将准备好的9个文件拖入software目录

将除

MySQL-client-5.6.46-1.el7.x86_64.rpm

MySQL-server-5.6.46-1.el7.x86_64.rpm

hadoop-native-64-2.6.0.tar

mysql-connector-java-5.1.0-bin.jar的5个安装包 解压至opt目录下:tar -zxf 文件名 -C/opt

将hadoop-native-64-2.6.0.tar 分别解压至 /opt/soft/hadoop-2.6.0-cdh5.14.2/lib、

/opt/soft/hadoop-2.6.0-cdh5.14.2/lib/native 目录下

tar -xvf hadoop-native-64-2.6.0.tar

tar -xvf hadoop-native-64-2.6.0.tar

cd /opt 切换至 opt目录下

将解压的文件包改名

mv hadoop-2.6.0-cdh5.14.2 hadoop

mv hbase-1.2.0-cdh5.14.2 hbase

mv hive-1.1.0-cdh5.14.2 hive

mv zookeeper-3.4.6 zookpr

mv jdk-8u221-linux-x64 java8

ps:注意空格

配置环境变量

vi /etc/profile

export JAVA_HOME=/opt/soft/java

export JRE_HOME=/opt/soft/java/jre

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar

export PATH=/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/root/bin

export HADOOP_HOME=/opt/soft/hadoop

export HBASE_HOME=/opt/soft/hbase

export HIVE_HOME=/opt/soft/hive

export HADOOP_MAPRED_HOME=$HADOOP_HOME

export HADOOP_COMMON_HOME=$HADOOP_HOME

export HADOOP_HDFS_HOME=$HADOOP_HOME

export YARN_HOME=$HADOOP_HOME

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib"

export PATH=$PATH:$JAVA_HOME/bin:$JRE_HOME/bin:$HADOOP_HOME/sbin:$HADOOP_HOME/bin:$HBASE_HOME/bin:$HIVE_HOME/bin

保存退出

输入 java -version

javac

hadoop version

hbase version

是否能够出结果

切换至/opt/hadoop/etc/hadoop:cd /opt/soft/hadoop/etc/hadoop

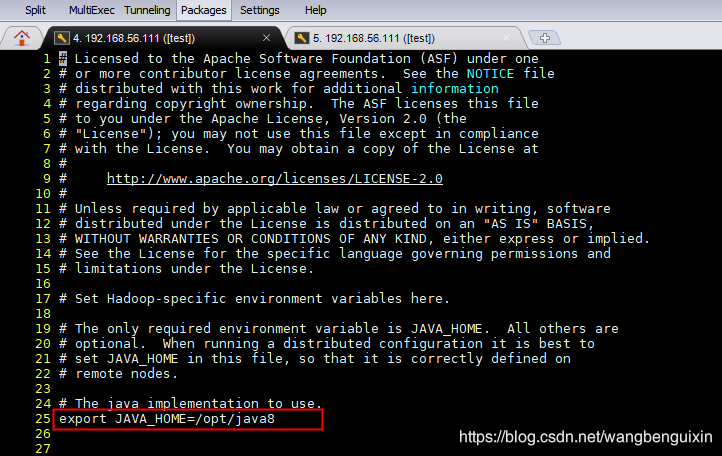

修改hadoop-env.sh 文件

vi hadoop-env.sh

ps:我这里将jdk-8u221-linux-x64改名为了java 你们可根据情况自行调整

export JAVA_HOME=/opt/soft/java

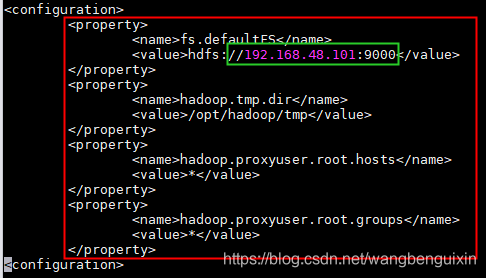

修改core-site.xml配置文件信息

vi core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.48.101:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/hadoop/tmp</value>

</property>

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

修改hdfs-site.xml配置文件

vi hdfs-site.xml

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>192.168.48.101:50090</value>

本文详细介绍了如何搭建Hadoop集群,包括Zookeeper、Hbase、Docker、MySQL的安装配置,并提供了时间同步的进阶版教程。从环境准备开始,逐步指导读者完成各个组件的安装和配置,包括Hadoop的环境变量设置、配置文件修改等关键步骤,最后通过实例展示了Hive的使用。

本文详细介绍了如何搭建Hadoop集群,包括Zookeeper、Hbase、Docker、MySQL的安装配置,并提供了时间同步的进阶版教程。从环境准备开始,逐步指导读者完成各个组件的安装和配置,包括Hadoop的环境变量设置、配置文件修改等关键步骤,最后通过实例展示了Hive的使用。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

603

603

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?